文章目录

Generator NetworkGANUncoditional generationGeneratorDiscriminator Basic Idea of GANAlgorithmTheory behind GANWGANWasserstein distance Conditional GenerationConditional GAN

Generator Network

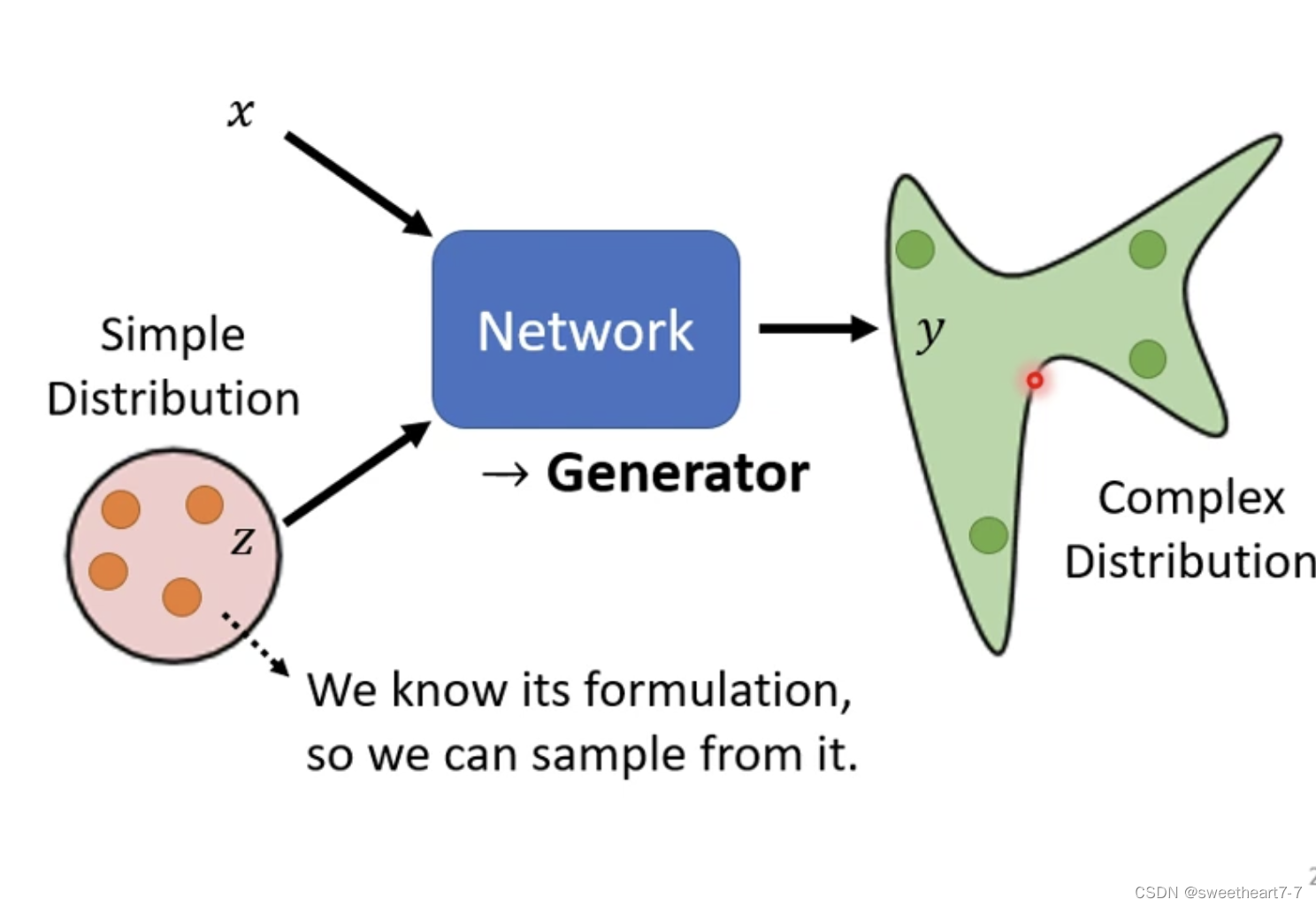

将 Network 拿来当 Generator 来使用

现在 Network 的输入会加上一个 random 的 variable (z),z 是从一个分布中 取样出来的,现在的 Network 是同时看 x 跟 z 得到输出。

由于 z 的值随机,所以 y 的输出也就不一样,此时 Network 的输出不是单一的一个东西,而是一个复杂的 distribution。

这个可以输出一个 distribution 的 Network,我们就叫它 generator

GAN

Uncoditional generation

Generator

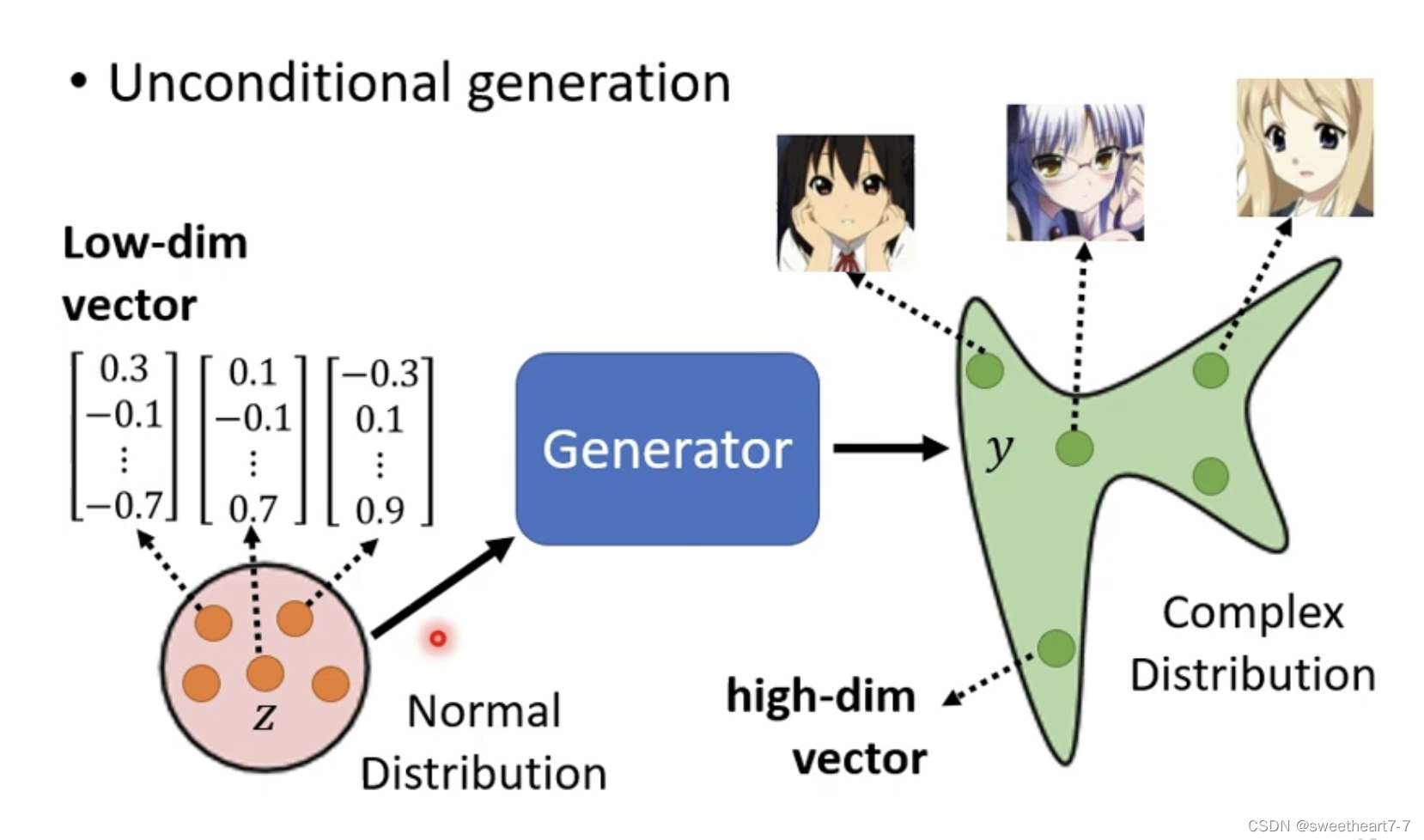

此时 Generator 它的输入就是 z,输出就是 y

假设 z 是从一个 normal distribution 中 sample 出来的向量(维度自定义)

输出是一个卡通图像(可以看成一个高维度的向量)

当输入不同时,输出也会改变。

Discriminator

除了 generator 外,还需要训练 discriminator(本质上也是一个 neural network)

它的作用是:拿一个图片作为输入,输出是一个数值(数字越大代表输入的图片越像是真实的二次元人物的图像)。

generator 和 discriminator 都是 neural network,它们的架构完全可以人为设计/选择(如:CNN、Transform)。

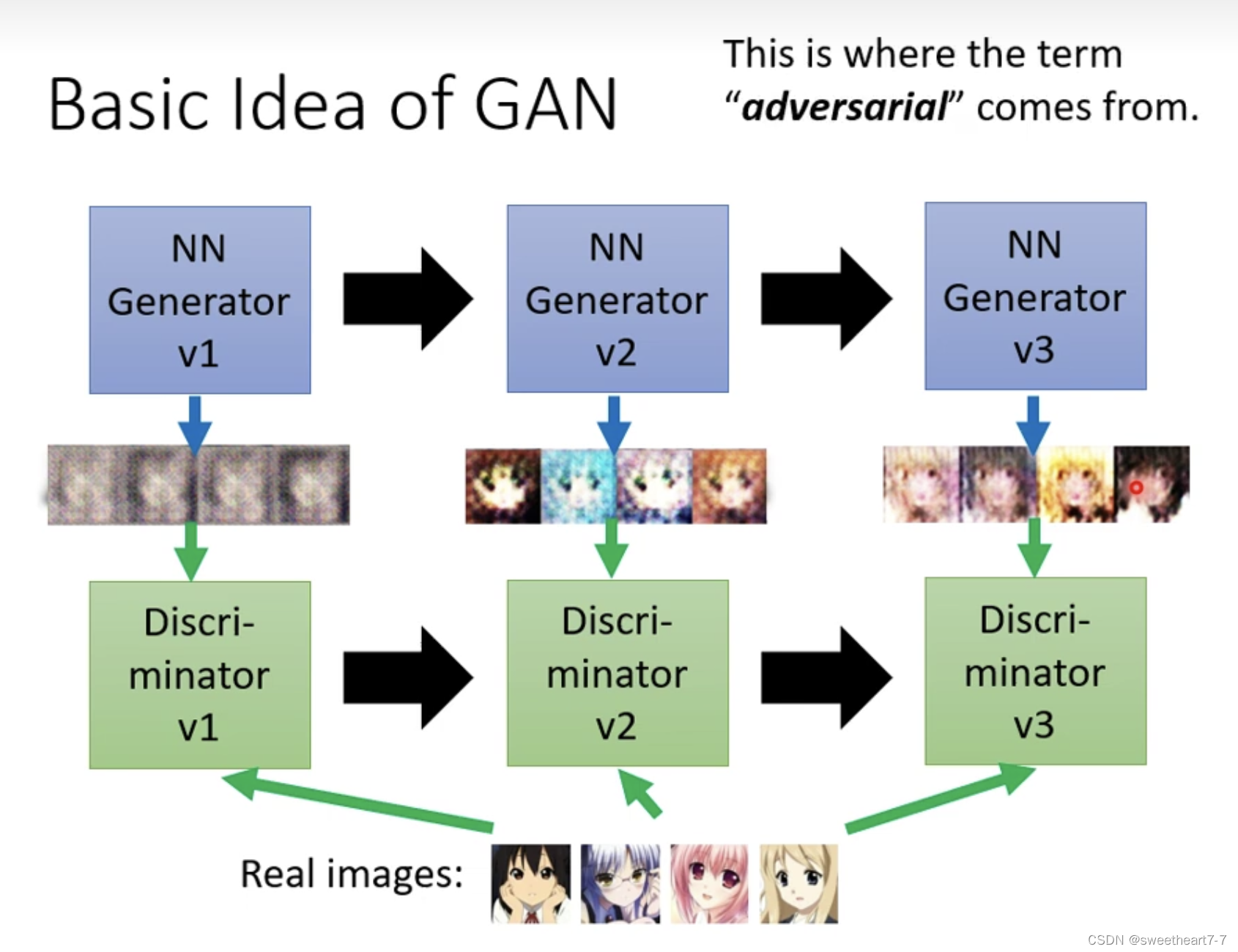

Basic Idea of GAN

直观上理解:generator 优化的目标是骗过 discriminator 的识别,而 discriminator 优化的目标是去更好的识别出 generator 生成的图像。

Algorithm

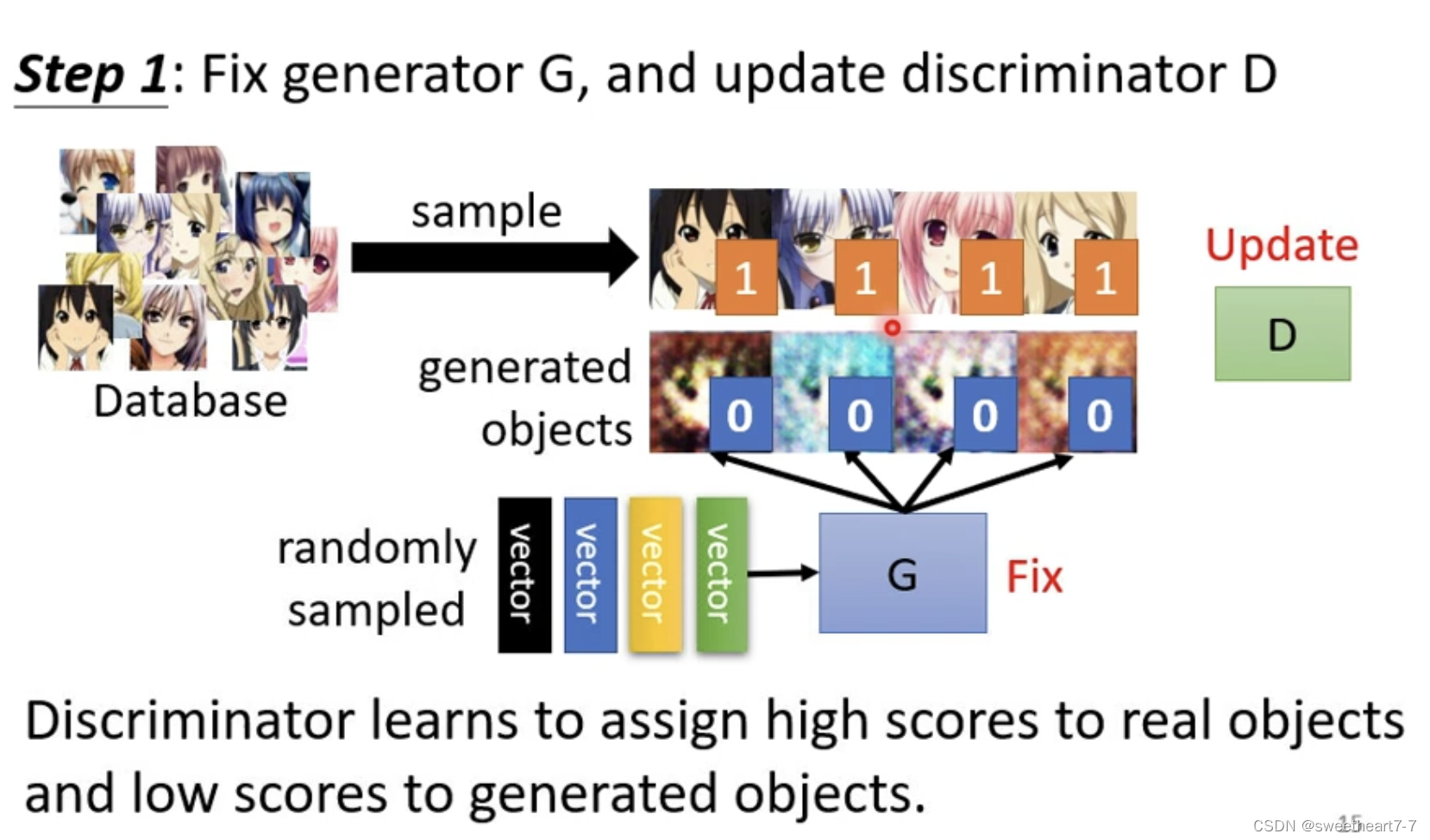

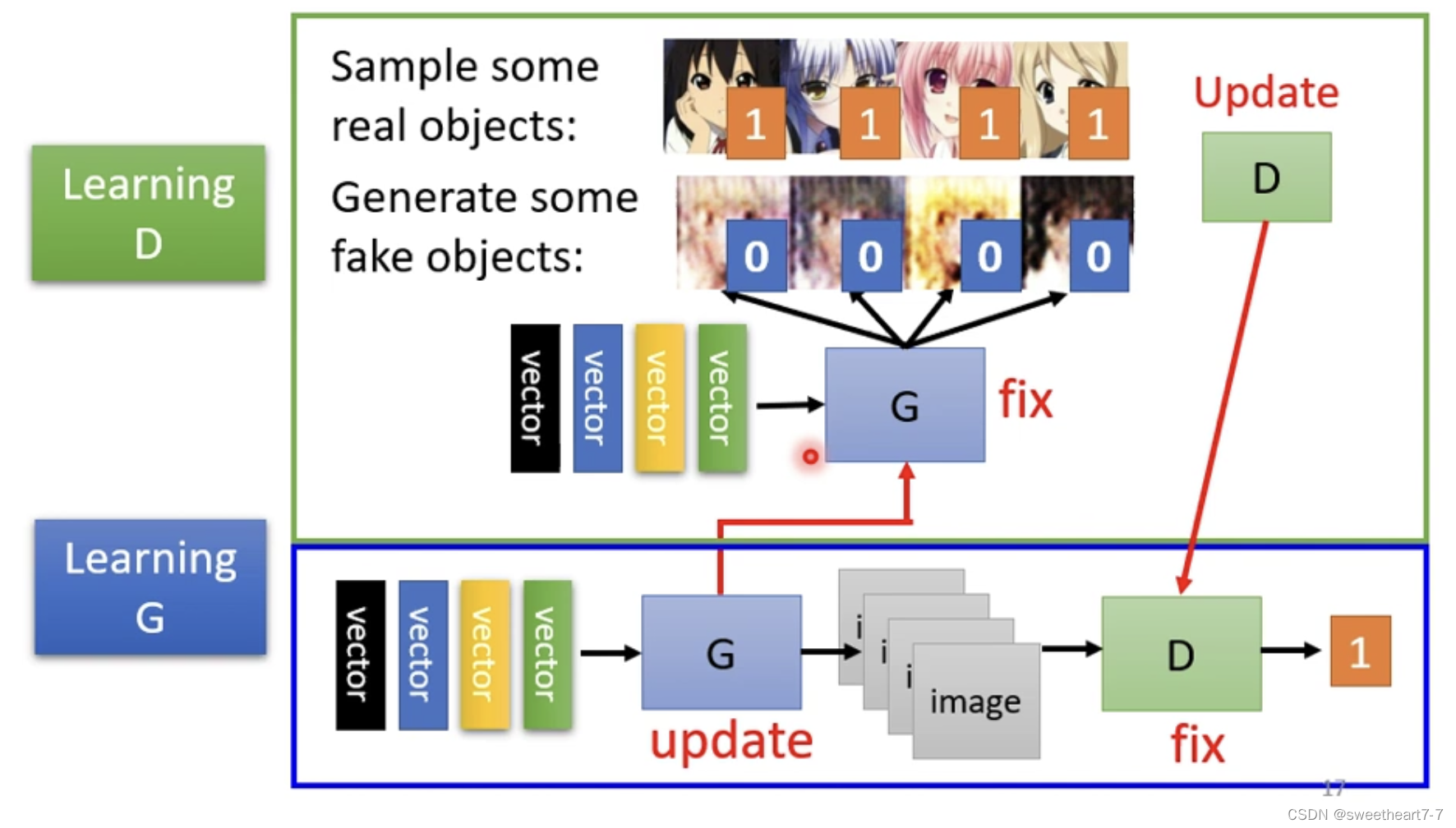

假设 Generator 和 Discriminator 的参数已经被初始化了。

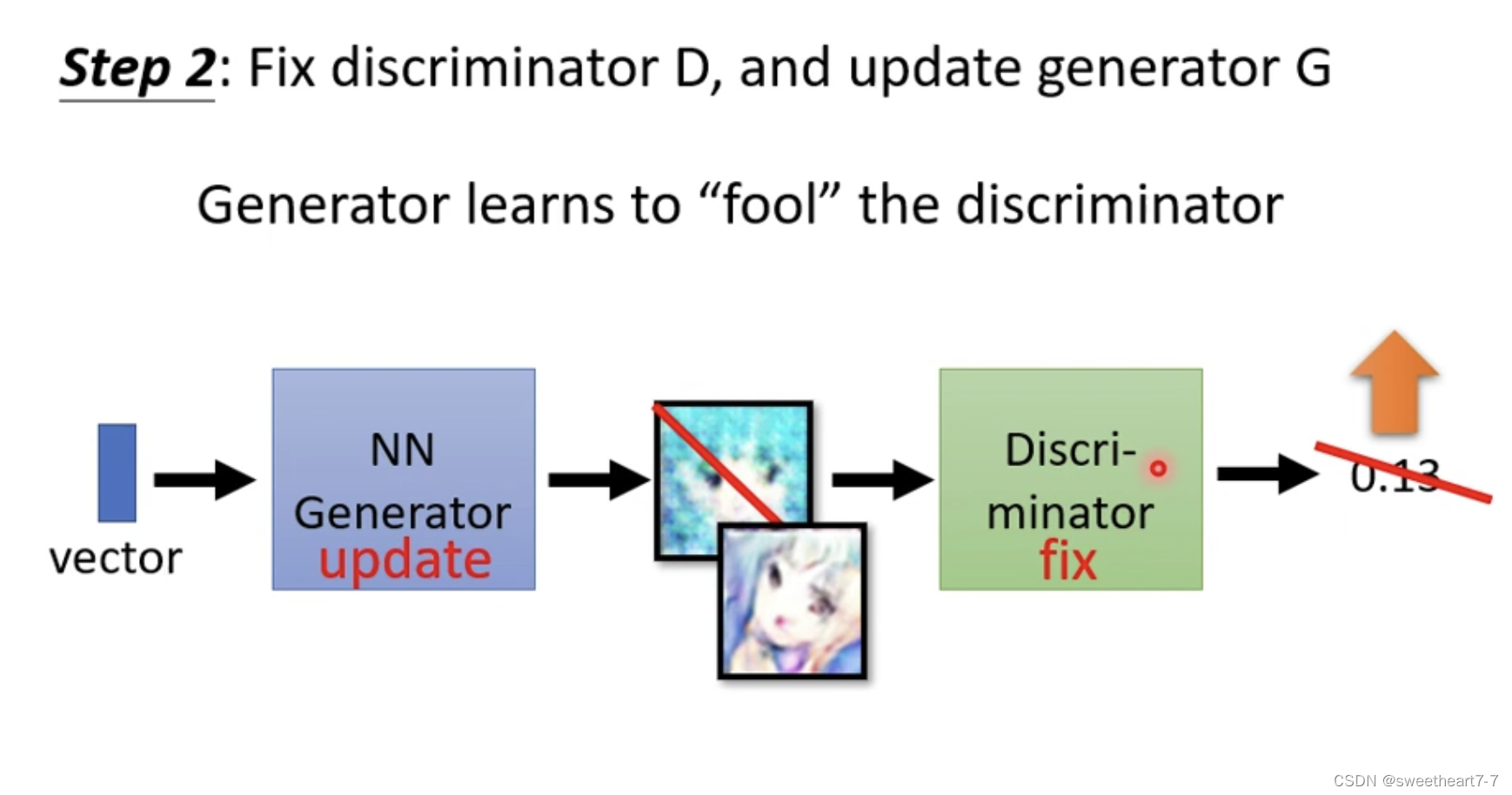

固定住 generator,只训练此时的 discriminator此时将随机产生的向量作为输入,输出的是很奇怪的一些图片

用真正的卡通图像跟 generator 产生出来的结果,去训练 discriminator(训练的目标是分辨真正的卡通图像与 generator 产生出来的卡通图像之间的差异)

Theory behind GAN

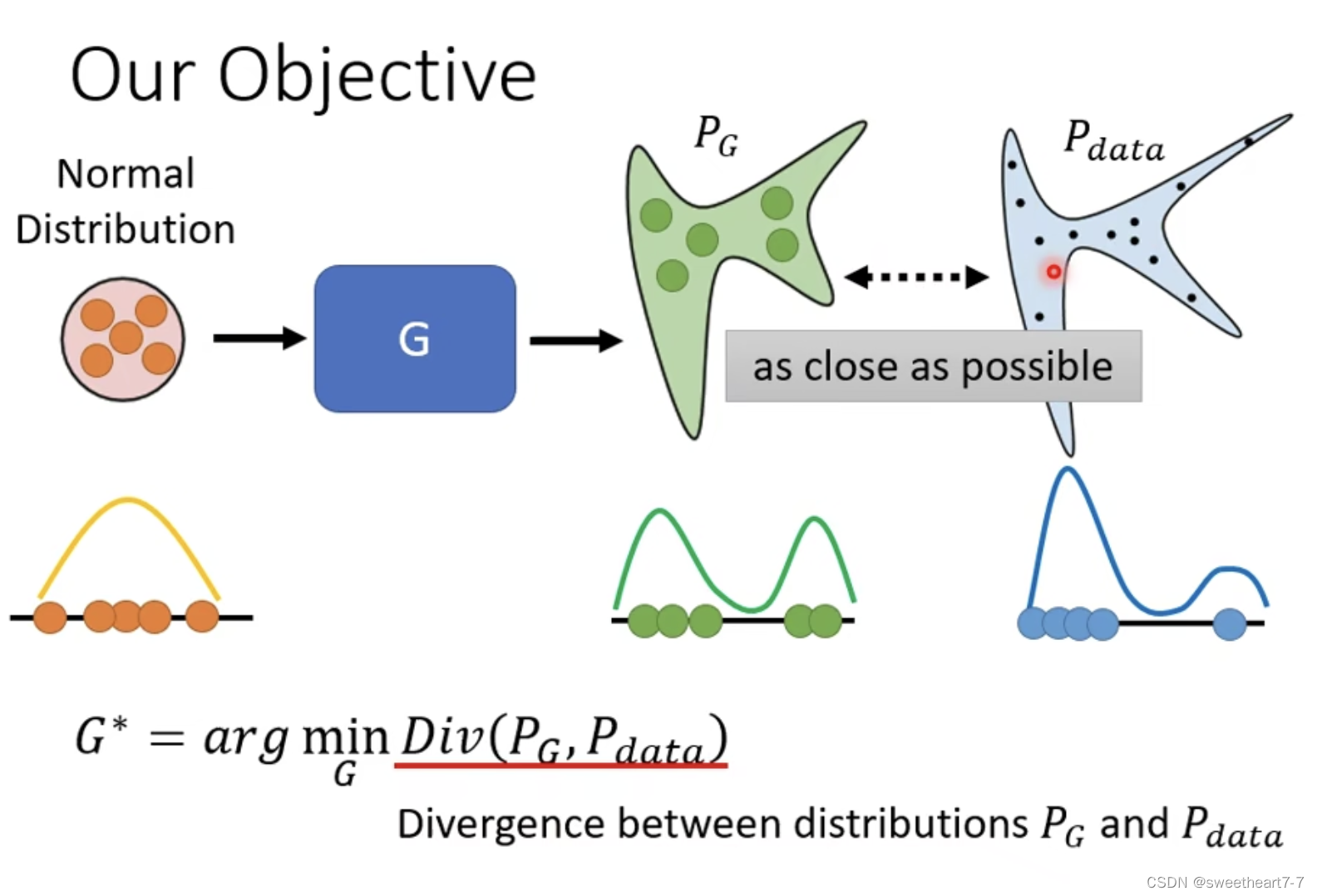

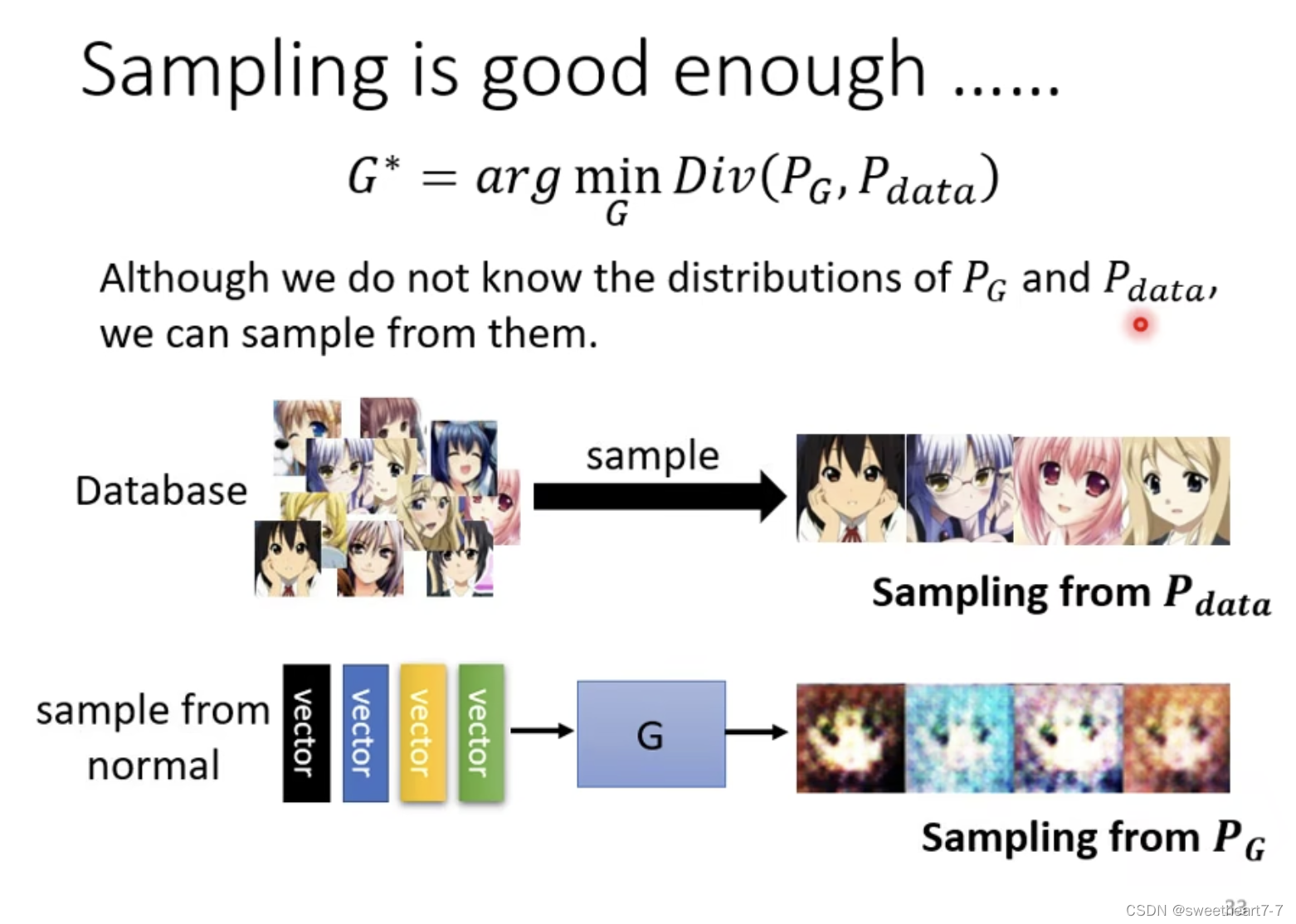

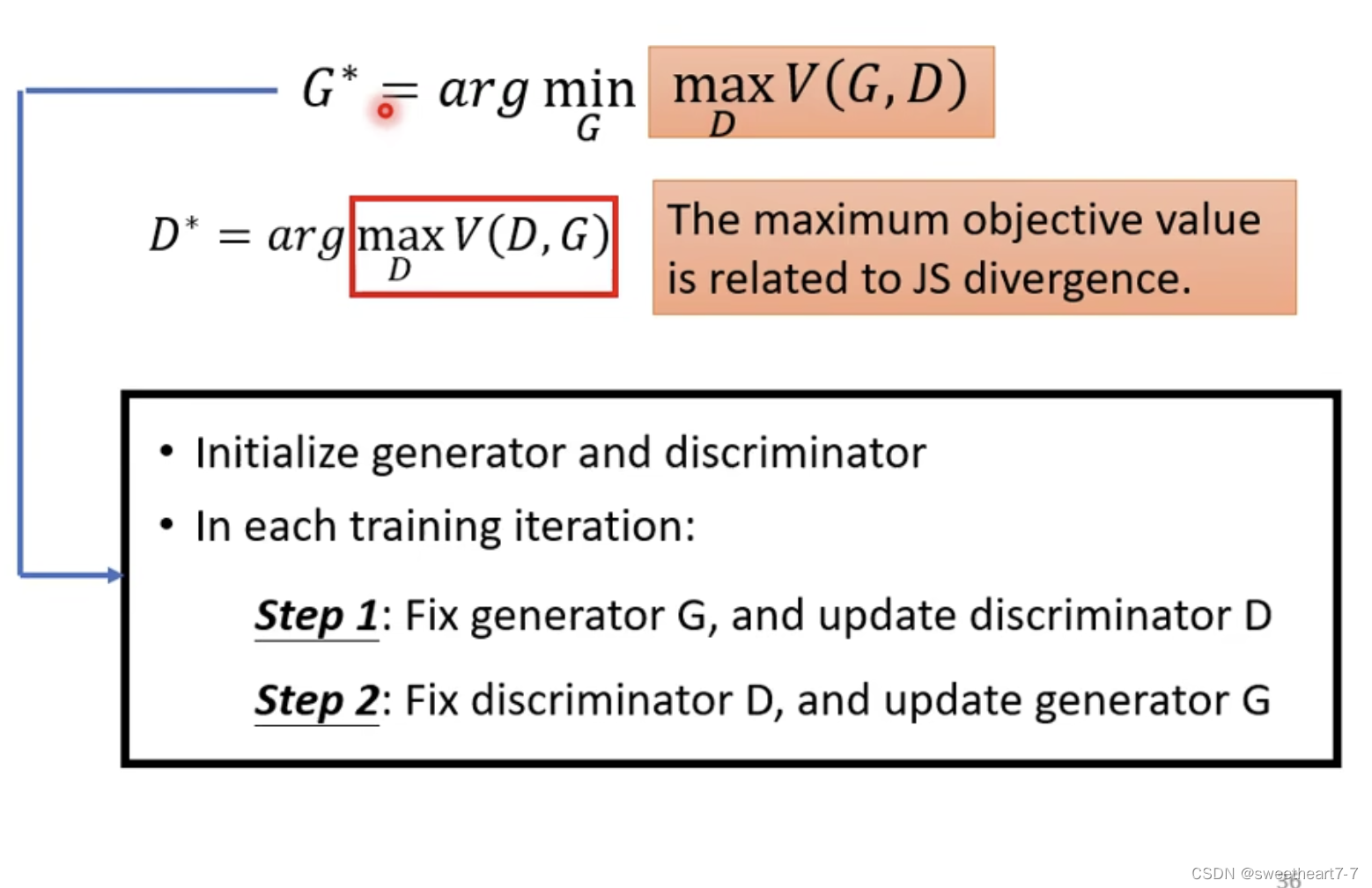

将 Normal Distribution 随机生成一堆 vector,丢到 Generator 以后,会产生一个比较复杂的 Distribution(叫做 PG),真正的 Data 也形成了另外一个 Distribution,叫做 Pdata,我们期待 PG 跟 Pdata 越接近越好。

此时的 Loss function 可以理解为 PG 和 Pdata 的 divergence

通过 smaple 出来的数据来估测 Divergence

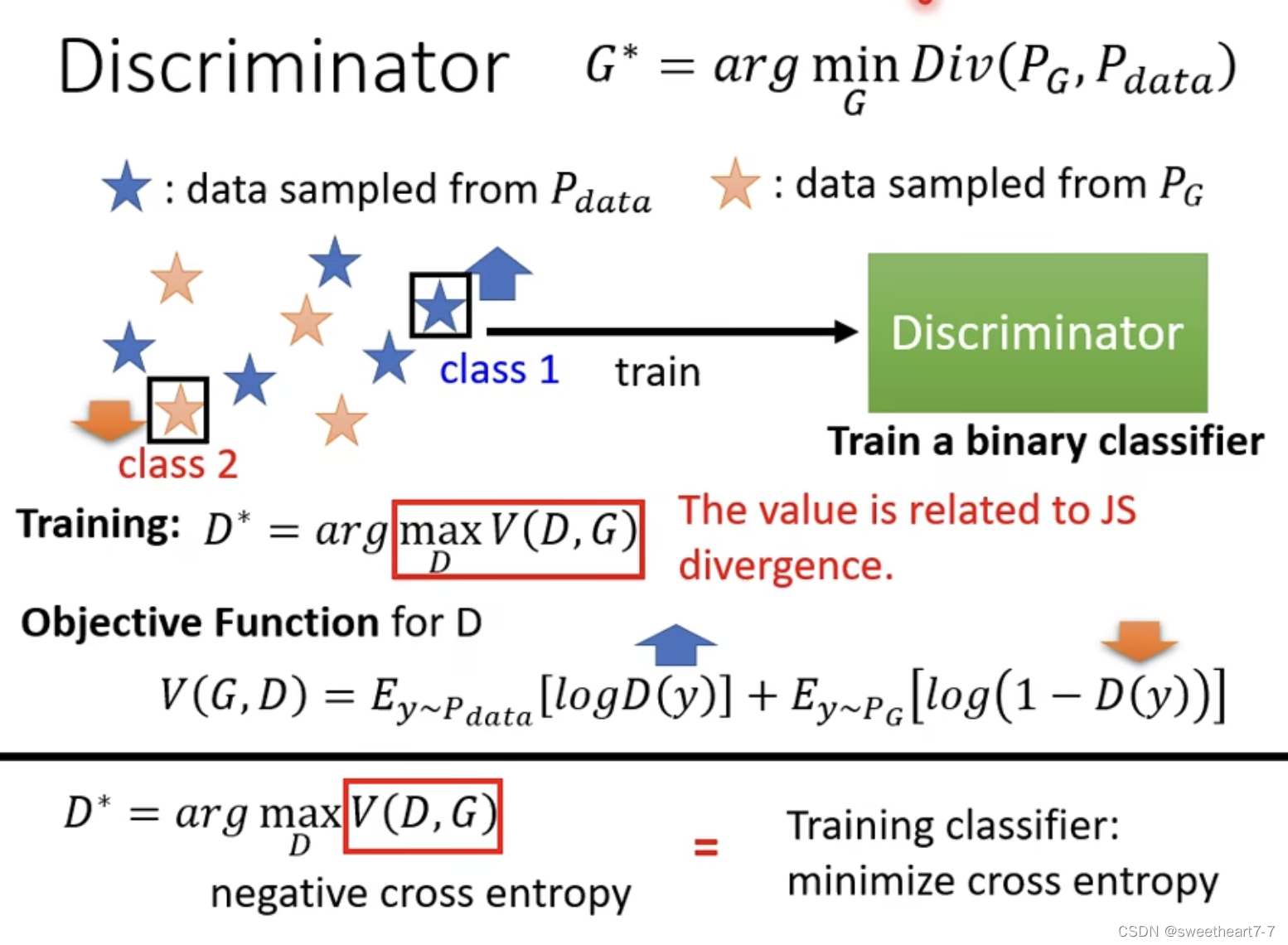

Discriminator 训练的目标:给来自 Pdata 的数据更高的分数,给来自 PG 的数据更低的分数。

最大化 Object function 这个 V,相当于要让前面的来自 Pdata 的 y 的 D(y) 越大越好,后面的来自 PG 的 y 的 D(y) 越小越好。(等同于 Minimize Cross Entropy,当作训练一个 Classifier)

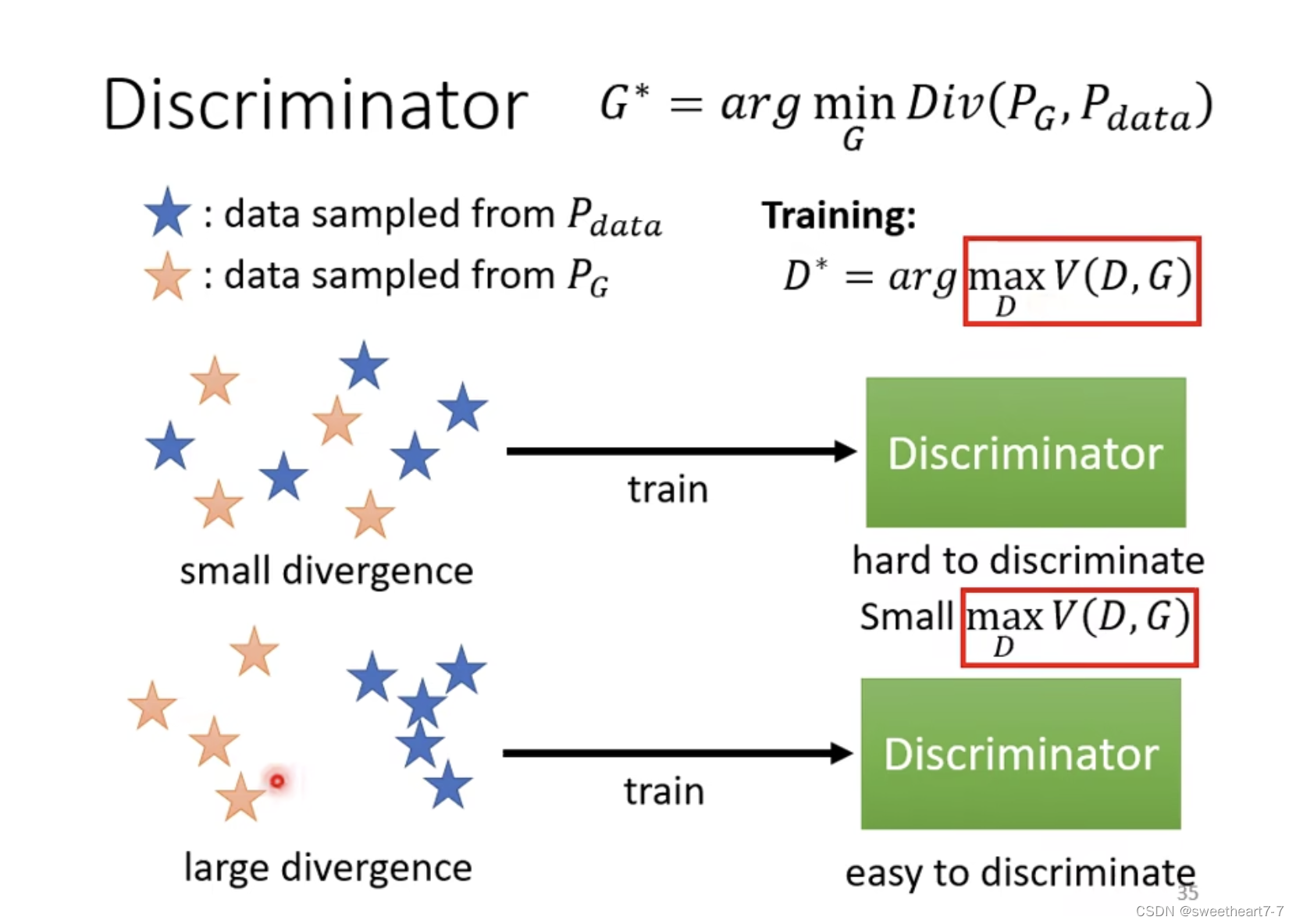

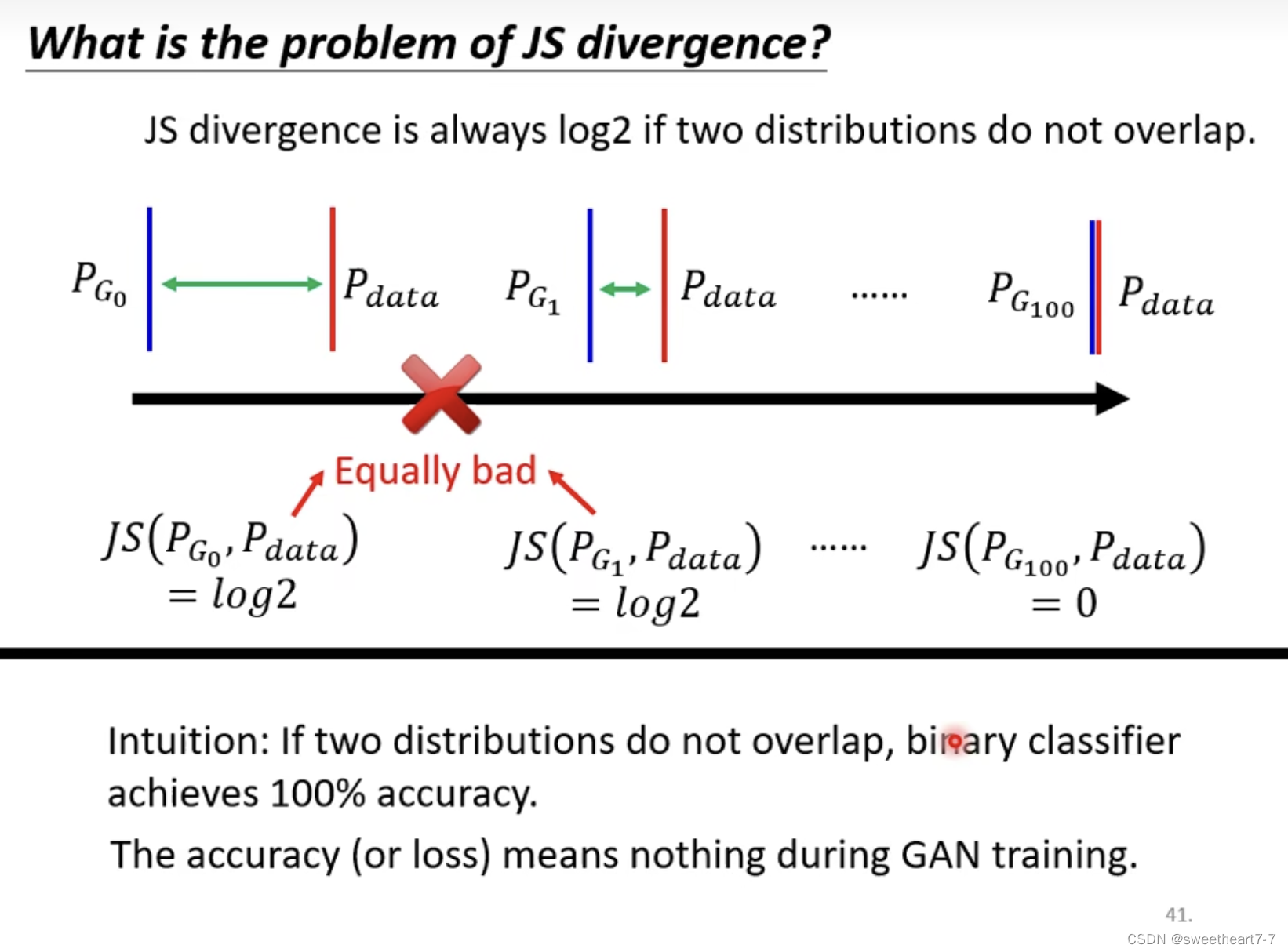

小的 divergence 对应小的 Object Fuction 的 Maximum 值:小的 divergence 说明 PG 和 Pdata 很像,对 discriminator (train 一个 binary 的 classifier)来说,这两对资料是混在一起的,那就很难分开,这个问题就很难,在解这个 Optiminzation Problem 的时候,就没有办法让这个 Objective 的值非常地大,所以 这个 Objective V 的 Maximum 的值就比较小。

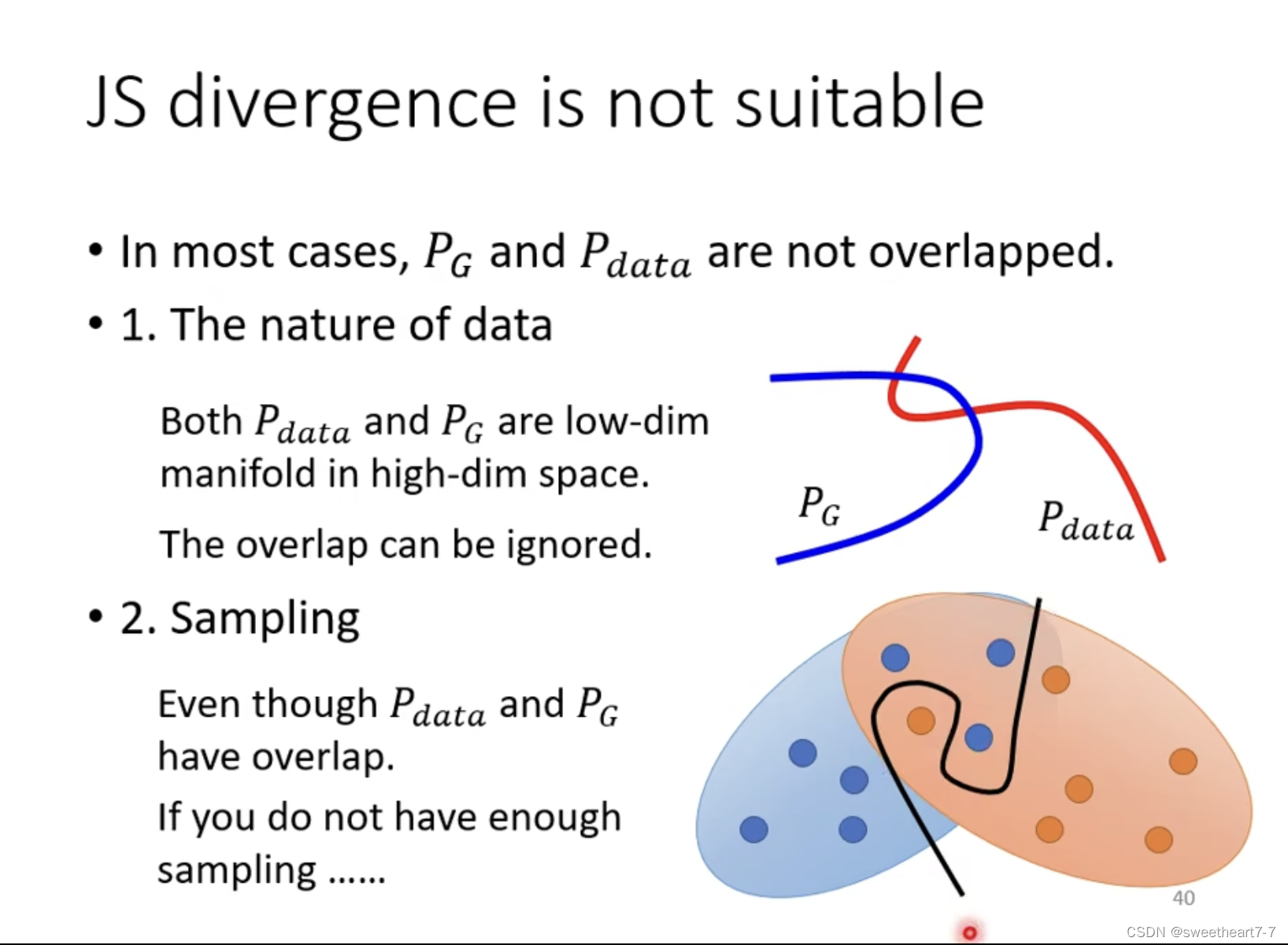

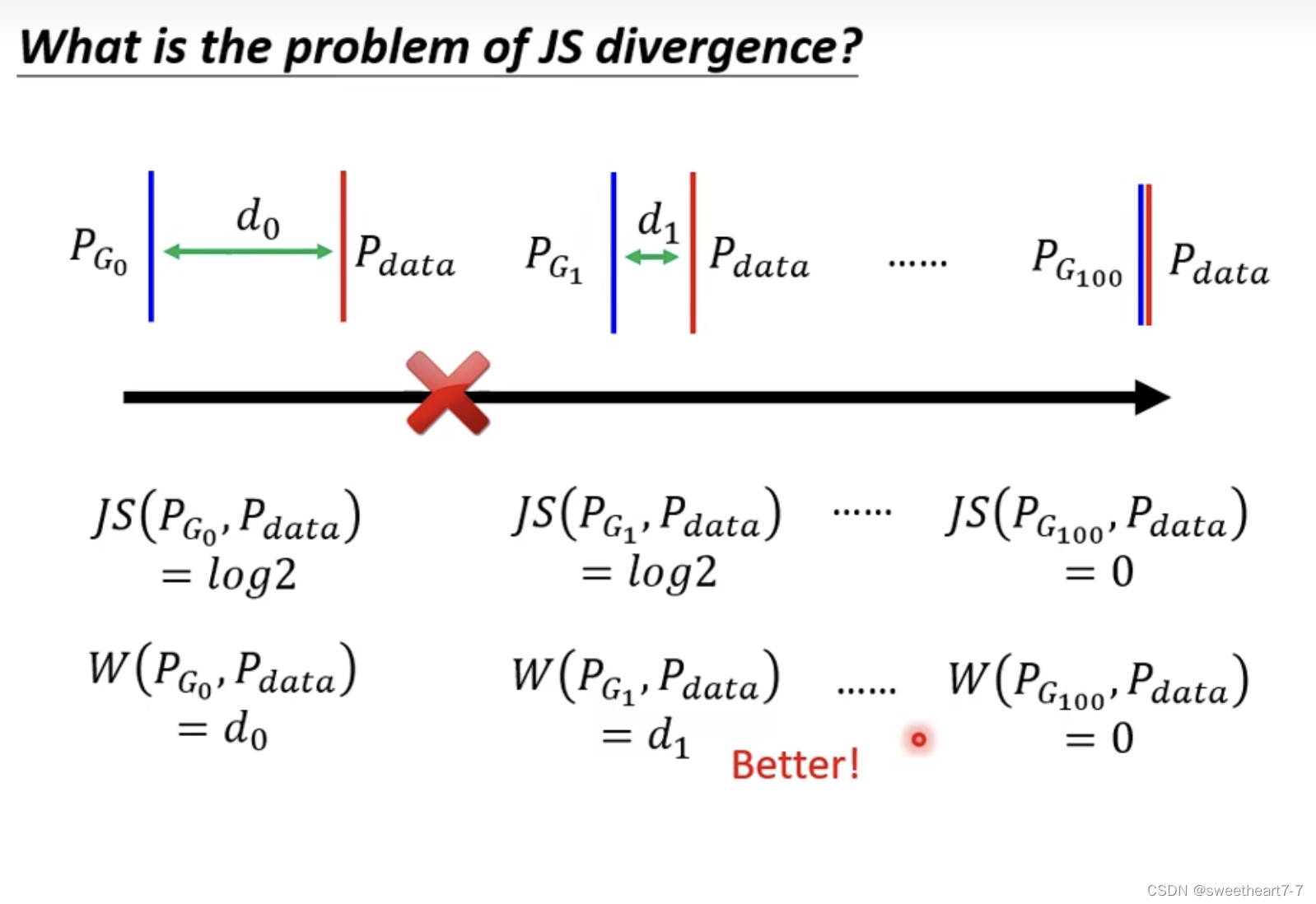

JS divergence 的问题

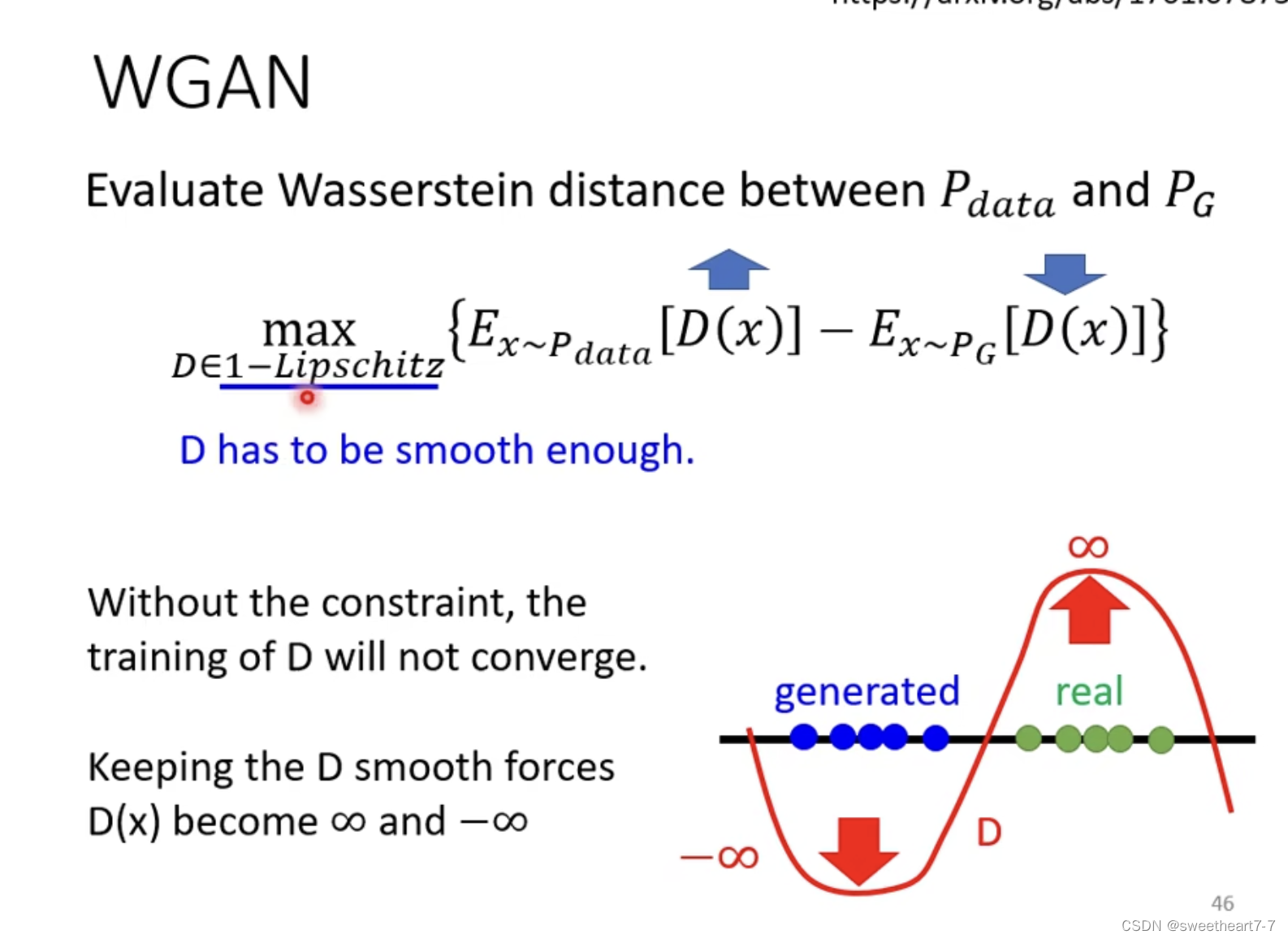

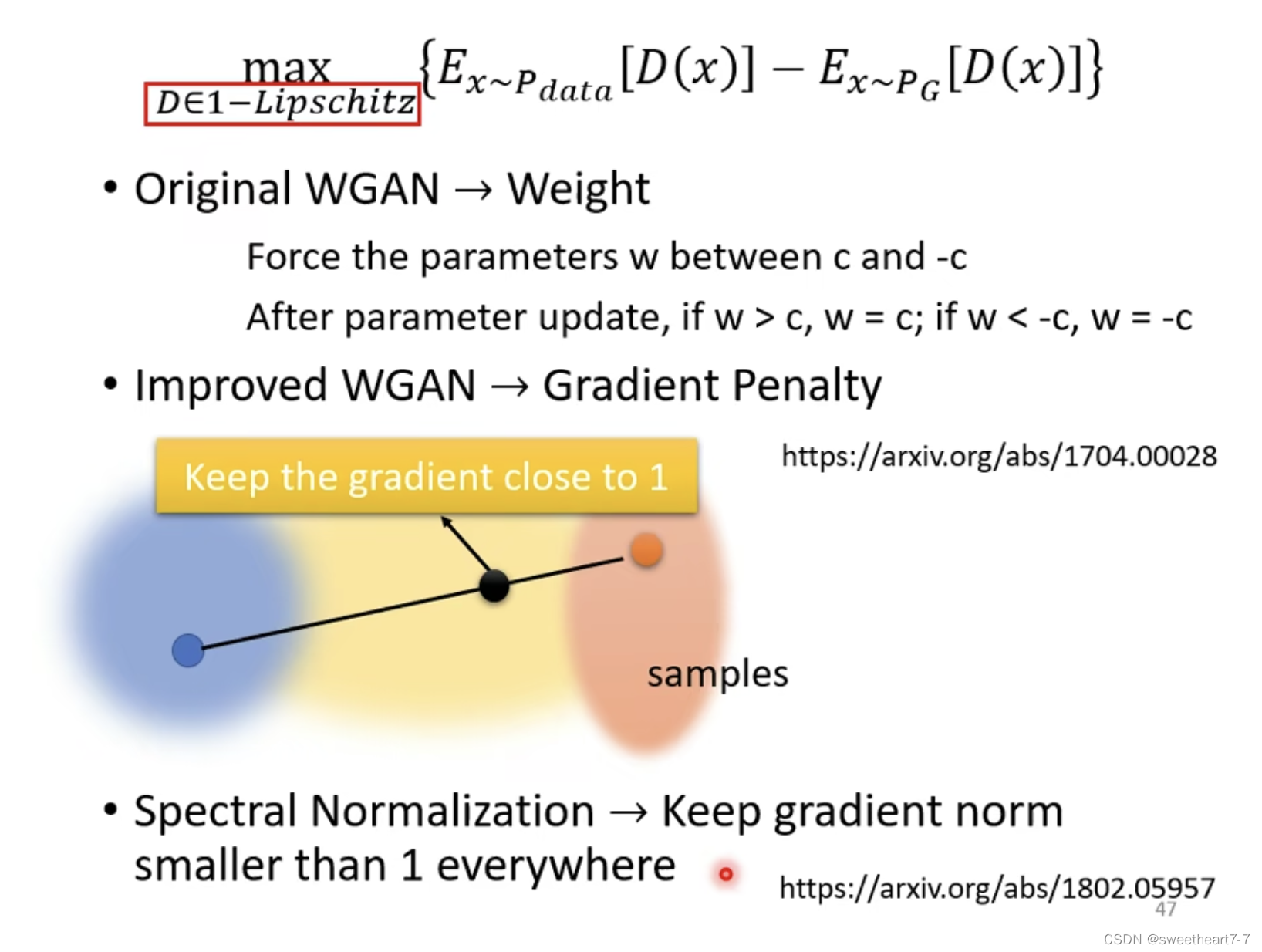

WGAN

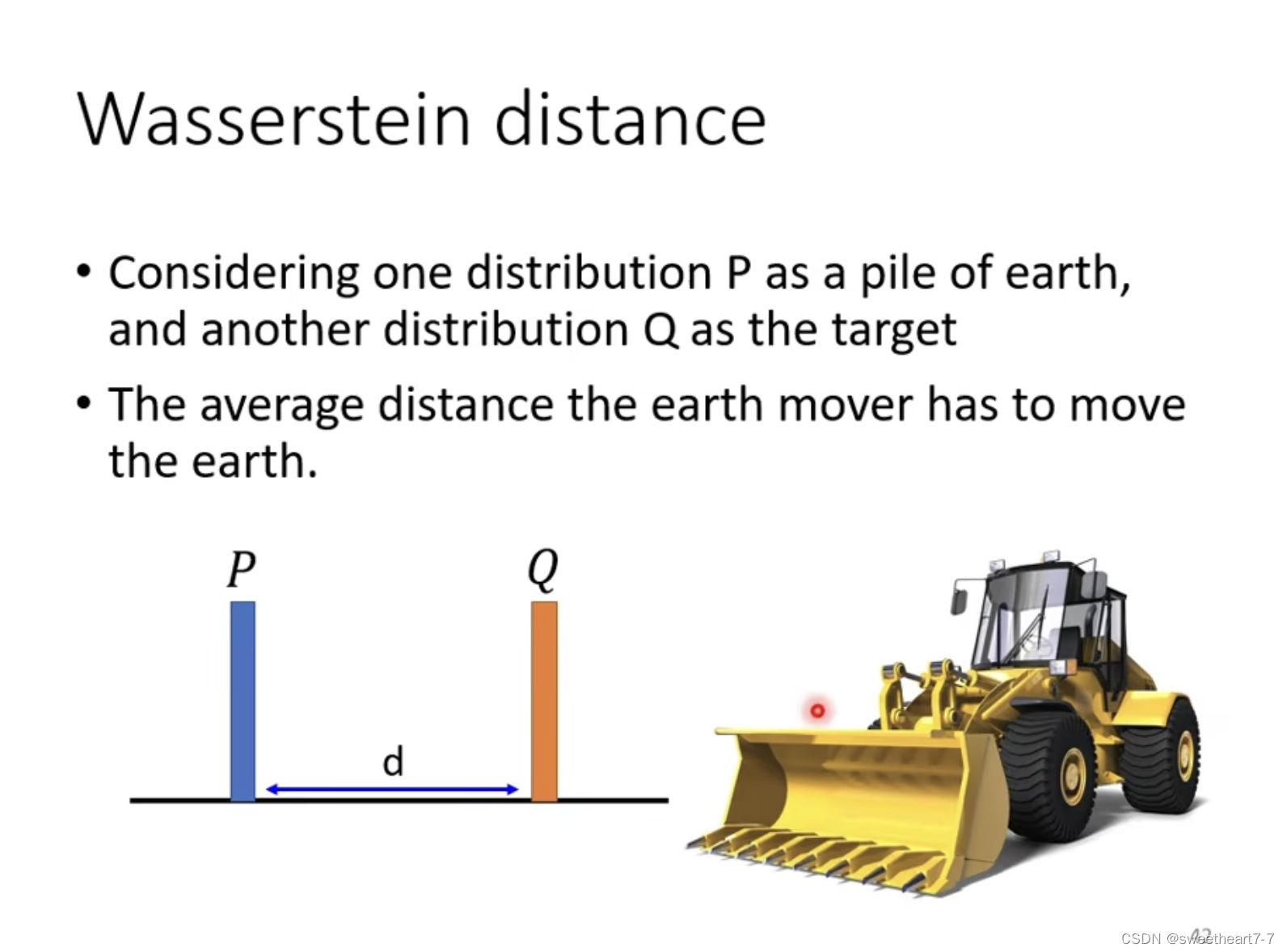

用 Wasserstein distance 代替 JS divergence

Wasserstein distance

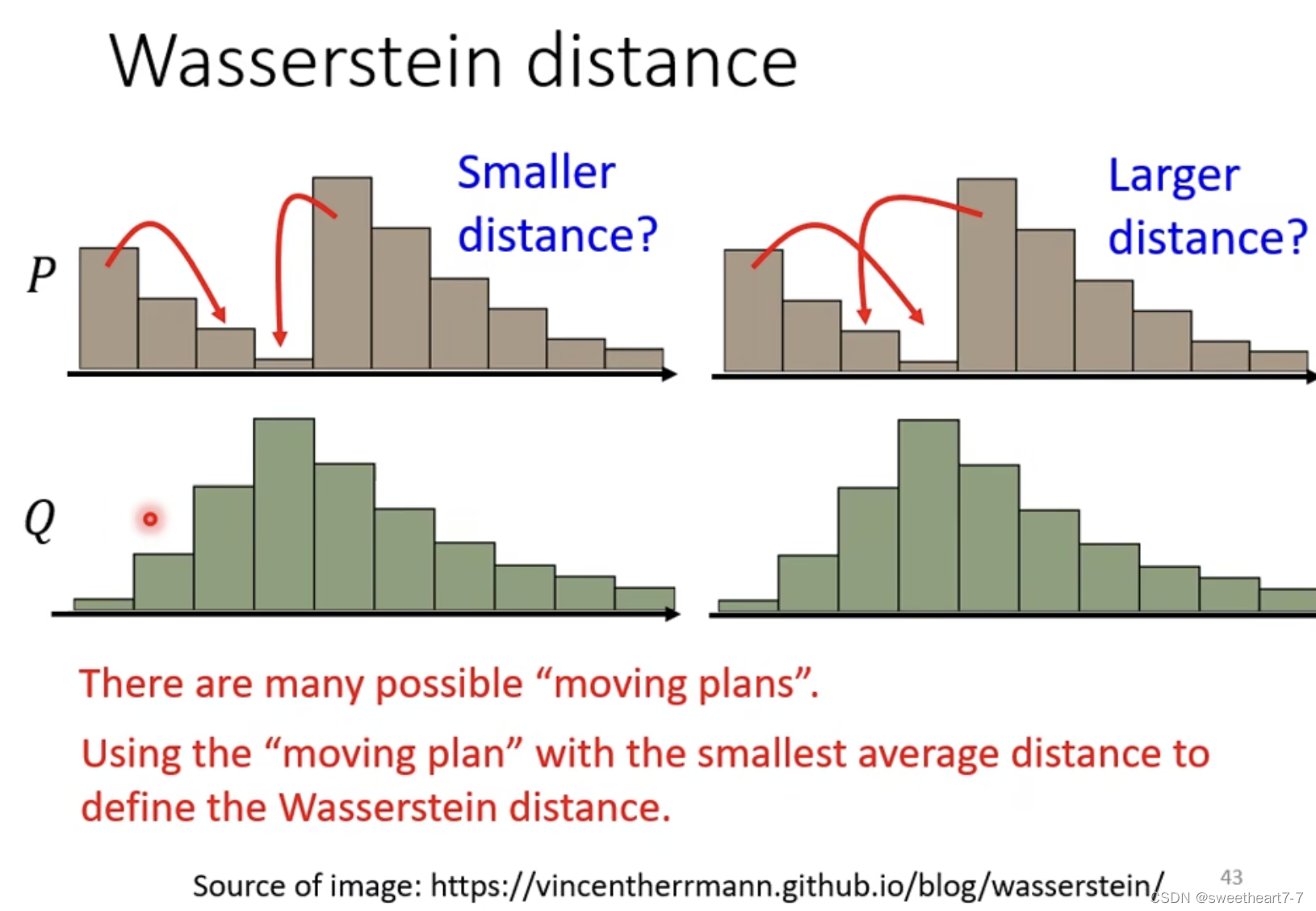

可以理解为用推土机将 P 推到 Q 的距离

可能有多种移动方法,Wd 需要用最小的一种来定义

Wasserstein distance 如何计算:

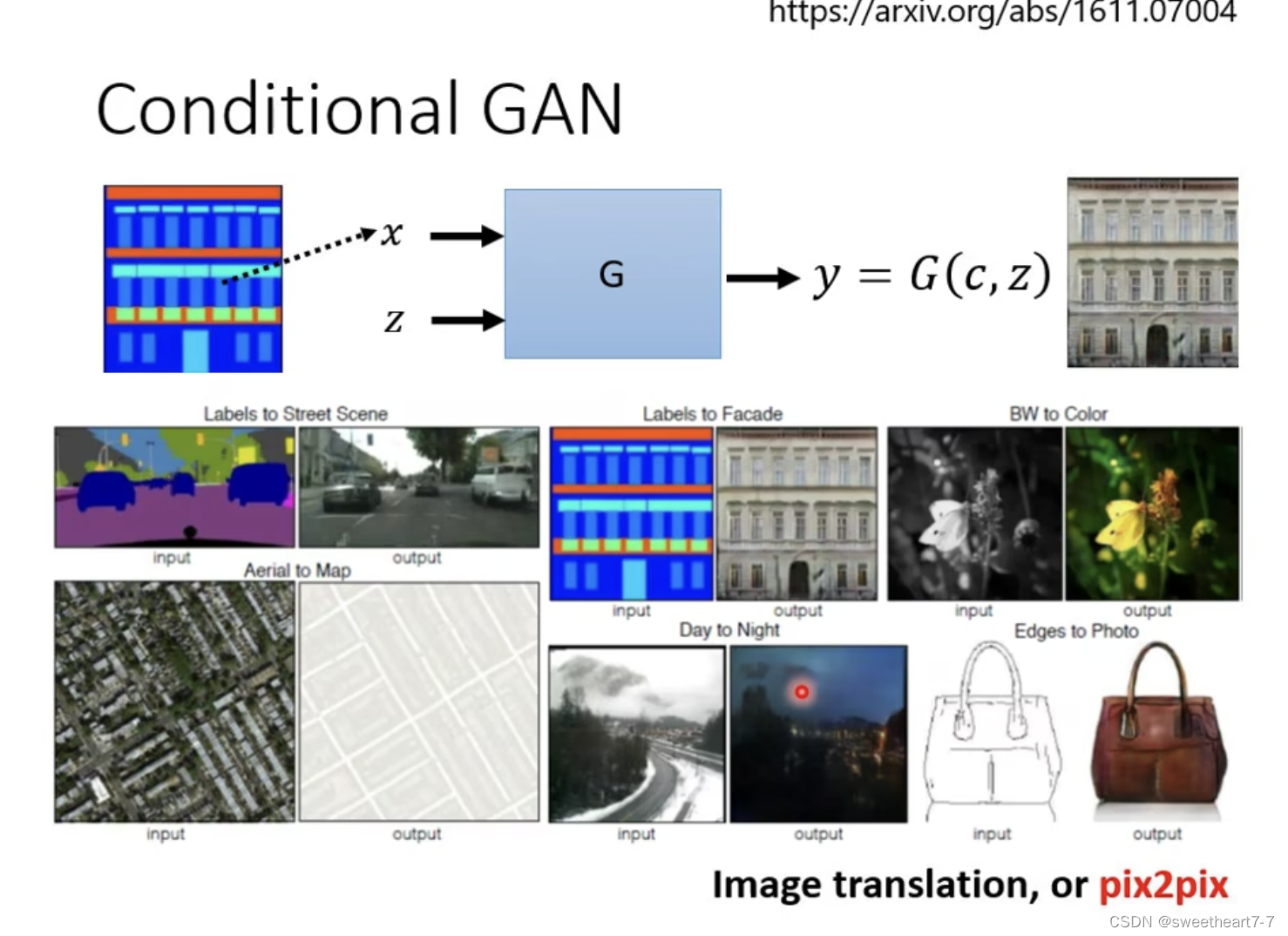

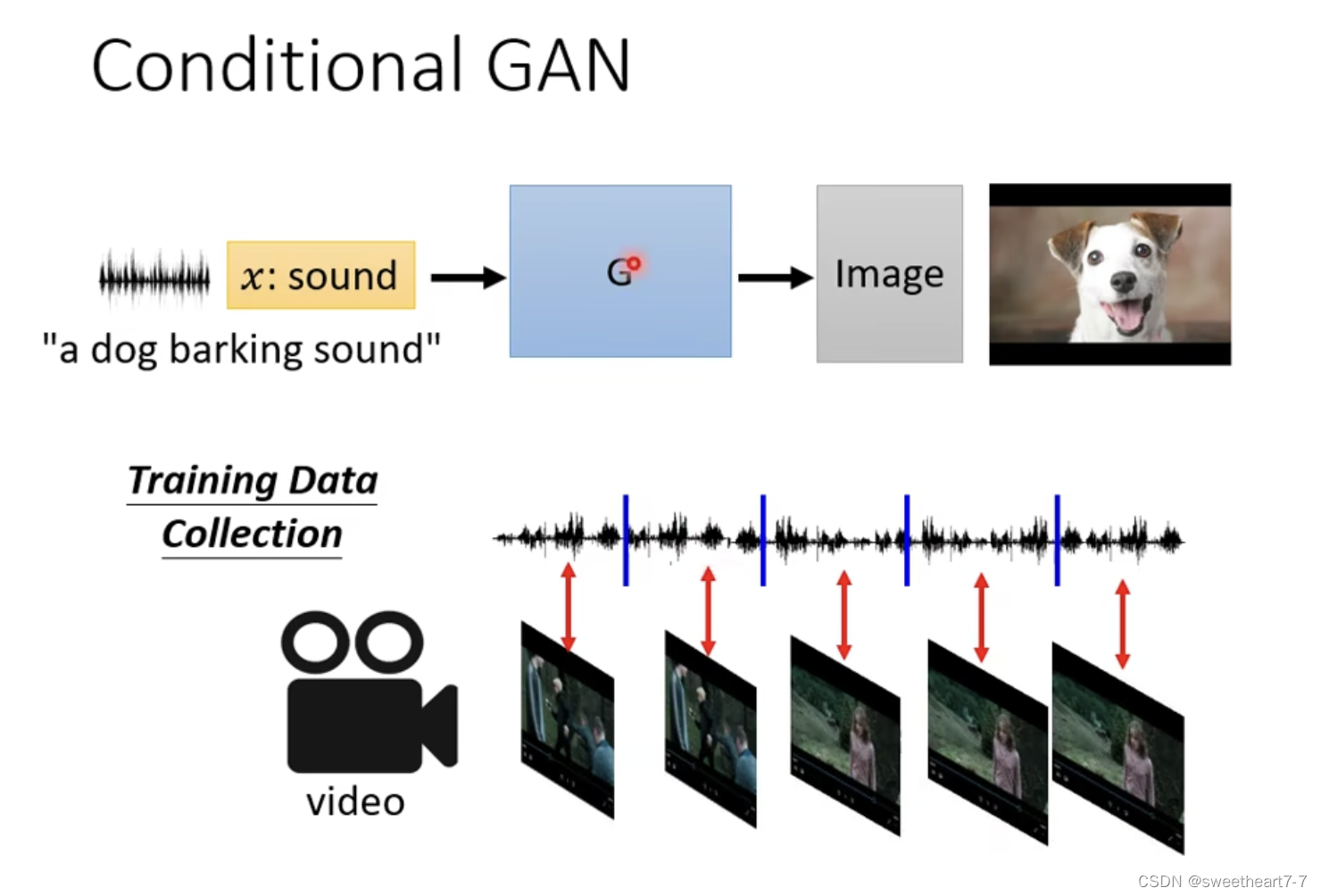

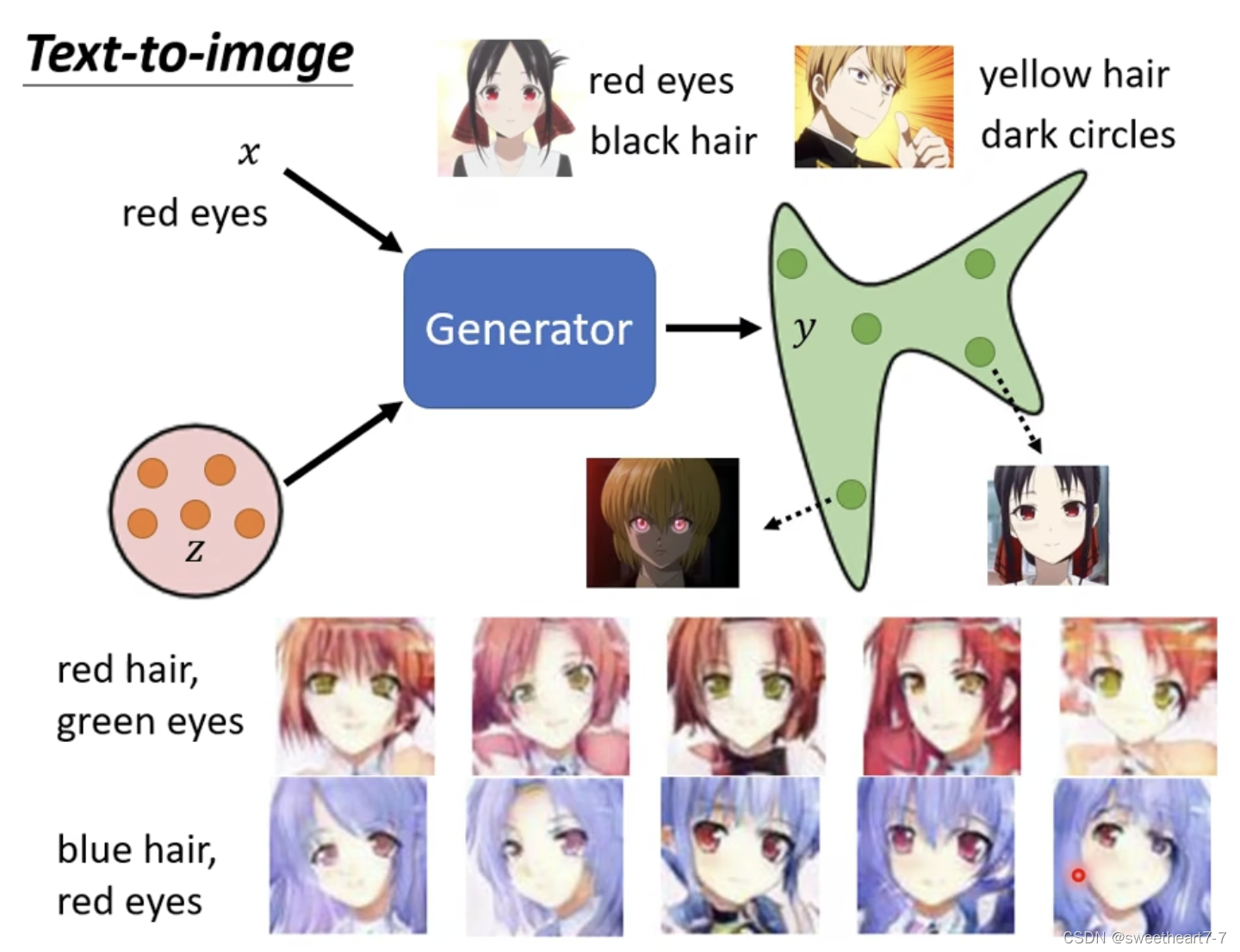

Conditional Generation

之前的 Generator 的输入都是一个随机的分布,而 Conditional Generation 是为了操控 Generator 的输出。给 Generator 一个 x 让其根据 x 和 z 来产生 y

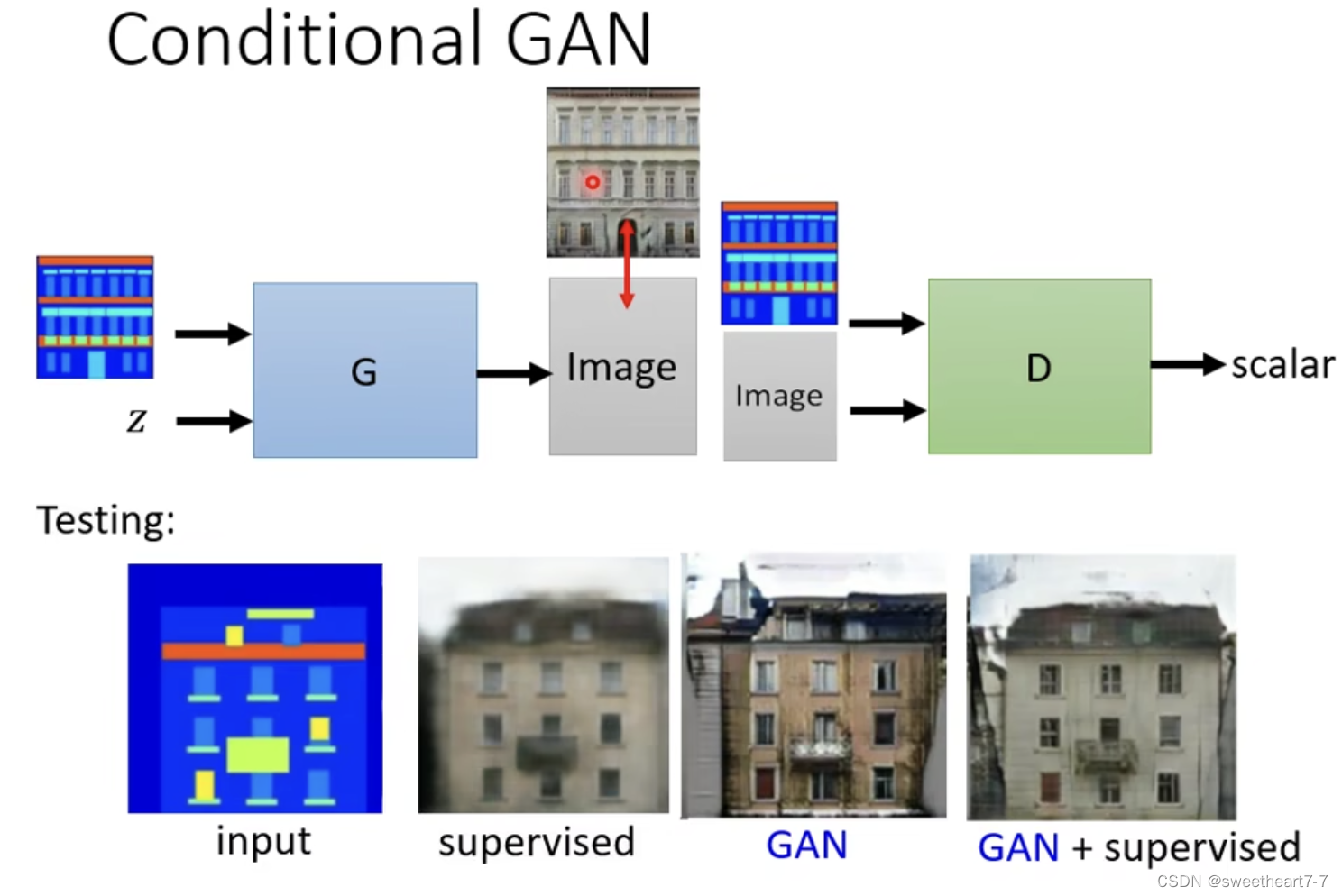

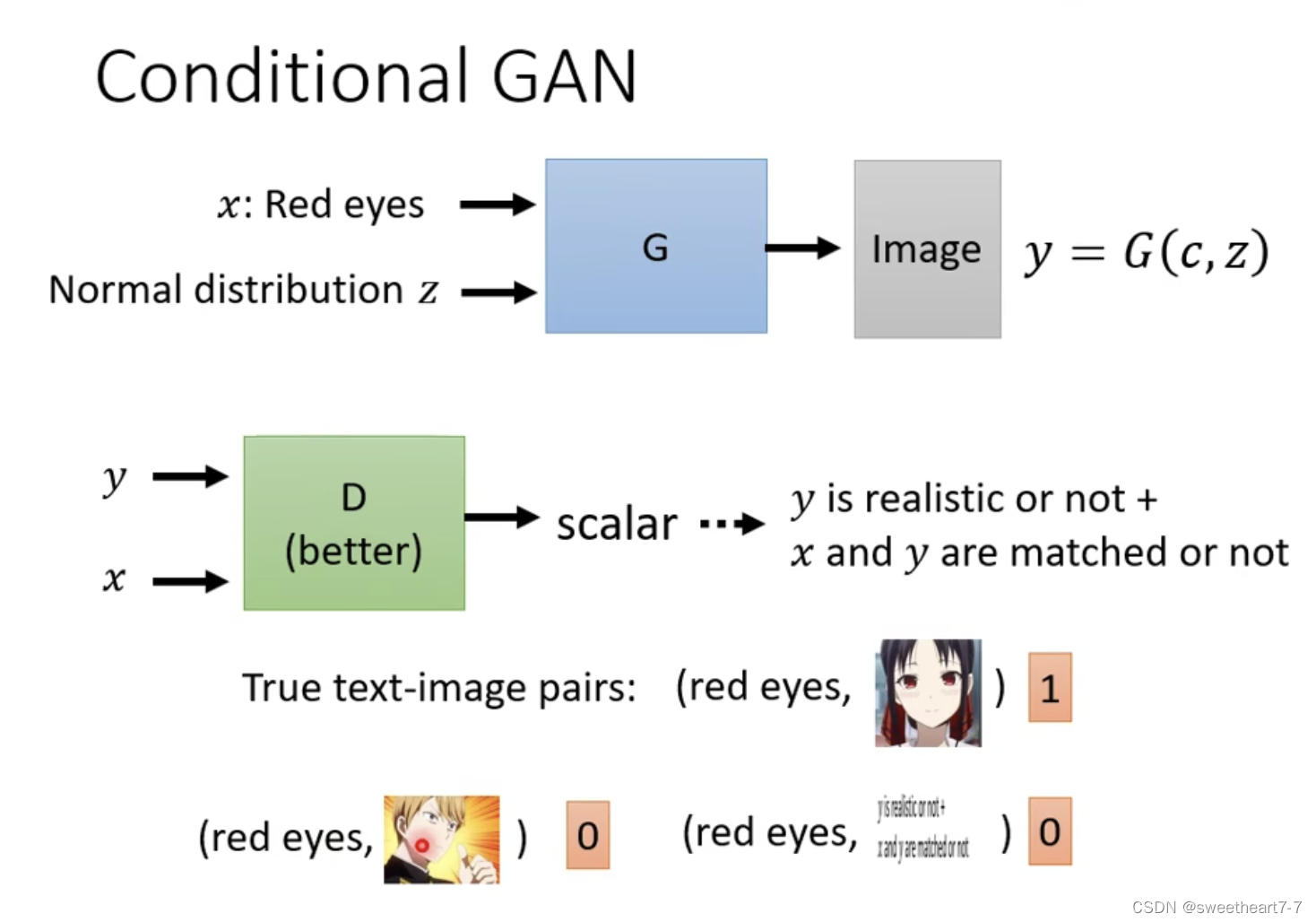

Conditional GAN

discriminator 训练:需要将 y 和 x 都作为输入,然后产生一个数值(图片辨别 + 图片跟文字匹配)

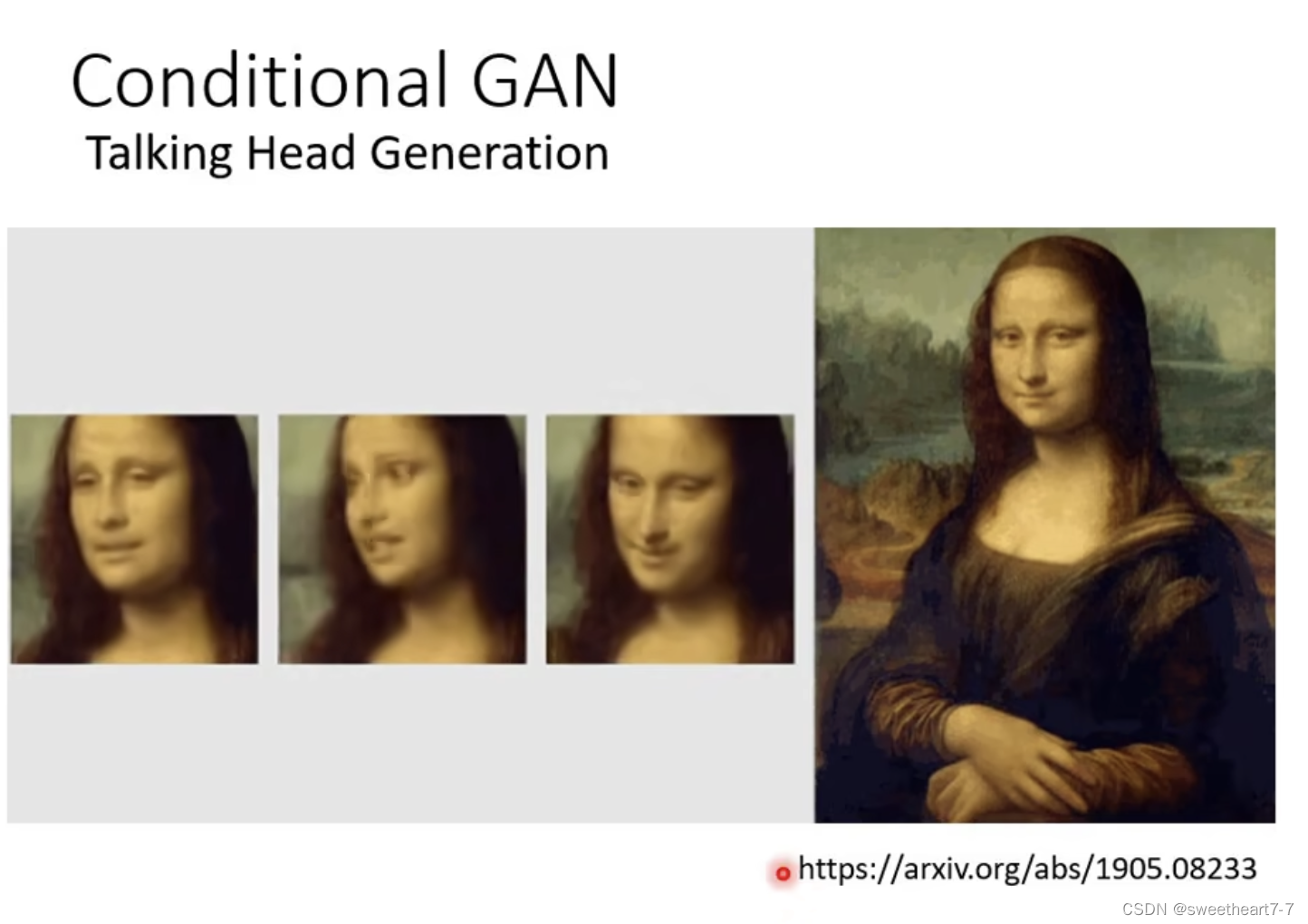

应用: