刚刚参加完大数据技能竞赛,回到学校立刻就开启了计算机设计大赛,时间非常仓促,所以这个项目只能一边设计一边开发。12天的速成品,就只能这样啦。

这个项目主要主题是岗位分析,分析用户的期待岗位,为用户生成个人报告。

在很多招聘平台上,岗位大多以列表的形式展示,用户只能看到局部文字数据,如果需要查看多个城市相同岗位之间的差异,就要定位到另一个城市,对于我这个记忆力不太好的人来说不是很方便。所以就有了这个项目。

下面这个就是首页外层的说明页,是不是感觉有点高逼格?(其实并没有)

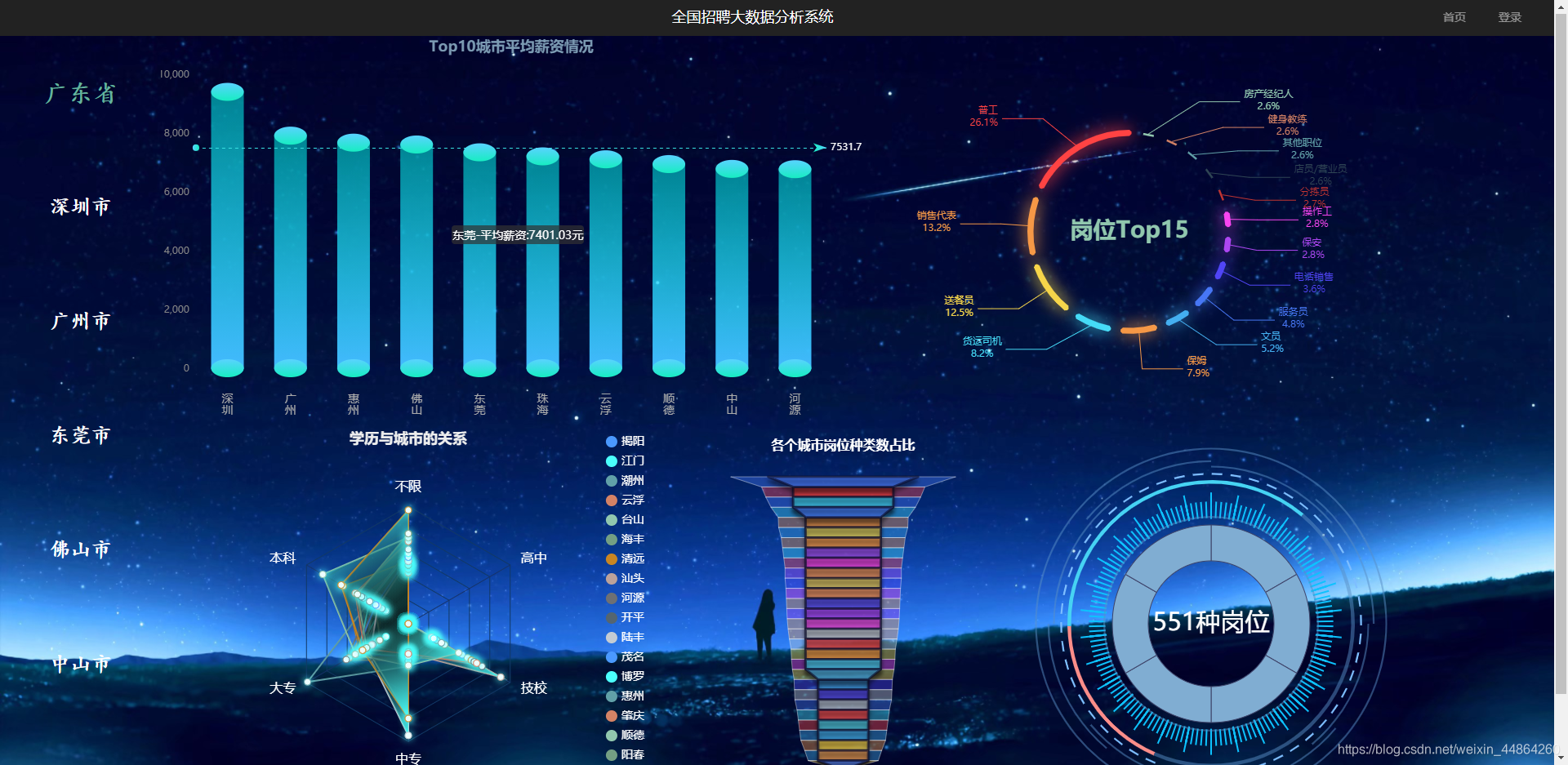

这是点击进入之后的主页,可以看到各个省份的平均薪资信息,中间的地图和右边的柱状图都是可以点击的,如果想要了解某个城市的话,就点击进去。

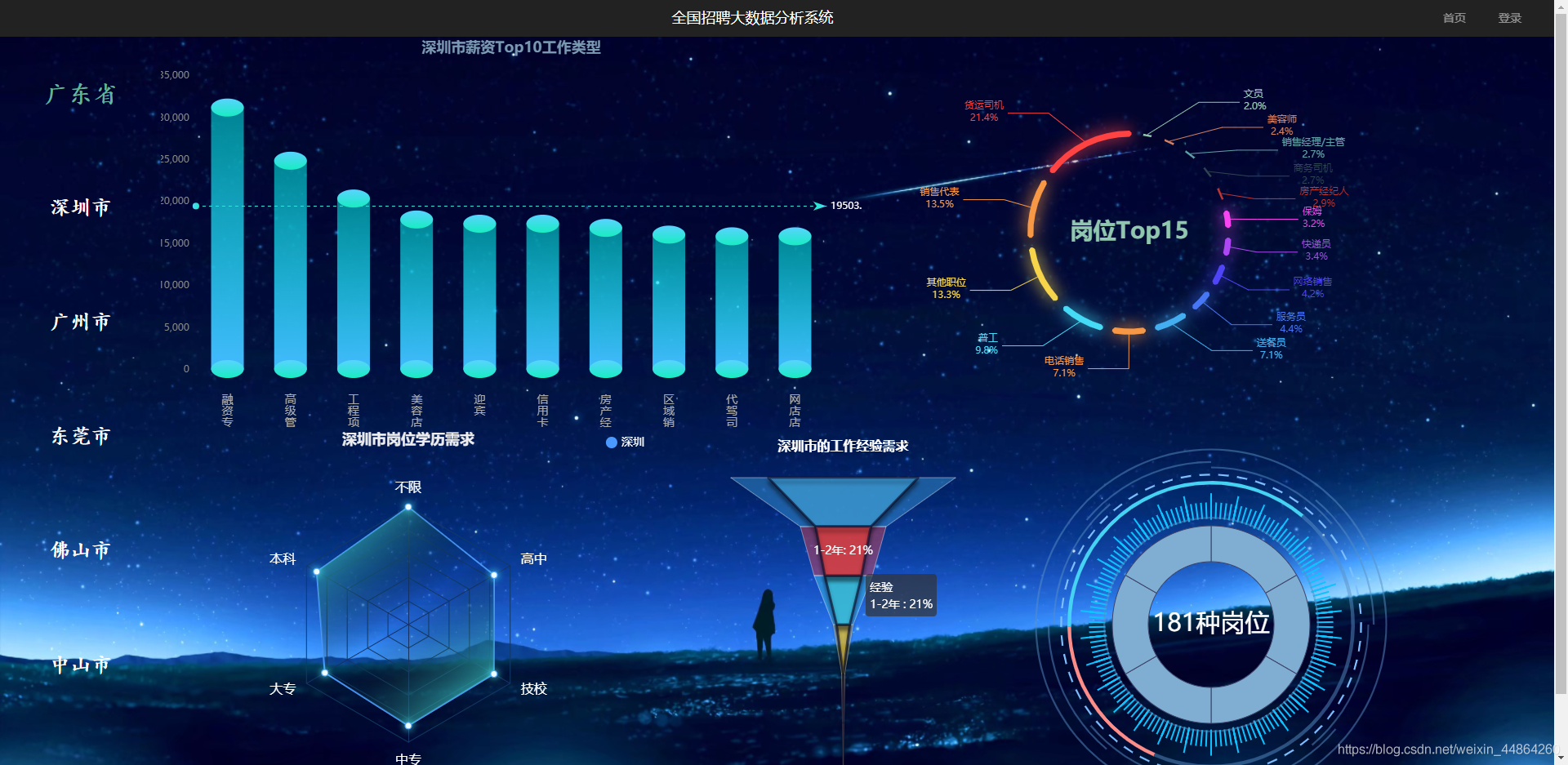

点击了某个省份之后,就可以查看这个省份以及这个省份的城市的岗位信息。

以上的都是没登录状态可以看到的,现在展示登录情况下新增的个人报告,噢忘记了,我还没有账号,那就先注册去了。

然后登录一下哎

登录之后导航栏就新增两个模块

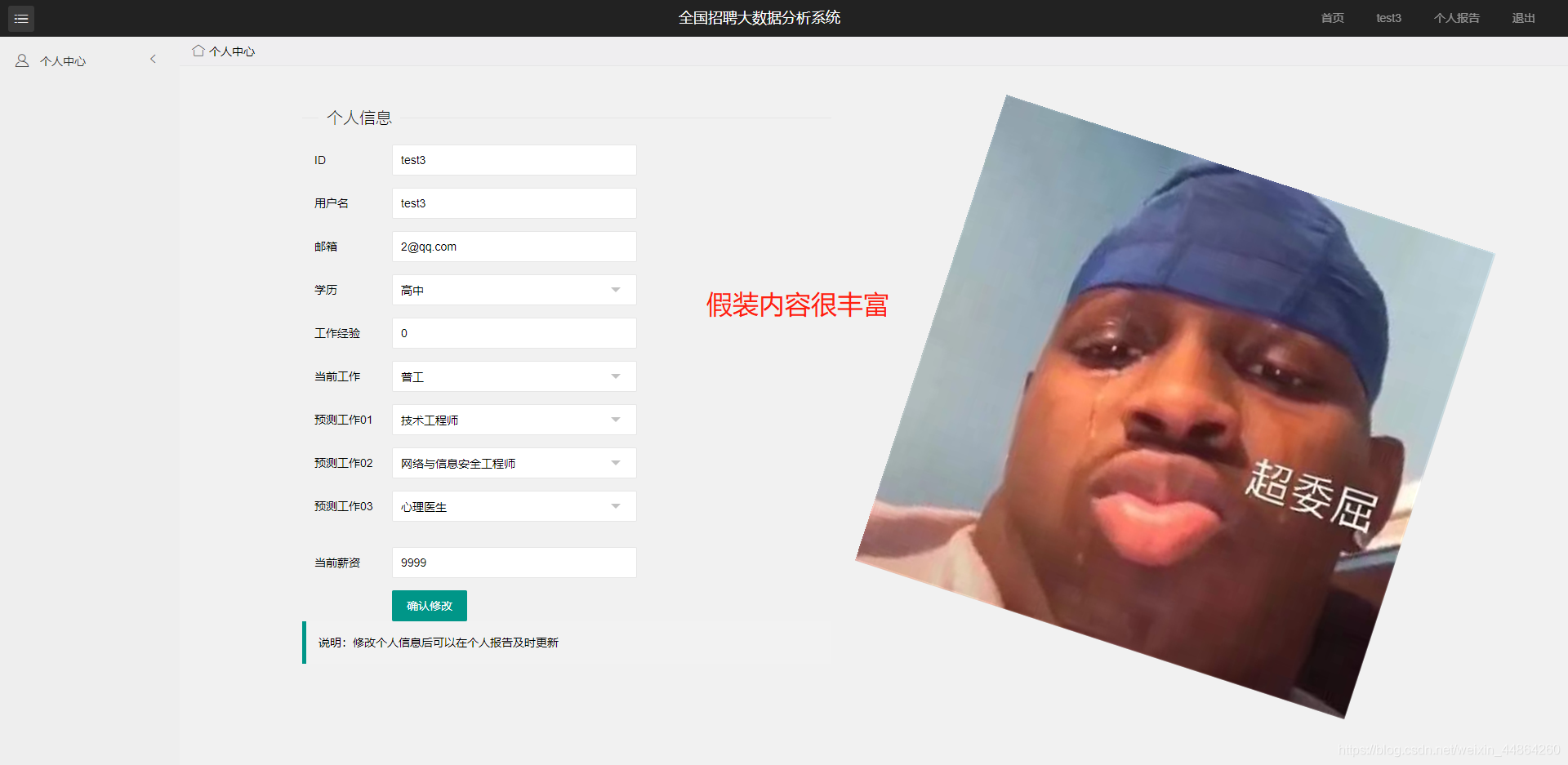

先看看个人中心,这个模块可以修改个人信息,有点空落落的,没办法,时间仓促。。。

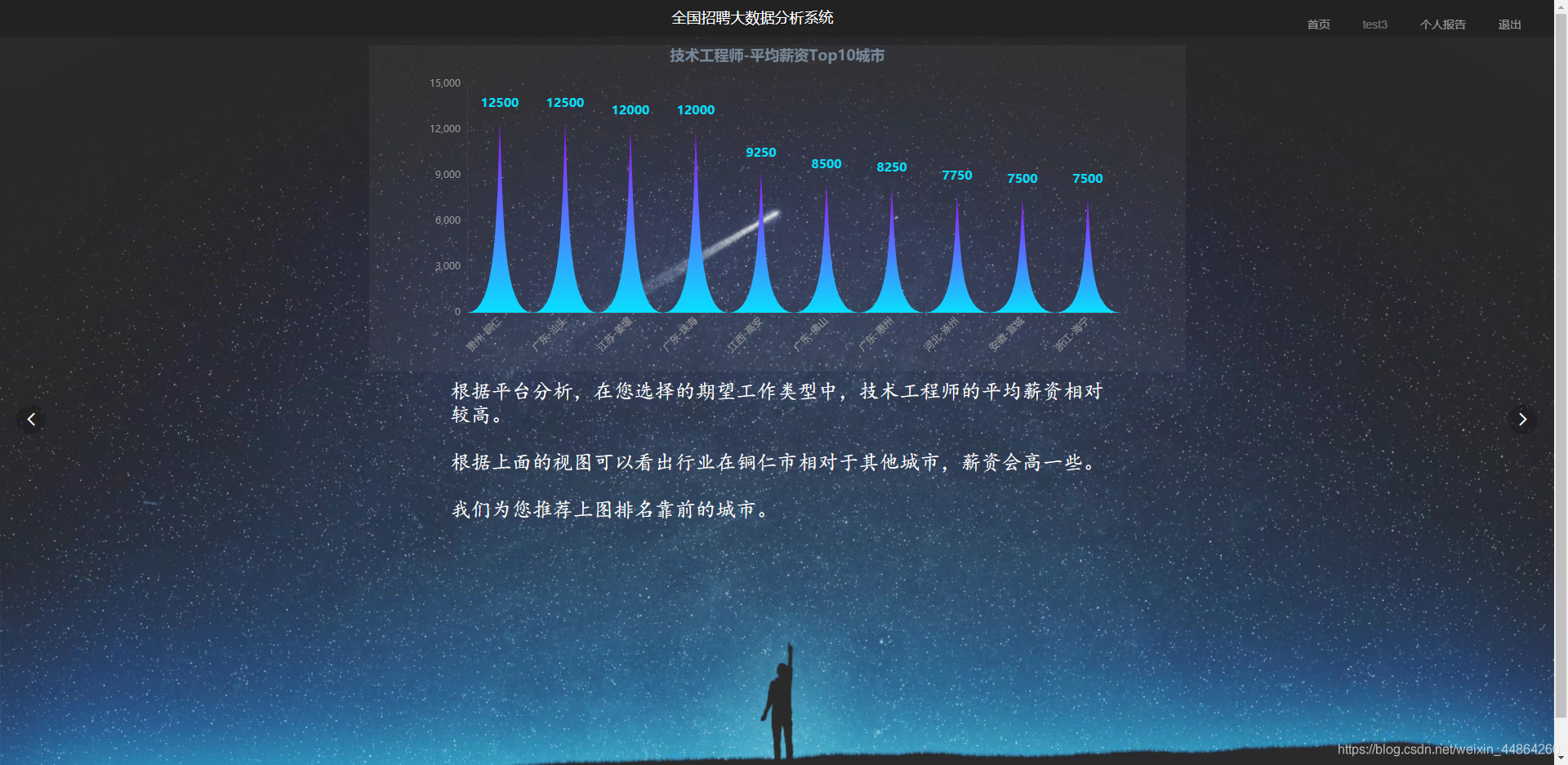

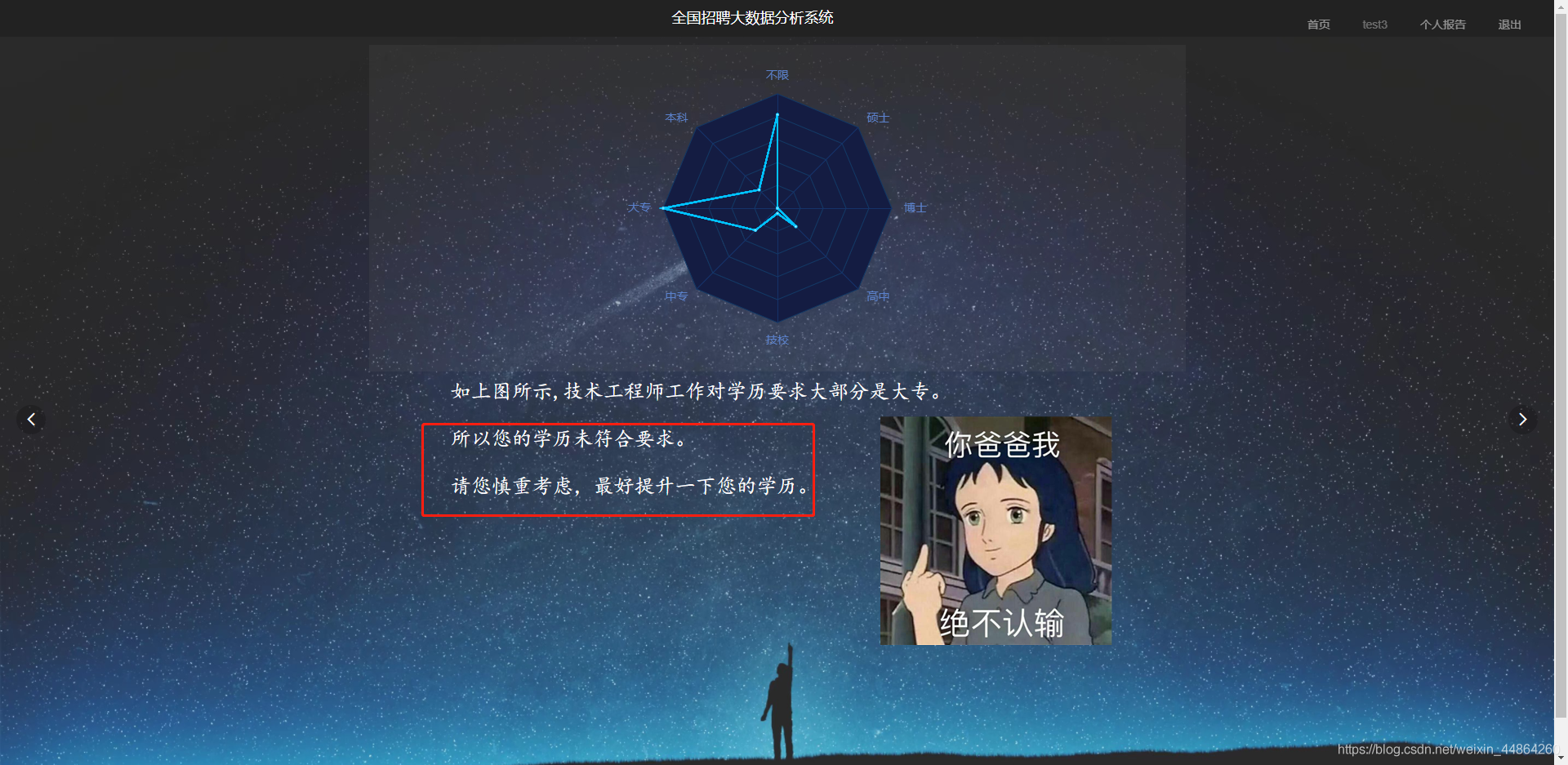

再看看个人报告吧

然后就没有然后了,别怀疑,普通用户就只有这单体验了。

还是介绍一下超级管理员账号登录激活后台管理模块。

进入后台之后

对用户进行管理

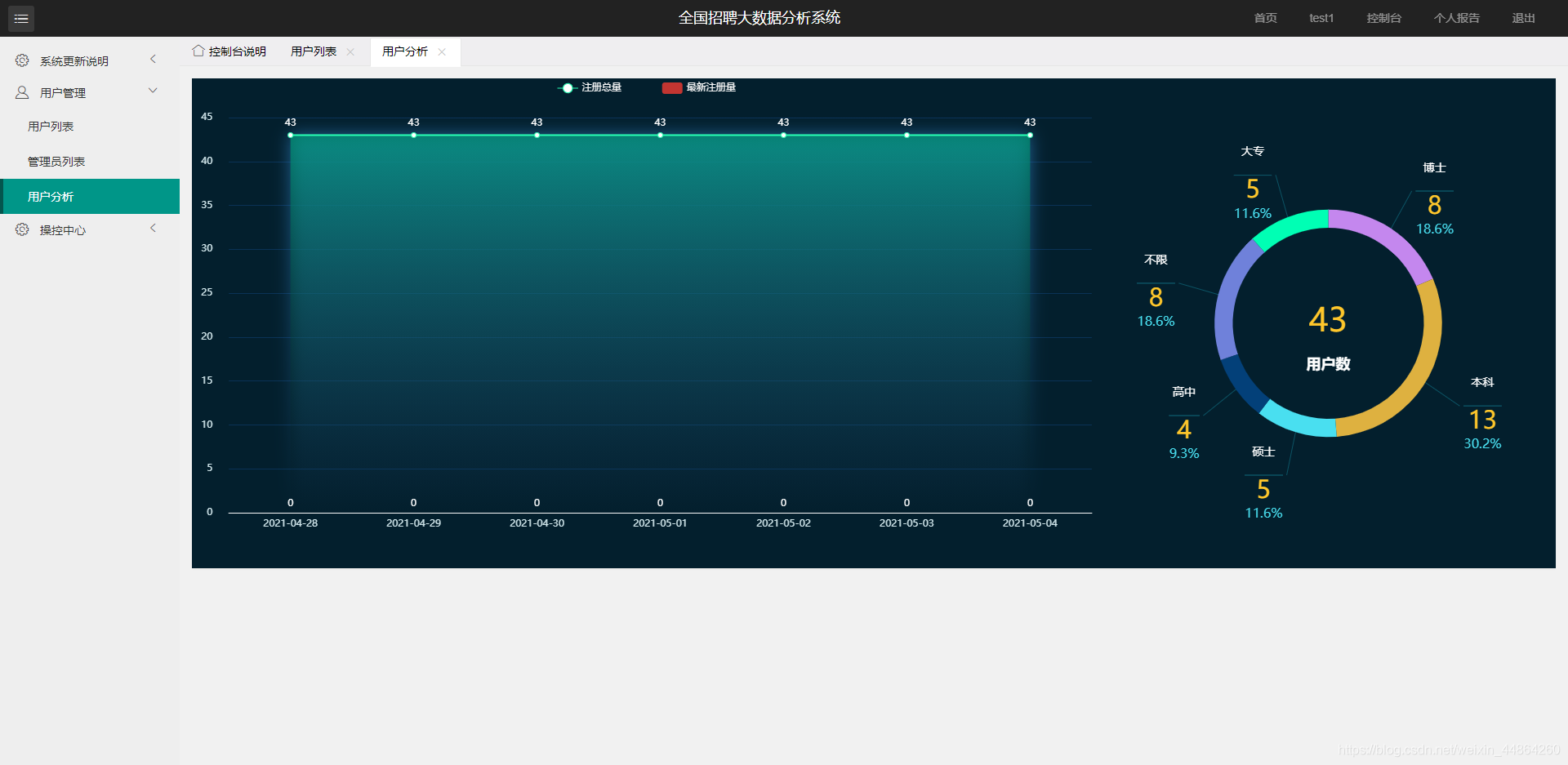

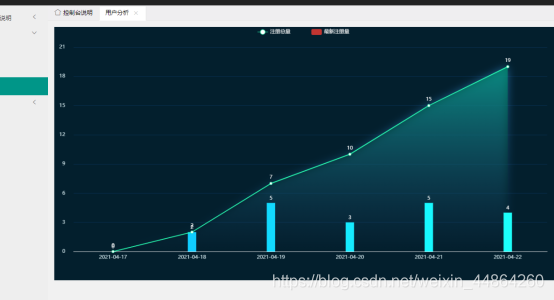

还有用户分析,因为没有新用户注册,所以图好丑

之前的图是这样的

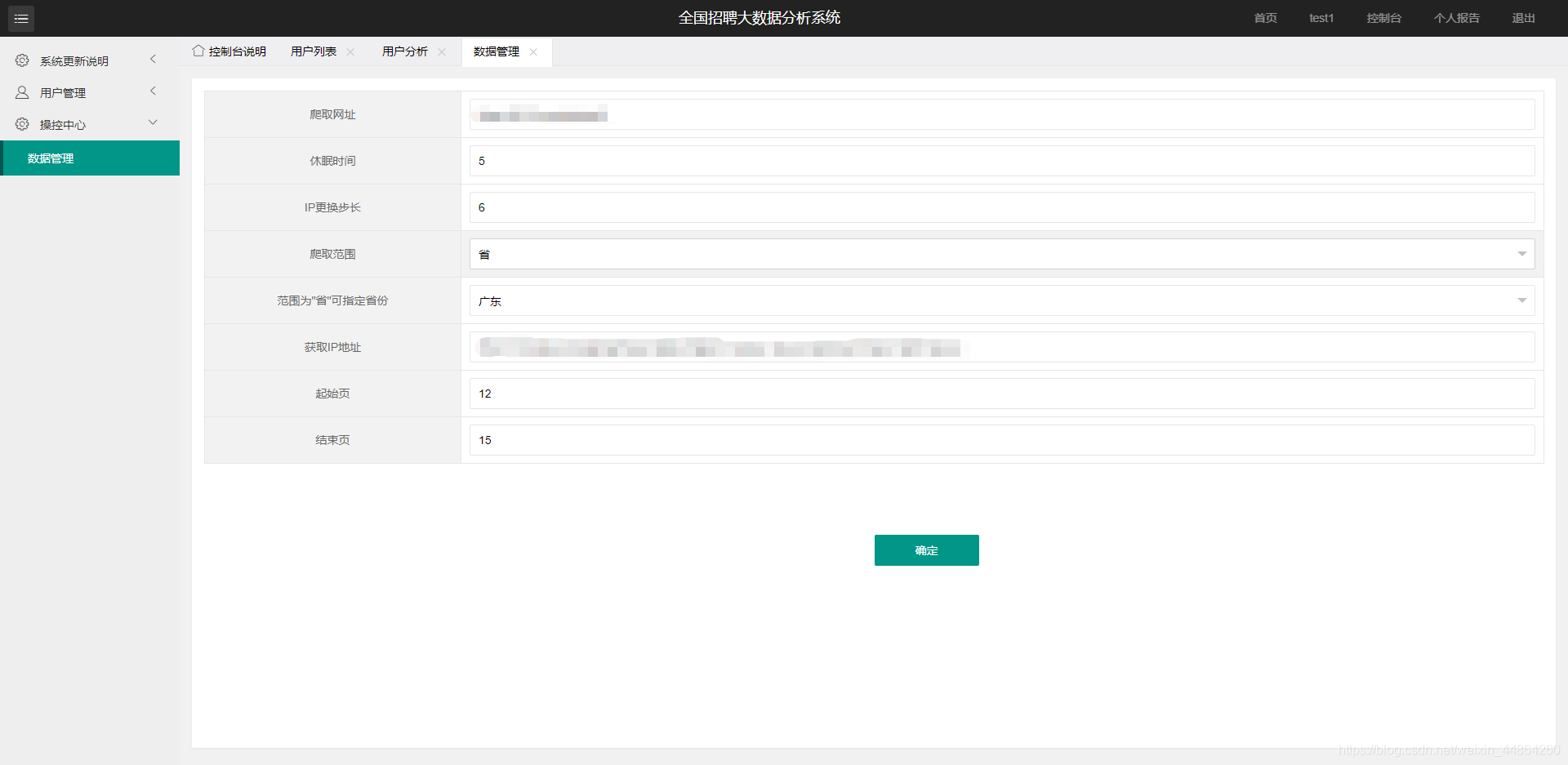

还可以更改爬虫的数据,这个反人类技术,我还是很慌的

数据没有商用,项目只是在本地跑!~~

看到这里,可视化项目就结束啦,数据源是scrapy爬虫爬取回来的数据啦,爬取回来会用spark清洗。都是用shell脚本写的,用定时任务crotabel,每天定时爬取,报错会发邮件,用redis记录状态码,以防数据没爬取完就启动spark清洗。不过展示用的都是之前练手的数据源。

emmm,后期如果有稳定的数据源,会考虑用pandas和sklearn等技术进行更新。

希望能通过初赛吧。奔跑吧~12天的没日没夜。