NPU 的诞生!

随着人工智能和大数据时代的到来,传统嵌入式处理器中的CPU和GPU逐渐无法满足日益增长的深度学习需求。为了应对这一挑战,在一些高端处理器中,NPU(神经网络处理单元)也被集成到了处理器里。NPU的出现不仅减轻了CPU和GPU的负担,还让复杂的计算任务得以高效处理。在典型的工作流中,CPU会首先接收任务,并根据任务的性质将其分配给合适的处理单元,图像处理任务由GPU处理,而人工智能相关任务则交给NPU。

什么是 NPU 呢? 在谈这个问题之前,可以先来看看什么是 CPU 和 GPU,CPU 就是中央处理器,中央处理器就好像是人类的大脑,主要负责各种逻辑控制和任务调度。所以 CPU 的计算能力相对来说不是最强的。GPU 是图形处理器,顾名思义,图形处理器是用来处理图形的,那处理图形就要 涉及到大量的计算,所以 GPU 相对 CPU 来说更擅长计算,但是不擅长逻辑控制和调度。从这 方面来讲就可以说 GPU 是 CPU 的互补。 但是随着人工智能,大数据的时代来临,以前嵌入式处理器中的 CPU 和 GPU 渐渐的难以满足与日俱增的需求,尤其是深度学习方面。为了应对日渐增长的需求,NPU 就诞生的了。

NPU 英语全称为 Neural Process Unit,译为神经网络处理器。NPU 是在电路层来模拟人类的神经元和突触,所以特别擅长处理人工智能任务。

NPU 的诞生大大的降低了 CPU 和 GPU 的负担,任何工作首先要经过 CPU,然后 CPU 在根据这个任务的性质来决定是分给 GPU 还是 NPU,如果是图像处理器方面,就分给 GPU,如果是人工智能方面,就分给 NPU。

NPU 的应用场景非常的广泛,如人脸跟踪、手势和身体跟踪、图像分类、视频监控、自动语音识别(ASR)和先进的驾驶员辅助系统(ADAS)等等。

总结

NPU 是 "Neural Processing Unit"(神经网络处理单元)的缩写,是一种专门用于加速深度学习和神经网络计算的硬件处理器。NPU 是为了满足机器学习任务中高效处理大规模矩阵运算和复杂模型推理的需求而设计的,特别适合处理卷积神经网络(CNNs)、循环神经网络(RNNs)、生成对抗网络(GANs)等深度学习模型。

初识 RKNPU

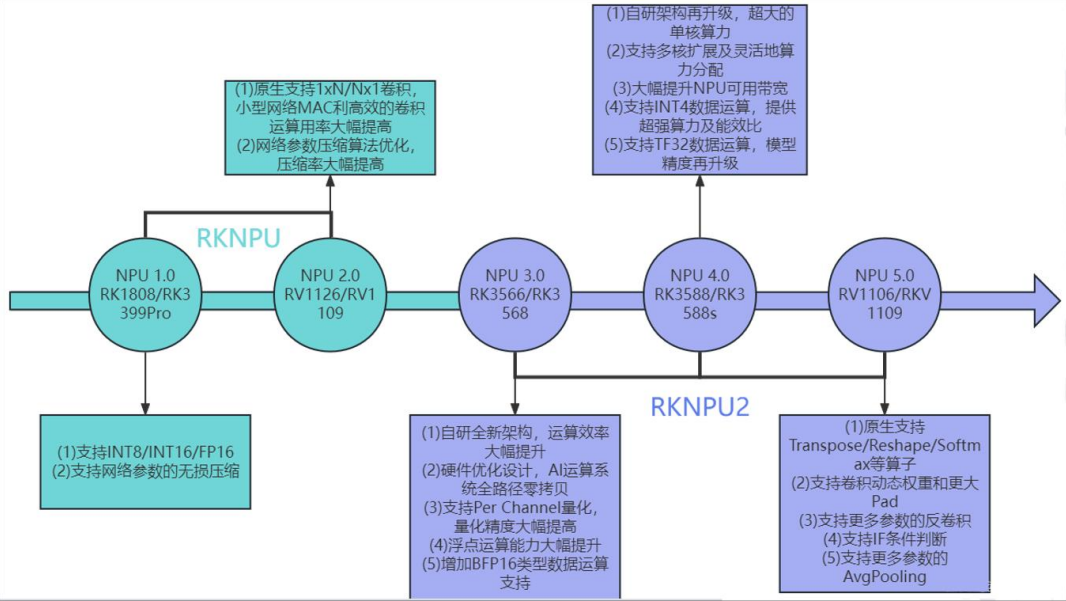

为了满足人工智能的需要,瑞芯微的处理器也逐渐集成了 NPU,瑞芯微的处理器内置的 NPU,称之为 RKNPU。 RKNPU 经过了几代的发展,首代初次引入了 RKNPU 是从 RK3399pro 和 RK1808 开始的, 相比传统的 CPU 和 GPU,在深度学习运算能力上有比较大幅度的提升。接下来在 RV1109 和 RV1126 上使用了第二代 NPU,提升了 NPU 的利用率。第三代 NPU 应用在 RK3566 和 RK3568 上,搭载全新 NPU 自研架构。第四代 NPU 应用在 RK3588 和 RK3588s 上,自研架构再升级。 RKNPU 发展过程如下图所示:

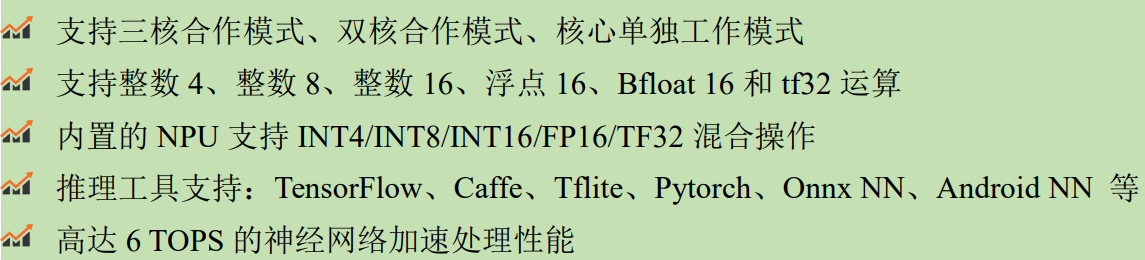

瑞芯微 RK3588 芯片内置 NPU,是 RKNPU 第四代的代表产品。第四代 RKNPU 特点如下所示:

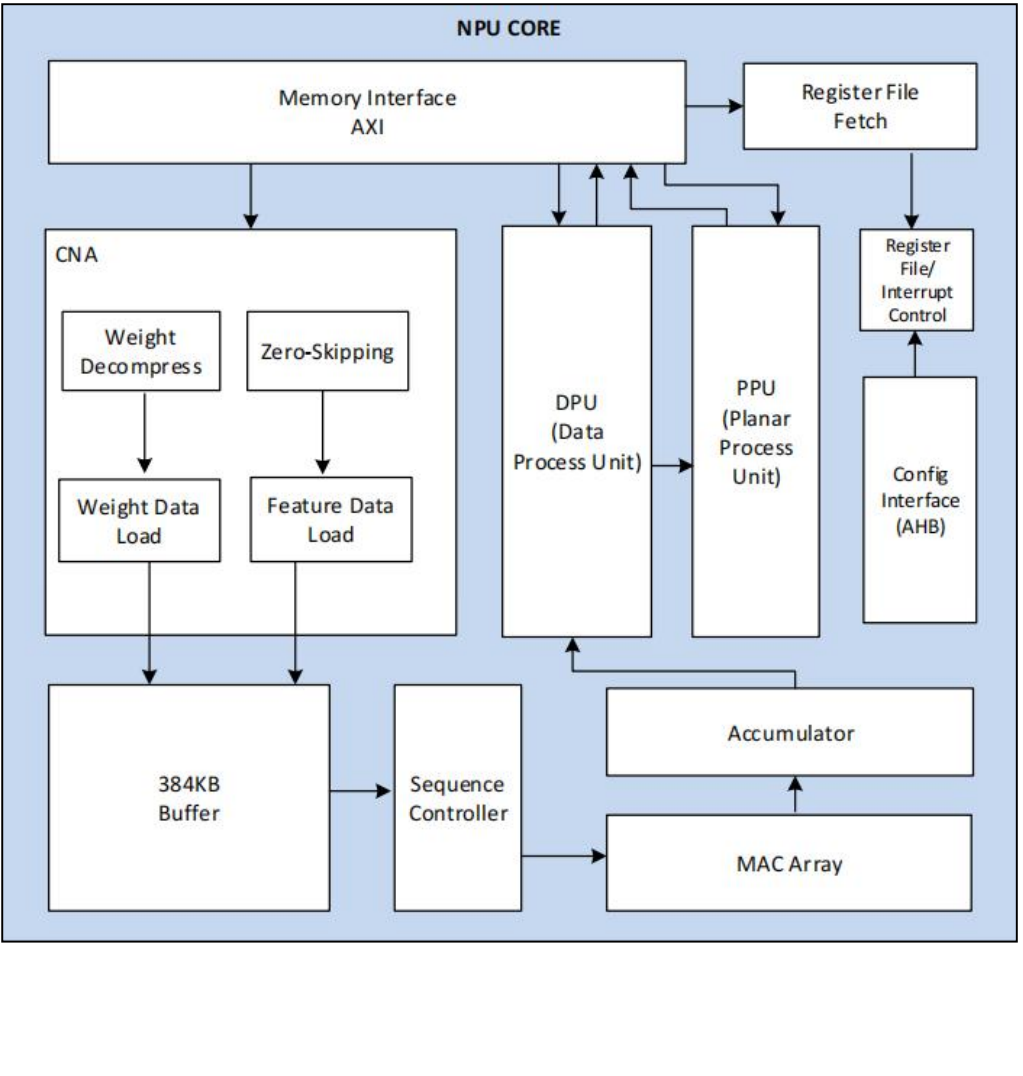

RK3588NPU 是 3 个核心,包含 CNA 模块、 DPU 模块、PPU 模块。

CNA 模块全称是 Convolution Neural Network Accelerator,也就是卷积神经网络加速器。

DPU 模块全称是 dada processing Unit,也就是数据处理单元。

PPU 模块全称是 Planar Processing Unit,平面处理单元。

NPU 框图如下图所示: