方向一:可解释性AI的定义与重要性

1. 什么是可解释人工智能

可解释人工智能(Explainable Artificial Intelligence, XAI)是指智能体以一种可解释、可理解、人机互动的方式,与人工智能系统的使用者、受影响者、决策者、开发者等,达成清晰有效的沟通,以取得人类信任,同时满足监管要求。

AI VS. XAI

简单而言,可解释性可用于两个阶段:模型之前(pre)和模型之后(post)。

算法的透明性和简单性(Algorithmic Transparency and Simplicity)表达的可解构性(Decomposability)模型的可担责性(Accountability)算法的适用边界因果分析和推理对黑盒模型的事后解释(Post-hoc Explanation)对模型表达能力的建模与解释

人们对于解释的评价与度量指对于特定的可解释性方法的评测。常见的测评角度包括以下几种:

可解释性方法的敏感度可解释性方法的对抗攻击鲁棒性可解释性方法的全面性可解释性方法的客观性解释结果的简单易懂性可解释性方法的互洽性可解释性方法的计算效率2. 为什么需要可解释人工智能

了解人工智能模型的正确决策机制,是提升人类对人工智能模型信任度的重要方法。而现有人工智能可解释性的研究成果揭示,基于数据驱动的人工智能系统决策机制,离取得人类信任这一终极目标,至少还存在以下3个方面的差距:

机器学习决策机制的理论缺陷现在的机器学习方法,通常就是在输入数据和预期结果之间建立关联(Association), 而由于数据样本普遍存在局限和偏差,这种关联学习不可避免地学到一种虚假关系(Spurious Relationship)。为了发现出真正的因果关系,需要通过主动干预(intervention)实验来拓展观测现象,并运用反事实推理(Counterfactual Reasoning)去伪存真。

因果推理的三个认知层次

2. 机器学习的应用缺陷

数据样本的局限和偏见,会导致数据驱动的人工智能系统存在偏见;“黑盒“的深度学习网络存在安全性上的潜在风险;从决策机制来看,当前对深度学习的分析还处于不透明的摸索阶段。3. 人工智能系统未能满足监管要求

可解释人工智能的全路径

3. 如何研究可解释性

可解释性可主要分为以下几个类别:

特定模型的可解释性(Model-Specific explainability)严格限定于特定模型算法的可解释性,如决策树模型、贝叶斯网络等。

不限模型的可解释性(Model-Agnostic explainability)这种类型的解释适用于任何类型的机器学习模型。通常,后分析方法将在机器学习模型训练之后使用,它不依赖于任何特定算法,并且不了解内部模型结构和权重。

模型中心的可解释性(Model-Centric explainability)大多数解释方法都是以模型为中心的,因为这些方法用于解释如何调整特征和目标值,应用各种算法并提取特定的结果集。

数据中心的可解释性(Data-Centric explainability)因为数据在模型训练和预测中有重要作用,这类方法主要用于理解数据的意义,常见的方法有:数据剖析(Data Profiling)、监控数据漂移(Monitoring Data-Drifts)和数据对抗(Data-Adversarial)。

可解释性技术的分类

模型可解释性的研究方法:

知识抽取 (Knowledge extraction) 探索性数据分析 (Exploratory Data Analysis, EDA)结果可视化 (Result visualization) 比较分析 (Comparison analysis)基于影响的方法 (Influence-based) 敏感性分析与特征重要性选择 (Sensitivity Analysis and Feature selection importance)分享几个有用的可解释性分析工具:

SHAP (Shapley Values)一种基于博弈论的解释性方法,可以衡量输入样本不同维度对预测结果的重要性

LIME (Local Interpretable Model Agnostic Explanations)可以对任意机器模型预测给出解释的方法,可以衡量输入样本不同维度对预测结果的重要性

AnchorsLRP (Layer-wise Relevance Propagation) :repo 1 and repo 2Prediction Difference Analysis (PDA)TCAV (Testing with Concept Activation Vectors)

方向二:可解释性AI的挑战与难点

模型复杂性:许多现代人工智能模型(如深度神经网络)具有非常复杂的结构和大量的参数。这使得理解模型的内部工作原理变得困难,限制了对其决策过程的解释。解决方法:

采用更简单的模型,如决策树或逻辑回归,这些模型更易于解释。构建可以提供模型解释的辅助工具或方法,如特征重要性分析或规则提取。 数据不确定性:人工智能模型的决策是基于输入数据进行训练和推断的。然而,数据本身可能存在噪声、缺失值或错误,导致模型在决策时产生不确定性。解决方法:

开发新的方法来评估和处理不确定性,如蒙特卡洛方法或贝叶斯推断。提供模型对数据的置信度或不确定性的度量,以帮助用户理解模型的决策。 因果关系:人工智能模型通常可以从数据中学习到输入和输出之间的相关性,但难以捕捉因果关系。理解模型中的因果关系对于解释模型的决策过程至关重要。解决方法:

使用因果推理方法,如因果图模型或因果探索算法,帮助模型找到输入和输出之间的因果关系。引入因果约束作为模型训练的一部分,以增强模型的因果解释能力。为提高AI的可解释性,我们可以采取以下策略:

透明度和可视化:提供模型内部的解释,如特征重要性排名、决策路径或决策规则,以帮助用户理解模型的决策逻辑。

上下文和背景信息:将模型的决策与背景信息相结合,如相关法律、道德准则或领域知识,以提供更全面的解释和理解。

用户参与:让用户参与模型的训练和解释过程,通过用户反馈和解释的迭代,提高模型的可解释性。

教育和沟通:向用户和相关利益相关者提供培训和教育,以帮助他们理解AI模型的工作原理和局限性,并促进与AI系统的有效沟通。

方向三:可解释性AI的应用场景

在金融领域,可解释性AI可以用于风险评估、信贷评估和投资决策等场景。例如,对于一家银行来说,透明的AI决策可以解释客户的信用评分是如何计算得出的,帮助银行员工和客户了解决策的依据,并增强对决策的信任。

在医疗领域,可解释性AI可以用于辅助医生进行诊断和治疗决策。例如,通过可解释性AI,医生可以了解一个自动诊断系统是如何根据患者的症状和医学历史来给出诊断结果的,从而更好地理解系统的建议并做出决策。

在自动驾驶领域,可解释性AI可以帮助乘客和监管机构理解自动驾驶车辆的决策过程。例如,当自动驾驶汽车决定采取某个操作时,可解释性AI可以向乘客解释该决策是如何基于传感器数据和预测模型计算得出的,增强对自动驾驶系统的信任。

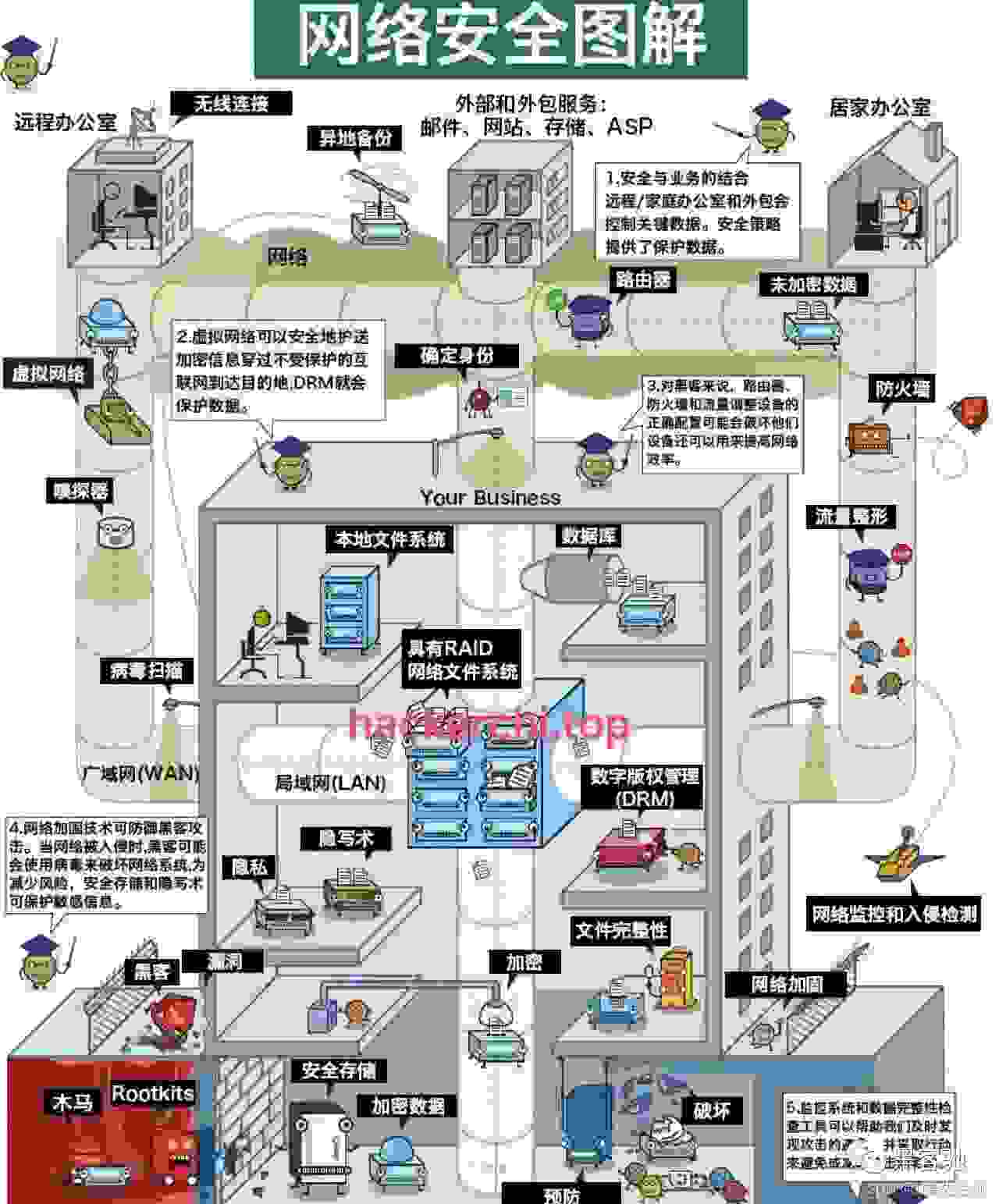

在安全领域,可解释性AI可以用于威胁检测和网络安全等场景。例如,一个可解释的威胁检测系统可以向安全分析师解释为什么某个行为被判断为威胁,从而帮助分析师更好地理解系统的警报并采取相应的行动。

为了解决具体问题,可解释性AI可以采用多种方法。一种方法是使用可解释的模型,例如决策树、规则集或线性模型,这些模型可以直接展示决策过程或特征的重要性。另一种方法是使用模型解释技术,例如特征重要性分析、局部可解释性方法和模型规则提取算法,这些技术可以根据模型的输入和输出给出解释或可视化结果。另外,模型预测不确定性的评估也可以增加可解释性,例如通过生成置信度或概率分布来表示模型的不确定性。

总之,可解释性AI在金融、医疗、自动驾驶和安全等领域中有广泛的应用。它可以帮助用户理解和信任AI系统的决策,提高系统的可用性和可靠性,并为用户提供更好的决策支持。

方向四:可解释性AI的评估与度量

可解释性指标:可解释性指标可以量化模型的解释能力。最常用的指标是模型的准确性和可信度。然而,这些指标并不能直接评估模型的解释性。因此,还需要考虑用于解释模型决策的指标,例如:特征重要性、决策树解释、局部解释等。

解释性评估标准:解释性评估标准可以用来评估不同模型的解释性能力。一种常用的评估标准是邀请人类评估员对模型决策的解释进行评估。另外,还可以使用一些定量指标,如解释性得分、解释性比率等。

数据集:选择合适的数据集对于评估和度量AI的可解释性非常重要。应该选择与实际应用场景相似的数据集,并且要考虑到数据集的多样性,以确保评估结果的鲁棒性和可靠性。

用户反馈:用户反馈是评估和度量AI可解释性的重要信息源。可以邀请实际使用者对模型的解释进行反馈,根据他们的反馈来评估模型的解释性能。

选择合适的评估工具需要考虑以下几个因素:

目标:首先需要明确评估的目标是什么,是为了满足法律法规的要求,还是为了提高用户的信任度,或者是为了提高模型的可用性。

可解释性方法:不同的可解释性方法适用于不同的场景和问题。选择评估工具时需要考虑该工具是否适用于当前任务的解释需求,并且是否能提供准确、可靠的结果。

成本和效率:评估工具的成本和效率也是选择评估工具时需要考虑的因素。一些评估工具可能需要大量的人力和时间资源,而另一些评估工具可能更加高效和经济。

总之,在评估和度量AI的可解释性时,需要综合考虑可解释性指标、解释性评估标准、数据集和用户反馈等因素。选择合适的评估工具时,需要明确评估目标,选择适用于当前任务的解释方法,并考虑成本和效率等因素。

方向五:可解释性AI的未来发展

解释能力的提升:可解释性AI将通过改进算法和模型来提高其解释能力。例如,一些研究人员正在探索如何将深度学习模型进行可解释性改造,以便能够更好地解释模型的决策过程。

可视化工具的发展:可解释性AI将借助可视化工具来帮助用户理解模型的决策过程。这些工具可以将复杂的模型输出可视化为图表、图像或其他易于理解的形式,使用户能够更容易地理解模型的工作原理。

知识表示和推理:未来的可解释性AI将与知识表示和推理领域相结合,从而能够从人类专家那里获取更多的领域知识,并将其应用于模型的决策过程中。

社会和法律的需求:随着AI在各个领域的广泛应用,社会对AI的透明度和可解释性的需求也越来越高。政府和法律机构可能会出台相关规定和法律,要求AI系统提供解释和理由,以确保其决策的可追踪性和可解释性。

在技术发展的方向和可能出现的突破方面,以下是一些可能的发展方向:

可解释性算法的研究:研究人员将进一步探索各种可解释性算法,以提高模型的解释能力。可能的突破包括新的解释性模型结构、改进的特征选择和特征重要性度量方法等。

改进模型的可解释性评估方法:为了推动可解释性AI的研究和应用,需要开发更好的评估方法来衡量模型的可解释性。这将有助于研究人员和开发者了解模型的局限性,并为改进模型提供指导。

数据集的设计和收集:为了训练和评估可解释性AI模型,需要设计和收集与领域相关的高质量数据集。这些数据集应涵盖不同类型的解释需求和决策场景,以确保模型的广泛适用性。

推动可解释性AI的研究和应用需要从以下几个方面入手:

教育和培训:培训更多的专业人才,使他们具备开发和应用可解释性AI的能力。这需要在教育中强调可解释性AI的重要性,并提供相关的培训和课程。

跨领域合作:可解释性AI的研究需要来自不同领域的专家的协作。例如,计算机科学家、心理学家和社会科学家可以共同研究如何设计和评估可解释性AI模型。

提供透明度和解释性:开发者应该将透明度和解释性作为AI系统设计的重要目标。他们应该提供易于理解和解释的模型结果,并积极回应用户的疑问和质疑。

可解释性AI的研究和应用对人工智能领域具有重要影响和意义:

增强用户信任:可解释性AI可以增强用户对AI系统的信任,使其更愿意使用和接受AI技术的决策。

促进公平和负责任的AI:可解释性AI可以帮助发现并纠正模型的偏见和不公平性,从而提高AI系统的公平性和负责任性。

加强决策的理解:通过解释AI模型的决策过程,人们可以更好地理解和评估AI系统的决策,从而能够更好地应对其结果和影响。

总之,可解释性AI的发展将使人们更加信任和接受AI技术,并促进公平和负责任的AI应用。通过跨领域的研究合作和技术创新,我们可以推动可解释性AI的研究和应用,从而为人工智能领域带来更大的影响和意义。

方向六:可解释性AI的实践经验与案例分析

解释性图像分类:

使用梯度热图(Gradient Heatmap):可以生成一个彩色图像,显示出模型在图片中的关注区域。这可以帮助用户理解模型是如何做出决策的,以及模型关注的是哪些特征。使用类别激活图(Class Activation Map):可以可视化模型对不同类别的敏感性。这可以帮助用户理解模型对于不同类别的决策依据,以及模型在决策过程中注意的是哪些图像区域。解释性语言生成:

使用词频统计和关键词提取:可以将模型生成的文本与相关领域的关键词进行比较,并计算出每个关键词在生成文本中的重要性。这样可以帮助用户理解模型生成文本的决策过程。使用注意力机制(Attention Mechanism):可以将模型在文本生成过程中的注意力权重可视化,以显示模型在生成每个词时关注的是哪些输入信息。解释性预测模型:

使用特征重要性分析:可以通过计算特征在预测结果中的贡献度,来解释模型对于不同特征的重要性。这可以帮助用户理解模型在做出预测时的决策依据。使用决策规则提取:可以通过将模型转换为一组决策规则来解释模型的决策过程。这样可以使用户更容易理解模型的工作原理,并追踪模型决策的逻辑。在实践中,还有一些实用的技巧和建议可帮助读者更好地理解和应用可解释性AI:

对系统输出进行验证:验证模型输出的正确性并与实际情况进行比较是非常重要的。如果模型的解释与实际情况不一致,需要重新评估模型的可靠性和解释性。

向用户提供交互式解释:提供用户与解释产生的交互可能性,使用户能够探索模型的决策过程。这可以增加用户的参与度,提高对模型的理解和信任。

不同应用领域的需求:不同应用领域需要不同的解释方法。因此,根据具体应用的特点,选择最合适的解释技术和方法。

教育用户:教育用户如何正确地解读和使用可解释性AI的结果是至关重要的。用户可能需要一些培训和指导,以充分利用可解释性AI的优势和潜力。

综上所述,可解释性AI在实际应用中具有重要价值。通过合理选择解释方法和技术实现,并向用户提供相应的培训和指导,可以帮助用户更好地理解和应用可解释性AI。