几行命令教你私有化部署自己的AI大模型,每个人都可以有自己的GTP

第一步:安装Docker(如果已经有了可以直接跳第二步)

####下载安装Dockerwget https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo -O/etc/yum.repos.d/docker-ce.repo##更新yum软件包索引yum makecache fast## 安装docker ce cliyum -y install docker-ce-23.0.6-1.el7 docker-ce-cli-23.0.6-1.el7##"启动Docker并验证"systemctl enable docker && systemctl start dockerdocker version第二步:使用Docker部署Ollama

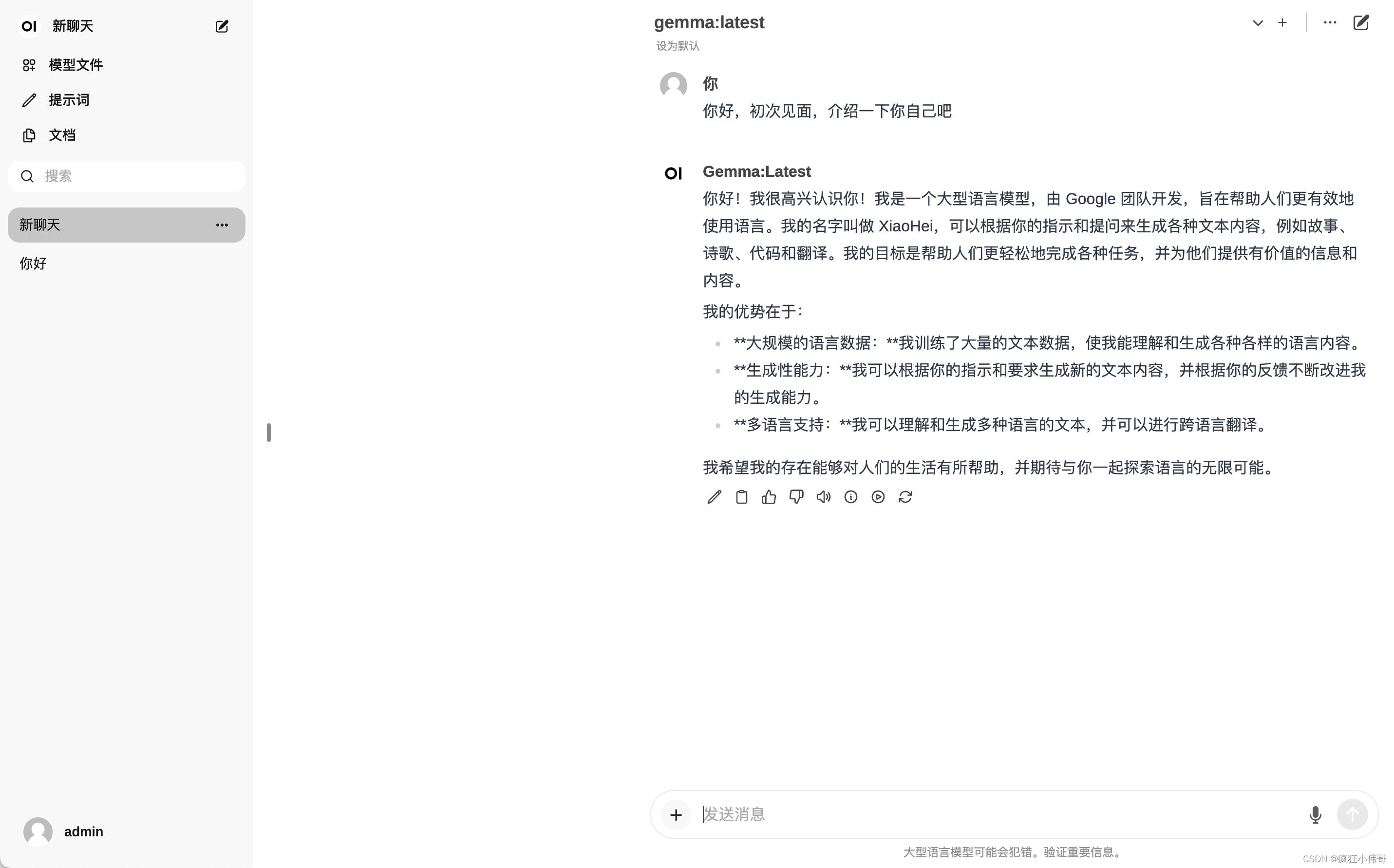

(ollama run gemma)安装谷歌gemma大模型

(ollama run llama2)安装Meta llama2大模型

(ollama run qwen)安装阿里的qwen大模型

###docker下载ollama部署docker run -d -v ollama:/root/.ollama -p 11434:11434 --name ollama --restart always ollama/ollama###开始下载gemma大模型docker exec -it ollama ollama run gemma “你好”第三步:使用Docker部署webUI页面

将${inner_ip}替换成你本机IP(用hostname -I可查看)

docker run -d -p 3000:8080 -e OLLAMA_BASE_URL=http://${inner_ip}:11434 -v open-webui:/app/backend/data --name open-webui --restart always ghcr.nju.edu.cn/open-webui/open-webui:main第四步,正在启动WEBUI界面,大约5分钟后,

部署完毕,请访问:http://IP:3000正常就可以打开访问属于你自己的大模型了。

可以通过下面的命令查看日志

docker logs -f open-webui