人工智能发展日新月异,大模型技术越发成熟。作为IT程序员的我们,不掌握点大模型技术知识怎么行。本文介绍怎么在自己电脑本地从零开始搭建属于自己的大模型,可以离线使用,不像网上文章讲的依赖openai , 百度文心一言等 API接口。

首先了解下大模型是什么?通俗来讲,大模型就是输入大量语料,来让计算机获得类似人类的“思考”能力,使之能够理解自然语言,能够进行『文本生成』、『推理问答』、『对话』、『文档摘要』等工作。

大家对于chatGPT耳熟能详, 像GPT3.5, GPT4.0大模型,大部分人 通过 科学上网或 使用一些套壳软件 或多或少用过其能力。 2023年上半年chatGPT火热的时候,我就有学习大模型的想法,但奈何大模型严重依赖 海量数据、价格不菲的算力,复杂的算法。当时的电脑不支持GPU,冒出的想法暂时搁置了。自从meta开源 LLaMA2后, 国内雨后春笋冒出很多搞大模型的套壳公司。最近晚上在家刷公众号,经常刷到一些xxxx元AI大模型学习的韭菜付费课程。 作为新时代爱好学习的知识好青年,看不惯这种割韭菜的行为,毕竟大家的钱不是大风刮来的。本文准备在 自己的电脑上搭建类似 chatGPT的工具,这里以MAC为例, windows或linux类似。

先说工具, 线上链接 https://github.com/jmorganca/ollama ,直接根据文档介绍一步步来操作就可以。ollama是我目前所知 搭建大模型最容易上手的方式, 傻瓜式操作。

打开网站,mac安装包下载地址到本地,一步步傻瓜式安装。

这里以运行llama2 为例, 安装成功后 , 直接 运行

ollama run llama2

这里运行的 lama2大模型, 是不是很容易,截图里写的一个java冒泡算法。

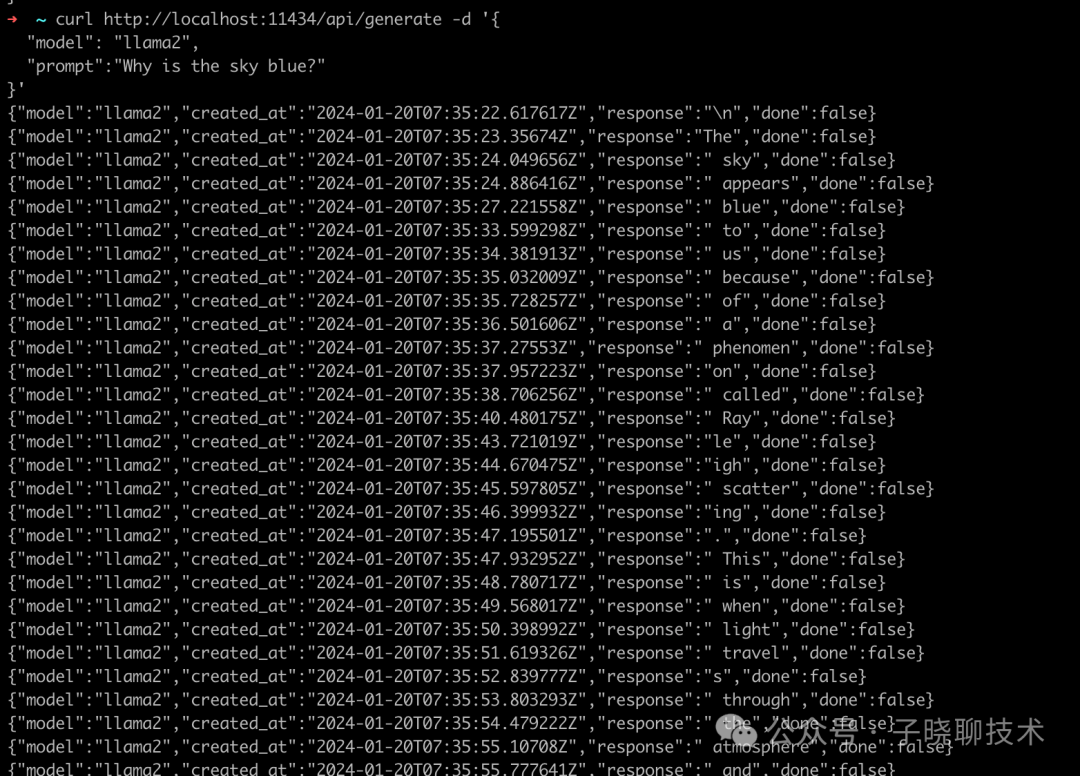

如果我们想把这个提供一个web服务,写一个聊天机器人,只要搞个自己定制的前端UI,后端直接调用提供的restapi接口即可。 专属免费,功能不比chatGpt逊色多少的聊天机器人就搞定了。

curl http://localhost:11434/api/generate -d '{"model": "llama2","prompt":"Why is the sky blue?"}'

本篇文章就到此为止,后续的计划:

1、AI应用侧,写一些基于AI的实际应用、落地实践。

2、作为程序员来说,后续还是更新一些关于机器学习、深度学习相关的文章(tensorflow、pytorch、transformer等),学习期间穿插微积分、线性代数、概率论的理论文章。毕竟实践还需要依赖一些数学理论。

文章可能偶尔忘记发在这里, 如果感兴趣可以关注 同名公众号(子晓聊技术)