目录

前言

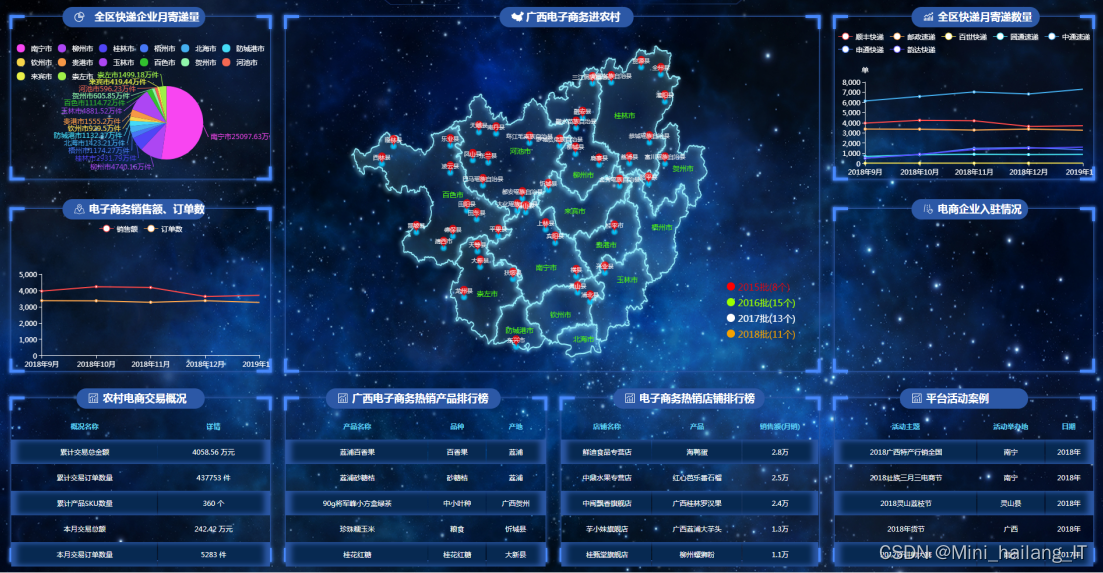

项目背景

数据集

设计思路

算法理论基础

实验环境设置

实验结果分析

更多帮助

前言

?大四是整个大学期间最忙碌的时光,一边要忙着备考或实习为毕业后面临的就业升学做准备,一边要为毕业设计耗费大量精力。近几年各个学校要求的毕设项目越来越难,有不少课题是研究生级别难度的,对本科同学来说是充满挑战。为帮助大家顺利通过和节省时间与精力投入到更重要的就业和考试中去,学长分享优质的选题经验和毕设项目与技术思路。

?对毕设有任何疑问都可以问学长哦!

大家好,这里是海浪学长计算机毕设专题,本次分享的课题是

?基于深度学习的手写数字识别系统

项目背景

随着信息技术的飞速发展,手写数字识别技术在众多领域,如银行、教育、医疗等,展现出巨大的应用潜力。然而,传统的手写数字识别方法常常受限于识别精度和鲁棒性,难以满足实际应用的需求。因此,研究基于深度学习的手写数字识别系统具有重要的现实意义和应用价值。通过深度学习技术,我们可以构建更加高效、准确的识别模型,提高手写数字识别的性能和稳定性,为相关领域提供更为可靠的技术支持。

数据集

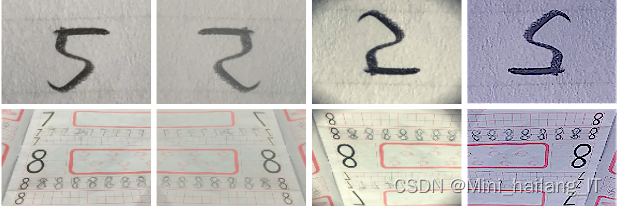

现有的公开数据集往往难以覆盖各种实际场景中的手写数字风格。因此,我决定自制一个手写数字数据集。首先,我邀请了不同年龄段、不同职业背景的人参与手写数字的收集,以确保数据集的多样性。然后,我使用高分辨率的扫描仪将手写数字转换为数字图像,并进行归一化和预处理,以便模型能够更好地学习和识别。接下来,我对这些图像进行了标注,并为每个数字分配了一个唯一的标签。最终,我得到了一个包含数千张手写数字图像的数据集,为我的研究提供了坚实的数据基础。

数据扩充是一种有效的技术,用于增加训练数据的数量和多样性,从而提高深度学习模型的泛化能力。在手写数字识别系统的研究中,我们采用了多种数据扩充方法来扩充数据集。首先,我们对原始图像进行了旋转、平移和缩放等几何变换,以模拟不同角度和尺度的手写数字输入。其次,我们引入了噪声和干扰因素,如随机添加像素点、线条和模糊等,以模拟实际场景中可能出现的图像质量下降情况。此外,我们还采用了数据插值和时间序列生成等方法,生成了更多的合成数据。通过这些数据扩充技术,我们成功地增加了数据集的多样性和复杂性,为深度学习模型的训练提供了更多的有效信息,从而提高了手写数字识别系统的性能和鲁棒性。

设计思路

算法理论基础

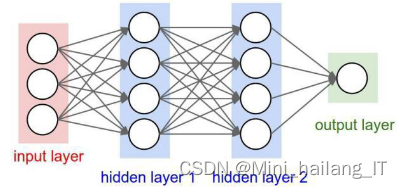

卷积神经网络是一种具有容错能力、泛化能力强且具备自我学习和处理能力的前馈神经网络。它通过反向传播算法优化网络结构,从二维图像中提取拓扑结构和特征,并具有良好的局部特征挖掘能力。卷积神经网络在图像分类、目标检测等领域广泛应用,通过权值共享进一步提升特征优势。其整体结构包括输入层、卷积层、激励层、池化层和全连接层,能够有效提取和识别数据特征。

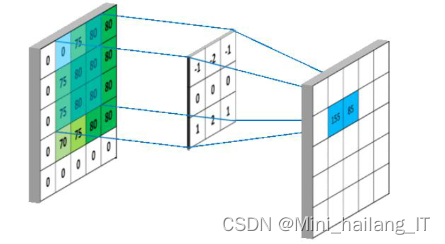

卷积层通过滤波器(也称为卷积核)在输入数据上进行卷积操作。每个滤波器都是一个小的可学习参数矩阵,它在输入数据上进行滑动窗口操作,并将窗口内的元素与滤波器的对应元素相乘并求和,得到一个输出值。通过对输入数据的不同位置应用不同的滤波器,卷积层可以提取出输入数据中的不同特征。卷积操作具有局部感知性,即每个滤波器只关注输入数据的一小部分区域。这种局部感知性使得卷积层能够捕捉到输入数据中的局部特征,并且对平移不变性具有一定的保持能力。卷积层还通过共享权重的方式减少了需要学习的参数数量,提高了网络的效率和泛化能力。

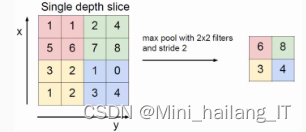

池化层是卷积神经网络中常用的层之一,用于缩小输入特征图的尺寸,压缩数据并加速计算速度。主要采用最大池化操作,通过设定池化区域的大小和步长来提取每个区域的最大值,并生成新的特征图。这样可以有效防止过拟合,并在一定程度上降低计算负载。然而,池化操作会导致特征图的尺寸减小,可能损失一些细节信息,从而影响模型的准确性。为了弥补这一点,可以通过增加特征图的层数来补充丢失的信息。通过增加特征图的深度,网络可以学习更多的抽象特征,并提高模型的表达能力。

激励层在神经网络中起到将输入映射到输出的作用。从生物神经网络的角度来看,神经元通过树突接受输入信号,当信号强度超过一定阈值时,经过轴突传递输出信息。激励函数的作用在于决定输入信号是否能够通过神经元,并对输出进行非线性映射。

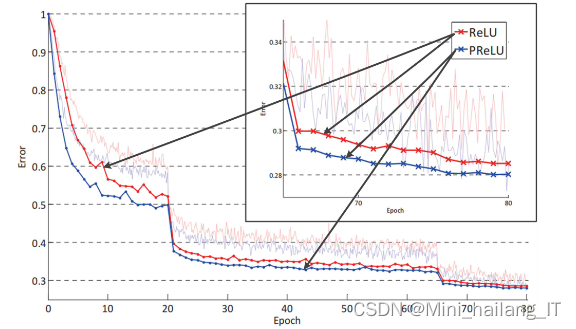

激活函数在AlexNet中起着重要的作用,能够引入非线性因素,使网络能够解决更复杂的问题。激活函数可以大致分为两类:饱和激活函数和非饱和激活函数。饱和激活函数如Tanh、Sigmoid等,具有计算量大、反向传播中涉及除法、易产生梯度消失等劣势,导致无法有效完成模型训练。而非饱和激活函数如ReLU、ELU、Leaky ReLU、RReLU等具有更好的性质。在AlexNet中采用了非饱和激活函数ReLU,除了加速收敛速度外,还能解决梯度消失的问题。

在非饱和激活函数中,PReLU激活函数是一种改进形式,相比于ReLU激活函数,它只引入了很少的额外参数,意味着网络的计算量和过拟合的风险都只增加了一点点。特别是当不同通道使用相同的参数时,参数数量更少。因此,PReLU激活函数在一定程度上平衡了性能和计算效率的考虑。

实验环境设置

实验环境使用Windows操作系统,并利用Python作为主要的编程语言进行算法和模型的实现。使用PyTorch作为深度学习框架,构建和训练神经网络模型。借助Pandas等库,完成数据的加载、处理和转换。这样的实验环境提供了一个方便和高效的平台,用于开发和测试算法系统。

实验结果分析

在测试集上,我们选择了动量优化算法Momentum以及自适应学习率优化算法Adam和RMSProp这三种优化器算法进行对比测试。我们的目标是分析每个算法在不同学习率下的最优范围,以解决模型训练中由于选择不准确的学习率而导致的收敛速度缓慢或波动过大的问题。

对AlexNet卷积神经网络进行了激活函数、计算模型、归一化和优化器等四个方面的创新和改进研究,有效地解决了基于卷积神经网络的手写数字识别中存在的准确率、收敛速度和模型训练速度等问题。实验结果表明,经过这些改进后的AlexNet卷积神经网络在手写数字识别研究中的准确率明显提高,模型的计算速度和收敛速度也有显著提升。

通过优化激活函数,网络能够引入非线性因素,提高模型的表达能力和解决复杂问题的能力。改进计算模型可以增加网络的深度和宽度,提升模型的表征能力和学习能力。归一化技术有助于缓解梯度消失和梯度爆炸问题,提高模型的稳定性和泛化能力。而优化器的选择和调整可以加速模型的收敛速度,提高模型的训练效率。

相关代码示例:

import numpy as npfrom sklearn.datasets import load_digitsfrom sklearn.model_selection import train_test_splitfrom sklearn.preprocessing import OneHotEncoderfrom tensorflow.keras.models import Sequentialfrom tensorflow.keras.layers import Dense# 加载手写数字数据集digits = load_digits()X = digits.datay = digits.target# 将标签进行独热编码encoder = OneHotEncoder(sparse=False)y_encoded = encoder.fit_transform(y.reshape(-1, 1))# 划分训练集和测试集X_train, X_test, y_train, y_test = train_test_split(X, y_encoded, test_size=0.2, random_state=42)# 构建神经网络模型model = Sequential([ Dense(64, activation='relu', input_shape=(64,)), Dense(64, activation='relu'), Dense(10, activation='softmax')])# 编译模型model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])# 训练模型model.fit(X_train, y_train, epochs=10, batch_size=16, validation_split=0.1)# 在测试集上进行预测y_pred = model.predict(X_test)y_pred = np.argmax(y_pred, axis=1)# 计算准确率accuracy = np.mean(y_pred == y_test)print("Accuracy:", accuracy)海浪学长项目示例: