张士玉小黑屋

一个关注IT技术分享,关注互联网的网站,爱分享网络资源,分享学到的知识,分享生活的乐趣。

当前位置:首页 » 特征 - 第2页

02月24日

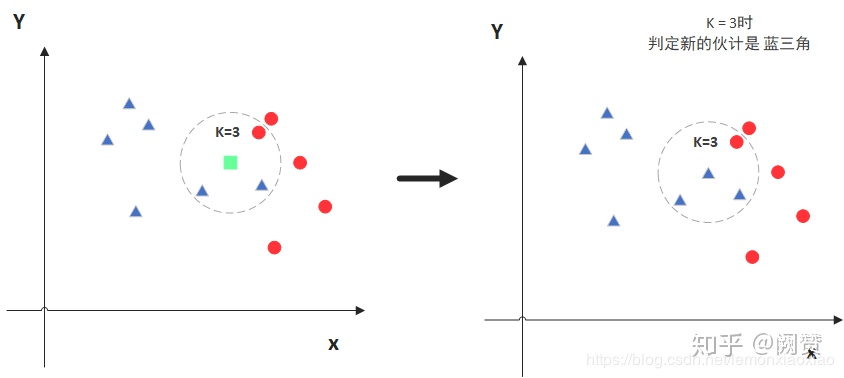

ICCV 2021 | 表现SOTA!CurveNet:面向点云几何形状的长距离特征提取网络_阿木寺的博客

发布 : zsy861 | 分类 : 《随便一记》 | 评论 : 0 | 浏览 : 586次

02月06日

「ORB_SLAM2|3实践笔记」构造函数Frame::Frame() 、去畸变UndistortKeyPoints()、计算虚拟右目横坐标ComputeStereoFromRGBD_小秋SLAM和DL实践笔记

发布 : zsy861 | 分类 : 《休闲阅读》 | 评论 : 0 | 浏览 : 509次

01月22日

Python计算树模型(随机森林、xgboost等)的特征重要度及其波动程度:基于熵减的特征重要度计算及可视化、基于特征排列的特征重要性(feature permutation)计算及可视化_data+scenario+science+insight

发布 : zsy861 | 分类 : 《关注互联网》 | 评论 : 0 | 浏览 : 577次

12月21日

Distilling Holistic Knowledge with Graph Neural Networks论文解读_Daft shiner的博客

发布 : zsy861 | 分类 : 《随便一记》 | 评论 : 0 | 浏览 : 467次

11月22日

睿智的目标检测52——Keras搭建YoloX目标检测平台_Bubbliiiing的学习小课堂

发布 : zsy861 | 分类 : 《随便一记》 | 评论 : 0 | 浏览 : 521次

search zhannei

最新文章

Copyright © 2020-2022 ZhangShiYu.com Rights Reserved.豫ICP备2022013469号-1