传奇开心果博文系列

系列博文目录Python的文本和语音相互转换库技术点案例示例系列 博文目录前言一、雏形示例代码二、扩展思路介绍三、Azure多语种支持示例代码四、Azure实时对话模式示例代码五、Azure自定义翻译模型示例代码六、Azure语音合成示例代码七、Azure用户界面优化示例代码八、Azure离线模式支持示例代码九、Azure安全和隐私保护示例代码十、Azure集成其他服务示例代码十一、归纳总结

系列博文目录

Python的文本和语音相互转换库技术点案例示例系列

博文目录

前言

语音翻译应用程序:结合Microsoft Azure的语音识别和翻译服务,很容易开发支持多语言的语音翻译应用程序,帮助用户进行跨语种语言跨平台交流。

语音翻译应用程序:结合Microsoft Azure的语音识别和翻译服务,很容易开发支持多语言的语音翻译应用程序,帮助用户进行跨语种语言跨平台交流。

一、雏形示例代码

以下是一个简单示例代码,使用Azure的语音识别和翻译服务来实现一个支持多语言的语音翻译应用程序。在这个示例中,我们使用Azure的语音服务和翻译服务,你需要替换

以下是一个简单示例代码,使用Azure的语音识别和翻译服务来实现一个支持多语言的语音翻译应用程序。在这个示例中,我们使用Azure的语音服务和翻译服务,你需要替换 <YOUR_REGION>, <YOUR_SUBSCRIPTION_KEY> 和 <YOUR_TRANSLATOR_KEY> 分别为你的Azure区域、语音服务订阅密钥和翻译服务密钥。

import azure.cognitiveservices.speech as speechsdkimport osfrom azure.ai.textanalytics import TextAnalyticsClientfrom azure.core.credentials import AzureKeyCredential# 语音识别配置speech_key = "<YOUR_SUBSCRIPTION_KEY>"service_region = "<YOUR_REGION>"speech_config = speechsdk.SpeechConfig(subscription=speech_key, region=service_region)# 翻译配置translator_key = "<YOUR_TRANSLATOR_KEY>"translator_region = "global"translator_endpoint = "https://api.cognitive.microsofttranslator.com/"translator_credentials = AzureKeyCredential(translator_key)translator_client = TextAnalyticsClient(endpoint=translator_endpoint, credential=translator_credentials)def translate_speech_to_text(speech_config, translator_client): speech_recognizer = speechsdk.SpeechRecognizer(speech_config) print("Speak something...") result = speech_recognizer.recognize_once() if result.reason == speechsdk.ResultReason.RecognizedSpeech: print("Recognized: {}".format(result.text)) # 翻译文本 translation = translator_client.translate(result.text, target_language="en") print("Translated: {}".format(translation.result)) elif result.reason == speechsdk.ResultReason.NoMatch: print("No speech could be recognized.") elif result.reason == speechsdk.ResultReason.Canceled: cancellation_details = result.cancellation_details print("Speech Recognition canceled: {}".format(cancellation_details.reason)) if cancellation_details.reason == speechsdk.CancellationReason.Error: print("Error details: {}".format(cancellation_details.error_details))translate_speech_to_text(speech_config, translator_client)这段代码演示了如何使用Azure的语音服务和翻译服务来实现语音识别和翻译功能。请确保已安装 azure-cognitiveservices-speech 和 azure-ai-textanalytics Python 包。此示例仅供参考,实际开发中可能需要根据具体需求进行更多的定制和优化。

二、扩展思路介绍

当开发语音翻译应用程序时,除了基本的语音识别和翻译功能外,还可以考虑以下扩展思路来增强应用程序的功能和用户体验:

当开发语音翻译应用程序时,除了基本的语音识别和翻译功能外,还可以考虑以下扩展思路来增强应用程序的功能和用户体验:

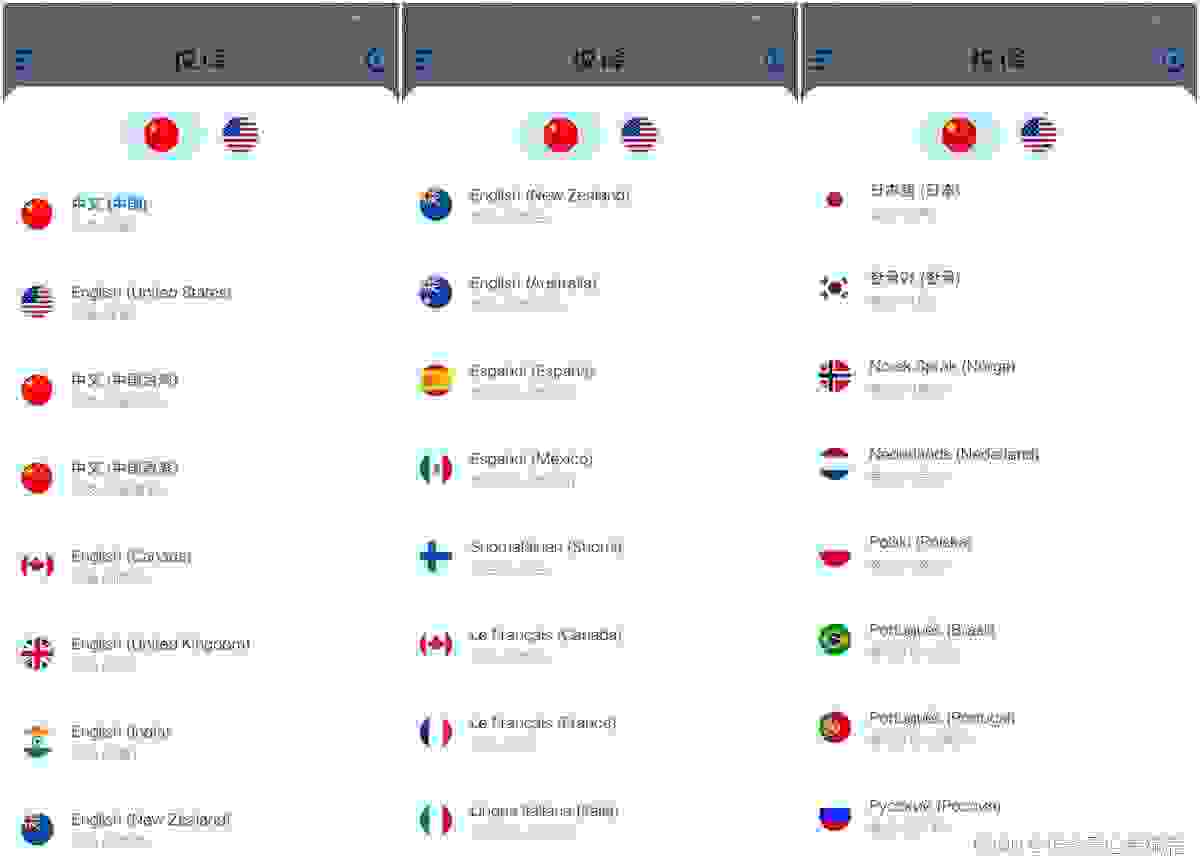

多语种支持:除了基本的语言翻译功能,可以进一步扩展支持更多语种,包括一些少数民族语言或地区方言,以满足更广泛的用户需求。

实时对话模式:实现实时对话模式,让用户可以进行连续的对话,实时翻译并显示对话内容,模拟真实的跨语言交流场景。

自定义翻译模型:根据特定领域的术语和表达习惯,可以训练自定义的翻译模型,提高翻译的准确性和专业性。

语音合成:结合语音合成技术,将翻译后的文本转换为自然流畅的语音输出,实现双向的语音翻译和交流。

用户界面优化:设计直观友好的用户界面,包括语言选择、语音输入、翻译结果展示等模块,提升用户体验和易用性。

离线模式支持:考虑在应用中集成离线模式,允许用户在没有网络连接的情况下继续使用基本的语音识别和翻译功能。

安全和隐私保护:确保用户语音数据和翻译内容的安全性和隐私保护,遵守相关的数据保护法规和标准。

集成其他服务:考虑与其他服务集成,如语音识别后的文本可以进一步用于文本分析、信息提取等,增加应用程序的价值和功能多样性。

通过以上扩展思路的实施,可以使语音翻译应用程序更加智能、全面,满足用户在跨语言交流和沟通方面的多样化需求,提升用户体验和应用的实用性。

三、Azure多语种支持示例代码

在Azure中实现多语种支持可以通过Azure Translator Text API来实现。以下是一个示例代码,演示如何使用Azure Translator Text API 来支持多语种翻译,包括一些少数民族语言或地区方言。请确保替换

在Azure中实现多语种支持可以通过Azure Translator Text API来实现。以下是一个示例代码,演示如何使用Azure Translator Text API 来支持多语种翻译,包括一些少数民族语言或地区方言。请确保替换 <YOUR_SUBSCRIPTION_KEY> 和 <YOUR_ENDPOINT> 为你的Azure订阅密钥和终结点。

from azure.core.credentials import AzureKeyCredentialfrom azure.ai.textanalytics import TextAnalyticsClient# 替换为你的Azure订阅密钥和终结点key = "<YOUR_SUBSCRIPTION_KEY>"endpoint = "<YOUR_ENDPOINT>"# 支持的语言列表,可以根据需求扩展languages = ["en", "es", "fr", "zh-Hans", "ar", "ru", "de"]def translate_text(text, target_language): credential = AzureKeyCredential(key) client = TextAnalyticsClient(endpoint=endpoint, credential=credential) response = client.translate(text, target_language=target_language) return response.resulttext = "Hello, how are you?"for lang in languages: translation = translate_text(text, lang) print(f"Translated to {lang}: {translation}")在这个示例中,我们定义了一个支持的语言列表 languages,然后循环遍历这些语言,将输入的文本翻译成各种语言。你可以根据需要扩展或修改支持的语言列表。这样,用户可以选择不同的语言进行翻译,包括一些少数民族语言或地区方言,从而满足更广泛的用户需求。

四、Azure实时对话模式示例代码

要在Azure中实现实时对话模式,可以结合Azure的语音识别和翻译服务来实现。以下是一个简单的示例代码,演示如何实现实时对话模式,让用户进行连续的对话,实时翻译并显示对话内容。请确保替换

要在Azure中实现实时对话模式,可以结合Azure的语音识别和翻译服务来实现。以下是一个简单的示例代码,演示如何实现实时对话模式,让用户进行连续的对话,实时翻译并显示对话内容。请确保替换 <YOUR_SUBSCRIPTION_KEY> 和 <YOUR_REGION> 为你的Azure订阅密钥和区域。

import azure.cognitiveservices.speech as speechsdk# 替换为你的Azure订阅密钥和区域speech_key = "<YOUR_SUBSCRIPTION_KEY>"service_region = "<YOUR_REGION>"def translate_speech_to_text(speech_text, target_language): translation_config = speechsdk.translation.SpeechTranslationConfig( subscription=speech_key, region=service_region ) translation_config.speech_recognition_language = "en-US" translation_config.add_target_language(target_language) recognizer = speechsdk.translation.TranslationRecognizer(translation_config=translation_config) result = recognizer.recognize_once() return result.translations[target_language]# 实时对话模式while True: user_input = input("You: ") translated_text = translate_speech_to_text(user_input, "fr") # 将用户输入翻译成法语 print("Translated: ", translated_text)在这个示例中,用户可以连续输入对话内容,程序会将用户输入的内容实时翻译成法语并显示出来。你可以根据需要修改目标语言或者添加更多的目标语言。这样,用户可以模拟真实的跨语言交流场景,在实时对话中进行语音翻译,增强用户体验。

五、Azure自定义翻译模型示例代码

要在Azure中训练自定义翻译模型,可以使用Azure Custom Translator服务。Custom Translator服务允许你使用自定义术语和数据集训练翻译模型,以提高翻译的准确性和专业性。以下是一个简单的示例代码,演示如何使用Azure Custom Translator服务训练自定义翻译模型。请确保替换

要在Azure中训练自定义翻译模型,可以使用Azure Custom Translator服务。Custom Translator服务允许你使用自定义术语和数据集训练翻译模型,以提高翻译的准确性和专业性。以下是一个简单的示例代码,演示如何使用Azure Custom Translator服务训练自定义翻译模型。请确保替换 <YOUR_SUBSCRIPTION_KEY> 和 <YOUR_ENDPOINT> 为你的Azure订阅密钥和终结点。

from azure.ai.translation.custom import TranslationProject, TranslationClientfrom azure.core.credentials import AzureKeyCredential# 替换为你的Azure订阅密钥和终结点key = "<YOUR_SUBSCRIPTION_KEY>"endpoint = "<YOUR_ENDPOINT>"# 创建自定义翻译项目project = TranslationProject(endpoint=endpoint, credential=AzureKeyCredential(key))# 添加训练数据project.add_document("en", "fr", "This is a sample sentence.", "C'est une phrase d'exemple.")# 开始训练翻译模型project.train()# 获取训练状态while not project.is_training: project.refresh()print("Training started...")# 等待训练完成project.wait_until_done()# 获取训练结果if project.status == "Succeeded": print("Training succeeded. Model ID:", project.model_id)else: print("Training failed. Status:", project.status)# 使用自定义翻译模型进行翻译client = TranslationClient(endpoint=endpoint, credential=AzureKeyCredential(key))result = client.translate(["This is a sample sentence."], models=[project.model_id], source_language="en", target_language="fr")print("Translated text:", result[0].translations[0].text)在这个示例中,我们创建了一个自定义翻译项目,添加了训练数据并开始训练翻译模型。一旦训练完成,我们可以使用训练好的自定义翻译模型进行翻译。通过训练自定义翻译模型,你可以根据特定领域的需求定制翻译模型,提高翻译的准确性和专业性。

六、Azure语音合成示例代码

要在Azure中实现语音合成功能,可以使用Azure的语音服务(Text to Speech)。以下是一个简单的示例代码,演示如何结合语音合成技术,将翻译后的文本转换为自然流畅的语音输出。请确保替换

要在Azure中实现语音合成功能,可以使用Azure的语音服务(Text to Speech)。以下是一个简单的示例代码,演示如何结合语音合成技术,将翻译后的文本转换为自然流畅的语音输出。请确保替换 <YOUR_SUBSCRIPTION_KEY> 和 <YOUR_REGION> 为你的Azure订阅密钥和区域。

import azure.cognitiveservices.speech as speechsdk# 替换为你的Azure订阅密钥和区域speech_key = "<YOUR_SUBSCRIPTION_KEY>"service_region = "<YOUR_REGION>"def translate_text_to_speech(text, language): speech_config = speechsdk.SpeechConfig(subscription=speech_key, region=service_region) speech_synthesizer = speechsdk.SpeechSynthesizer(speech_config=speech_config) result = speech_synthesizer.speak_text_async(text).get() if result.reason == speechsdk.ResultReason.SynthesizingAudioCompleted: print("Speech synthesis is successful.") else: print("Speech synthesis failed: {}".format(result.reason))# 翻译文本并转换为语音输出translated_text = "Bonjour, comment ça va?"translate_text_to_speech(translated_text, "fr-FR")在这个示例中,我们定义了一个 translate_text_to_speech 函数,用于将文本转换为语音输出。在函数中,我们使用Azure的语音合成服务,将翻译后的文本转换为相应语言的语音输出。你可以根据需要调用这个函数,实现双向的语音翻译和交流,让用户可以听到翻译后的内容。这样可以增强用户体验,使交流更加自然和流畅。

七、Azure用户界面优化示例代码

要设计一个直观友好的用户界面,包括语言选择、语音输入、翻译结果展示等模块,你可以使用前端开发技术如HTML、CSS和JavaScript来实现。以下是一个简单的示例代码,展示一个基本的用户界面,用于语音翻译应用。你可以根据需求和设计风格进行定制。

要设计一个直观友好的用户界面,包括语言选择、语音输入、翻译结果展示等模块,你可以使用前端开发技术如HTML、CSS和JavaScript来实现。以下是一个简单的示例代码,展示一个基本的用户界面,用于语音翻译应用。你可以根据需求和设计风格进行定制。

<!DOCTYPE html><html lang="en"><head><meta charset="UTF-8"><meta name="viewport" content="width=device-width, initial-scale=1.0"><title>Voice Translation App</title><style> /* CSS样式 */ body { font-family: Arial, sans-serif; } .container { max-width: 600px; margin: 0 auto; padding: 20px; text-align: center; }</style></head><body><div class="container"> <h1>Voice Translation App</h1> <label for="selectLanguage">Select Language:</label> <select id="selectLanguage"> <option value="en">English</option> <option value="fr">French</option> <option value="es">Spanish</option> <!-- 添加更多语言选项 --> </select> <br><br> <textarea id="inputText" rows="4" cols="50" placeholder="Speak or type text here..."></textarea> <br><br> <button onclick="translateText()">Translate</button> <br><br> <div id="translationResult"></div></div><script> // JavaScript代码 function translateText() { var selectedLanguage = document.getElementById("selectLanguage").value; var inputText = document.getElementById("inputText").value; // 在此调用翻译和语音合成功能,将结果展示在页面上 // 可以使用Azure的翻译和语音合成服务进行实际翻译和语音合成操作 // 示例代码中仅包含用户界面部分的逻辑 var translatedText = "Translated text will appear here."; document.getElementById("translationResult").innerText = translatedText; }</script></body></html>这个示例代码包含了一个简单的用户界面,用户可以选择语言、输入文本,然后点击按钮进行翻译。实际的翻译和语音合成功能需要调用Azure的相应服务来实现。你可以根据需求和设计风格对界面进行进一步的美化和定制,以提升用户体验和易用性。

八、Azure离线模式支持示例代码

要在应用中集成离线模式支持,允许用户在没有网络连接的情况下继续使用基本的语音识别和翻译功能,你可以考虑使用Azure的语音服务中的离线语音识别功能。Azure提供了离线语音识别SDK,可以在没有网络连接的情况下进行语音识别。以下是一个简单的示例代码,演示如何在Azure中实现离线模式支持。

要在应用中集成离线模式支持,允许用户在没有网络连接的情况下继续使用基本的语音识别和翻译功能,你可以考虑使用Azure的语音服务中的离线语音识别功能。Azure提供了离线语音识别SDK,可以在没有网络连接的情况下进行语音识别。以下是一个简单的示例代码,演示如何在Azure中实现离线模式支持。

import azure.cognitiveservices.speech as speechsdk# 替换为你的Azure订阅密钥和区域speech_key = "<YOUR_SUBSCRIPTION_KEY>"service_region = "<YOUR_REGION>"def offline_speech_recognition(audio_file_path, language): speech_config = speechsdk.SpeechConfig(subscription=speech_key, region=service_region) speech_config.speech_recognition_language = language audio_input = speechsdk.AudioConfig(filename=audio_file_path) speech_recognizer = speechsdk.SpeechRecognizer(speech_config=speech_config, audio_config=audio_input) result = speech_recognizer.recognize_once() if result.reason == speechsdk.ResultReason.RecognizedSpeech: print("Recognized: {}".format(result.text)) elif result.reason == speechsdk.ResultReason.NoMatch: print("No speech could be recognized.") elif result.reason == speechsdk.ResultReason.Canceled: cancellation_details = result.cancellation_details print("Speech recognition canceled: {}".format(cancellation_details.reason))# 在离线模式下进行语音识别audio_file_path = "path/to/your/audio/file.wav"offline_speech_recognition(audio_file_path, "en-US")在这个示例中,我们定义了一个 offline_speech_recognition 函数,用于在离线模式下进行语音识别。函数中使用了Azure的离线语音识别SDK,可以传入本地音频文件路径进行识别。请确保替换 <YOUR_SUBSCRIPTION_KEY> 和 <YOUR_REGION> 为你的Azure订阅密钥和区域,以及替换 audio_file_path 为你的本地音频文件路径。这样用户就可以在没有网络连接的情况下继续使用基本的语音识别功能。

九、Azure安全和隐私保护示例代码

在确保用户语音数据和翻译内容的安全性和隐私保护方面,你可以采取一些措施来保障用户数据的安全性,包括使用加密技术、访问控制、数据匿名化等。此外,遵守相关的数据保护法规和标准也是非常重要的,如GDPR(《通用数据保护条例》)等。

在确保用户语音数据和翻译内容的安全性和隐私保护方面,你可以采取一些措施来保障用户数据的安全性,包括使用加密技术、访问控制、数据匿名化等。此外,遵守相关的数据保护法规和标准也是非常重要的,如GDPR(《通用数据保护条例》)等。

以下是一些示例代码,展示如何在Azure中使用加密技术来保护用户数据的安全性:

import azure.identityfrom azure.keyvault.secrets import SecretClientfrom azure.identity import DefaultAzureCredential# 替换为你的Azure Key Vault名称和区域key_vault_name = "your-key-vault-name"key_vault_url = "https://" + key_vault_name + ".vault.azure.net/"# 使用Azure默认凭据获取访问密钥credential = DefaultAzureCredential()client = SecretClient(vault_url=key_vault_url, credential=credential)# 从Azure Key Vault中获取加密密钥key_name = "encryption-key"key_value = client.get_secret(key_name).value# 使用获取的密钥对用户数据进行加密def encrypt_data(data, key): # 在这里实现加密算法,这里只是一个示例 encrypted_data = data + " encrypted with key: " + key return encrypted_data# 使用获取的密钥对用户数据进行解密def decrypt_data(data, key): # 在这里实现解密算法,这里只是一个示例 decrypted_data = data.replace(" encrypted with key: " + key, "") return decrypted_data# 示例:加密用户数据user_data = "Sensitive data to be encrypted"encrypted_data = encrypt_data(user_data, key_value)print("Encrypted data:", encrypted_data)# 示例:解密用户数据decrypted_data = decrypt_data(encrypted_data, key_value)print("Decrypted data:", decrypted_data)在这个示例中,我们使用Azure Key Vault来存储加密密钥,并通过Azure默认凭据获取访问密钥。然后,我们定义了 encrypt_data 和 decrypt_data 函数,用于加密和解密用户数据。这样可以确保用户语音数据和翻译内容的安全性和隐私保护。请根据实际需求和安全标准对代码进行定制和扩展。

十、Azure集成其他服务示例代码

要将Azure语音识别后的文本与其他服务集成,可以使用Azure的文本分析服务来进行文本分析、信息提取等操作。Azure提供了文本分析服务,可以帮助你从文本中提取关键短语、实体、情绪等信息。以下是一个示例代码,演示如何将语音识别后的文本与Azure文本分析服务进行集成:

要将Azure语音识别后的文本与其他服务集成,可以使用Azure的文本分析服务来进行文本分析、信息提取等操作。Azure提供了文本分析服务,可以帮助你从文本中提取关键短语、实体、情绪等信息。以下是一个示例代码,演示如何将语音识别后的文本与Azure文本分析服务进行集成:

from azure.core.credentials import AzureKeyCredentialfrom azure.ai.textanalytics import TextAnalyticsClientfrom azure.ai.textanalytics import TextAnalyticsApiKeyCredential# 替换为你的Azure文本分析服务密钥和终结点text_analytics_key = "<YOUR_TEXT_ANALYTICS_KEY>"text_analytics_endpoint = "<YOUR_TEXT_ANALYTICS_ENDPOINT>"def analyze_text(text): text_analytics_credential = TextAnalyticsApiKeyCredential(text_analytics_key) text_analytics_client = TextAnalyticsClient(endpoint=text_analytics_endpoint, credential=text_analytics_credential) result = text_analytics_client.analyze_sentiment([text]) for doc in result: for idx, sentence in enumerate(doc.sentences): print("Sentence: {}".format(sentence.text)) print("Sentiment: {}".format(sentence.sentiment)) print("Confidence scores:") print("Positive: {}".format(sentence.confidence_scores.positive)) print("Neutral: {}".format(sentence.confidence_scores.neutral)) print("Negative: {}".format(sentence.confidence_scores.negative))# 从语音识别后的文本进行文本分析recognized_text = "The text recognized from speech"analyze_text(recognized_text)在这个示例中,我们定义了一个 analyze_text 函数,用于将文本传递给Azure文本分析服务进行情感分析。你需要替换 <YOUR_TEXT_ANALYTICS_KEY> 和 <YOUR_TEXT_ANALYTICS_ENDPOINT> 为你的Azure文本分析服务密钥和终结点。然后,我们调用这个函数,将从语音识别后的文本传递给文本分析服务进行情感分析,提取情感信息和置信度分数。这样可以增加应用程序的价值和功能多样性,为用户提供更丰富的信息和服务。

十一、归纳总结

开发Microsoft Azure语音翻译应用程序涉及多方面的知识点,以下是对相关知识点的归纳总结:

开发Microsoft Azure语音翻译应用程序涉及多方面的知识点,以下是对相关知识点的归纳总结:

Azure语音服务:

使用Azure语音服务进行语音识别和语音合成。了解如何配置Azure语音服务,包括API密钥、终结点等。Azure翻译服务:

使用Azure翻译服务进行文本翻译。熟悉Azure翻译服务的功能和限制,如支持的语言等。用户界面设计:

设计直观友好的用户界面,包括语音输入和文本输出的展示。考虑用户体验和易用性,确保用户能够方便地使用应用程序。数据安全和隐私保护:

确保用户语音数据和翻译内容的安全性和隐私保护。使用加密技术、访问控制等措施保障用户数据的安全。多语种支持:

实现多语种的语音识别和翻译功能,为用户提供更广泛的语言支持。与其他服务集成:

将语音识别后的文本与其他服务集成,如文本分析、信息提取等,增加应用程序的价值和功能多样性。实时对话模式:

实现实时对话模式,使用户能够进行实时语音输入和翻译,提升用户体验。离线模式支持:

考虑实现离线模式支持,使用户能够在没有网络连接的情况下使用应用程序。遵守法规和标准:

遵守相关的数据保护法规和标准,如GDPR等,保护用户数据的隐私和安全。 以上知识点涵盖了在Microsoft Azure上开发语音翻译应用程序所需的关键方面,希望对你有所帮助。如果有任何进一步的问题或需要更多详细信息,请随时告诉我。

以上知识点涵盖了在Microsoft Azure上开发语音翻译应用程序所需的关键方面,希望对你有所帮助。如果有任何进一步的问题或需要更多详细信息,请随时告诉我。