深入学习Pandas:数据连接、合并、加入、添加、重构函数的全面指南

Pandas是Python中最强大且广泛使用的数据处理库之一,提供了丰富的函数和工具,以便更轻松地处理和分析数据。在本文中,我们将深入探讨Pandas中一系列数据连接、合并、加入、添加、重构函数,包括merge、concat、join、append、stack和unstack。通过理解这些功能,你将能够更灵活地处理和转换数据,提高数据分析和清理的效率。

1. merge函数

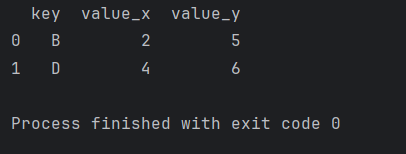

merge函数用于将两个数据框基于一个或多个键进行连接。以下是一个简单的示例:

import pandas as pd# 创建两个数据框df1 = pd.DataFrame({'key': ['A', 'B', 'C', 'D'], 'value': [1, 2, 3, 4]})df2 = pd.DataFrame({'key': ['B', 'D', 'E', 'F'], 'value': [5, 6, 7, 8]})# 使用merge进行连接merged_df = pd.merge(df1, df2, on='key')print(merged_df)在这个例子中,我们使用merge函数基于’key’列连接了两个数据框。输出将是一个包含共同键的新数据框。

2. concat函数

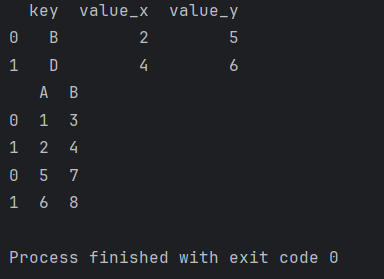

concat函数用于沿着指定轴连接多个数据框。以下是一个示例:

# 创建两个数据框df1 = pd.DataFrame({'A': [1, 2], 'B': [3, 4]})df2 = pd.DataFrame({'A': [5, 6], 'B': [7, 8]})# 使用concat进行连接concatenated_df = pd.concat([df1, df2])print(concatenated_df)在这个例子中,我们使用concat函数沿着默认的行轴连接了两个数据框。你还可以通过指定axis参数来沿着列轴连接。

3. join函数

join函数用于将两个数据框基于索引进行连接。以下是一个简单的例子:

# 创建两个数据框df1 = pd.DataFrame({'value': [1, 2]}, index=['A', 'B'])df2 = pd.DataFrame({'value': [3, 4]}, index=['B', 'C'])# 使用join进行连接joined_df = df1.join(df2, how='inner')print(joined_df)在这个例子中,我们使用join函数将两个数据框基于索引进行了内连接(inner join)。

4. append函数

append函数用于将一个数据框追加到另一个数据框的末尾。以下是一个例子:

# 创建两个数据框df1 = pd.DataFrame({'A': [1, 2], 'B': [3, 4]})df2 = pd.DataFrame({'A': [5, 6], 'B': [7, 8]})# 使用append进行连接appended_df = df1.append(df2)print(appended_df)在这个例子中,我们使用append函数将df2追加到了df1的末尾。

5. stack和unstack函数

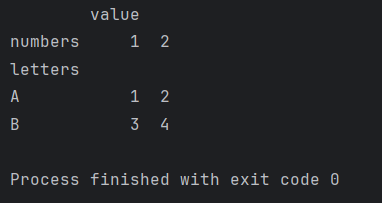

stack和unstack函数用于在行和列之间进行数据重构。以下是一个示例:

# 创建一个多层索引的数据框arrays = [['A', 'A', 'B', 'B'], [1, 2, 1, 2]]multi_index = pd.MultiIndex.from_arrays(arrays, names=('letters', 'numbers'))df = pd.DataFrame({'value': [1, 2, 3, 4]}, index=multi_index)# 使用stack进行数据重构stacked_df = df.stack()print(stacked_df)在这个例子中,我们使用stack函数将列标签的层次结构转移到行索引,创建了一个更紧凑的数据框。

6. stack 和 unstack 函数

stack 和 unstack 函数是用于在行和列之间进行数据重构的强大工具。下面是一个例子:

# 创建一个多层索引的数据框arrays = [['A', 'A', 'B', 'B'], [1, 2, 1, 2]]multi_index = pd.MultiIndex.from_arrays(arrays, names=('letters', 'numbers'))df = pd.DataFrame({'value': [1, 2, 3, 4]}, index=multi_index)# 使用unstack进行数据重构unstacked_df = df.unstack()print(unstacked_df)在这个例子中,我们使用unstack函数将行索引的层次结构转移到列,使数据框更为直观。

7. set_index 和 reset_index 函数

set_index 和 reset_index 函数用于重新设置数据框的索引,有助于灵活地处理数据框的结构。

# 创建一个简单的数据框df = pd.DataFrame({'A': [1, 2, 3], 'B': [4, 5, 6]})# 使用 set_index 将 'A' 列设置为新的索引df_set_index = df.set_index('A')print(df_set_index)在这个例子中,我们使用 set_index 将 ‘A’ 列设置为新的索引,这可以方便地基于该列进行数据检索。

# 使用 reset_index 重新设置索引df_reset_index = df_set_index.reset_index()print(df_reset_index)而 reset_index 则是用于将设置的新索引还原为默认整数索引。这在某些情况下很有用,特别是在进行一些索引操作后需要将数据框还原到初始状态。

8. pd.merge 的更高级用法

除了基本的连接操作,pd.merge 还提供了一些高级用法,如多键连接、不同连接方式等。

# 创建两个数据框df1 = pd.DataFrame({'key1': ['A', 'B', 'C'], 'key2': ['X', 'Y', 'Z'], 'value': [1, 2, 3]})df2 = pd.DataFrame({'key1': ['A', 'B', 'C'], 'key2': ['X', 'Z', 'Y'], 'value': [4, 5, 6]})# 多键连接multikey_merge = pd.merge(df1, df2, on=['key1', 'key2'])print(multikey_merge)在这个例子中,我们使用 pd.merge 进行多键连接,通过传递一个键的列表,实现更精确的匹配。

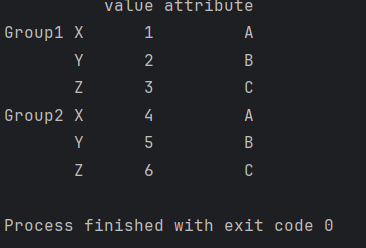

9. 分层索引的运用

分层索引是 Pandas 中一项重要的功能,通过它,你可以创建具有多层次的行或列索引,更灵活地组织和访问数据。

# 创建一个包含分层索引的数据框data = {'value': [1, 2, 3, 4, 5, 6], 'attribute': ['A', 'B', 'C', 'A', 'B', 'C']}df_multiindex = pd.DataFrame(data, index=[['Group1', 'Group1', 'Group1', 'Group2', 'Group2', 'Group2'], ['X', 'Y', 'Z', 'X', 'Y', 'Z']], columns=['value', 'attribute'])print(df_multiindex)在这个例子中,我们创建了一个包含两层分层索引的数据框,其中第一层为 ‘Group1’ 和 ‘Group2’,第二层为 ‘X’、‘Y’ 和 ‘Z’。这样的数据结构使得我们可以更方便地进行多层次的数据分析和操作。

10. 处理缺失数据

数据中经常会包含缺失值,而 Pandas 提供了一系列处理缺失数据的方法,例如 dropna 和 fillna。

# 创建一个包含缺失值的数据框df_missing = pd.DataFrame({'A': [1, 2, np.nan, 4], 'B': [5, np.nan, 7, 8]})# 使用 dropna 删除包含缺失值的行df_cleaned = df_missing.dropna()print(df_cleaned)在这个例子中,我们使用 dropna 删除包含缺失值的行。除此之外,你还可以使用 fillna 来填充缺失值,以便更好地保留数据。

总结:

通过本文,我们深入探讨了 Pandas 中一系列重要的数据连接、合并、加入、添加、重构函数,包括 merge、concat、join、append、stack、unstack、set_index 和 reset_index 等。这些功能为数据科学家和分析师提供了强大的工具,使其能够更灵活地处理和分析各种数据。

我们学习了基本的连接和合并操作,了解了如何使用不同的连接方式以及处理多键连接。同时,介绍了分层索引的运用,使数据结构更为灵活。

此外,我们还探讨了处理缺失数据的方法,包括使用 dropna 删除缺失值所在的行和使用 fillna 填充缺失值,从而在数据清理和准备阶段更加得心应手。

通过不断练习和应用这些知识,你将更加熟练地处理不同类型的数据,并能够更高效地进行数据分析和挖掘。Pandas 提供的这些功能和技巧,无疑为数据科学领域的从业者提供了强大的支持,希望本文能够为你在数据处理的学习和实践中提供有益的指导。祝你在数据科学的旅程中取得更大的成功!