一、准备工作

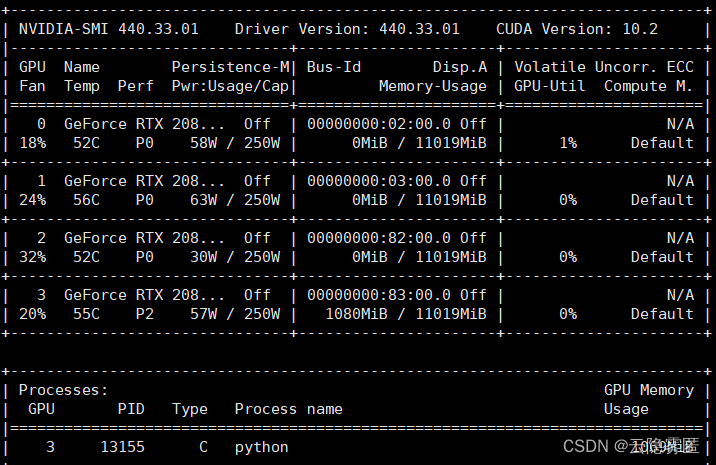

查看GPU状态和信息,找到空闲的GPU:

nvidia-smi

二、指定单GPU

从图中 Processes 表格我们可以发现0、1、2号GPU均是可以利用的。于是我们可以在python文件中加入以下代码,表示使用0号GPU:

import osos.environ["CUDA_VISIBLE_DEVICES"] = "0" # 使用0号GPU或者可以在命令行窗口处输入,表示使用1号GPU运行代码:

CUDA_VISIBLE_DEVICES=1 python your_model.py # 使用1号GPU运行代码再或者使用 torch.cuda.set_device()函数指定gpu使用编号:

import torchtorch.cuda.set_device(2) # 使用2号GPU三、指定多GPU

若此时所有GPU都是空闲的,那么最简单的做法是:

import torchmodel = torch.nn.DataParallel(model) # 使用默认所有存在的GPU而假如像上文所述只有0、1、2号显卡空闲,那么可以使用以下代码指定多个GPU:

(注意:无论是指定单个GPU还是多个GPU,设定 os 的语句需要放在 import torch 语句之前,否则指定GPU的操作可能无法生效)

import osos.environ["CUDA_VISIBLE_DEVICES"] = ','.join(map(str, [0,1,2])) # 一般在程序开头设置import torchmodel = torch.nn.DataParallel(model) # 等价于os.environ["CUDA_VISIBLE_DEVICES"] = '0,1,2'可以看到两者相比,后者其实就是限定了GPU范围。

或者直接使用更简便的方法:

import torchtorch.nn.DataParallel(model, device_ids=[0, 1, 2]) # 使用0、1、2号GPU四、补充

为GPU设置随机种子

import torchtorch.cuda.manual_seed(seed)torch.cuda.manual_seed_all(seed)