C++版本OpenCv教程(一)Mat—基本的图像容器

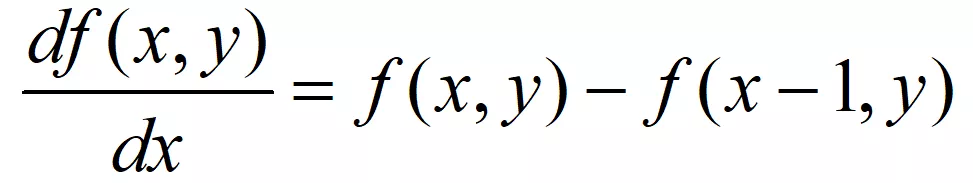

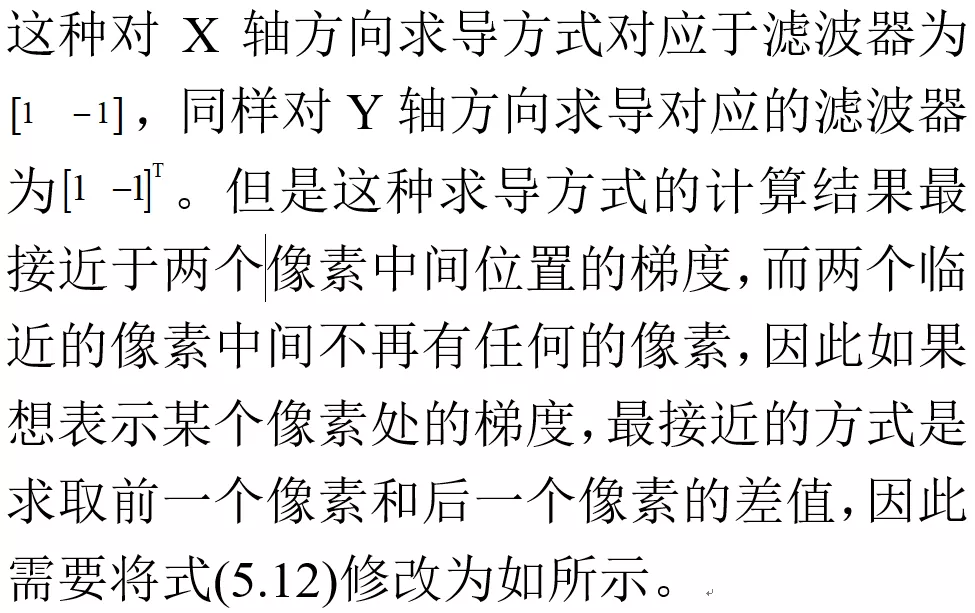

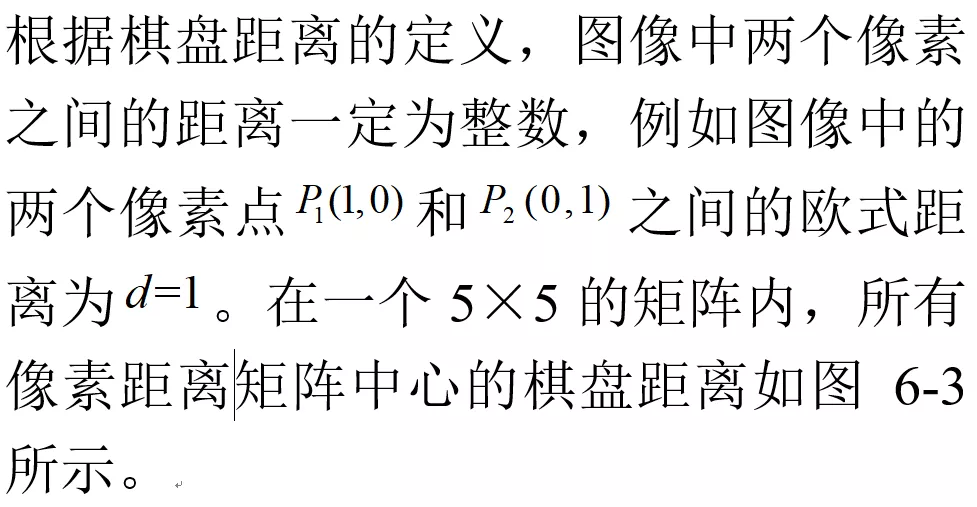

目标

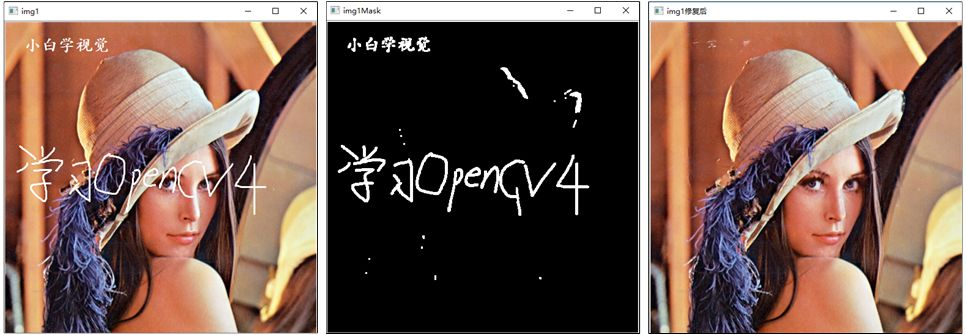

我们有多种方法从现实世界获取数字图像:数码相机、扫描仪、计算机断层扫描和磁共振成像等等。在以上任何情况下,我们(人类)看到的都是图像。然而,当将其转换到我们的数字设备时,我们所记录的是图像中每个点的数值。

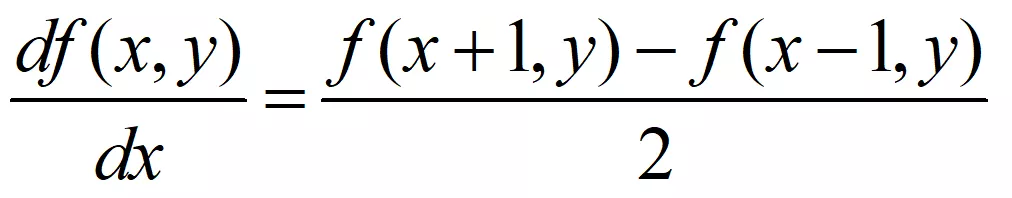

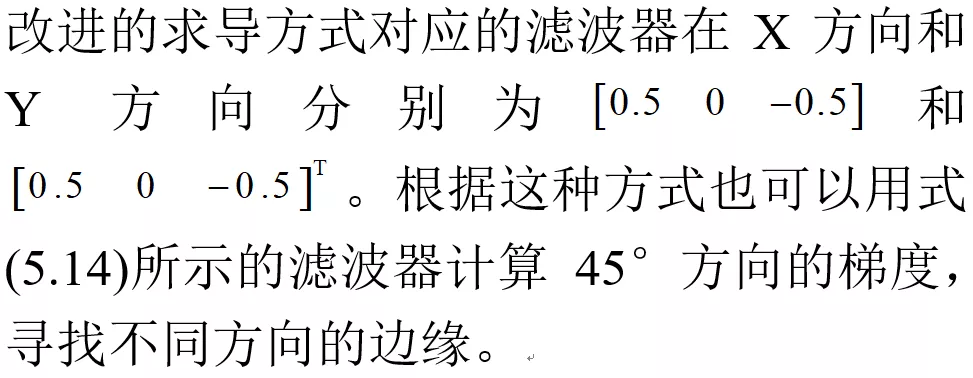

例如,在上面的图像中,你可以看到汽车的镜子只不过是一个包含所有像素点的强度值的矩阵。我们获取和存储像素值的方式可能会根据我们的需要而有所不同,但最终计算机世界中的所有图像都可能被简化为数值矩阵和描述矩阵本身的其他信息。OpenCV是一个计算机视觉库,主要致力于处理和操作这些信息。因此,首先需要熟悉OpenCV如何存储和处理图像。

Mat

cv::Mat Class Reference

关于Mat,您需要知道的第一件事是,您不再需要 手动分配它的内存并在不需要时立即释放它。虽然仍可以这样做,但大多数OpenCV函数将自动分配其输出数据。如果您传递一个已经存在的Mat对象(该对象已经为矩阵分配了所需的空间),那么它将被重用。换句话说,我们在任何时候都只使用执行任务所需的内存。

Mat基本上是一个类,有两个数据部分:Mat头(包含矩阵大小、存储方法、矩阵存储地址等信息)和一个指向包含像素值矩阵的指针(采取多少维数 取决于选择的存储方法)。矩阵头的大小是恒定的,然而,矩阵本身的大小可能随着图像的不同而变化,通常会大上几个数量级。

OpenCV是一个图像处理库。它包含了大量的图像处理功能。为了解决计算难题,大多数时候您将使用库的多个函数。因此,将图像传递给函数是一种常见的做法。我们不应该忘记我们讨论的是图像处理算法,这些算法往往需要大量的计算。我们最不希望做的事情就是通过对可能很大的图像进行不必要的复制来进一步降低程序的速度。

为了解决这个问题,OpenCV使用了一个引用计数系统。其思想是每个Mat对象都有自己的矩阵头,但是当两个Mat对象之间共享一个矩阵时,可以通过让两个Mat对象的矩阵指针指向相同的地址。此外,复制操作符将只复制矩阵头和指向大矩阵的指针,而不是数据本身。

Mat A, C; // creates just the header partsA = imread(argv[1], IMREAD_COLOR); // here we'll know the method used (allocate matrix)Mat B(A); // Use the copy constructorC = A; // Assignment operator最后,上述所有对象都指向同一个数据矩阵,使用其中任何一个对象进行修改都会影响到所有其他对象。实际上,不同的对象只是为相同的底层数据提供了不同的访问方法;然而,它们的矩阵头部分是不同的。真正有趣的部分是,您可以创建只引用部分数据的矩阵头。例如,要在图像中创建感兴趣的区域(ROI),只需创建一个带有新边界的新标题:

Mat D (A, Rect(10, 10, 100, 100) ); // using a rectangleMat E = A(Range::all(), Range(1,3)); // using row and column boundaries现在你可能会问-如果矩阵本身可能属于多个Mat对象:当它不再被需要时,谁负责清理它。简而言之:是最后一个使用它的对象。这是通过使用引用计数机制来处理的。每当有人复制一个Mat对象的矩阵头时,就会为矩阵增加一个计数器。每当清除矩阵头时,此计数器就会减少。当计数器达到0时,矩阵被释放。

采用引用次数来释放存储内容是C++中常见的方式,用这种方式可以避免仍有某个变量引用数据时将这个数据删除造成程序崩溃的问题,同时极大的缩减了程序运行时所占用的内存。

但是,有时候还需要复制矩阵本身,所以OpenCV提供了 cv::Mat::clone() 和 cv::Mat::copyTo() 函数。

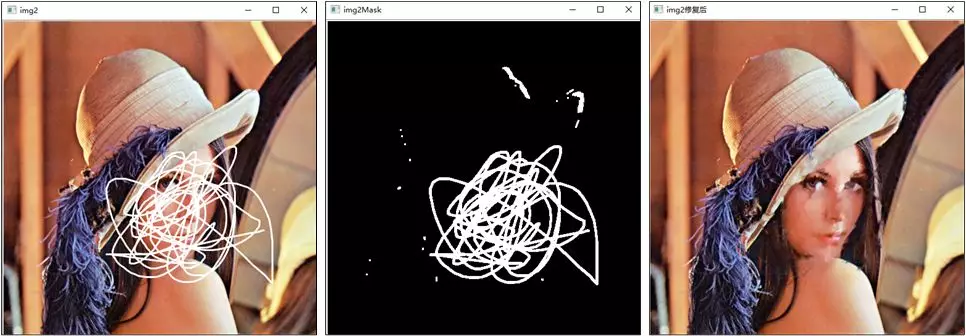

Mat F = A.clone();Mat G;A.copyTo(G);接下来我们来了解Mat类里可以存储的数据类型,根据官方给出的Mat类继承图,如图2-2所示,我们发现Mat类可以存储的数据类型包含double、float、uchar、unsigned char以及自定义的模板等。

我们可以通过代码清单2-2的方式声明一个存放指定类型的Mat类变量:

代码清单2-2 声明一个指定类型的Mat类cv::Mat A = Mat_<double>(3,3);//创建一个3*3的矩阵用于存放double类型数据由于OpenCV提出Mat类主要用于存储图像,而像素值的最大值又决定了图像的质量,如果用8位无符号整数去存储16位图像,会造成严重的图像颜色失真或造成数据错误。而由于不同位数的编译器对数据长度定义不同,为了避免在不同环境下因变量位数长度不同而造成程序执行问题,OpenCV根据数值变量存储位数长度定义了数据类型,表2-1中列出了OpenCV中的数据类型与取值范围。

仅有数据类型是不够的,还需要定义图像数据的通道(Channel)数,例如灰度图像数据是单通道数据,彩色图像数据是3通道或者4通道数据。因此针对这个情况,OpenCV还定义了通道数标识,C1、C2、C3、C4分别表示单通道、双通道、3通道和4通道。每一种数据类型都存在多个通道的情况,所以将数据类型与通道数表示结合便得到了OpenCV中对图像数据类型的完整定义,例如CV_8UC1表示的就是8位单通道数据,用于表示8位灰度图,而CV_8UC3表示的是8位3通道数据,用于表示8位彩色图。我们可以通过代码清单2-3的方式创建一个声明通道数和数据类型的Mat类:

代码清单2-3 通过OpenCV数据类型创建Mat类cv::Mat a(640,480,CV_8UC3) //创建一个640*480的3通道矩阵用于存放彩色图像cv::Mat a(3,3,CV_8UC1) //创建一个3*3的8位无符号整数的单通道矩阵cv::Mat a(3,3,CV_8U) //创建单通道矩阵C1标识可以省略虽然在64位编辑器里,uchar和CV_8U都表示8位无符号整数,但是两者有严格的定义,CV_8U只能用在Mat类内部的方法。例如用Mat_<CV_8U>(3,3)和Mat a(3,3,uchar)会提示创建错误。

现在修改F或G将不会影响A的Mat头指向的矩阵。你需要记住的是:

OpenCV函数的输出图像内存分配是自动的(除非另有指定)。您不需要考虑使用OpenCV的c++接口进行内存管理。赋值操作符和复制构造函数只复制Mat头。可以使用cv::Mat::clone()和cv::Mat::copyTo()函数复制图像的底层(数据)矩阵。存储方法

这是关于如何存储像素值的。您可以选择颜色空间和使用的数据类型。颜色空间指的是我们如何结合颜色组件来编码一个给定的颜色。最简单的一种是灰度,我们可以使用黑色和白色来制造灰度。这些组合使我们能够创建许多灰度级。

对于创建色彩的方式,我们有更多的方式可供选择。它们每一种都将其分解为三个或四个基本组件,我们可以使用这些组件的组合来创建其他组件。最流行的一种是RGB,主要是因为这也是我们的眼睛构建颜色的方式。它的基色是红、绿、蓝。为了编码一种颜色的透明度,有时会添加第四个元素:alpha (透明度)(A)。

然而, 不同颜色系统各有其优点:

RGB是最常见的,我们的眼睛使用类似的模式。但是请记住,OpenCV标准显示系统使用BGR颜色空间组成颜色(红色和蓝色通道互换位置)。HSV和HLS将颜色分解为色调、饱和度和亮度值组成部分,这是我们描述颜色更自然的方式。例如,您可能会忽略最后一个组件,使您的算法对输入图像的光线条件不太敏感。YCrCb被流行的JPEG图像格式所使用。CIE Lab*是一个感知上一致的颜色空间,如果你需要测量一种给定颜色到另一种颜色的距离,它很方便。每个构建组件都有自己的有效域。他们直接影响所使用的数据类型。存储组件的方式定义了我们对其域的控制。最小的数据类型可能是char,即一个字节或8位。它可以是无符号的(因此可以存储0到255的值)或有符号的(从-127到+127的值)。虽然在三个组件的情况下,这已经给出了1600万种可能的颜色来表示(像在RGB的情况下),但是,我们仍可以通过使用float(4字节= 32位)或double(8字节= 64位)数据类型为每个组件获得更精细的控制。不过,请记住,增加组件的大小也会增加内存中整个图片的大小。

显式创建一个Mat对象

但是,出于调试的目的,查看实际值要方便得多。您可以使用Mat的<<运算符来完成此操作。注意,这只适用于二维矩阵。

虽然Mat作为图像容器工作得很好,但它也是一个通用的矩阵类。因此,创建和操作多维矩阵是可能的。你可以用多种方式创建一个Mat对象:

- cv::Mat::Mat 构造函数

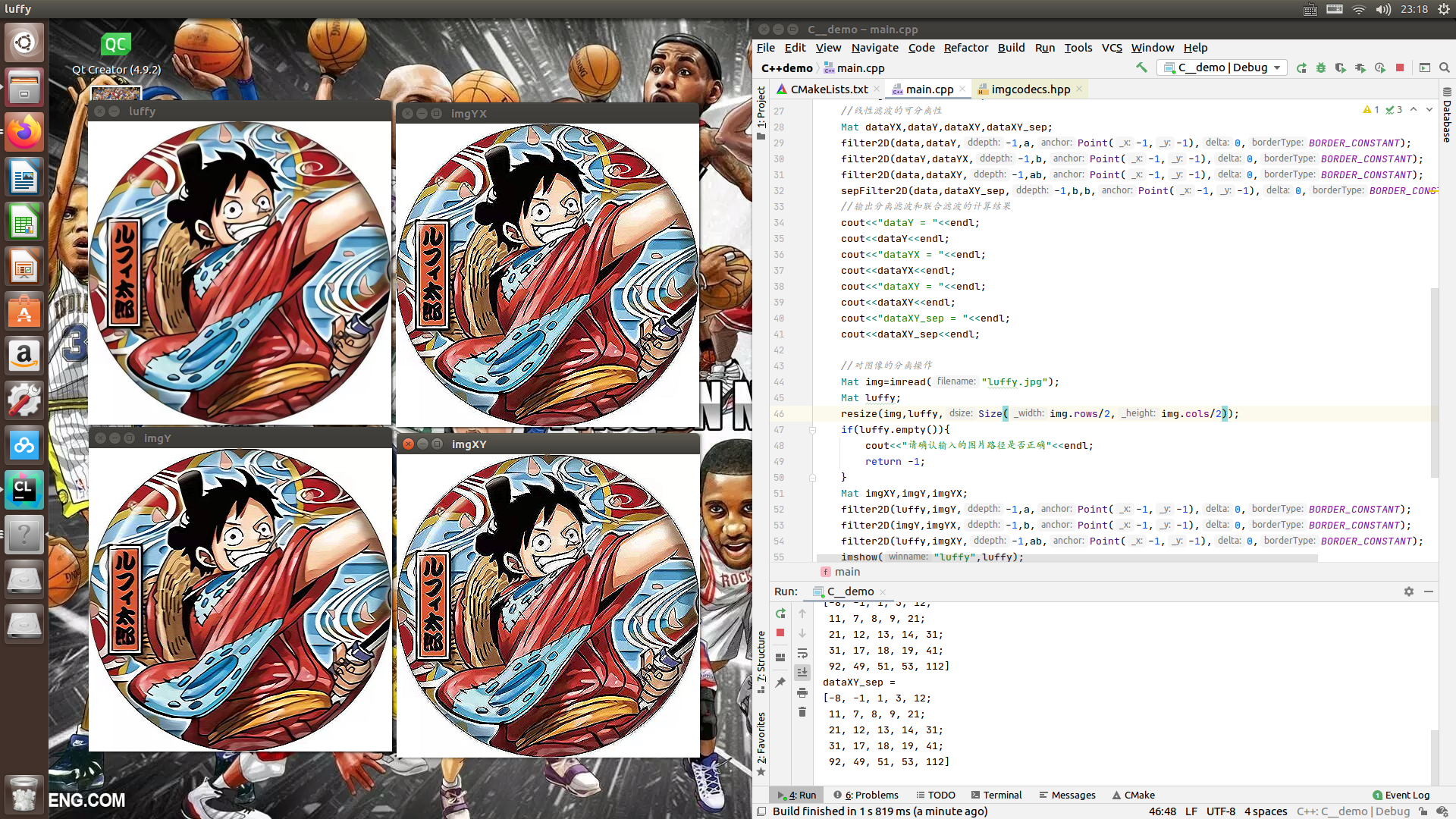

#include<iostream>//#include <stdio.h>#include <opencv2/opencv.hpp>#include "opencv/highgui.h"using namespace std;using namespace cv;int main(int argc,char** argv) { Mat M(2,2,CV_8UC3,Scalar(0,0,255)); cout<<"M = "<<endl; cout<<M<<endl; return 0;}结果:

M = [ 0, 0, 255, 0, 0, 255; 0, 0, 255, 0, 0, 255]对于二维和多通道图像,我们首先定义它们的大小,行和列计数。

然后,我们需要指定用于存储元素的数据类型和每个矩阵点的通道数量。为了做到这一点,我们根据下面的约定构造了多个定义:

CV_[The number of bits per item][Signed or Unsigned][Type Prefix]C[The channel number]CV_[单元素的bits数][Signed or Unsigned][数据类型前缀]C[通道数]例如,CV_8UC3意味着我们使用8位长的无符号char类型,每个像素有三个这样的类型来形成三个通道。为最多4个通道预定义了类型。cv::Scalar是四个元素的 short vector。指定它,您就可以用自定义值初始化所有矩阵点。如果需要更多,可以使用上面的宏创建类型,在括号中设置通道编号,如下所示。

- 使用C/ C++数组并通过构造函数进行初始化

int sz[3] = {2,2,2};Mat L(3,sz, CV_8UC(1), Scalar::all(0));上面的例子展示了如何创建一个二维以上的矩阵。指定其维度,然后传递一个包含每个维度大小的指针,剩下的保持不变。

- cv::Mat::create 函数

M.create(4,4, CV_8UC(2));cout << "M = "<< endl << " " << M << endl << endl;您不能用这种结构初始化矩阵值。它只会重新分配它的矩阵数据内存,如果新的大小不能适应旧的。

- MATLAB风格的初始化器:cv::Mat:: zero, cv::Mat:: ones,cv::Mat::eye。指定要使用的大小和数据类型:

Mat E = Mat::eye(4, 4, CV_64F);cout << "E = " << endl << " " << E << endl << endl;Mat O = Mat::ones(2, 2, CV_32F);cout << "O = " << endl << " " << O << endl << endl;Mat Z = Mat::zeros(3,3, CV_8UC1);cout << "Z = " << endl << " " << Z << endl << endl;结果:

E = [1, 0, 0, 0; 0, 1, 0, 0; 0, 0, 1, 0; 0, 0, 0, 1]O = [1, 1; 1, 1]Z = [ 0, 0, 0; 0, 0, 0; 0, 0, 0]- 对于小矩阵,你可以使用逗号分隔的初始化器或初始化器列表(最后一种情况需要c++ 11支持):

Mat C = (Mat_<double>(3,3) << 0, -1, 0, -1, 5, -1, 0, -1, 0);cout << "C = " << endl << " " << C << endl << endl;C = (Mat_<double>({0, -1, 0, -1, 5, -1, 0, -1, 0})).reshape(3);cout << "C = " << endl << " " << C << endl << endl;- 您可以使用cv::randu()函数用随机值填充一个矩阵。你需要为随机值给出一个下限和上限:

Mat R = Mat(3, 2, CV_8UC3);randu(R, Scalar::all(0), Scalar::all(255));C++版本OpenCv教程(二)Mat类构造与赋值

目录

Mat类的构造 1.利用默认构造函数2.根据输入矩阵尺寸和类型构造3.利用已有矩阵构造 Mat类的赋值 1.构造时赋值2.枚举赋值法3.循环赋值4.类方法赋值5.利用数组进行赋值Mat类的构造

1.利用默认构造函数

默认构造函数使用方式cv::Mat::Mat();通过代码清单2-4,利用默认构造函数构造了一个Mat类,这种构造方式不需要输入任何的参数,在后续给变量赋值的时候会自动判断矩阵的类型与大小,实现灵活的存储,常用于存储读取的图像数据和某个函数运算输出结果。

2.根据输入矩阵尺寸和类型构造

利用矩阵尺寸和类型参数构造Mat类cv::Mat::Mat( int rows,int cols,int type)这种构造方法我们前文也见过,通过输入矩阵的行、列以及存储数据类型实现构造。这种定义方式清晰、直观、易于阅读,常用在明确需要存储数据尺寸和数据类型的情况下,例如相机的内参矩阵、物体的旋转矩阵等。利用输入矩阵尺寸和数据类型构造Mat类的方法存在一种变形,通过将行和列组成一个Size()结构进行赋值,代码清单2-6中给出了这种构造方法的原型。

用Size()结构构造Mat类cv::Mat::Mat(Size size(),int type)利用这种方式构造Mat类时要格外注意,在Size()结构里矩阵的行和列的顺序与代码清单2-5中的方法相反,使用Size()时,列在前、行在后。如果不注意同样会构造成功Mat类,但是当我们需要查看某个元素时,我们并不知道行与列颠倒,就会出现数组越界的错误。使用该种方法构造函数如下:

用Size()结构构造Mat示例cv::Mat a(Size(480, 640), CV_8UC1); //构造一个行为640,列为480的单通道矩阵cv::Mat b(Size(480, 640), CV_32FC3); //构造一个行为640,列为480的3通道矩3.利用已有矩阵构造

利用已有矩阵构造Mat类cv::Mat::Mat( const Mat & m);m:已经构建完成的Mat类矩阵数据。这种构造方式非常简单,可以构造出与已有的Mat类变量存储内容一样的变量。注意这种构造方式只是复制了Mat类的矩阵头,矩阵指针指向的是同一个地址,因此如果通过某一个Mat类变量修改了矩阵中的数据,另一个变量中的数据也会发生改变。

【注】如果想复制两个一模一样的Mat类而彼此之间不会受影响,可以使用m=a.clone()实现。

如果需要构造的矩阵尺寸比已有矩阵小,并且存储的是已有矩阵的子内容,那么可以用代码清单2-9中的方法进行构建:

构造已有Mat类的子类

cv::Mat::Mat(const Mat & m, const Range & rowRange,const Range & colRange = Range::all())这种方式主要用于在原图中截图使用,不过需要注意的是,通过这种方式构造的Mat类与已有Mat类享有共同的数据,即如果两个Mat类中有一个数据发生更改,另一个也会随之更改。

构造已有Mat类的子类

cv::Mat::Mat(const Mat & m,const Range & rowRange, const Range & colRange = Range::all())Mat类的赋值

构建完成Mat类后,变量里并没有数据,需要将数据赋值给它。针对不同情况,OpenCV 4.1提供了多种赋值方式,接下来将介绍如何给Mat类变量进行赋值。

1.构造时赋值

在构造时赋值的方法

cv::Mat::Mat(int rows,int cols,int type,const Scalar & s)该种方式是在构造的同时进行赋值,将每个元素想要赋予的值放入Scalar结构中即可,这里需要注意的是,用此方法会将图像中的每个元素赋值相同的数值,例如Scalar(0, 0, 255)会将每个像素的三个通道值分别赋值0,0,255。我们可以使用如下的形式构造一个已赋值的Mat类

在构造时赋值示例cv::Mat a(2, 2, CV_8UC3, cv::Scalar(0,0,255));//创建一个3通道矩阵,每个像素都是0,0,255cv::Mat b(2, 2, CV_8UC2, cv::Scalar(0,255));//创建一个2通道矩阵,每个像素都是0,255cv::Mat c(2, 2, CV_8UC1, cv::Scalar(255)); //创建一个单通道矩阵,每个像素都是255我们在程序return语句之前加上断点进行调试,用Image Watch查看每一个Mat类变量里的数据,结果如图2-3所示,证明我们已成功构造矩阵并赋值。

Scalar结构中变量的个数一定要与定义中的通道数相对应,如果Scalar结构中变量个数大于通道数,则位置大于通道数之后的数值将不会被读取,例如执行a(2, 2, CV_8UC2, Scalar(0,0,255))后,每个像素值都将是(0,0),而255不会被读取。如果Scalar结构中变量数小于通道数,则会以0补充。

2.枚举赋值法

这种赋值方式是将矩阵中所有的元素都一一枚举出,并用数据流的形式赋值给Mat类。具体赋值形式如代码清单2-13所示。

利用枚举法赋值示例cv::Mat a = (cv::Mat_<int>(3, 3) << 1, 2, 3, 4, 5, 6, 7, 8, 9);cv::Mat b = (cv::Mat_<double>(2, 3) << 1.0, 2.1, 3.2, 4.0, 5.1, 6.2);上面第一行代码创建了一个3×3的矩阵,矩阵中存放的是从1-9的九个整数,先将矩阵中的第一行存满,之后再存入第二行、第三行,即1、2、3存放在矩阵a的第一行,4、5、6存放在矩阵a的第二行,7,8,9存放在矩阵a的第三行。第二行代码创建了一个2×3的矩阵,其存放方式与矩阵a相同。

采用枚举法时,输入的数据个数一定要与矩阵元素个数相同,例如代码清单2-13中第一行代码只输入从1到8八个数,赋值过程会出现报错,因此本方法常用在矩阵数据比较少的情况。

3.循环赋值

与通过枚举法赋值方法相类似,循环法赋值也是对矩阵中的每一位元素进行赋值,但是可以不在声明变量的时候进行赋值,而且可以对矩阵中的任意部分进行赋值。具体赋值形式如代码清单2-14所示。

利用枚举法赋值示例cv::Mat c = cv::Mat_<int>(3, 3); //定义一个3*3的矩阵for (int i = 0; i < c.rows; i++) //矩阵行数循环{for (int j = 0; j < c.cols; j++) //矩阵列数循环{c.at<int>(i, j) = i+j;}}上面代码同样创建了一个3×3的矩阵,通过for循环的方式,对矩阵中的每一位元素进行赋值。需要注意的是,在给矩阵每个元素进行赋值的时候,赋值函数中声明的变量类型要与矩阵定义时的变量类型相同,即上面代码中第1行和第6行中变量类型要相同,如果第6行代码改成c.at(i, j) ,程序就会报错,无法赋值。

4.类方法赋值

在Mat类里提供了可以快速赋值的方法,可以初始化指定的矩阵。例如生成单位矩阵、对角矩阵、所有元素都为0或者1的矩阵等。

利用类方法赋值示例cv::Mat a = cv::Mat::eye(3, 3, CV_8UC1);cv::Mat b = (cv::Mat_<int>(1, 3) << 1, 2, 3);cv::Mat c = cv::Mat::diag(b);cv::Mat d = cv::Mat::ones(3, 3, CV_8UC1);cv::Mat e = cv::Mat::zeros(4, 2, CV_8UC3);上面代码中,每个函数作用及参数含义分别如下:

eye():构建一个单位矩阵,前两个参数为矩阵的行数和列数,第三个参数为矩阵存放的数据类型与通道数。如果行和列不相等,则在矩阵的 (1,1),(2,2),(3,3)等主对角位置处为1。diag():构建对角矩阵,其参数必须是Mat类型的1维变量,用来存放对角元素的数值。ones():构建一个全为1的矩阵,参数含义与eye()相同。zeros():构建一个全为0的矩阵,参数含义与eye()相同。5.利用数组进行赋值

这种方法与枚举法相类似,但是该方法可以根据需求改变Mat类矩阵的通道数,可以看作枚举法的拓展,在代码清单2-16中给出了这种方法的赋值形式。

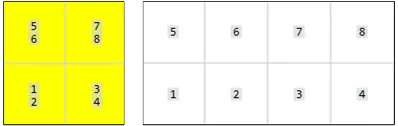

利用数组赋值示例float a[8] = { 5,6,7,8,1,2,3,4 };cv::Mat b = cv::Mat(2, 2, CV_32FC2, a);cv::Mat c = cv::Mat(2, 4, CV_32FC1, a);这种赋值方式首先将需要存入到Mat类中的变量存入到一个数组中,之后通过设置Mat类矩阵的尺寸和通道数将数组变量拆分成矩阵,这种拆分方式可以自由定义矩阵的通道数,当矩阵中的元素数目大于数组中的数据时,将用-1.0737418e+08填充赋值给矩阵,如果矩阵中元素的数目小于数组中的数据时,将矩阵赋值完成后,数组中剩余数据将不再赋值。由数组赋值给矩阵的过程是首先将矩阵中第一个元素的所有通道依次赋值,之后再赋值下一个元素,为了更好的体会这个过程,我们将定义的b和c矩阵在图2-4中给出。

C++版本OpenCv教程(三)Mat类支持的运算

Excerpt

在处理数据时需要对数据进行加减乘除运算,例如对图像进行滤波、增强等操作都需要对像素级别进行加减乘除运算。为了方便运算,Mat类变量支持矩阵的加减乘除运算,即我们在使用Mat类变量时,将其看做普通的矩阵即可,例如Mat类变量与常数相乘遵循矩阵与常数相乘的运算法则。Mat类与常数运算时,可以直接通过加减乘除符号实现。Mat类的加减法运算cv::Mat a = (cv::Mat_(3, 3) << 1, 2, 3, 4, 5, 6, 7, 8, 9);cv::Mat b =

在处理数据时需要对数据进行加减乘除运算,例如对图像进行滤波、增强等操作都需要对像素级别进行加减乘除运算。为了方便运算,Mat类变量支持矩阵的加减乘除运算,即我们在使用Mat类变量时,将其看做普通的矩阵即可,例如Mat类变量与常数相乘遵循矩阵与常数相乘的运算法则。Mat类与常数运算时,可以直接通过加减乘除符号实现。

Mat类的加减法运算cv::Mat a = (cv::Mat_<int>(3, 3) << 1, 2, 3, 4, 5, 6, 7, 8, 9);cv::Mat b = (cv::Mat_<int>(3, 3) << 1, 2, 3, 4, 5, 6, 7, 8, 9);cv::Mat c = (cv::Mat_<double>(3, 3) << 1.0, 2.1, 3.2, 4.0, 5.1, 6.2, 2, 2, 2);cv::Mat d = (cv::Mat_<double>(3, 3) << 1.0, 2.1, 3.2, 4.0, 5.1, 6.2, 2, 2, 2);cv::Mat e, f, g, h, i;e = a + b;f = c - d;g = 2 * d;h = d / 2.0;i = a – 1;结果:

a = [1, 2, 3; 4, 5, 6; 7, 8, 9]b = [1, 2, 3; 4, 5, 6; 7, 8, 9]c = [1, 2.1, 3.2; 4.3, 5.4, 6.5; 7.6, 8.699999999999999, 9.800000000000001]d = [1, 2.1, 3.2; 4.3, 5.4, 6.5; 7.6, 8.699999999999999, 9.800000000000001]e = [2, 4, 6; 8, 10, 12; 14, 16, 18]f = [0, 0, 0; 0, 0, 0; 0, 0, 0]g = [2, 4.2, 6.4; 8.6, 10.8, 13; 15.2, 17.4, 19.6]h = [0.5, 1.05, 1.6; 2.15, 2.7, 3.25; 3.8, 4.35, 4.9]i = [0, 1, 2; 3, 4, 5; 6, 7, 8]这里需要注意的是,当两个Mat类变量加减运算时,必须保证两个矩阵中的数据类型是相同的,即两个分别保存int和double数据类型的Mat类变量不能进行加减运算。与常规的乘除法不同之处在于,常数与Mat类变量运算结果的数据类型保留Mat类变量的数据类型,例如,double类型的常数与int类型的Mat类运算,最后结果仍然为int类型。

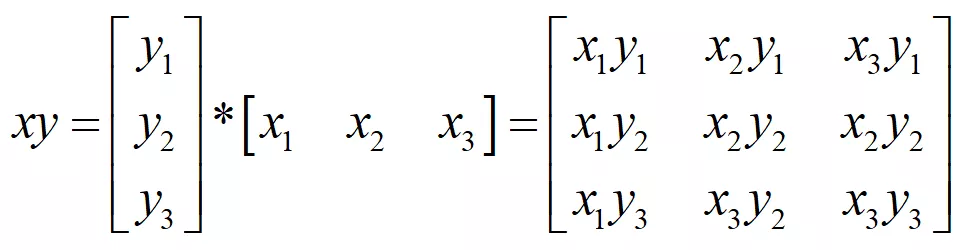

在对图像进行卷积运算的时候,需要两个矩阵进行乘法运算,opencv不仅提供了两个Mat类矩阵的乘法运算,而且定义了两个矩阵的内积和对应位的乘法运算。

两个Mat类矩阵的乘法运算cv::Mat j, m;double k;j = c*d;k = a.dot(b);m = a.mul(b);运行结果:

j = [34.35, 41.28, 48.21000000000001; 76.92, 94.73999999999999, 112.56; 119.49, 148.2, 176.91]k = 285m = [1, 4, 9; 16, 25, 36; 49, 64, 81]在上面的代码中定义了两个Mat类变量和一个double变量,分别实现了两个Mat类矩阵的乘法、内积和对应位乘法。第三行代码中的“”运算符表示两个矩阵的数学乘积,例如存在两个矩阵A3×3和B3×3,“”运算结果为C3×3,C3×3中的每一个元素表示为:

cij=ai1b1j+ai2b2j+ai3b3j,需要注意的是。“*”运算要求第一个Mat类矩阵的列数必须与第二个Mat类矩阵的行数相同,而且该运算要求Mat类中的数据类型必须是CV_32FC1、CV_64FC1、CV_32FC2、CV_64FC2这四种的一种,也就是对于一个二维的Mat类矩阵,其保存的数据类型必须是float类型或者double类型。

关于Mat类矩阵的dot运算和mul运算可以参照下面的链接:

Opencv中Mat矩阵相乘——点乘、dot、mul运算详解

【注】Mat类矩阵的dot运算是把两个矩阵每一位上对应的数相乘然后相加返回一个double类型的数值。

Mat类矩阵的mul运算是把两个矩阵每一位上对应的数相乘返回一个Mat类型的矩阵。

需要注意的是,不同于前两种乘法运算,参与mul()方法运算的两个Mat类矩阵中保存的数据在保证相同的前提下,可以使任何一种类型,并且默认的输出数据类型与两个Mat类矩阵保持一致。在图像处理领域,常用的数据类型是CV_8U,其数据范围是0-255,当两个比较大的整数相乘时就会产生结果溢出的现象,输出结果为255,因此在使用mul()方法时需要防止数据溢出的现象。

C++版本OpenCv教程(四)4种读取Mat类元素的的方法

Excerpt

目录通过at方法读取Mat类矩阵中的元素通过指针ptr读取Mat类矩阵中的元素通过迭代器访问Mat类矩阵中的元素通过矩阵元素地址定位方式访问元素对于Mat类矩阵的读取与更改,我们已经在矩阵的循环赋值中见过如何用at方法对矩阵的每一位进行赋值,这只是OpenCV提供的多种读取矩阵元素方式中的一种,本小节将详细介绍如何读取Mat类矩阵中的元素,并对其数值进行修改。在学习如何读取Mat类矩阵元素之前,首先需要知道Mat类变量在计算机中是如何存储的。多通道的Mat类矩阵是一个类似于三维的数据,而计算机的存储空间是

目录

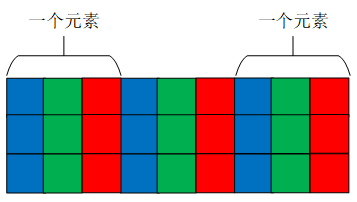

通过at方法读取Mat类矩阵中的元素通过指针ptr读取Mat类矩阵中的元素通过迭代器访问Mat类矩阵中的元素通过矩阵元素地址定位方式访问元素对于Mat类矩阵的读取与更改,我们已经在矩阵的循环赋值中见过如何用at方法对矩阵的每一位进行赋值,这只是OpenCV提供的多种读取矩阵元素方式中的一种,本小节将详细介绍如何读取Mat类矩阵中的元素,并对其数值进行修改。在学习如何读取Mat类矩阵元素之前,首先需要知道Mat类变量在计算机中是如何存储的。多通道的Mat类矩阵是一个类似于三维的数据,而计算机的存储空间是一个二维空间,因此Mat类矩阵在计算机存储时是将三维数据变成二维数据,先存储第一个元素每个通道的数据,之后再存储第二个元素每个通道的数据。每一行的元素都按照这种方式进行存储,因此如果我们找到了每个元素的起始位置,便可以找到这个元素中每个通道的数据。图2-5展示了一个三通道的矩阵的存储方式,其中连续的蓝色、绿色和红色的方块分别代表每个元素的三个通道。

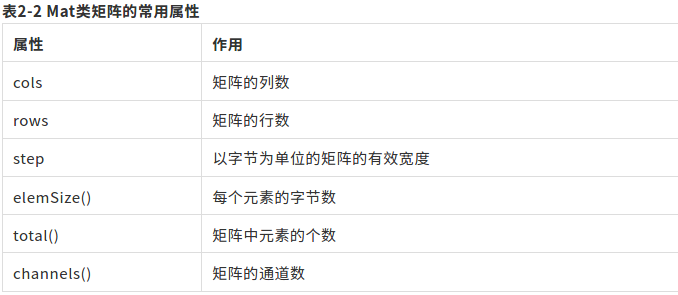

了解了Mat类变量的存储方式之后,我们来看一下Mat类具有的属性,我们在表2-2中列出了常用的属性,同时详细的介绍了每种属性的作用。

这些属性之间互相组合可以得到多数Mat类矩阵的属性,例如step属性与cols属性组合,可以求出每个元素所占据的字节数,而再与channels()属性结合,就可以知道每个通道的字节数,进而知道矩阵中存储的数据量的类型。接下来通过一个例子来具体说明每个属性的用处,用Mat (3, 4, CV_32FC3)定义一个矩阵,这时通道数channels()为3;列数cols为4;行数rows为3;矩阵中元素的个数为3_4,结果为12;每个元素的字节数为32/8_channels(),最后结果为12;以字节为单位的有效长度step为eleSize()*cols,结果为48。

常用的Mat类矩阵的元素读取方式有:通过at方法进行读取、通过指针ptr进行读取、通过迭代器进行读取、通过矩阵元素的地址定位方式进行读取。接下来将详细的介绍这四种读取方式。

通过at方法读取Mat类矩阵中的元素

通过at方法读取矩阵元素分为针对单通道的读取方法和针对多通道的读取方法,在代码清单2-19中给出了通过at方法读取单通道矩阵元素的代码。

at方法读取Mat类单通道矩阵元素Mat a = (Mat_<uchar>(3, 3) << 1, 2, 3, 4, 5, 6, 7, 8, 9);int value = (int)a.at<uchar>(0, 0);cout<<"value = "<<value<<endl;运行结果:

value = 1通过at方法读取元素需要在后面跟上“<数据类型>”,如果此处的数据类型与矩阵定义时的数据类型不相同,就会出现因数据类型不匹配的报错信息。该方法以坐标的形式给出需要读取的元素坐标(行数,列数)。需要说明的是,如果矩阵定义的是uchar类型的数据,在需要输入数据的时候,需要强制转换成int类型的数据进行输出,否则输出的结果并不是整数。

由于单通道图像是一个二维矩阵,因此在at方法的最后给出二维平面坐标即可访问对应位置元素。而多通道矩阵每一个元素坐标处都是多个数据,因此引入一个变量用于表示同一元素多个数据。在openCV 中,针对3通道矩阵,定义了cv::Vec3b、cv::Vec3s、cv::Vec3w、cv::Vec3d、cv::Vec3f、cv::Vec3i六种类型用于表示同一个元素的三个通道数据。通过这六种数据类型可以总结出其命名规则,其中的数字表示通道的个数,最后一位是数据类型的缩写,b是uchar类型的缩写、s是short类型的缩写、w是ushort类型的缩写、d是double类型的缩写、f是float类型的缩写、i是int类型的缩写。当然OpenCV也为2通道和4通道定义了对应的变量类型,其命名方式也遵循这个命名规则,例如2通道和4通道的uchar类型分别用cv::Vec2b和cv::Vec4b表示。代码清单2-20中给出了通过at方法读取多通道矩阵的实现代码。

Mat b(3, 4, CV_8UC3, cv::Scalar(0, 0, 1));Vec3b vc3 = b.at<Vec3b>(0, 0);int first = (int)vc3.val[0];int second = (int)vc3.val[1];int third = (int)vc3.val[2];cout<<"b = "<<endl<<b<<endl;cout<<"first = "<<first<<endl;cout<<"second = "<<second<<endl;cout<<"third = "<<third<<endl;运行结果:

b = [ 0, 0, 1, 0, 0, 1, 0, 0, 1, 0, 0, 1; 0, 0, 1, 0, 0, 1, 0, 0, 1, 0, 0, 1; 0, 0, 1, 0, 0, 1, 0, 0, 1, 0, 0, 1]first = 0second = 0third = 1在使用多通道变量类型时,同样需要注意at方法中数据变量类型与矩阵的数据变量类型相对应,并且cv::Vec3b类型在输入每个通道数据时需要将其变量类型强制转成int类型。不过,如果直接将at方法读取出的数据直接赋值给cv::Vec3i类型变量,就不需要在输出每个通道数据时进行数据类型的强制转换。

通过指针ptr读取Mat类矩阵中的元素

前面我们分析过Mat类矩阵在内存中的存放方式,矩阵中每一行中的每个元素都是挨着存放,如果找到每一行元素的起始地址位置,那么读取矩阵中每一行不同位置的元素就是将指针在起始位置向后移动若干位即可。在代码清单2-21中给出了通过指针ptr读取Mat类矩阵元素的代码实现。

Mat b(3,4,CV_8UC3,Scalar(0,0,1));for(int i=0;i<b.rows;++i){ uchar *ptr=b.ptr<uchar>(i); for(int j=0;j<b.cols*b.channels();++j){ cout<<(int)ptr[j]<<" "; } cout<<endl;}运行结果:

0 0 1 0 0 1 0 0 1 0 0 1 0 0 1 0 0 1 0 0 1 0 0 1 0 0 1 0 0 1 0 0 1 0 0 1 在程序里,首先有一个大循环用来控制矩阵中每一行,之后定义一个uchar类型的指针ptr,在定义时需要声明Mat类矩阵的变量类型,并在定义最后用小括号声明指针指向的Mat类矩阵的哪一行。第二个循环控制用于输出矩阵中每一行所有通道的数据。根据图2-5中所示的存储形式,每一行中存储的数据数量为列数与通道数的乘积,即指针可以向后移动cols*channels()-1位,如第7行代码所示,指针向后移动的位数在中括号给出。程序中给出了循环遍历Mat类矩阵中的每一个数据的方法,当我们能够确定需要访问的数据时,可以直接通过给出行数和指针后移的位数进行访问,例如当读取第2行数据中第3个数据时,可以用a.ptr(1)[2]这样的形式来直接访问。

通过迭代器访问Mat类矩阵中的元素

Mat类变量同时也是一个容器变量,所以Mat类变量拥有迭代器,用于访问Mat类变量中的数据,通过迭代器可以实现对矩阵中每一个元素的遍历,

指针ptr读取Mat类矩阵元素cv::MatIterator_<uchar> it = a.begin<uchar>();cv::MatIterator_<uchar> it_end = a.end<uchar>();for (int i = 0; it != it_end; it++){cout << (int)(*it) << " ";if ((++i% a.cols) == 0){cout << endl;}}Mat类的迭代器变量类型是cv::MatIterator_< >,在定义时同样需要在括号中声明数据的变量类型。Mat类迭代器的起始是Mat.begin< >(),结束是Mat.end< >(),与其他迭代器用法相同,通过“++”运算实现指针位置向下迭代,数据的读取方式是先读取第一个元素的每一个通道,之后再读取第二个元素的每一个通道,直到最后一个元素的最后一个通道。

通过矩阵元素地址定位方式访问元素

前面三种读取元素的方式都需要知道Mat类矩阵存储数据的类型,而且在从认知上,我们更希望能够通过声明“第x行第x列第x通道”的方式来读取某个通道内的数据,代码清单2-23中给出的就是这种读取数据的方式。

代码清单2-23 通过矩阵元素地址定位方式访问元素

(int)(*(b.data + b.step[0] * row + b.step[1] * col + channel));代码中row变量的含义是某个数据所在元素的行数,col变量的含义是某个数据所在元素的列数,channel变量的含义是某个数据所在元素的通道数。这种方式与我们通过指针读取数据的形式类似,都是通过将首个数据的地址指针移动若干位后指向需要读取的数据,只不过这种方式可以通过直接给出行、列和通道数进行读取,不需要用户再进行计算某个数据在这行数据存储空间中的位置。

C++版本OpenCv教程(五)图像读取函数imread

Excerpt

我们在前面已经见过了图像读取函数imread()的调用方式,这里我们给出函数的原型。cv::Mat cv::imread(const String & filename,int flags=IMREAD_COLOR)filename:需要读取图像的文件名称,包含图像地址、名称和图像文件扩展名flags:读取图像形式的标志,如将彩色图像按照灰度图读取,默认参数是按照彩色图像格式读取,可选参数在表2-3给出。函数用于读取指定的图像并将其返回给一个Mat类变量,如果图像文件不存在、破损或者

我们在前面已经见过了图像读取函数imread()的调用方式,这里我们给出函数的原型。

cv::Mat cv::imread(const String & filename,int flags=IMREAD_COLOR)函数用于读取指定的图像并将其返回给一个Mat类变量,如果图像文件不存在、破损或者格式不受支持时,则无法读取图像,此时函数返回一个空矩阵,因此可以通过判断返回矩阵的data属性是否为空或者empty()函数是否为真来判断是否成功读取图像,如果读取图像失败,data属性返回值为0,empty()函数返回值为1。函数能够读取多种格式的图像文件,但是在不同操作系统由于使用的编解码器不同,因此在某个系统中能够读取的图像文件可能在其他系统中就无法读取。无论在哪个系统中,bmp文件和dib文件都是始终可以读取的,在Windows和Mac系统中,默认情况下使用OpenCV自带的编解码器(libjpeg,libpng,libtiff和libjasper),因此可以读取JPEG(jpg、jpeg、jpe),PNG,TIFF(tiff、tif)文件,在Linux系统中需要自行安装这些编解码器,安装后同样可以读取这些类型的文件。不过需要说明的是,该函数能否读取文件数据与扩展名无关,而是通过文件的内容确定图像的类型,例如将一个扩展名由png修改成exe时,该函数一样可以读取该图像,但是将扩展名exe改成png,该函数不能加载该文件。

该函数第一个参数以字符串形式给出待读取图像的地址,第二个函数是设置读取图像的形式,默认的参数是以彩色图的形式读取,针对不同需求可以更改参数,在OpenCV 4.1中给出了13种模式读取图像的形式,总结起来分别是以原样式读取、灰度图读取、彩色图读取、多位数读取、在读取时将图像缩小一定尺寸等形式读取,具体可选择的参数及作用在表2-3种给出,这里需要指出的是,将彩色图像转成灰度图通过编解码器内部转换,可能会与OpenCV程序中将彩色图像转成灰度图的结果存在差异。这些标志参数在功能不冲突的前提下可以同时声明多个,不同参数之间用“|”隔开。

C++版本OpenCv教程(六)namedWindow函数&imshow函数的使用

Excerpt

目录图像窗口函数namedWindow图像显示函数imshow图像窗口函数namedWindow在我们之前的程序中并没有见到窗口函数,因为我们在显示图像时如果没有主动定义图像窗口,程序会自动生成一个窗口用于显示图像,然而有时我们需要在显示图像之前对图像窗口进行操作,例如添加滑动条,此时就需要提前创建图像窗口。创建窗口函数的原型。void cv::namedWindow(const String & winname,int flags = WINDOW_AUTOSIZE)winname:

目录

图像窗口函数namedWindow图像显示函数imshow图像窗口函数namedWindow

在我们之前的程序中并没有见到窗口函数,因为我们在显示图像时如果没有主动定义图像窗口,程序会自动生成一个窗口用于显示图像,然而有时我们需要在显示图像之前对图像窗口进行操作,例如添加滑动条,此时就需要提前创建图像窗口。创建窗口函数的原型。

void cv::namedWindow(const String & winname,int flags = WINDOW_AUTOSIZE)该函数会创建一个窗口变量,用于显示图像和滑动条,通过窗口的名称引用该窗口,如果在创建窗口时已经存在具有相同名称的窗口,则该函数不会执行任何操作。创建一个窗口需要占用部分内存资源,因此通过该函数创建窗口后,在不需要窗口时需要关闭窗口来释放内存资源。OpenCV提供了两个关闭窗口资源的函数,分别是cv::destroyWindow()函数和cv :: destroyAllWindows(),通过名称我们可以知道前一个函数是用于关闭一个指定名称的窗口,即在括号内输入窗口名称的字符串即可将对应窗口关闭,后一个函数是关闭程序中所有的窗口,一般用于程序的最后。不过事实上,在一个简单的程序里,我们并不需要调用这些函数,因为程序退出时会自动关闭应用程序的所有资源和窗口。虽然不主动释放窗口也会在程序结束时释放窗口资源,但是OpenCV 4.0版本在结束时会报出没有释放窗口的错误,而OpenCV 4.1版本则不会报错。

该函数的第一个参数是声明窗口的名称,用于窗口的唯一识别,第二个参数是声明窗口的属性,主要用于设置窗口的大小是否可调、显示的图像是否填充满窗口等,具体可选择的参数及含义在表2-4中给出,默认情况下,函数加载的标志参数为“WINDOW_AUTOSIZE | WINDOW_KEEPRATIO | WINDOW_GUI_EXPANDED”。

图像显示函数imshow

我们在前面已经见过了图像显示函数imshow()的调用方式,这里我们给出函数的原型。

void cv::imshow(const String & winname,InputArray mat)该函数会在指定的窗口中显示图像,如果在此函数之前没有创建同名的图像窗口,就会以WINDOW_AUTOSIZE标志创建一个窗口,显示图像的原始大小,如果创建了图像窗口,则会缩放图像以适应窗口属性。该函数会根据图像的深度将其缩放,具体缩放规则为:

如果图像是8位无符号类型,则按照原样显示如果图像是16位无符号类型或者32位整数类型,则会将像素除以256,将范围由[0,255*256]映射到[0,255]如果图像时32位或64位浮点类型,则将像素乘以255,即将范围由[0,1]映射到[0,255]函数中第一个参数为图像显示窗口的名称,第二个参数是需要显示的图像Mat类矩阵。这里需要特殊说明的是,我们看到第二个参数并不是常见的Mat类,而是InputArray,这个是OpenCV定义的一个类型声明引用,用作输入参数的标识,我们在遇到它时可以认为是需要输入一个Mat类数据。同样,OpenCV对输出也定义了OutputArray类型,我们同样可以认为是输出一个Mat类数据。

注意 此函数运行后会继续执行后面程序,如果后面程序执行完直接退出的话,那么显示的图像有可能闪一下就消失了,因此在需要显示图像的程序中,往往会在imshow()函数后跟有cv::waitKey()函数,用于将程序暂停一段时间。waitKey()函数是以毫秒计的等待时长,如果参数缺省或者为“0”表示等待用户按键结束该函数。

C++版本OpenCv教程(七)视频数据的读取&摄像头的直接调用

Excerpt

目录视频数据的读取摄像头的直接调用视频数据的读取虽然视频文件是由多张图片组成的,但是imread()函数并不能直接读取视频文件,需要由专门的视频读取函数进行视频读取,并将每一帧图像保存到Mat类矩阵中,下面的代码中给出了VideoCapture类在读取视频文件时的构造方式。cv :: VideoCapture :: VideoCapture(); //默认构造函数cv :: VideoCapture :: VideoCapture(const String& filename,int api

视频数据的读取

虽然视频文件是由多张图片组成的,但是imread()函数并不能直接读取视频文件,需要由专门的视频读取函数进行视频读取,并将每一帧图像保存到Mat类矩阵中,下面的代码中给出了VideoCapture类在读取视频文件时的构造方式。

cv :: VideoCapture :: VideoCapture(); //默认构造函数cv :: VideoCapture :: VideoCapture(const String& filename,int apiPreference =CAP_ANY)该函数是构造一个能够读取与处理视频文件的视频流,在代码清单2-27中的第一行是VideoCapture类的默认构造函数,只是声明了一个能够读取视频数据的类,具体读取什么视频文件,需要在使用时通过open()函数指出,例如cap.open(“1.avi”)是VideoCapture类变量cap读取1.avi视频文件。

第二种构造函数在给出声明变量的同时也将视频数据赋值给变量。可以读取的文件种类包括视频文件(例如video.avi)、图像序列或者视频流的URL。其中读取图像序列需要将多个图像的名称统一为“前缀+数字”的形式,通过“前缀+%02d”的形式调用,例如在某个文件夹中有图片img_00.jpg、img_01.jpg、img_02.jpg……加载时文件名用img_%02d.jpg表示。函数中的读取视频设置属性标签默认的是自动搜索合适的标志,所以在平时使用中,可以将其缺省,只需要输入视频名称即可。与imread()函数一样,构造函数同样有可能读取文件失败,因此需要通过isOpened()函数进行判断,如果读取成功则返回值为true,如果读取失败,则返回值为false。

通过构造函数只是将视频文件加载到了VideoCapture类变量中,当我们需要使用视频中的图像时,还需要将图像由VideoCapture类变量里导出到Mat类变量里,用于后期数据处理,该操作可以通过“>>”运算符将图像按照视频顺序由VideoCapture类变量复制给Mat类变量。当VideoCapture类变量中所有的图像都赋值给Mat类变量后,再次赋值的时候Mat类变量会变为空矩阵,因此可以通过empty()判断VideoCapture类变量中是否所有图像都已经读取完毕。

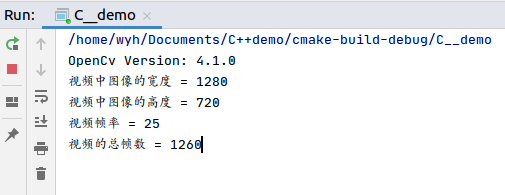

VideoCapture类变量同时提供了可以查看视频属性的get()函数,通过输入指定的标志来获取视频属性,例如视频的像素尺寸、帧数、帧率等,常用标志和含义在表2-5中给出。

#include<iostream>//#include <stdio.h>#include <opencv2/opencv.hpp>#include "opencv/highgui.h"using namespace std;using namespace cv;int main(int argc,char** argv) { cout<<"OpenCv Version: "<<CV_VERSION<<endl; VideoCapture video("/home/wyh/Documents/C++demo/project_video.mp4"); if(video.isOpened()){ cout<<"视频中图像的宽度 = "<<video.get(CAP_PROP_FRAME_WIDTH)<<endl; cout<<"视频中图像的高度 = "<<video.get(CAP_PROP_FRAME_HEIGHT)<<endl; cout<<"视频帧率 = "<<video.get(CAP_PROP_FPS)<<endl; cout<<"视频的总帧数 = "<<video.get(CAP_PROP_FRAME_COUNT)<<endl; } else{ cout<<"请确认视频文件名称是否正确"<<endl; return -1; } while(1){ Mat frame; video>>frame; if(frame.empty()){ break;; } imshow("video",frame); waitKey(1000/video.get(CAP_PROP_FPS)); } waitKey(); return 0;}

摄像头的直接调用

VideoCapture类还可以调用摄像头,构造方式如代码清单2-29中所示。

cv :: VideoCapture :: VideoCapture(int index,int apiPreference = CAP_ANY)调用摄像头与读取视频文件相比,只有第一个参数不同。调用摄像头时,第一个参数为要打开的摄像头设备的ID,ID的命名方式从0开始。从摄像头中读取图像数据的方式与从视频中读取图像数据的方式相同,通过“>>”符号读取当前时刻相机拍摄到的图像。并且读取视频时VideoCapture类具有的属性同样可以使用。

C++版本OpenCv教程(八)图像的保存&视频的保存

Excerpt

目录图像的保存视频的保存图像的保存OpenCV提供imwrite()函数用于将Mat类矩阵保存成图像文件,该函数的函数原型在代码清单2-30中给出。bool cv :: imwrite(const String& filename,InputArray img,Const std::vector& params = std::vector())filename:保存图像的地址和文件名,包含图像格式img:将要保存的Mat类矩阵变量p

图像的保存

OpenCV提供imwrite()函数用于将Mat类矩阵保存成图像文件,该函数的函数原型在代码清单2-30中给出。

bool cv :: imwrite(const String& filename,InputArray img,Const std::vector<int>& params = std::vector<int>())该函数用于将Mat类矩阵保存成图像文件,如果成功保存,则返回true,否则返回false。可以保存的图像格式参考imread()函数能够读取的图像文件格式,通常使用该函数只能保存8位单通道图像和3通道BGR彩色图像,但是可以通过更改第三个参数保存成不同格式的图像。不同图像格式能够保存的图像位数如下:

16位无符号(CV_16U)图像可以保存成PNG、JPEG、TIFF格式文件;32位浮点(CV_32F)图像可以保存成PFM、TIFF、OpenEXR和Radiance HDR格式文件;4通道(Alpha通道)图像可以保存成PNG格式文件。函数第三个参数在一般情况下不需要填写,保存成指定的文件格式只需要直接在第一个参数后面更改文件后缀即可,但是当需要保存的Mat类矩阵中数据比较特殊时(如16位深度数据),则需要设置第三个参数。第三个参数的设置方式如下所示

vector <int> compression_params;compression_params.push_back(IMWRITE_PNG_COMPRESSION);compression_params.push_back(9);imwrite(filename, img, compression_params)

为了更好的理解imwrite()函数的使用方式,在代码清单2-32中给出了生成带有Alpha通道的矩阵,并保存成PNG格式图像的程序。程序运行后会生成一个保存了4通道的png格式图像,为了更直观的看到图像结果,我们在图2-8中给出了Image Watch插件中看到的图像和保存成png格式的图像。

#include<iostream>#include<vector>//#include <stdio.h>#include <opencv2/opencv.hpp>#include "opencv/highgui.h"using namespace std;using namespace cv;void AlphaMat(Mat &mat){ CV_Assert(mat.channels()==4); for(int i=0;i<mat.rows;++i){ for(int j=0;j<mat.cols;++j){ Vec4b &bgra=mat.at<Vec4b>(i,j); bgra[0]=UCHAR_MAX;//蓝色通道 bgra[1]=saturate_cast<uchar>((float(mat.cols-j))/((float)mat.cols)*UCHAR_MAX);//绿色通道 bgra[2]=saturate_cast<uchar>((float(mat.rows-i))/((float)mat.rows)*UCHAR_MAX);//红色通道 bgra[3]=saturate_cast<uchar>(0.5*(bgra[1]+bgra[2]));//Alpha通道 } }}int main(int argc,char** argv) { cout<<"OpenCv Version: "<<CV_VERSION<<endl; Mat mat(480,640,CV_8UC4); AlphaMat(mat); vector<int>comprocession_params; comprocession_params.push_back(IMWRITE_PNG_COMPRESSION);//PNG格式图像压缩标志 comprocession_params.push_back(9);//设置最高压缩质量 bool result=imwrite("alpha.png",mat,comprocession_params); if(!result){ cout<<"保存成PNG格式图像失败"<<endl; return -1; } cout<<"保存成功"<<endl; imshow("alpha.png",mat); waitKey(0); return 0;}

视频的保存

有时我们需要将多幅图像生成视频,或者直接将摄像头拍摄到的数据保存成视频文件。OpenCV中提供了VideoWrite()类用于实现多张图像保存成视频文件,该类构造函数的原型在代码清单2-33中给出。

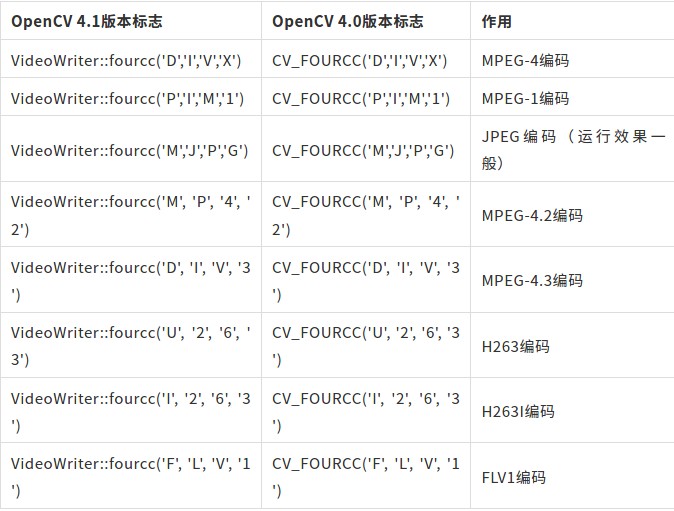

cv :: VideoWriter :: VideoWriter(); //默认构造函数cv :: VideoWriter :: VideoWriter(const String& filename, int fourcc, double fps, Size frameSize, bool isColor=true )代码清单2-33中的第1行默认构造函数的使用方法与VideoCapture()相同,都是创建一个用于保存视频的数据流,后续通过open()函数设置保存文件名称、编解码器、帧数等一系列参数。第二种构造函数需要输入的第一个参数是需要保存的视频文件名称,第二个函数是编解码器的代码,可以设置的编解码器选项在表中给出,如果赋值“-1”则会自动搜索合适的编解码器,需要注意的是其在OpenCV 4.0版本和OpenCV 4.1版本中的输入方式有一些差别,具体差别在表2-7给出。第三个参数为保存视频的帧率,可以根据需求自由设置,例如实现原视频二倍速播放、原视频慢动作播放等。第四个参数是设置保存的视频文件的尺寸,这里需要注意的时,在设置时一定要与图像的尺寸相同,不然无法保存视频。最后一个参数是设置保存的视频是否是彩色的,程序中,默认的是保存为彩色视频。

该函数与VideoCapture()有很大的相似之处,都可以通过isOpened()函数判断是否成功创建一个视频流,可以通过get()查看视频流中的各种属性。在保存视频时,我们只需要将生成视频的图像一帧一帧通过“<<”操作符(或者write()函数)赋值给视频流即可,最后使用release()关闭视频流。

为了更好的理解VideoWrite()类的使用方式,代码清单2-34中给出了利用已有视频文件数据或者直接通过摄像头生成新的视频文件的例程。读者需要重点体会VideoWrite()类和VideoCapture()类的相似之处和使用时的注意事项。

#include<iostream>#include<vector>//#include <stdio.h>#include <opencv2/opencv.hpp>#include "opencv/highgui.h"using namespace std;using namespace cv;int main(int argc,char** argv) { cout<<"OpenCv Version: "<<CV_VERSION<<endl; Mat img; VideoCapture video(0);//使用某个摄像头 //读取视频 //VideoCapture video //video.open("cpu.mp4"); if(!video.isOpened()){//判断是否调用成功 cout<<"打开摄像头失败,请确认摄像头是否安装成功"; return -1; } video>>img;//获取图像 //检测是否成功获取图像 if(img.empty()){//判断有没有读取图像成功 cout<<"没有获取到图像"<<endl; return -1; } bool isColor=(img.type()==CV_8UC3);//判断相机(视频)是否为彩色 VideoWriter writer; int coder=VideoWriter::fourcc('M','J','P','G');//选择编码格式 double fps=25.0;//设置视频帧率 string filename="live.avi";//保存的视频文件名称 writer.open(filename,coder,fps,img.size(),isColor);//创建保存视频文件的视频流 if(!writer.isOpened()){ cout<<"打开视频文件失败,请确认是否为合法输入"<<endl; return -1; } while (1){ //检测是否执行完毕 if(!video.read(img)){ cout<<"摄像头断开连接或者视频读取完成"<<endl; break; } writer.write(img);//把图像写入视频流 imshow("Live",img);//显示图像 char c=waitKey(50); if(c==27){//按ESC键突出视频保存 break; } } video.release(); writer.release(); return 0;}C++版本OpenCv教程(九)保存和读取XML和YMAL文件

Excerpt

除了图像数据之外,有时程序中的尺寸较小的Mat类矩阵、字符串、数组等数据也需要进行保存,这些数据通常保存成XML文件或者YAML文件。本小节中将介绍如何利用OpenCV 4中的函数将数据保存成XML文件或者YAML文件以及如何读取这两种文件中的数据。XML是一种元标记语言,所谓元标记就是使用者可以根据自身需求定义自己的标记,例如可以用、等标记来定义数据的含义,例如用24来表示age数据的数值为24。XML是一种结构化的语言,通过XML语言可以知道数据之间的隶属关系,例如100150表示在color数据中

除了图像数据之外,有时程序中的尺寸较小的Mat类矩阵、字符串、数组等

数据也需要进行保存,这些数据通常保存成XML文件或者YAML文件。本小节中将介绍如何利用OpenCV 4中的函数将数据保存成XML文件或者YAML文件以及如何读取这两种文件中的数据。

XML是一种元标记语言,所谓元标记就是使用者可以根据自身需求定义自己的标记,例如可以用、等标记来定义数据的含义,例如用24来表示age数据的数值为24。XML是一种结构化的语言,通过XML语言可以知道数据之间的隶属关系,例如100150表示在color数据中含有两个名为red和blue的数据,两者的数值分别是100和150。通过标记的方式,无论以任何形式保存数据,只要文件满足XML格式,那么读取出来的数据就不会出现混淆和歧义。XML文件的扩展名是“.xml”。

YMAL是一种以数据为中心的语言,通过“变量:数值”的形式来表示每个数据的数值,通过不同的缩进来表示不同数据之间的结构和隶属关系。YMAL可读性高,常用来表达资料序列的格式,它参考了多种语言,包括XML、C语言、Python、Perl等。YMAL文件的扩展名是“.ymal”或者“.yml”。

OpenCV 4中提供了用于生成和读取XML文件和YMAL文件的FileStorage类,类中定义了初始化类、写入数据和读取数据等方法。我们在使用该FileStorage类时首先需要对其进行初始化,初始化可以理解为声明需要操作的文件和操作类型。OpenCV 4提供了两种初始化的方法,分别是不输入任何参数的初始化(可以理解为只定义,并未初始化)和输入文件名称和操作类型的初始化。后者初始化构造函数的函数原型在代码清单2-35中给出。

cv::FileStorage::FileStorage(const String & filename, int flags, const String & encoding = String() )

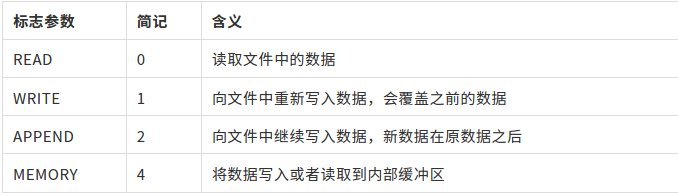

该函数是FileStorage类的构造函数,用于声明打开的文件名称和操作的类型。函数第一个参数是打开的文件名称,参数是字符串类型,文件的扩展名是“.xml”、“.ymal”或者“.yml”。打开得文件可以已经存在或者未存在,但是当对文件进行读取操作时需要是已经存在的文件。第二个参数是对文件进行的操作类型标志,例如对文件进行读取操作、写入操作等,常用参数及含义在表2-8给出,由于该标志量在FileStorage类中,因此在使用时需要加上类名作为前缀,例如“FileStorage::WRITE”。最后一个参数是文件的编码格式,目前不支持UTF-16 XML编码,需要使用UTF-8 XML编码,通常情况下使用该参数的默认值即可。

打开文件后,可以通过FileStorage类中的isOpened()函数判断是否成功打开文件,如果成功打开文件,该函数返回true,如果打开文件失败,则该函数返回false。

FileStorage类中默认构造函数没有任何参数,因此没有声明打开的文件和操作的类型,此时需要通过FileStorage类中的open()函数单独进行声明。

virtual bool cv::FileStorage::open(const String & filename, int flags, const String & encoding = String() )该函数补充了默认构造函数没有声明打开文件的缺点,函数可以指定FileStorage类打开的文件,如果成功打开文件,则返回值为true,否则为false。函数中所有的参数及含义都与代码清单2-35中的相同,因此这里不再进行赘述。同样,通过该函数打开文件后仍然可以通过FileStorage类中的isOpened()函数判断是否成功打开文件。

打开文件后,类似C++中创建的数据流,可以通过“<<”操作符将数据写入文件中,或者通过“>>”操作符从文件中读取数据。除此之外,还可以通过FileStorage类中的write()函数将数据写入文件中,该函数的函数原型在代码清单2-37中给出。

void cv::FileStorage::write(const String & name, int val )该函数能够将不同数据类型的变量名称和变量值写入到文件中。该函数的第一个参数是写入文件中的变量名称。第二个参数是变量值,代码清单2-37中的变量值是int类型,但是在FileStorage类中提供了write()函数的多个重载函数,分别用于实现将double、String、Mat、vector类型的变量值写入到文件中。

使用操作符向文件中写入数据时与write()函数类似,都需要声明变量名和变量值,例如变量名为“age”,变量值为“24”,可以通过“file<<”age”<<24”来实现。如果某个变量的数据是一个数组,可以用“[]”将属于同一个变量的变量值标记出来,例如“file<<”age”<<“[”<<24<<25<<”]””。如果某些变量隶属于某个变量,可以用“{}”表示变量之间的隶属关系,例如“file<<”age”<<“{”<<”Xiaoming”<<24<<”Wanghua”<<25<<”}””。

读取文件中的数据时,只需要通过变量名就可以读取变量值。例如“file [“x”] >> xRead”是读取变量名为x的变量值。但是,当某个变量中含有多个数据或者含有子变量时,就需要通过FileNode节点类型和迭代器FileNodeIterator进行读取,例如某个变量的变量值是一个数组,首先需要定义一个file [“age”]的FileNode节点类型变量,之后通过迭代器遍历其中的数据。另外一种方法可以不使用迭代器,通过在变量后边添加“[]”地址的形式读取数据,例如FileNode[0]表示数组变量中的第一个数据,FileNode[“Xiaoming”]表示“age”变量中的“Xiaoming”变量的数据,依次向后添加“[]”地址实现多节点数据的读取。

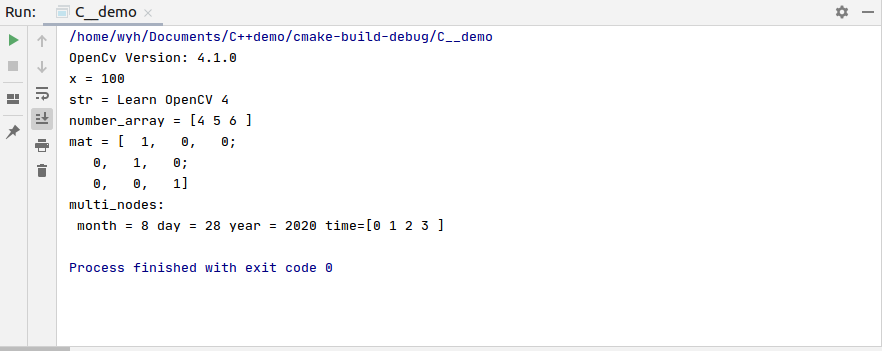

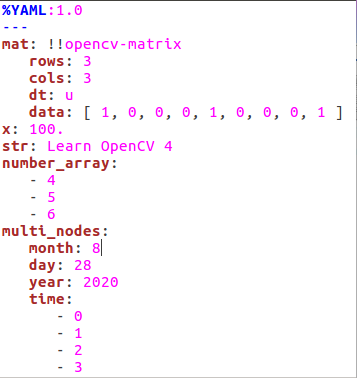

为了了解如何生成和读取XML文件和YMAL文件,在代码清单2-38中给出了实现文件写入和读取的示例程序。程序中使用write()函数和“<<”操作符两种方式向文件中写入数据,使用迭代器和“[]”地址两种方式从文件中读取数据。数据的写入和读取方法在前面已经介绍,在代码清单2-38中需要重点了解如何通过程序实现写入与读取。程序生成的XML文件和YMAL文件中的数据在图2-10给出,读取文件数据的结果在图2-9给出。

#include<iostream>#include<vector>#include<string>//#include <stdio.h>#include <opencv2/opencv.hpp>#include "opencv/highgui.h"using namespace std;using namespace cv;int main(int argc,char** argv) { cout<<"OpenCv Version: "<<CV_VERSION<<endl; string filename="datas.yaml";//文件的名称 FileStorage fwriter(filename,FileStorage::WRITE); //存入矩阵Mat类型的数据 Mat mat=Mat::eye(3,3,CV_8U); fwriter.write("mat",mat);//使用write()函数写入数据 //存入浮点型数据,节点名称为x float x=100; fwriter<<"x"<<x; //存入字符串类型数据,节点名称为str string str="Learn OpenCV 4"; fwriter<<"str"<<str; //存入数组,节点名称为number_array fwriter<<"number_array"<<"["<<4<<5<<6<<"]"; //存入多node节点数据,主名为multi_nodes fwriter<<"multi_nodes"<<"{"<<"month"<<8<<"day"<<28<<"year" <<2020<<"time"<<"["<<0<<1<<2<<3<<"]"<<"}"; //关闭文件 fwriter.release(); //以读取的模式打开文件 FileStorage fread(filename,FileStorage::READ); //判断是否打开成功 if(!fread.isOpened()){ cout<<"打开文件失败,请确认文件名称是否正确!"<<endl; return -1; } //读取文件中的数据 float xRead; fread["x"]>>xRead;//读取浮点型数据 cout<<"x = "<<xRead<<endl; //读取字符串数据 string strRead; fread["str"]>>strRead; cout<<"str = "<<strRead<<endl; //读取含多个number_array节点 FileNode fileNode=fread["number_array"]; cout<<"number_array = ["; for(FileNodeIterator i=fileNode.begin();i!=fileNode.end();++i){ float a; *i>>a; cout<<a<<" "; } cout<<"]"<<endl; //读取Mat类型数据 Mat matRead; fread["mat="]>>matRead; cout<<"mat = "<<mat<<endl; //读取含有多个子节点的节点数据,不使用fileNode和迭代器进行读取 FileNode fileNode1=fread["multi_nodes"]; int month=(int)fileNode1["month"]; int day=(int)fileNode1["day"]; int year=(int)fileNode1["year"]; cout<<"multi_nodes:"<<endl; cout<<" month = "<<month<<" day = "<<day<<" year = "<<year<<" time=["; for(int i=0;i<4;++i){ int a=(int)fileNode1["time"][i]; cout<<a<<" "; } cout<<"]"<<endl; //关闭文件 fread.release(); return 0;}

C++版本OpenCv教程(十)颜色模型与转换

Excerpt

目录RGB颜色模型YUV颜色模型RGB颜色模型前面对于RGB颜色模型已经有所介绍,该模型的命名方式是采用三种颜色的英文首字母组成,分别是红色(Red)、绿色(Green)和蓝色(Blue)。虽然该颜色模型的命名方式是红色在前,但是在OpenCV中却是相反的顺序,第一个通道时蓝色(B)分量,第二个通道时绿色(G)分量,第三个通道时红色(R)分量。根据存储顺序的不同,OpenCV 4中提供了这种顺序的反序格式,用于存储第一个通道是红色分量的图像,但是这两种格式的图像的颜色空间是相同的,颜色空间如图3-1所示

目录

RGB颜色模型YUV颜色模型HSV颜色模型Lab颜色模型GRAY颜色模型不同颜色模型间的互相转换RGB颜色模型

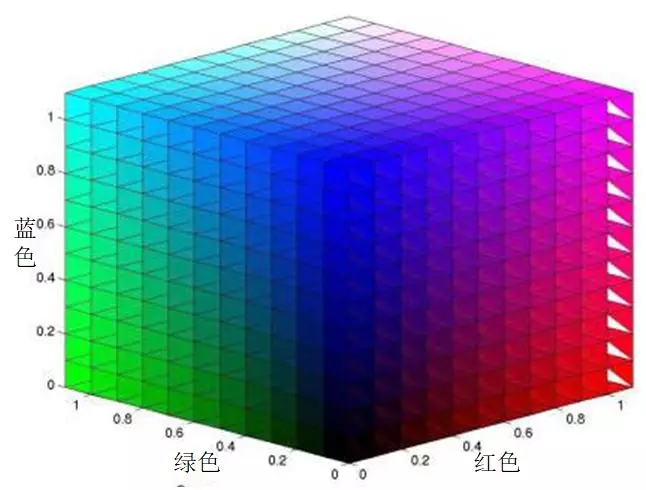

前面对于RGB颜色模型已经有所介绍,该模型的命名方式是采用三种颜色的英文首字母组成,分别是红色(Red)、绿色(Green)和蓝色(Blue)。虽然该颜色模型的命名方式是红色在前,但是在OpenCV中却是相反的顺序,第一个通道时蓝色(B)分量,第二个通道时绿色(G)分量,第三个通道时红色(R)分量。根据存储顺序的不同,OpenCV 4中提供了这种顺序的反序格式,用于存储第一个通道是红色分量的图像,但是这两种格式的图像的颜色空间是相同的,颜色空间如图3-1所示。三个通道对于颜色描述的范围是相同的,因此RGB颜色模型的空间构成是一个立方体。在RGB颜色模型中,所有的颜色都是由这三种颜色通过不同比例的混合得到,如果三种颜色分量都为0,则表示为黑色,如果三种颜色的分量相同且都为最大值,则表示为白色。每个通道都表示某一种颜色由0到1的过程,不同位数的图像表示将这个颜色变化过程细分成不同的层级,例如8U3C格式的图像每个通道将这个过程量化成256个等级,分别由0到255表示。在这个模型的基础上增加第四个通道即为RGBA模型,第四个通道表示颜色的透明度,当没有透明度需求的时候,RGBA模型就会退化成RGB模型。

YUV颜色模型

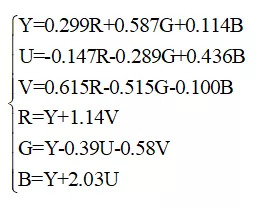

YUV模型是电视信号系统所采用的颜色编码方式。这三个变量分别表示是像素的亮度(Y)以及红色分量与亮度的信号差值(U)和蓝色与亮度的差值(V)。这种颜色模型主要用于视频和图像的传输,该模型的产生与电视机的发展历程密切相关。由于彩色电视机在黑白电视机发明之后才产生,因此用于彩色电视机的视频信号需要能够兼容黑白电视机。彩色电视机需要三个通道的数据才能显示彩色,而黑白电视机只需要一个通道的数据即可,因此为了使视频信号能够兼容彩色电视与黑白电视,将RGB编码方式转变成YUV的编码方式,其Y通道是图像的亮度,黑白电视只需要使用该通道就可以显示黑白视频图像,而彩色相机通过将YUV编码转成RGB编码方式,便可以在彩色电视种显示彩色图像,较好的解决了同一个视频信号兼容不同类型电视的问题。RGB模型与YUV模型之间的转换关系如式所示,其中RGB取值范围均为0-255。

HSV颜色模型

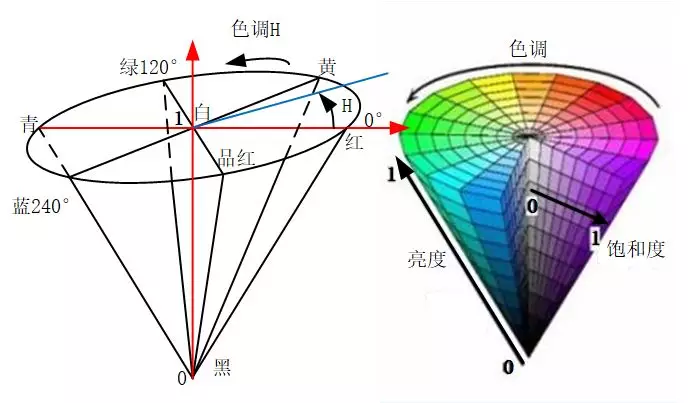

HSV是色度(Hue)、饱和度(Saturation)和亮度(Value)的简写,通过名字也可以看出来该模型通过这三个特性对颜色进行描述。色度是色彩的基本属性,就是平时常说的颜色,例如红色,蓝色等;饱和度是指颜色的纯度,饱和度越高色彩越纯越艳,饱和度越低色彩则逐渐地变灰变暗,饱和度的取值范围是由0到100%;亮度是颜色的明亮程度,其取值范围由0到计算机中允许的最大值。由于色度、饱和度和亮度的取值范围不同,因此其颜色空间模型用锥形表示,其形状如图3-2所示。相比于RGB模型三个颜色分量与最终颜色联系不直观的缺点,HSV模型更加符合人类感知颜色的方式:颜色、深浅以及亮暗。

Lab颜色模型

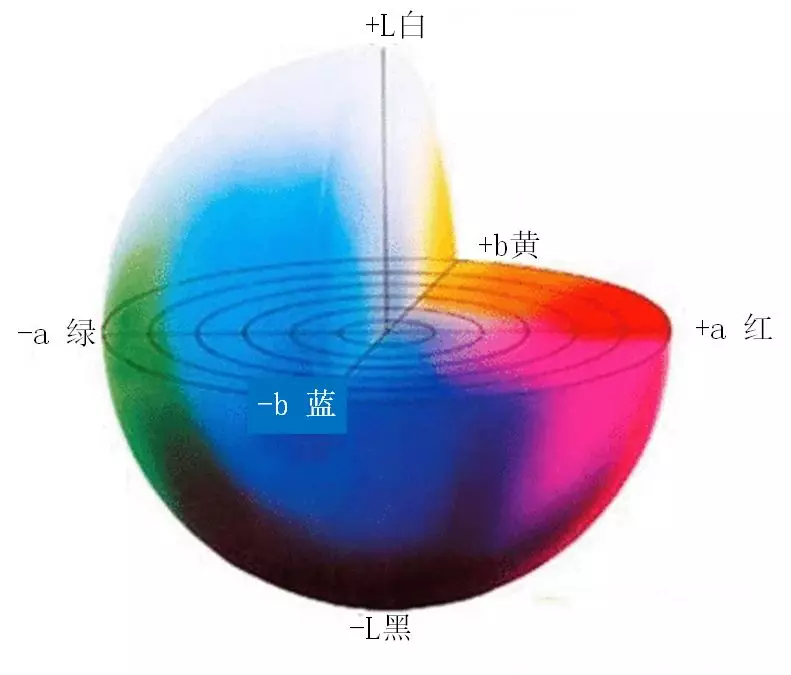

Lab颜色模型弥补了RGB模型的不足,是一种设备无关的颜色模型,是一种基于生理特征的颜色模型。在模型中L表示亮度(Luminosity),a和b是两个颜色通道,两者的取值区间都是由-128到+127,其中a通道数值由小到大对应的颜色是从绿色变成红色,b通道数值由小到大对应的颜色是由蓝色变成黄色。其构成的颜色空间是一个球形,形式如图3-3所示。

GRAY颜色模型

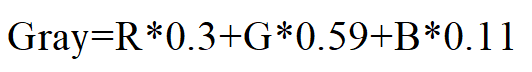

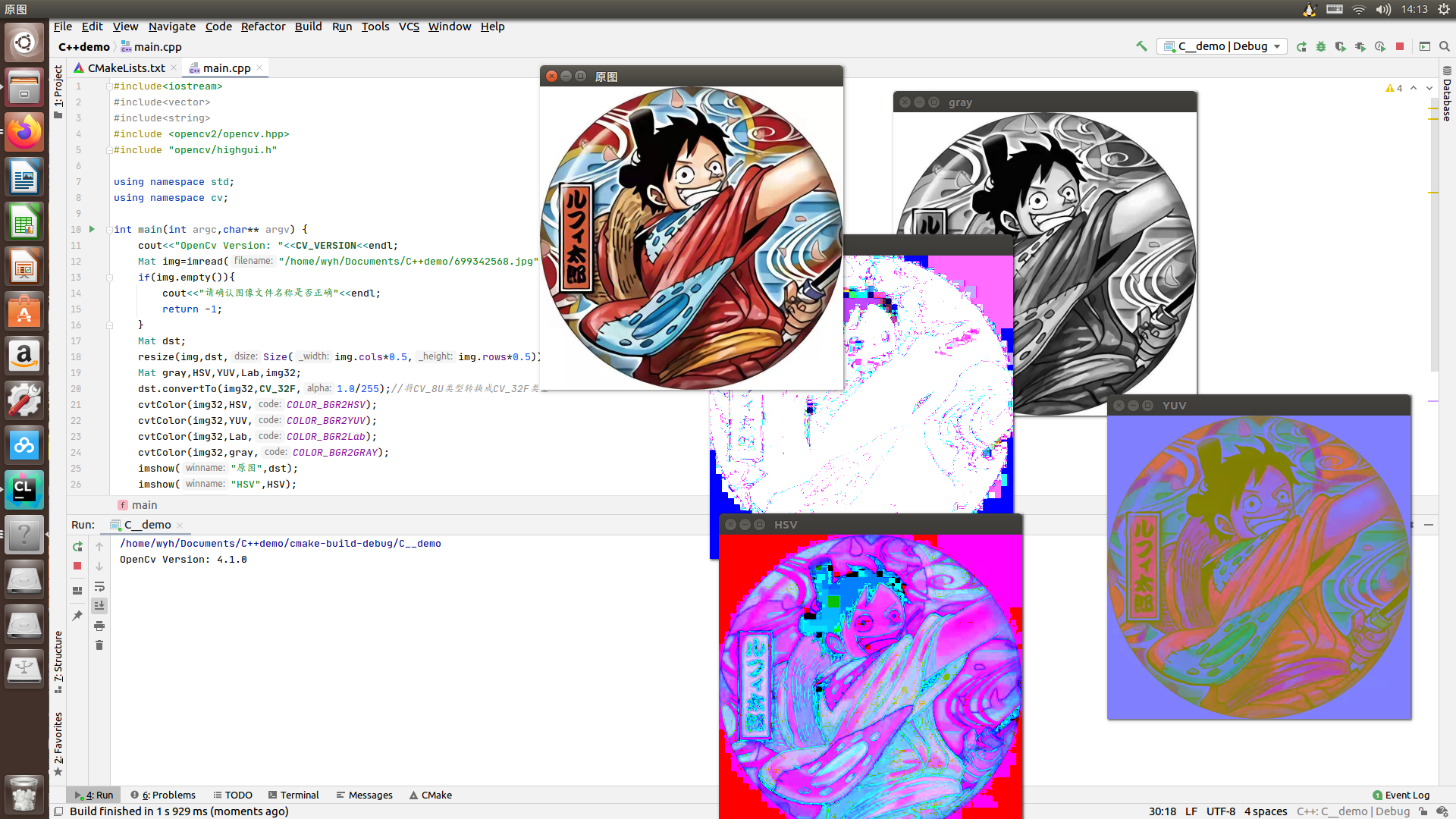

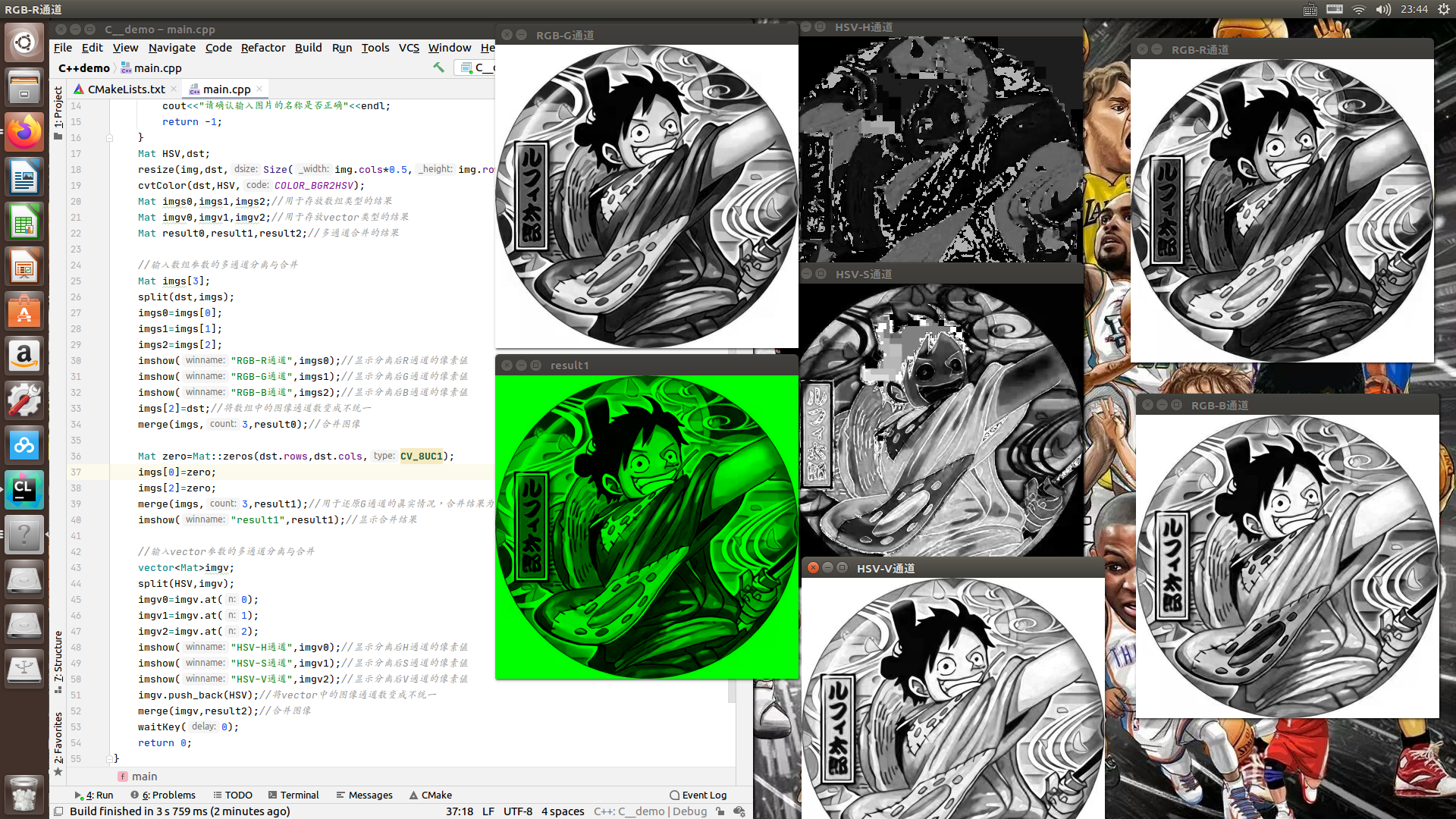

GRAY模型并不是一个彩色模型,他是一个灰度图像的模型,其命名使用的是英文单词gray的全字母大写。灰度图像只有单通道,灰度值根据图像位数不同由0到最大依次表示由黑到白,例如8UC1格式中,由黑到白被量化成了256个等级,通过0-255表示,其中255表示白色。彩色图像具有颜色丰富、信息含量大的特性,但是灰度图在图像处理中依然具有一定的优势。例如,灰度图像具有相同尺寸相同压缩格式所占容量小,易于采集,便于传输等优点。常用的RGB模型转成灰度图的方式如式中所示。

不同颜色模型间的互相转换

针对图像不同颜色模型之间的相互转换,OpenCV 4提供了cvtColor()函数用于实现转换功能,该函数的函数原型如下所示:

void cv::cvtColor(InputArray src, OutputArray dst, int code, int dstCn = 0)函数用于将图像从一个颜色模型转换为另一个颜色模型,前两个参数用于输入待转换图像和转换颜色空间后目标图像,第三个参数用于声明该函数具体的转换模型空间。第四个参数在一般情况下不需要特殊设置,使用默认参数即可。需要注意的是该函数变换前后的图像取值范围,由于8位无符号图像的像素由0到255,16位无符号图像的像素由0-65535,而32位浮点图像的像素是由0到1,因此一定要注意目标图像的像素范围。在线性变换的情况下,范围问题不需要考虑,目标图像的像素不会超出范围。如果在非线性变换的情况下,应将输入RGB图像归一化到适当的范围以内获得正确的结果,例如将8位无符号图像转成32位浮点图像,需要先将图像像素通过除以255缩放到0到1范围内,以防止产生错误结果。

【注意】如果转换过程中添加了alpha通道(RGB模型中第四个通道,表示透明度),则其值将设置为相应通道范围的最大值:CV_8U为255,CV_16U为65535,CV_32F为1

为了直观的感受同一张图像在不同颜色空间中的样子,在代码清单3-2中给出了前面几种颜色模型互相转换的程序,运行结果如图3-4所示。需要说明的是Lab颜色模型具有负数,而通过imshow()函数显示的图像无法显示负数,因此在结果中给出了Image Watch插件显示图像在Lab模型中的样子。在程序中,我们为了防止转换后出现数值越界的情况,先将CV_8U类型转成CV_32F类型后再进行颜色模型的转换。

#include<iostream>#include<vector>#include<string>#include <opencv2/opencv.hpp>#include "opencv/highgui.h"using namespace std;using namespace cv;int main(int argc,char** argv) { cout<<"OpenCv Version: "<<CV_VERSION<<endl; Mat img=imread("/home/wyh/Documents/C++demo/699342568.jpg"); if(img.empty()){ cout<<"请确认图像文件名称是否正确"<<endl; return -1; } Mat dst; resize(img,dst,Size(img.cols*0.5,img.rows*0.5)); Mat gray,HSV,YUV,Lab,img32; dst.convertTo(img32,CV_32F,1.0/255);//将CV_8U类型转换成CV_32F类型 cvtColor(img32,HSV,COLOR_BGR2HSV); cvtColor(img32,YUV,COLOR_BGR2YUV); cvtColor(img32,Lab,COLOR_BGR2Lab); cvtColor(img32,gray,COLOR_BGR2GRAY); imshow("原图",dst); imshow("HSV",HSV); imshow("YUV",YUV); imshow("Lab",Lab); imshow("gray",gray); waitKey(10000); return 0;}

C++版本OpenCv教程(十一)多通道分离与合并

Excerpt

在图像颜色模型中不同的分量存放在不同的通道中,如果我们只需要颜色模型的某一个分量,例如只需要处理RGB图像中的红色通道,可以将红色通道从三通道的数据中分离出来再进行处理,这种方式可以减少数据所占据的内存,加快程序的运行速度。同时,当我们分别处理完多个通道后,需要将所有通道合并在一起重新生成RGB图像。针对图像多通道的分离与混合,OpenCV 4中提供了split()函数和merge()函数用于解决这些需求。多通道分离函数split()OpenCV 4中针对多通道分离函数split()有两种重载原型,在代

在图像颜色模型中不同的分量存放在不同的通道中,如果我们只需要颜色模型的某一个分量,例如只需要处理RGB图像中的红色通道,可以将红色通道从三通道的数据中分离出来再进行处理,这种方式可以减少数据所占据的内存,加快程序的运行速度。同时,当我们分别处理完多个通道后,需要将所有通道合并在一起重新生成RGB图像。针对图像多通道的分离与混合,OpenCV 4中提供了split()函数和merge()函数用于解决这些需求。

多通道分离函数split()

OpenCV 4中针对多通道分离函数split()有两种重载原型,在代码清单3-4中给出了这两种函数原型。

void cv::split(const Mat & src, Mat * mvbegin )void cv::split(InputArray m, OutputArrayOfArrays mv )该函数主要是用于将多通道的图像分离成若干单通道的图像,两个函数原型中不同之处在于前者第二个参数输入的是Mat类型的数组,其数组的长度需要与多通道图像的通道数相等并且提前定义;第二种函数原型的第二个参数输入的是一个vector容器,不需要知道多通道图像的通道数。两个函数原型虽然输入参数的类型不同,但是通道分离的原理是相同的,可以用公式(3.4)表示。

多通道合并函数merge()

OpenCV 4中针对多通道合并函数merge()也有两种重载原型,在代码清单3-5中给出了两种原型。

void cv::merge(const Mat * mv, size_t count, OutputArray dst ) void cv::merge(InputArrayOfArrays mv, OutputArray dst )该函数主要是用于将多个图像合并成一个多通道图像,该函数也具有两种不同的函数原型,每一种函数原型都是与split()函数相对应,两种原型分别输入数组形式的图像数据和向量vector形式的图像数据,在输入数组形式数据的原型中,还需要输入数组的长度。合并函数的输出结果是一个多通道的图像,其通道数目是所有输入图像通道数目的总和。这里需要说明的是,用于合并的图像并非都是单通道的,也可以是多个通道数目不相同的图像合并成一个通道更多的图像,虽然这些图像的通道数目可以不相同,但是需要所有图像具有相同的尺寸和数据类型。

图像多通道分离与合并例程

为了使读者更加熟悉图像多通道分离与合并的操作,同时加深对图像不同通道作用的理解,在代码清单3-6中实现了图像的多通道分离与合并的功能。程序中用两种函数原型分别分离了RGB图像和HSV图像,为了验证merge ()函数可以合并多个通道不相同的图像,程序中分别用两种函数原型合并了多个不同通道的图像,合并后图像的通道数为5,不能通过imshow()函数显示,我们用Image Watch插件查看了合并的结果。由于RGB三个通道分离结果显示时都是灰色且相差不大,因此图3-5没有给出其分离后的结果,只给出合并后显示为绿色的合并图像,同时给出HSV分离结果,其他结果读者可以自行运行程序查看。

#include<iostream>#include<vector>#include<string>#include <opencv2/opencv.hpp>#include "opencv/highgui.h"using namespace std;using namespace cv;int main(int argc,char** argv) { cout<<"OpenCv Version: "<<CV_VERSION<<endl; Mat img=imread("/home/wyh/Documents/C++demo/699342568.jpg"); if(img.empty()){ cout<<"请确认输入图片的名称是否正确"<<endl; return -1; } Mat HSV,dst; resize(img,dst,Size(img.cols*0.5,img.rows*0.5)); cvtColor(dst,HSV,COLOR_BGR2HSV); Mat imgs0,imgs1,imgs2;//用于存放数组类型的结果 Mat imgv0,imgv1,imgv2;//用于存放vector类型的结果 Mat result0,result1,result2;//多通道合并的结果 //输入数组参数的多通道分离与合并 Mat imgs[3]; split(dst,imgs); imgs0=imgs[0]; imgs1=imgs[1]; imgs2=imgs[2]; imshow("RGB-R通道",imgs0);//显示分离后R通道的像素值 imshow("RGB-G通道",imgs1);//显示分离后G通道的像素值 imshow("RGB-B通道",imgs2);//显示分离后B通道的像素值 imgs[2]=dst;//将数组中的图像通道数变成不统一 merge(imgs,3,result0);//合并图像 Mat zero=Mat::zeros(dst.rows,dst.cols,CV_8UC1); imgs[0]=zero; imgs[2]=zero; merge(imgs,3,result1);//用于还原G通道的真实情况,合并结果为绿色 imshow("result1",result1);//显示合并结果 //输入vector参数的多通道分离与合并 vector<Mat>imgv; split(HSV,imgv); imgv0=imgv.at(0); imgv1=imgv.at(1); imgv2=imgv.at(2); imshow("HSV-H通道",imgv0);//显示分离后H通道的像素值 imshow("HSV-S通道",imgv1);//显示分离后S通道的像素值 imshow("HSV-V通道",imgv2);//显示分离后V通道的像素值 imgv.push_back(HSV);//将vector中的图像通道数变成不统一 merge(imgv,result2);//合并图像 waitKey(0); return 0;}

C++版本OpenCv教程(十二)图像像素统计

Excerpt

我们可以将数字图像理解成一定尺寸的矩阵,矩阵中每个元素的大小表示了图像中每个像素的亮暗程度,因此统计矩阵中的最大值,就是寻找图像中灰度值最大的像素,计算平均值就是计算图像像素平均灰度,可以用来表示图像整体的亮暗程度。因此针对矩阵数据的统计工作在图像像素中同样具有一定的意义和作用。在OpenCV 4中集成了求取图像像素最大值、最小值、平均值、均方差等众多统计量的函数,接下来将详细介绍这些功能的相关函数。寻找图像像素最大值与最小值OpenCV 4提供了寻找图像像素最大值、最小值的函数minMaxLoc(),

我们可以将数字图像理解成一定尺寸的矩阵,矩阵中每个元素的大小表示了图像中每个像素的亮暗程度,因此统计矩阵中的最大值,就是寻找图像中灰度值最大的像素,计算平均值就是计算图像像素平均灰度,可以用来表示图像整体的亮暗程度。因此针对矩阵数据的统计工作在图像像素中同样具有一定的意义和作用。在OpenCV 4中集成了求取图像像素最大值、最小值、平均值、均方差等众多统计量的函数,接下来将详细介绍这些功能的相关函数。

寻找图像像素最大值与最小值

OpenCV 4提供了寻找图像像素最大值、最小值的函数minMaxLoc(),该函数的原型在代码清单3-7中给出。

void cv::minMaxLoc(InputArray src, double * minVal, double * maxVal = 0, Point * minLoc = 0, Point * maxLoc = 0, InputArray mask = noArray())这里我们见到了一个新的数据类型Point,该数据类型是用于表示图像的像素坐标,由于图像的像素坐标轴以左上角为坐标原点,水平方向为x轴,垂直方向为y轴,因此Point(x,y)对应于图像的行和列表示为Point(列数,行数)。在OpenCV中对于2D坐标和3D坐标都设置了多种数据类型,针对2D坐标数据类型定义了整型坐标cv::Point2i(或者cv::Point)、double型坐标cv::Point2d、浮点型坐标cv::Point2f,对于3D坐标同样定义了上述的坐标数据类型,只需要将其中的数字“2”变成“3”即可。对于坐标中x、y、z轴的具体数据,可以通过变量的x、y、z属性进行访问,例如Point.x可以读取坐标的x轴数据。

该函数实现的功能是寻找图像中特定区域内的最值,函数第一个参数是输入单通道矩阵,需要注意的是,该变量必须是一个单通道的矩阵数据,如果是多通道的矩阵数据,需要用cv::Mat::reshape()将多通道变成单通道,或者分别寻找每个通道的最值,然后再进行比较寻找到全局最值。对于cv::Mat::reshape()的用法,在代码清单3-8中给出。第二到第五个参数分别是指向最小值、最大值、最小值位置和最大值位置的指针,如果不需要寻找某一个参数,可以将该参数设置为NULL,函数最后一个参数是寻找最值得掩码矩阵,用于标记寻找上述四个值的范围,参数默认值为noArray(),表示寻找范围是矩阵中所有数据。

Mat cv::Mat::reshape(int cn,int rows = 0)注意

如果矩阵中存在多个最大值或者最小值时,minMaxLoc()函数输出最值的位置为按行扫描从左向右第一次检测到最值的位置,同时输入参数时一定要注意添加取地址符。

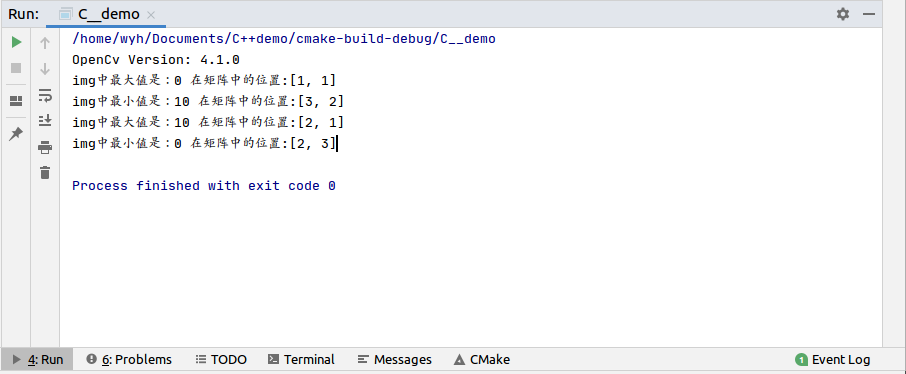

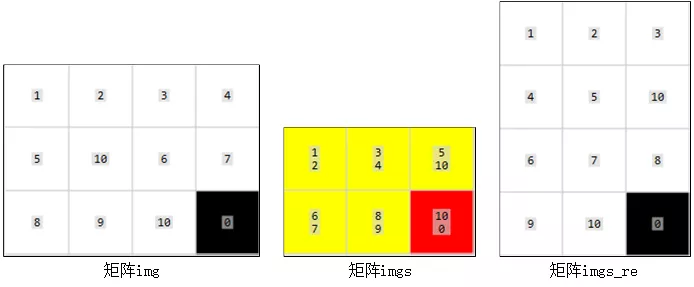

为了让读者更加了解minMaxLoc()函数的原理和使用方法,在代码清单3-9中给出寻找矩阵最值的示例程序,在图3-6中给出了程序运行的最终结果,在图3-7给出了创建的两个矩阵和通道变换后的矩阵在Image Watch中查看的内容。

#include<iostream>#include<vector>#include<string>#include <opencv2/opencv.hpp>#include "opencv/highgui.h"using namespace std;using namespace cv;int main(int argc,char** argv) { cout<<"OpenCv Version: "<<CV_VERSION<<endl; float a[12]={1,2,3,4,5,10,6,7,8,9,10,0}; Mat img=Mat(3,4,CV_32FC1,a);//单通道矩阵 Mat imgs=Mat(2,3,CV_32FC2,a);//多通道矩阵 double minVal,maxVal;//用于存放矩阵中的最大值和最小值 Point minIdx,maxIdx;//用于存放矩阵中的最大值和最小值的位置 /*寻找单通道矩阵中的最值*/ minMaxLoc(img,&maxVal,&minVal,&minIdx,&maxIdx); cout << "img中最大值是:" << maxVal << " " << "在矩阵中的位置:" << maxIdx << endl; cout << "img中最小值是:" << minVal << " " << "在矩阵中的位置:" << minIdx << endl; /*寻找多通道矩阵中的最值*/ Mat imgs_re=imgs.reshape(1,4);//将多通道矩阵变成单通道矩阵 minMaxLoc(imgs_re,&minVal,&maxVal,&minIdx,&maxIdx); cout << "img中最大值是:" << maxVal << " " << "在矩阵中的位置:" << maxIdx << endl; cout << "img中最小值是:" << minVal << " " << "在矩阵中的位置:" << minIdx << endl; return 0;}

计算图像的均值和标准方差

图像的均值表示图像整体的亮暗程度,图像的均值越大图像整体越亮。标准方差表示图像中明暗变化的对比程度,标准差越大表示图像中明暗变化越明显。OpenCV 4提供了mean()函数用于计算图像的平均值,提供了meanStdDev()函数用于同时计算图像的均值和标准方差。接下来将详细的介绍这两个函数的使用方法。

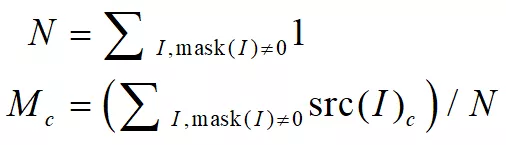

cv::Scalar cv::mean(InputArray src,InputArray mask = noArray())该函数用来求取图像矩阵的每个通道的平均值,函数的第一个参数用来输入待求平均值的图像矩阵,其通道数目可以在1到4之间。需要注意的是,该函数的返回值是一个cv::Scalar类型的变量,函数的返回值有4位,分别表示输入图像4个通道的平均值,如果输入图像只有1个通道,那么返回值的后三位都为0,例如输入该函数一个单通道平均值为1的图像,输出的结果为[1,0,0,0],可以通过cv::Scalar[n]查看第n个通道的平均值。该函数的第二个参数用于控制图像求取均值的范围,在第一个参数中去除第二个参数中像素值为0的像素,计算的原理如式(3.5)所示,当不输入第二个参数时,表示求取第一个参数全部像素的平均值。

其中表示第c个通道的平均值,表示第c个通道像素的灰度值。

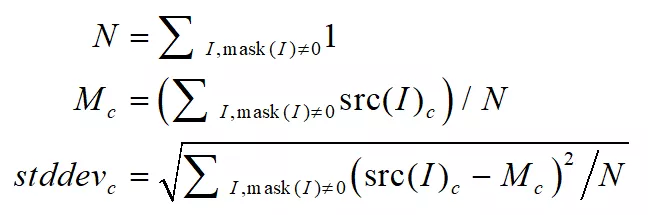

meanStdDev()函数可以同时求取图像每个通道的平均值和标准方差,其函数原型在代码清单3-11中给出。

void cv::meanStdDev(InputArray src,OutputArray mean,OutputArray stddev,InputArray mask = noArray())该函数的第一个参数与前面mean()函数第一个参数相同,都可以是1-4通道的图像,不同之处在于该函数没有返回值,图像的均值和标准方差输出在函数的第二个和第三个参数中,区别于mean()函数,用于存放平均值和标准方差的是Mat类型变量,变量中的数据个数与第一个参数通道数相同,如果输入图像只有一个通道,该函数求取的平均值和标准方差变量中只有一个数据。该函数计算原理如式(3.6)所示。

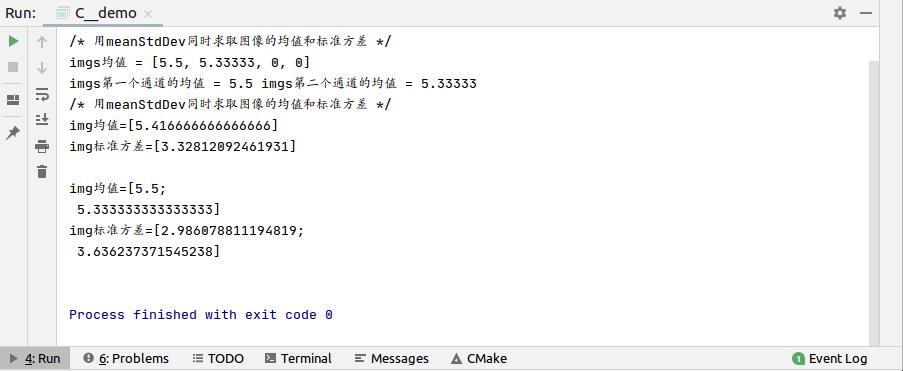

我们在代码清单3-12中给出了利用上面两个函数计算代码清单3-9中img和imgs两个矩阵的平均值和标准方差,并在图3-8给出了程序运行的结果。

#include<iostream>#include<vector>#include<string>#include <opencv2/opencv.hpp>#include "opencv/highgui.h"using namespace std;using namespace cv;int main(int argc,char** argv) { cout<<"OpenCv Version: "<<CV_VERSION<<endl; float a[12]={1,2,3,4,5,10,6,7,8,9,10,0}; Mat img=Mat(3,4,CV_32FC1,a);//单通道矩阵 Mat imgs=Mat(2,3,CV_32FC2,a);//多通道矩阵 cout << "/* 用meanStdDev同时求取图像的均值和标准方差 */" << endl; Scalar myMean; myMean=mean(imgs); cout<<"imgs均值 = "<<myMean<<endl; cout<<"imgs第一个通道的均值 = "<<myMean[0]<<" " <<"imgs第二个通道的均值 = "<<myMean[1]<<endl; cout << "/* 用meanStdDev同时求取图像的均值和标准方差 */" << endl; Mat myMeanMat,myStddevMat; meanStdDev(img,myMeanMat,myStddevMat); cout << "img均值=" << myMeanMat << " " << endl; cout << "img标准方差=" << myStddevMat << endl << endl; meanStdDev(imgs,myMeanMat,myStddevMat); cout << "img均值=" << myMeanMat << " " << endl; cout << "img标准方差=" << myStddevMat << endl << endl; return 0;}

C++版本OpenCv教程(十三)两图像间的像素操作

Excerpt

两张图像的比较运算OpenCV 4中提供了求取两张图像每一位像素较大或者较小灰度值的max()、min()函数,这两个函数分别比较两个图像中每一位元素灰度值的大小,保留较大(较小)的灰度值,这两个函数的函数原型在代码清单3-13中给出。void cv::max(InputArray src1,InputArray src2,OutputArray dst)void cv::min(InputArray src1,InputArray src2,OutputArray dst)src1:第一个图像

两张图像的比较运算

OpenCV 4中提供了求取两张图像每一位像素较大或者较小灰度值的max()、min()函数,这两个函数分别比较两个图像中每一位元素灰度值的大小,保留较大(较小)的灰度值,这两个函数的函数原型在代码清单3-13中给出。

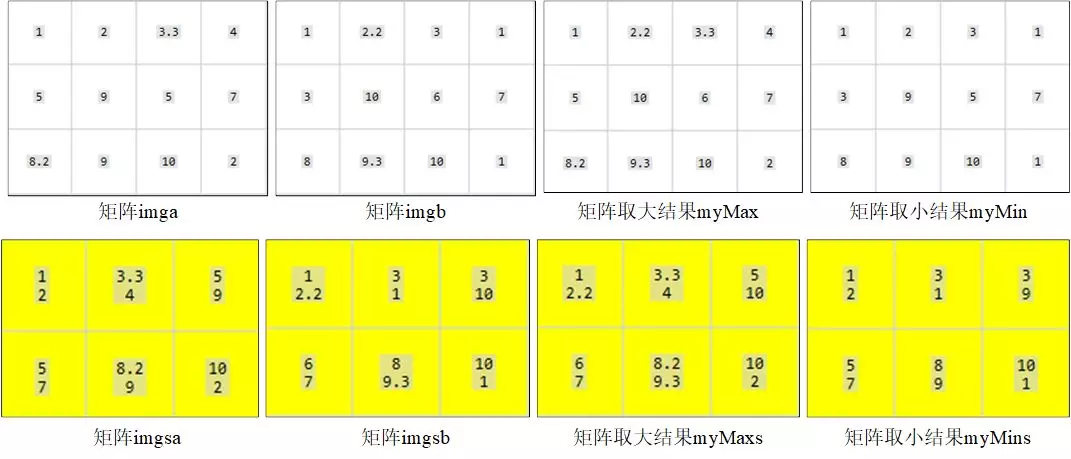

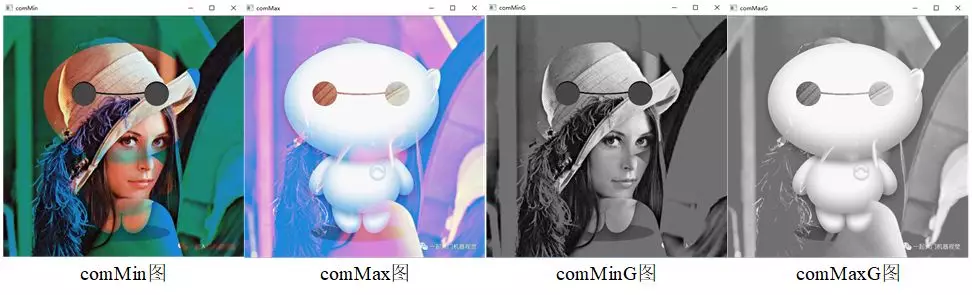

void cv::max(InputArray src1,InputArray src2,OutputArray dst)void cv::min(InputArray src1,InputArray src2,OutputArray dst)该函数的功能相对来说比较简单,就是比较图像每个像素的大小,按要求保留较大值或者较小值,最后生成新的图像。例如,第一张图像位置像素值为100,第二张图像位置像素值为10,那么输出图像位置像素值为100。在代码清单3-14中给出了这两个函数的代码实现过程以及运算结果,运算结果在图3-9、图3-10和图3-11中给出。这种比较运算主要用在对矩阵类型数据的处理,与掩模图像进行比较运算可以实现抠图或者选择通道的效果。

#include<iostream>#include<vector>#include<string>#include <opencv2/opencv.hpp>#include "opencv/highgui.h"using namespace std;using namespace cv;int main(int argc,char** argv) { cout<<"OpenCv Version: "<<CV_VERSION<<endl; float a[12]={1,2,3.3,4,5,9,5,7,8.2,9,10,2}; float b[12]={1,2.2,3,1,3,10,6,7,8,9.3,10,1}; Mat imga=Mat(3,4,CV_32FC1,a); Mat imgb=Mat(3,4,CV_32FC1,b); Mat imgas=Mat(2,3,CV_32FC2,a); Mat imgbs=Mat(2,3,CV_32FC2,b); //对两个单通道矩阵进行比较远算 Mat myMax,myMin; max(imga,imgb,myMax); min(imga,imgb,myMin); //对两个多通道矩阵进行比较运算 Mat myMaxs,myMins; max(imgas,imgbs,myMaxs); min(imgas,imgbs,myMins); //对两张彩色图像进行比较运算 Mat img0=imread("lena.png"); Mat img1=imread("noobcv.jpg"); if(img0.empty()||img1.empty()){ cout<<"请确认图像文件名称是否正确"<<endl; return -1; } Mat comMin,comMax; max(img0,img1,comMax); min(img0,img1,comMin); imshow("comMin",comMin); imshow("comMax",comMax); //与掩模进行比较运算 Mat src1=Mat::zeros(Size(512,512),CV_8UC3); Rect rect(100,100,300,300); src1(rect)=Scalar(255,255,255);//生成一个300*300的掩模 Mat comsrc1,comsrc2; min(img0,src1,comsrc1); imshow("comsrc1",comsrc1); Mat src2=Mat(512,512,CV_8UC3,Scalar(0,0,255));//生成一个显示红色的低通掩模 min(img0,src2,comsrc2); imshow("comsrc2",comsrc2); //对两张图片灰度图像进行比较运算 Mat img0G,img1G,comMinG,comMaxG; cvtColor(img0,img0G,COLOR_BGR2GRAY); cvtColor(img1,img1G,COLOR_BGR2GRAY); max(img0G,img1G,comMaxG); max(img0G,img1G,comMaxG); imshow("comMinG",comMinG); imshow("comMaxG",comMaxG); return 0;}

两张图像的逻辑运算

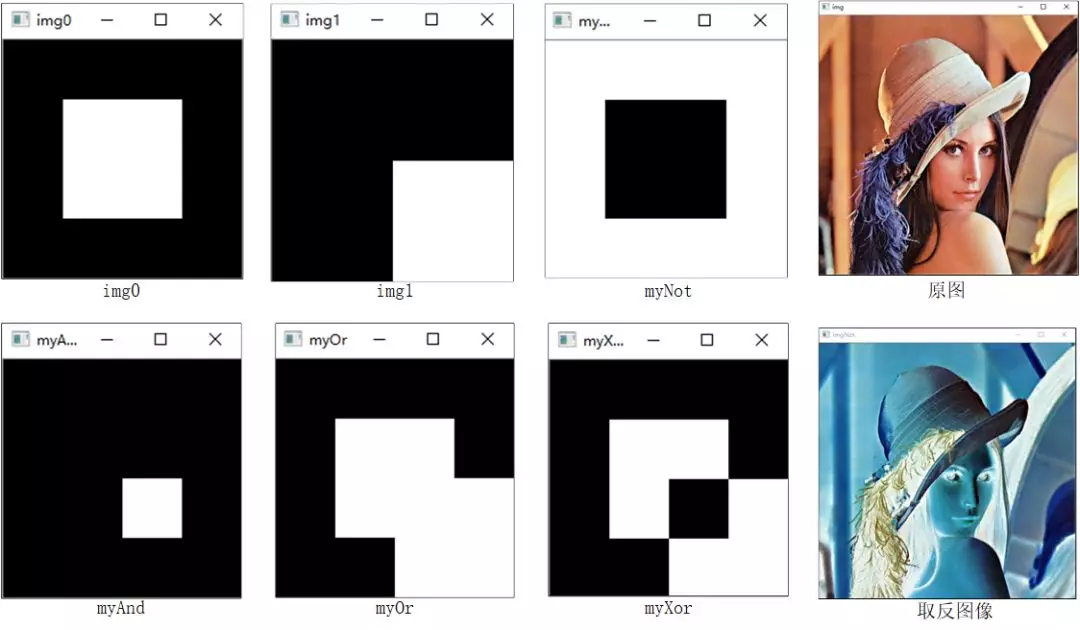

OpenCV 4针对两个图像像素之间的与、或、异或以及非运算提供了**bitwise_and()、bitwise_or()、bitwise_xor()和bitwise_not()**四个函数,在代码清单3-15中给出了这四个函数的函数原型。在了解函数用法之前,我们先了解一下图像像素逻辑运算的规则。图像像素间的逻辑运算与数字间的逻辑运算相同,具体规则在图3-12中给出。像素的非运算只能针对一个数值进行,因此在图3-12中对像素求非运算时对图像1的像素值进行非运算。如果像素取值只有0和1的话,那么图中的前4行数据正好对应了所有的运算规则,但是CV_8U类型的图像像素值从0取到255,此时的逻辑运算就需要将像素值转成二进制数后再进行,因为CV_8U类型是8位数据,因此对0求非是11111111,也就是255。在图3-12中最后一行数据中,像素值5对应的二进制为101,像素值6对应的二进制是110,因此与运算得100(4),或运算得111(7),异或运算得011(3),对像素值5进行非运算得11111010(250)。了解了像素的辑运算原理之后,我们再来看OpenCV 4中提供的辑运算函数的使用方法。

- //像素求与运算 - void cv::bitwise_and(InputArray src1, - InputArray src2, - OutputArray dst, - InputArray mask = noArray() - ) - //像素求或运算 - void cv::bitwise_or(InputArray src1, - InputArray src2, - OutputArray dst, - InputArray mask = noArray() - ) - //像素求异或运算 - void cv::bitwise_xor(InputArray src1, - InputArray src2, - OutputArray dst, - InputArray mask = noArray() - ) - //像素求非运算 - void cv::bitwise_not(InputArray src, - OutputArray dst, - InputArray mask = noArray() - )这几个函数都执行相应的逻辑运算,在进行逻辑计算时,一定要保证两个图像矩阵之间的尺寸、数据类型和通道数相同,多个通道进行逻辑运算时不同通道之间是独立进行的。为了更加直观的理解两个图像像素间的逻辑运算,在代码清单3-16中给出两个黑白图像像素逻辑运算的示例程序,最后运行结果在图3-13中给出。

1. #include <opencv2\opencv.hpp>2. #include <iostream>3. #include <vector>4. 5. using namespace std;6. using namespace cv;7. 8. int main()9. {10. Mat img = imread("lena.png");11. if (img.empty())12. {13. cout << "请确认图像文件名称是否正确" << endl;14. return -1;15. }16. //创建两个黑白图像17. Mat img0 = Mat::zeros(200, 200, CV_8UC1);18. Mat img1 = Mat::zeros(200, 200, CV_8UC1);19. Rect rect0(50, 50, 100, 100);20. img0(rect0) = Scalar(255);21. Rect rect1(100, 100, 100, 100);22. img1(rect1) = Scalar(255);23. imshow("img0", img0);24. imshow("img1", img1);25. 26. //进行逻辑运算27. Mat myAnd, myOr, myXor, myNot, imgNot;28. bitwise_not(img0, myNot);29. bitwise_and(img0, img1, myAnd);30. bitwise_or(img0, img1, myOr);31. bitwise_xor(img0, img1, myXor);32. bitwise_not(img, imgNot);33. imshow("myAnd", myAnd);34. imshow("myOr", myOr);35. imshow("myXor", myXor);36. imshow("myNot", myNot);37. imshow("img", img);38. imshow("imgNot", imgNot);39. waitKey(0);40. return 0;41. }

C++版本OpenCv教程(十四)图像二值化

Excerpt

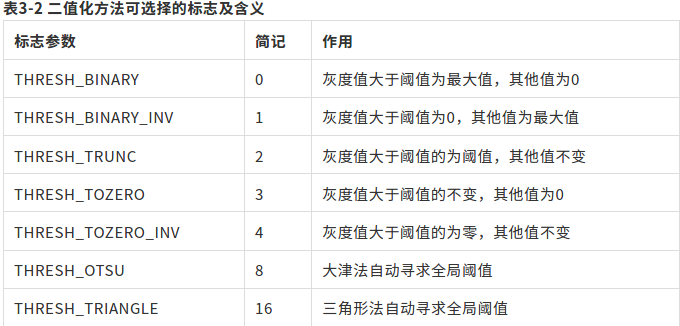

我们在上一节程序中生成了一张只有黑色和白色的图像,这种“非黑即白”的图像像素的灰度值无论在什么数据类型中只有最大值和最小值两种取值,因此称其为二值图像。二值图像色彩种类少,可以进行高度的压缩,节省存储空间,将非二值图像经过计算变成二值图像的过程称为图像的二值化。在OpenCV 4中提供了threshold()和adaptiveThreshold()两个函数用于实现图像的二值化,我们首先介绍threshold()函数的使用方法,该函数的函数原型在代码清单3-17中给出。double cv::threshol

我们在上一节程序中生成了一张只有黑色和白色的图像,这种“非黑即白”的图像像素的灰度值无论在什么数据类型中只有最大值和最小值两种取值,因此称其为二值图像。二值图像色彩种类少,可以进行高度的压缩,节省存储空间,将非二值图像经过计算变成二值图像的过程称为图像的二值化。在OpenCV 4中提供了threshold()和adaptiveThreshold()两个函数用于实现图像的二值化,我们首先介绍threshold()函数的使用方法,该函数的函数原型在代码清单3-17中给出。double cv::threshold(InputArray src,OutputArray dst,double thresh,double maxval,int type)该函数是众多二值化方法的集成,所有的方法都实现了一个功能,就是给定一个阈值,计算所有像素灰度值与这个阈值关系,得到最终的比较结果。函数中有些阈值比较方法输出结果的灰度值并不是二值的,而是具有一个取值范围,不过为了体现其最常用的功能,我们仍然称其为二值化函数或者阈值比较函数。函数的部分参数和返回值都是针对特定的算法才有用,但是即使不使用这些算法在使用函数时也需要明确的给出,不可缺省。函数的最后一个参数是选择二值化计算方法的标志,可以选择二值化方法以及控制哪些参数对函数的计算结果产生影响,该标志可以选择的范围及含义在表3-2中给出。

接下来将详细的介绍每种标志对应的二值化原理和需要的参数。

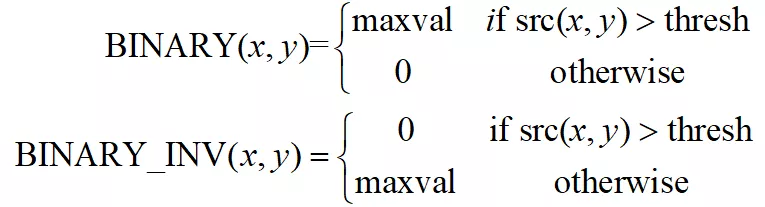

THRESH_BINARY和THRESH_BINARY_INV

这两个标志是相反的二值化方法,THRESH_BINARY是将灰度值与阈值(第三个参数thresh)进行比较,如果灰度值大于阈值就将灰度值改为函数中第四个参数maxval的值,否则将灰度值改成0。THRESH_BINARY_INV标志正好与这个过程相反,如果灰度值大于阈值就将灰度值改为0,否则将灰度值改为maxval的值。这两种标志的计算公式在式(3.7)中给出。

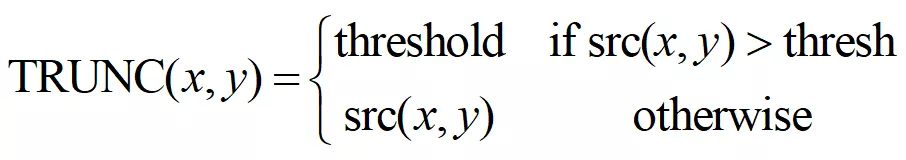

THRESH_TRUNC

这个标志相当于重新给图像的灰度值设定一个新的最大值,将大于新的最大值的灰度值全部重新设置为新的最大值,具体逻辑为将灰度值与阈值thresh进行比较,如果灰度值大于thresh则将灰度值改为thresh,否则保持灰度值不变。这种方法没有使用到函数中的第四个参数maxval的值,因此maxval的值对本方法不产生影响。这种标志的计算公式在式(3.8)中给出。

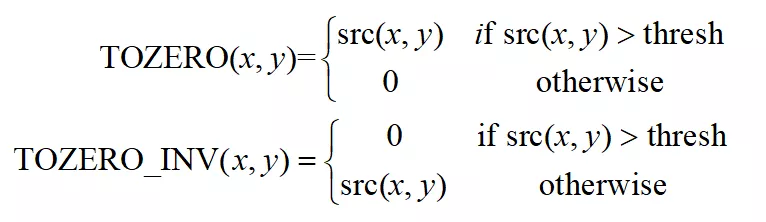

THRESH_TOZERO和THRESH_TOZERO_INV

这两个标志是相反的阈值比较方法, THRESH_TOZERO表示将灰度值与阈值thresh进行比较,如果灰度值大于thresh则将保持不变,否则将灰度值改为0。THRESH_TOZERO_INV方法与其相反,将灰度值与阈值thresh进行比较,如果灰度值小于等于thresh则将保持不变,否则将灰度值改为0。这种两种方法都没有使用到函数中的第四个参数maxval的值,因此maxval的值对本方法不产生影响。这两个标志的计算公式在式(3.9)中给出。

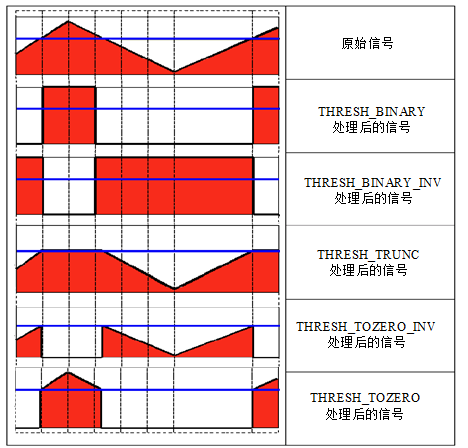

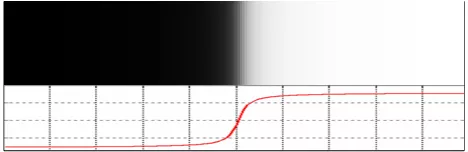

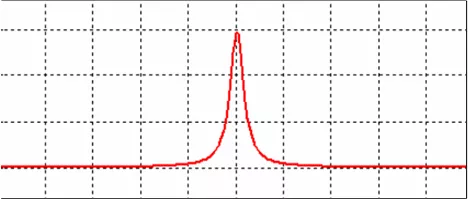

前面五种标志都支持输入多通道的图像,在计算时分别对每个通道进行阈值比较。为了更加直观的理解上述阈值比较方法,我们假设图像灰度值是连续变化的信号,将阈值比较方法比做滤波器,绘制连续信号通过滤波器后的信号形状,结果如图3-14所示,图中红线为设置的阈值,黑线为原始信号通过滤波器后的信号形状。

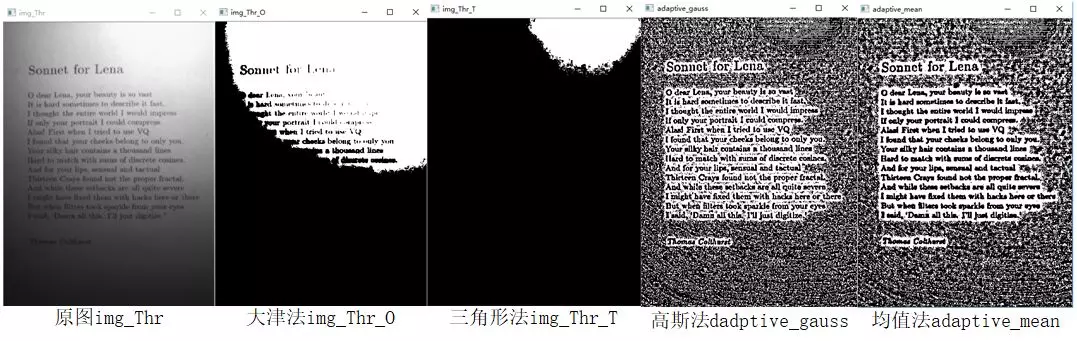

THRESH_OTSU和THRESH_TRIANGLE

这两种标志是获取阈值的方法,并不是阈值的比较方法的标志,这两个标志可以和前面5种标志一起使用,例如“THRESH_BINARY| THRESH_OTSU”。前面5种标志在调用函数时都需要人为的设置阈值,如果对图像不了解设置的阈值不合理,会对处理后的效果造成严重的影响,这两个标志分别表示利用**大津法(OTSU)和三角形法(TRIANGLE)**结合图像灰度值分布特性获取二值化的阈值,并将阈值以函数返回值的形式给出。因此如果函数最后一个参数设置了这两个标志中的任何一个,那么函数第三个参数thresh将由系统自动给出,但是在调用函数的时候仍然不能缺省,只是程序不会使用这个数值。需要注意的是,目前为止OpenCV 4中针对这两个标志只支持输入CV_8UC1类型的图像。

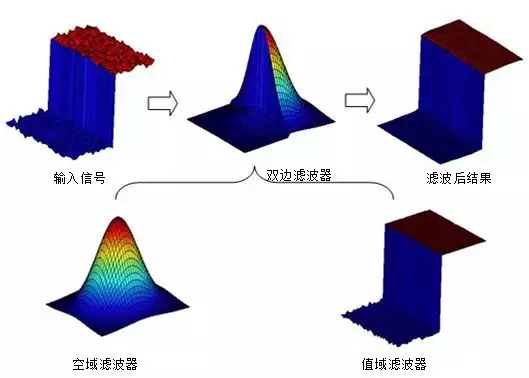

threshold()函数全局只使用一个阈值,在实际情况中由于光照不均匀以及阴影的存在,全局只有一个阈值会使得在阴影处的白色区域也会被函数二值化成黑色,因此adaptiveThreshold()函数提供了两种局部自适应阈值的二值化方法,该函数的函数原型在代码清单3-18中给出。

- void cv::adaptiveThreshold(InputArray src, - OutputArray dst, - double maxValue, - int adaptiveMethod, - int thresholdType, - int blockSize, - double C - )该函数将灰度图像转换成二值图像,通过均值法和高斯法自适应的计算blockSize* blockSize邻域内的阈值,之后进行二值化,其原理与前面的相同,这里就不再赘述。

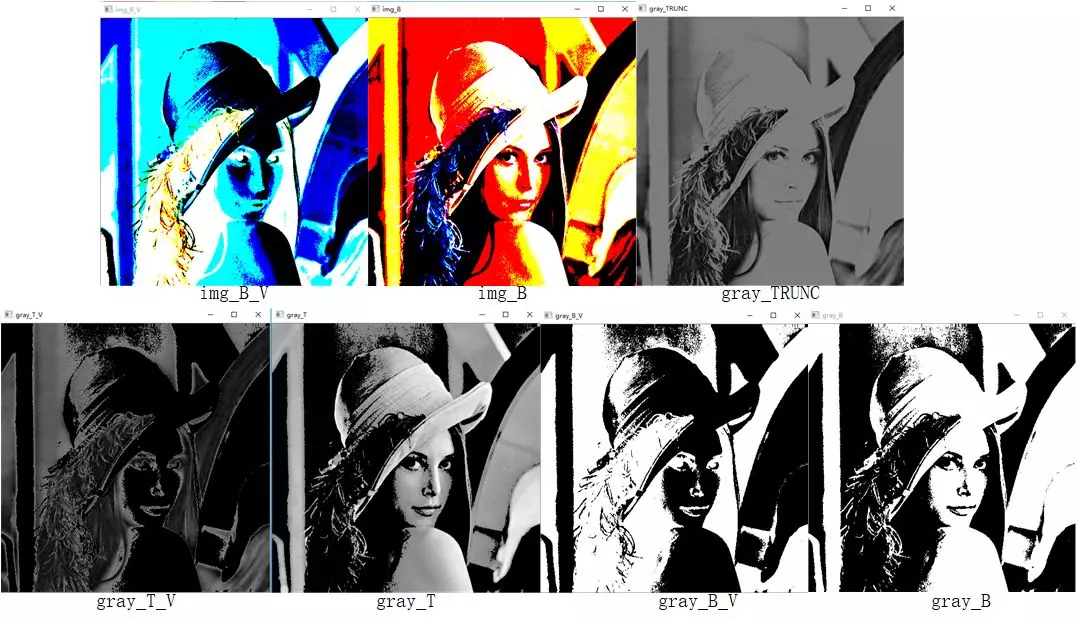

为了直观的体会到图像二值化的效果,在代码清单3-19中给出了分别对彩色图像和灰度图像进行二值化的示例程序,程序运行结果在图3-15、图3-16中给出。

#include<iostream>#include<vector>#include<string>#include <opencv2/opencv.hpp>#include "opencv/highgui.h"using namespace std;using namespace cv;int main(int argc,char** argv) { cout<<"OpenCv Version: "<<CV_VERSION<<endl; Mat img=imread("699342568.jpg"); if(img.empty()){ cout<<"请确认输入的图片的路径是否正确"<<endl; return -1; } Mat gray; cvtColor(img,gray,COLOR_BGR2GRAY); Mat img_B,img_B_V,gray_B,gray_B_V,gray_T,gray_T_V,gray_TRUNC; //彩色图像二值化 threshold(img,img_B,125,255,THRESH_BINARY); threshold(img,img_B_V,125,255,THRESH_BINARY_INV); imshow("img_B",img_B); imshow("img_B_V",img_B_V); //灰度图像二值化 threshold(gray,gray_B,125,255,THRESH_BINARY); threshold(gray,gray_B_V,125,255,THRESH_BINARY_INV); imshow("gray_B",gray_B); imshow("gray_B_V",gray_B_V); //灰度图像TOZERO变换 threshold(gray,gray_T,125,255,THRESH_TOZERO); threshold(gray,gray_T_V,125,255,THRESH_TOZERO_INV); imshow("gray_T",gray_T); imshow("gray_T_V",gray_T_V); //灰度图像TRUNC变换 threshold(gray,gray_TRUNC,125,255,THRESH_TRUNC); imshow("gray_TRUNC",gray_TRUNC); //灰度图像大津法和三角法二值化 Mat img_Thr=imread("threshold.jpg",IMREAD_GRAYSCALE); Mat img_Thr_0,img_Thr_T; threshold(img_Thr,img_Thr_0,100,255,THRESH_BINARY|THRESH_OTSU); threshold(img_Thr,img_Thr_T,125,255,THRESH_BINARY|THRESH_TRIANGLE); imshow("img_Thr",img_Thr); imshow("img_Thr_0",img_Thr_0); imshow("img_Thr_T",img_Thr_T); //灰度图像自适应二值化 Mat adaptive_mean,adaptive_gauss; adaptiveThreshold(img_Thr,adaptive_mean,255,ADAPTIVE_THRESH_MEAN_C,THRESH_BINARY,55,0); adaptiveThreshold(img_Thr,adaptive_gauss,255,ADAPTIVE_THRESH_GAUSSIAN_C,THRESH_BINARY,55,0); imshow("adaptive_mean",adaptive_mean); imshow("adaptive_gauss",adaptive_gauss); waitKey(0); return 0;}

C++版本OpenCv教程(十五)LUT查找表

Excerpt

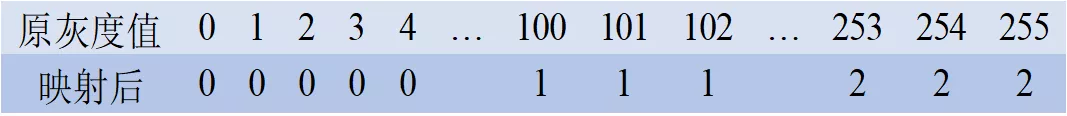

前面介绍的阈值比较方法中只有一个阈值,如果需要与多个阈值进行比较,就需要用到显示查找表(Look-Up-Table,LUT)。LUT查找表简单来说就是一个像素灰度值的映射表,它以像素灰度值作为索引,以灰度值映射后的数值作为表中的内容。例如我们有一个长度为5的存放字符的数组,LUT查找表就是通过这个数组将0映射成a,将1映射成b,依次类推,其映射关系为。在OpenCV 4中提供了LUT()函数用于实现图像像素灰度值的LUT查找表功能,在代码清单3-20中给出了该函数的原型。 - void cv::LUT(

前面介绍的阈值比较方法中只有一个阈值,如果需要与多个阈值进行比较,就需要用到显示查找表(Look-Up-Table,LUT)。LUT查找表简单来说就是一个像素灰度值的映射表,它以像素灰度值作为索引,以灰度值映射后的数值作为表中的内容。例如我们有一个长度为5的存放字符的数组,LUT查找表就是通过这个数组将0映射成a,将1映射成b,依次类推,其映射关系为。在OpenCV 4中提供了LUT()函数用于实现图像像素灰度值的LUT查找表功能,在代码清单3-20中给出了该函数的原型。

- void cv::LUT(InputArray src, - InputArray lut, - OutputArray dst - )该函数的第一个输入参数要求的数据类型必须是CV_8U类型,但是可以是多通道的图像矩阵。第二个参数根据其参数说明可以知道输入量是一个1×256的矩阵,其中存放着每个像素灰度值映射后的数值,其形式如图3-17所示。如果第二个参数是单通道,则输入变量中的每个通道都按照一个LUT查找表进行映射;如果第二个参数是多通道,则输入变量中的第i个通道按照第二个参数的第i个通道LUT查找表进行映射。与之前的函数不同,函数输出图像的数据类型不与原图像的数据类型保持一致,而是和LUT查找表的数据类型保持一致,这是因为将原灰度值映射到新的空间中,因此需要与新空间中的数据类型保持一致。

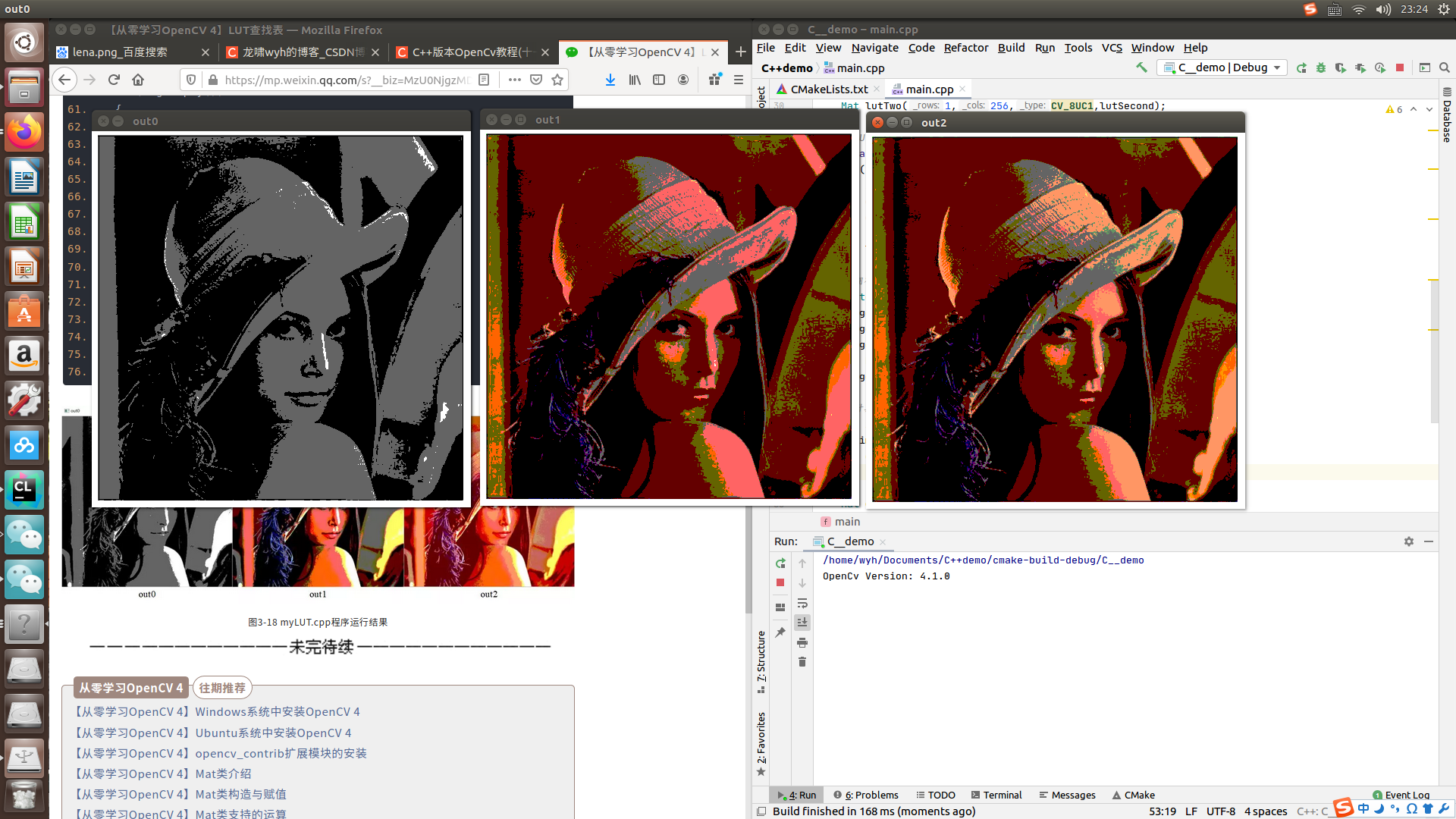

为了体会LUT查找表处理图像后的效果,在代码清单3-21中给出通过LUT()函数将灰度图像和彩色图像分别处理的示例程序,程序中分别应用单通道和三通道的查找表对彩色图像进行映射,最终结果在图3-18中给出。

#include<iostream>#include<vector>#include<string>#include <opencv2/opencv.hpp>#include "opencv/highgui.h"using namespace std;using namespace cv;int main(int argc,char** argv) { cout<<"OpenCv Version: "<<CV_VERSION<<endl; //LUT查找表第一层 uchar lutFirst[256]; for(int i=0;i<256;++i){ if(i<=100)lutFirst[i]=0; else if(i>100&&i<=200)lutFirst[i]=100; else lutFirst[i]=255; } Mat lutOne(1,256,CV_8UC1,lutFirst); //LUT查找表第二层 uchar lutSecond[256]; for(int i=0;i<256;++i){ if(i<=100)lutSecond[i]=0; else if(i>100&&i<=150)lutSecond[i]=100; else if(i>150&&i<=200)lutSecond[i]=150; else lutSecond[i]=255; } Mat lutTwo(1,256,CV_8UC1,lutSecond); //LUT查找表第三层 uchar lutThird[256]; for(int i=0;i<256;++i){ if(i<=100)lutThird[i]=0; else if(i>100&&i<=200)lutThird[i]=100; else lutThird[i]=255; } Mat lutThree(1,256,CV_8UC1,lutThird); //拥有三通道的LUT查找表矩阵 vector<Mat>mergeMats; mergeMats.push_back(lutOne); mergeMats.push_back(lutTwo); mergeMats.push_back(lutThree); Mat LutTree; merge(mergeMats,LutTree); //计算图像的查找表 Mat img=imread("lena.jpeg"); if(img.empty()){ cout<<"请确认输入的图片路径是否正确"<<endl; return -1; } Mat gray,out0,out1,out2; cvtColor(img,gray,COLOR_BGR2GRAY); LUT(gray,lutOne,out0); LUT(img,lutOne,out1); LUT(img,LutTree,out2); imshow("out0",out0); imshow("out1",out1); imshow("out2",out2); waitKey(0); return 0;}

C++版本OpenCv教程(十六)图像仿射变换

Excerpt

介绍完图像的缩放和翻转后,接下来将要介绍图像的旋转,但是在OpenCV 4中并没有专门用于图像旋转的函数,而是通过图像的仿射变换实现图像的旋转。实现图像的旋转首先需要确定旋转角度和旋转中心,之后 确定旋转矩阵,最终通过仿射变换实现图像旋转。针对这个流程,OpenCV 4提供了getRotationMatrix2D()函数用于计算旋转矩阵和warpAffine()函数用于实现图像的仿射变换。首先介绍计算旋转矩阵getRotationMatrix2D()函数,该函数的函数原型在代码清单3-31中给出。Mat

介绍完图像的缩放和翻转后,接下来将要介绍图像的旋转,但是在OpenCV 4中并没有专门用于图像旋转的函数,而是通过图像的仿射变换实现图像的旋转。实现图像的旋转首先需要确定旋转角度和旋转中心,之后 确定旋转矩阵,最终通过仿射变换实现图像旋转。针对这个流程,OpenCV 4提供了getRotationMatrix2D()函数用于计算旋转矩阵和warpAffine()函数用于实现图像的仿射变换。首先介绍计算旋转矩阵getRotationMatrix2D()函数,该函数的函数原型在代码清单3-31中给出。

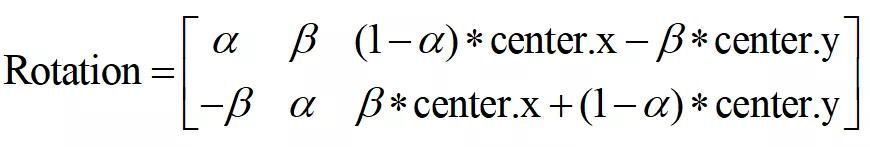

Mat cv::getRotationMatrix2D (Point2f center,double angle,double scale)该函数输入旋转角度和旋转中心,返回图像旋转矩阵,该返回值得数据类型为Mat类,是一个2×3的矩阵。如果我们已知图像旋转矩阵,可以自己生成旋转矩阵而不调用该函数。该函数生成的旋转矩阵与旋转角度和旋转中心的关系如式(3.11)所示。

其中:

warpAffine()函数进行仿射变换,就可以实现图像的旋转,在代码清单3-32中给出了warpAffine()函数的函数原型。

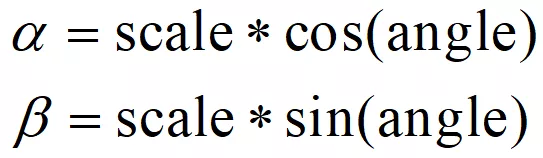

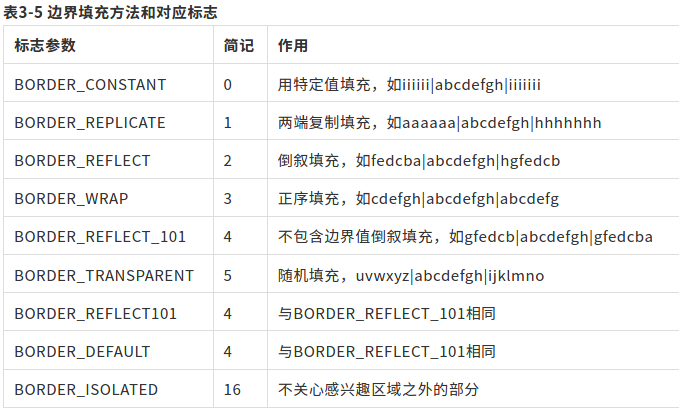

void cv::warpAffine(InputArray src, OutputArray dst, InputArray M, Size dsize, int flags = INTER_LINEAR, int borderMode = BORDER_CONSTANT, const Scalar& borderValue = Scalar())该函数拥有多个参数,但是多数都与前面介绍的图像尺寸变换具有相同的含义。函数中第三个参数为前面求取的图像旋转矩阵,第四个参数是输出图像的尺寸。函数第五个参数是仿射变换插值方法的标志,这里相比于图像尺寸变换多增加了两个类型,可以与其他插值方法一起使用,这两种类型在表3-4中给出。函数第六个参数为像素边界外推方法的标志,其可以的标志和对应的方法在表3-5中给出。第七个参数是外推标志选择BORDER_CONSTANT时的定值,默认情况下为0。

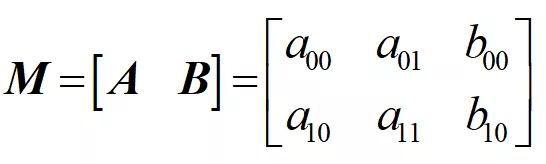

在了解函数每个参数的含义之后,为了更好的理解函数作用,需要介绍一下仿射变换的概念。仿射变换就是图像的旋转、平移和缩放操作的统称,可以表示为线性变换和平移变换的叠加。仿射变换的数学表示是先乘以一个线形变换矩阵再加上一个平移向量,其中线性变换矩阵为2×2的矩阵,平移向量为2×1的向量,至此你可能理解了为什么函数需要输入一个2×3的变换矩阵。假设我们存在一个线性变换矩阵和平移矩阵,两者与输入的矩阵之间的关系如式(3.13)中所示。

根据旋转矩阵和平移矩阵以及图像像素值,仿射变换的数学原理可以用式(3.14)来表示。

仿射变换又称为三点变换,如果知道变换前后两张图像中三个像素点坐标的对应关系,就可以求得仿射变换中的变换矩阵,OpenCV 4提供了利用三个对应像素点来确定矩阵的函数getAffineTransform(),该函数的函数原型在代码清单3-33中给出。

Mat cv::getAffineTransform(const Point2f src[],const Point2f dst[])该函数两个输入量都是存放浮点坐标的数组,在生成数组的时候像素点的输入顺序无关,但是需要保证像素点的对应关系,函数的返回值是一个2×3的变换矩阵。

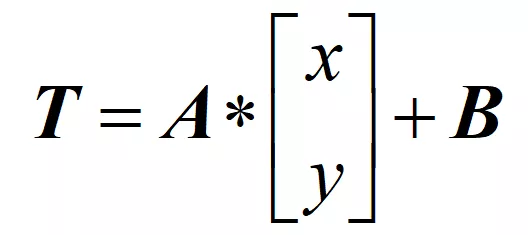

有了前面变换矩阵的求取,就可以利用warpAffine()函数实现矩阵的仿射变换,我们在代码清单3-34的例程中实现了图像的旋转以及图像三点映射的仿射变换,最终结果在图3-23中给出。

#include<iostream>#include<vector>#include<string>#include <opencv2/opencv.hpp>#include "opencv/highgui.h"using namespace std;using namespace cv;int main(int argc,char** argv) { cout<<"OpenCv Version: "<<CV_VERSION<<endl; Mat img=imread("699342568.jpg"); if(img.empty()){ cout<<"请确认输入的图像;路径是否正确"<<endl; return -1; } Mat img_; resize(img,img_,Size(img.rows/2,img.cols/2)); imshow("src",img_); Mat rotation0,rotation1,img_warp0,img_warp1; double angle=30;//设置图像旋转的角度 Size dst_size(img_.rows,img_.cols);//设置输出图像的尺寸 Point2f center(img_.rows/2.0,img_.cols/2.0);//设置图像的旋转中心 rotation0=getRotationMatrix2D(center,angle,1);//计算放射变换矩阵 warpAffine(img_,img_warp0,rotation0,dst_size);//进行仿射变换 imshow("img_warp0",img_warp0); //根据定义的三个点进行仿射变换 Point2f src_points[3]; Point2f dst_points[3]; src_points[0]=Point2f(0,0);//原始图像的三个点 src_points[1]=Point2f(0,(float)(img_.cols-1)); src_points[2]=Point2f((float)(img_.rows-1),(float)(img_.cols-1)); //仿射变换后图像中的三个点 dst_points[0]=Point2f((float)(img_.rows)*0.11,(float)(img_.cols)*0.20); dst_points[1]=Point2f((float)(img_.rows)*0.15,(float)(img_.cols)*0.70); dst_points[0]=Point2f((float)(img_.rows)*0.81,(float)(img_.cols)*0.85); rotation1=getAffineTransform(src_points,dst_points);//根据对应点求取放射变换矩阵 warpAffine(img_,img_warp1,rotation1,dst_size);//进行放射变换 imshow("img_warp1",img_warp1); waitKey(0); return 0;}

C++版本OpenCv教程(十七)图像透视变换

Excerpt

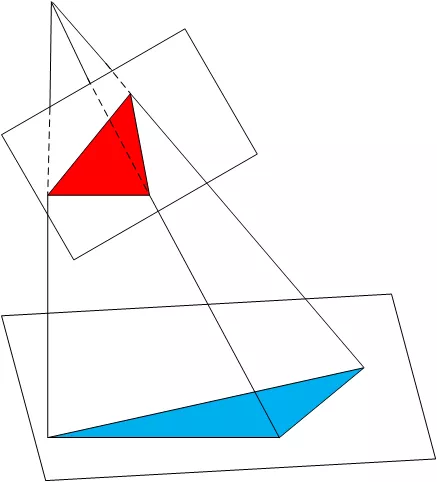

本小节将介绍图像的另一种变换——透视变换。透视变换是按照物体成像投影规律进行变换,即将物体重新投影到新的成像平面,示意图如图3-24所示。透视变换常用于机器人视觉导航研究中,由于相机视场与地面存在倾斜角使得物体成像产生畸变,通常通过透视变换实现对物体图像的校正。透视变换中,透视前的图像和透视后的图像之间的变换关系可以用一个3×3的变换矩阵表示,该矩阵可以通过两张图像中四个对应点的坐标求取,因此透视变换又称作“四点变换”。与仿射变换一样,OpenCV 4中提供了根据四个对应点求取变换矩阵的getPerspec

本小节将介绍图像的另一种变换——透视变换。透视变换是按照物体成像投影规律进行变换,即将物体重新投影到新的成像平面,示意图如图3-24所示。透视变换常用于机器人视觉导航研究中,由于相机视场与地面存在倾斜角使得物体成像产生畸变,通常通过透视变换实现对物体图像的校正。透视变换中,透视前的图像和透视后的图像之间的变换关系可以用一个3×3的变换矩阵表示,该矩阵可以通过两张图像中四个对应点的坐标求取,因此透视变换又称作“四点变换”。与仿射变换一样,OpenCV 4中提供了根据四个对应点求取变换矩阵的getPerspectiveTransform()函数和进行透视变换的warpPerspective()函数,接下来将介绍这两个函数的使用方法,两个函数的函数原型在代码清单3-35和代码清单3-36中给出。

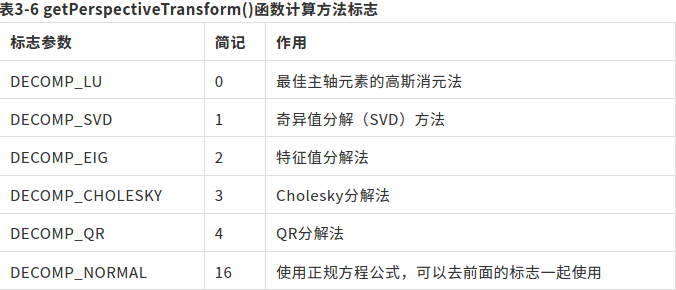

Mat cv::getPerspectiveTransform (const Point2f src[], const Point2f dst[], int solveMethod = DECOMP_LU )该函数两个输入量都是存放浮点坐标的数组,在生成数组的时候像素点的输入顺序无关,但是需要注意像素点的对应关系,函数的返回值是一个3×3的变换矩阵。函数中最后一个参数是根据四个对应点坐标计算透视变换矩阵方法的选择标志,其可以选择的参数标志在表3-6中给出,默认情况下选择的是最佳主轴元素的高斯消元法DECOMP_LU。

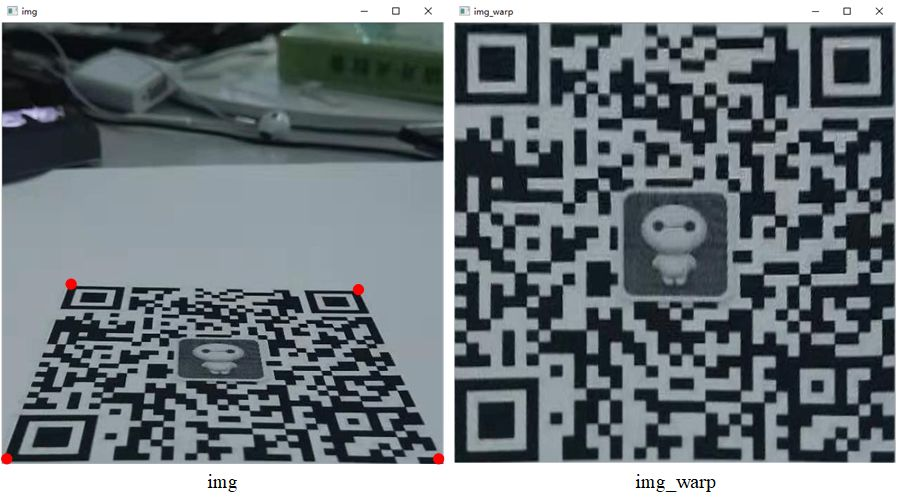

void cv::warpPerspective(InputArray src, OutputArray dst, InputArray M, Size dsize, int flags = INTER_LINEAR, int borderMode = BORDER_CONSTANT, const Scalar & borderValue = Scalar() )该函数所有参数含义都与warpAffine()函数的参数含义相同,这里不再进行赘述。为了说明该函数在实际应用中的作用,在代码清单3-37中给出了将相机视线不垂直于二维码平面拍摄的图像经过透视变换变成相机视线垂直于二维码平面拍摄的图像。在图3-25中给出了相机拍摄到的二维码图像和经过程序透视变换后的图像。为了寻找透视变换关系,我们需要寻找拍摄图像中二维码四个角点的像素坐标和透视变换后角点对应的理想坐标。本程序中,我们事先通过Image Watch插件查看了拍摄图像二维码四个角点的坐标,并希望透视变换后二维码可以充满全部的图像,因此我们在程序中手动输入四对对应点的像素坐标。但是在实际工程中,二维码的角点坐标可以通过角点检测的方式获取,具体方式我们将在后面介绍。

#include<iostream>#include<vector>#include<string>#include <opencv2/opencv.hpp>#include "opencv/highgui.h"using namespace std;using namespace cv;int main(int argc,char** argv) { cout<<"OpenCv Version: "<<CV_VERSION<<endl; Mat img=imread("noobcvqr.png"); if(img.empty()){ cout << "请确认图像文件名称是否正确" << endl; return -1; } Point2f src_points[4]; Point2f dst_points[4]; //通过Image Watch查看的二维码四个角点坐标 src_points[0]=Point2f(94.0, 374.0); src_points[1]=Point2f(507.0, 380.0); src_points[2]=Point2f(1.0, 623.0); src_points[3]=Point2f(627.0, 627.0); //期望透视变换后二维码四个角点的坐标 dst_points[0]=Point2f(0.0, 0.0); dst_points[1]=Point2f(627.0, 0.0); dst_points[2]=Point2f(0.0, 627.0); dst_points[3]=Point2f(627.0, 627.0); Mat rotation,img_warp; rotation=getPerspectiveTransform(src_points,dst_points); warpPerspective(img,img_warp,rotation,img.size()); imshow("img",img); imshow("img_warp",img_warp); waitKey(0); return 0;}

C++版本OpenCv教程(十八)极坐标变换

Excerpt

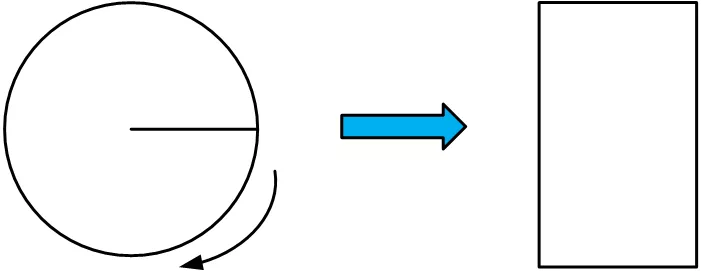

极坐标变换就是将图像在直角坐标系与极坐标系中互相变换,形式如图3-26所示,它可以将一圆形图像变换成一个矩形图像,常用于处理钟表、圆盘等图像。圆形图案边缘上的文字经过及坐标变换后可以垂直的排列在新图像的边缘,便于对文字的识别和检测。OpenCV 4中提供了warpPolar()函数用于实现图像的极坐标变换,该函数的函数原型在代码清单3-38中给出。void cv::warpPolar(InputArray src, OutputArray dst,

极坐标变换就是将图像在直角坐标系与极坐标系中互相变换,形式如图3-26所示,它可以将一圆形图像变换成一个矩形图像,常用于处理钟表、圆盘等图像。圆形图案边缘上的文字经过及坐标变换后可以垂直的排列在新图像的边缘,便于对文字的识别和检测。

OpenCV 4中提供了warpPolar()函数用于实现图像的极坐标变换,该函数的函数原型在代码清单3-38中给出。

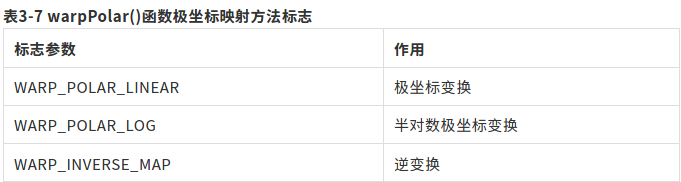

void cv::warpPolar(InputArray src, OutputArray dst, Size dsize, Point2f center, double maxRadius, int flags )该函数实现了图像极坐标变换和半对数极坐标变换。函数第一个参数是需要进行极坐标变换的原始图像,该图像可以是灰度图像也可以是彩色图像。第二个参数是变换后的输出图像,与输入图像具有相同的数据类型和通道数。第三个参数是变换后图像的大小。第四个参数是极坐标变换时极坐标原点在原图像中的位置,该参数同样适用于逆变换中。第五个参数是变换时边界圆的半径,它也决定了逆变换时的比例参数。最后一个参数是变换方法的选择标志,插值方法在表3-3中给出,极坐标映射方法在表3-7给出,两个方法之间通过“+”或者“|”号进行连接。

该函数可以对图像进行极坐标正变换也可以进行逆变换,关键在于最后一个参数如何选择。为了了解图像极坐标变换的功能以及相关函数的使用,在代码清单3-39给出了对表盘图像进行极坐标正变换和逆变换的示例程序。程序中选取表盘的中心作为极坐标的原点,变换的结果在图3-27给出。

#include<iostream>#include<vector>#include<string>#include <opencv2/opencv.hpp>#include "opencv/highgui.h"using namespace std;using namespace cv;int main(int argc,char** argv) { cout<<"OpenCv Version: "<<CV_VERSION<<endl; Mat img=imread("noobcvqr.png"); if(img.empty()){ cout << "请确认图像文件名称是否正确" << endl; return -1; } Mat img1,img2; Point2f center=Point2f(img.cols/2,img.rows/2);//极坐标在图像中的原点 //正极坐标变换 warpPolar(img,img1,Size(300,600),center,center.x,INTER_LINEAR+WARP_POLAR_LINEAR); //逆极坐标变换 warpPolar(img1,img2,Size(img.rows,img.cols),center,center.x,INTER_LINEAR+WARP_POLAR_LINEAR+WARP_INVERSE_MAP); imshow("原表盘图",img); imshow("表盘极坐标变换结果",img1); imshow("逆变换结果",img2); waitKey(0); return 0;}

C++版本OpenCv教程(十九)图像金字塔

Excerpt

高斯金字塔构建图像的高斯金字塔是解决尺度不确定性的一种常用方法。高斯金字塔是指通过下采样不断的将图像的尺寸缩小,进而在金字塔中包含多个尺度的图像,高斯金字塔的形式如图3-30所示,一般情况下,高斯金字塔的最底层为图像的原图,每上一层就会通过下采样缩小一次图像的尺寸,通常情况尺寸会缩小为原来的一半,但是如果有特殊需求,缩小的尺寸也可以根据实际情况进行调整。由于每次图像的尺寸都缩小为原来的一半,图像尺缩小的速度非常快,因此常见高斯金字塔的层数为3到6层。OpenCV 4中提供了**pyrDown()**函数专

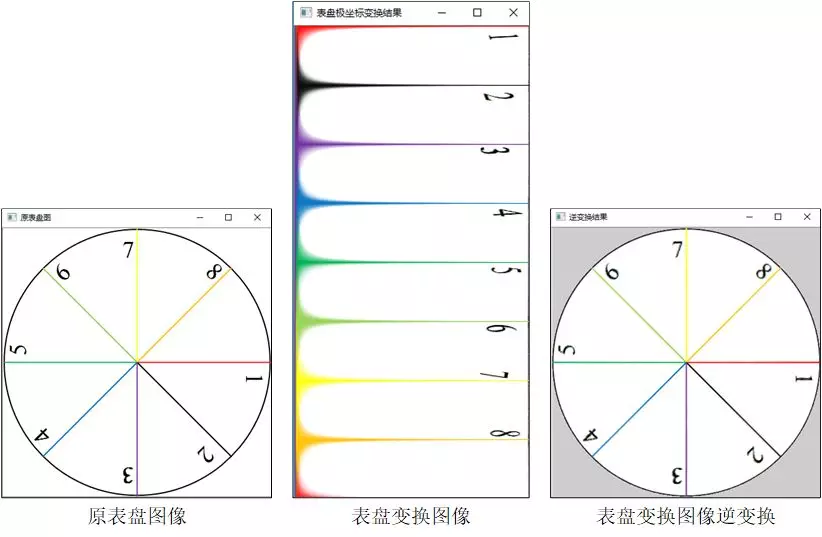

高斯金字塔

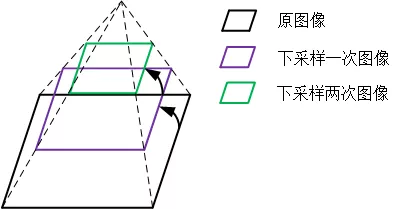

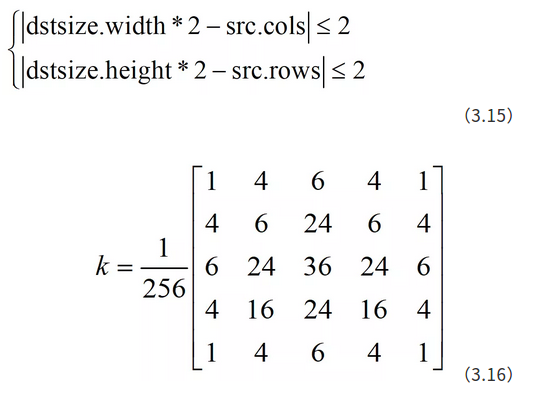

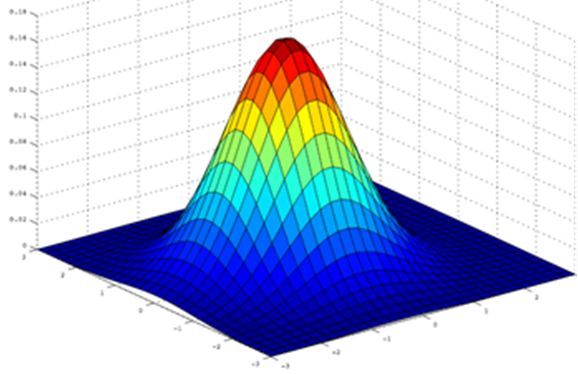

构建图像的高斯金字塔是解决尺度不确定性的一种常用方法。高斯金字塔是指通过下采样不断的将图像的尺寸缩小,进而在金字塔中包含多个尺度的图像,高斯金字塔的形式如图3-30所示,一般情况下,高斯金字塔的最底层为图像的原图,每上一层就会通过下采样缩小一次图像的尺寸,通常情况尺寸会缩小为原来的一半,但是如果有特殊需求,缩小的尺寸也可以根据实际情况进行调整。由于每次图像的尺寸都缩小为原来的一半,图像尺缩小的速度非常快,因此常见高斯金字塔的层数为3到6层。OpenCV 4中提供了**pyrDown()**函数专门用于图像的下采样计算,便于构建图像的高斯金字塔,该函数的函数原型在代码清单3-51中给出。

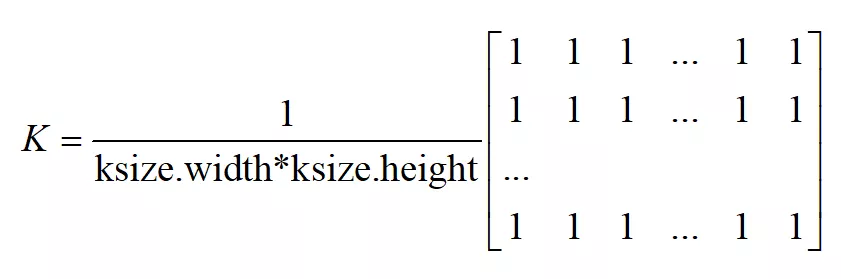

void cv::pyrDown(InputArray src, OutputArray dst, const Size & dstsize = Size(), int borderType = BORDER_DEFAULT )该函数用于实现图像模糊并对其进行下采样,默认状态下函数输出的图像的尺寸为输入图像尺寸的一半,但是也可以通过dstsize参数来设置输出图像的大小,需要注意的是无论输出尺寸为多少都应满足式(3.15)中的条件。该函数首先将原图像与内核矩阵进行卷积,内核矩阵如式(3.16)所示,之后通过不使用偶数行和列的方式对图像进行下采样,最终实现尺寸缩小的下采样图像。

该函数的功能与resize()函数将图像尺寸缩小一样,但是使用的内部算法不同,对于函数的具体使用方式以及如何构建图像金字塔在代码清单3-53中给出。

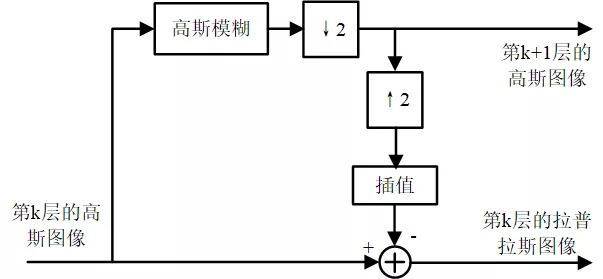

拉普拉斯金字塔

拉普拉斯金字塔与高斯金字塔正好相反,高斯金字塔通过底层图像构建上层图像,而拉普拉斯是通过上层小尺寸的图像构建下层大尺寸的图像。拉普拉斯金字塔具有预测残差的作用,需要与高斯金字塔联合一起使用,假设我们已经有一个高斯图像金字塔,对于其中的第i层图像(高斯金字塔最下面为第0层),首先通过下采样得到一尺寸缩小一半的图像,即高斯金字塔中的第i+1层或者不在高斯金字塔中,之后对这张图像再进行上采样,将图像尺寸恢复到第i层图像的大小,最后求取高斯金字塔第i层图像与经过上采样后得到的图像的差值图像,这个差值图像就是拉普拉斯金字塔的第i层图像,整个过程的流程如图3-31所示。

void cv::pyrUp(InputArray src, OutputArray dst, const Size & dstsize = Size(), int borderType = BORDER_DEFAULT)该函数所有参数的含义与pyrDown()函数中相同,使用方式也与其一致,因此这里不再进行赘述。

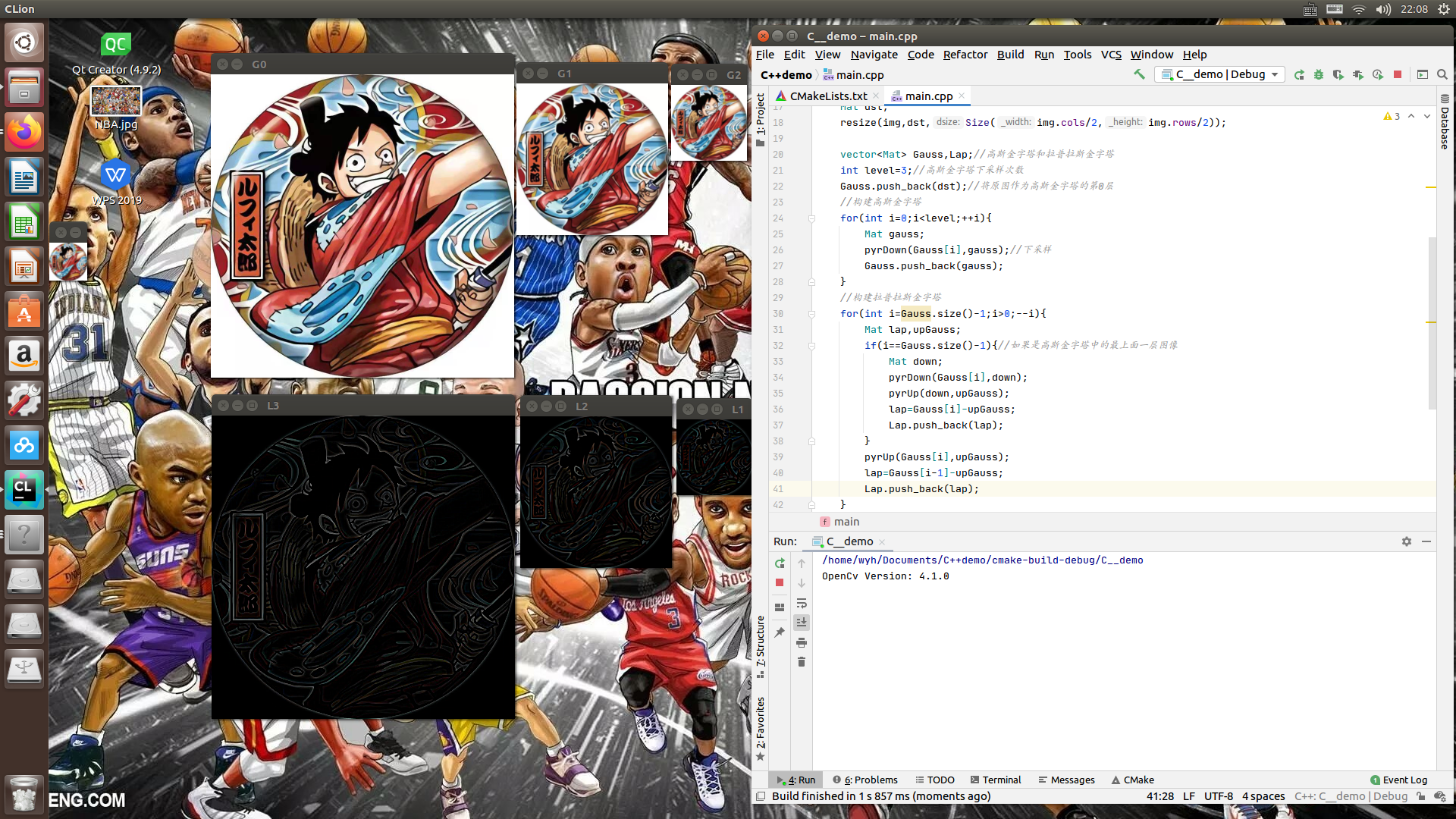

为了了解下采样函数pyrDown()和上采样函数pyrUp()的使用方式,以及高斯金字塔和拉普拉斯金字塔的构建过程,我们在代码清单3-53中给出构建高斯金字塔和拉普拉斯金字塔的示例程序。在例程中我们将原始图像作为高斯金字塔的第0层,之后依次构建高斯金字塔的每一层。完成高斯金字塔的构建之后,我们从上到下取出高斯金字塔中的每一层图像,如果取出的图像是高斯金字塔的最上面一层,则先将其下采样再上采样,之后求取从高斯金字塔中取出的图像与上采样后的图像的差值图像作为拉普拉斯金字塔的最上面一层。如果从高斯金字塔中取出的第i层不是最上面一层,则直接对高斯金字塔中第i+1层图像进行上采样,并计算高斯金字塔第i层图像与上采样结果的差值图像,将差值图像作为拉普拉斯金字塔的第i层。该例程最终的运行结果在图3-32、图3-33中给出。

#include<iostream>#include<vector>#include<string>#include <opencv2/opencv.hpp>#include "opencv/highgui.h"using namespace std;using namespace cv;int main(int argc,char** argv) { cout<<"OpenCv Version: "<<CV_VERSION<<endl; Mat img=imread("699342568.jpg"); if(img.empty()){ cout<<"请确认输入的图片路径是否正确"<<endl; return -1; } Mat dst; resize(img,dst,Size(img.cols/2,img.rows/2)); vector<Mat> Gauss,Lap;//高斯金字塔和拉普拉斯金字塔 int level=3;//高斯金字塔下采样次数 Gauss.push_back(dst);//将原图作为高斯金字塔的第0层 //构建高斯金字塔 for(int i=0;i<level;++i){ Mat gauss; pyrDown(Gauss[i],gauss);//下采样 Gauss.push_back(gauss); } //构建拉普拉斯金字塔 for(int i=Gauss.size()-1;i>0;--i){ Mat lap,upGauss; if(i==Gauss.size()-1){//如果是高斯金字塔中的最上面一层图像 Mat down; pyrDown(Gauss[i],down);//下采样 pyrUp(down,upGauss);//上采样 lap=Gauss[i]-upGauss; Lap.push_back(lap); } pyrUp(Gauss[i],upGauss); lap=Gauss[i-1]-upGauss; Lap.push_back(lap); } //查看两个金字塔中的图像 for(int i=0;i<Gauss.size();++i){ string name=to_string(i); imshow("G"+name,Gauss[i]); imshow("L"+name,Lap[i]); } waitKey(0); return 0;}

C++版本OpenCv教程(二十)图像直方图绘制

Excerpt

图像直方图是图像处理中非常重要的像素统计结果,图像直方图不再表征任何的图像纹理信息,而是对图像像素的统计。由于同一物体无论是旋转还是平移在图像中都具有相同的灰度值,因此直方图具有平移不变性、放缩不变性等优点,因此可以用来查看图像整体的变化形式,例如图像是否过暗、图像像素灰度值主要集中在哪些范围等,在特定的条件下也可以利用图像直方图进行图像的识别,例如对数字的识别。图像直方图简单来说就是统计图像中每个灰度值的个数,之后将图像灰度值作为横轴,以灰度值个数或者灰度值所占比率作为纵轴绘制的统计图。通过直方图可以看

图像直方图是图像处理中非常重要的像素统计结果,图像直方图不再表征任何的图像纹理信息,而是对图像像素的统计。由于同一物体无论是旋转还是平移在图像中都具有相同的灰度值,因此直方图具有平移不变性、放缩不变性等优点,因此可以用来查看图像整体的变化形式,例如图像是否过暗、图像像素灰度值主要集中在哪些范围等,在特定的条件下也可以利用图像直方图进行图像的识别,例如对数字的识别。

图像直方图简单来说就是统计图像中每个灰度值的个数,之后将图像灰度值作为横轴,以灰度值个数或者灰度值所占比率作为纵轴绘制的统计图。通过直方图可以看出图像中哪些灰度值数目较多,哪些较少,可以通过一定的方法将灰度值较为集中的区域映射到较为稀疏的区域,从而使得图像在像素灰度值上分布更加符合期望状态。通常情况下,像素灰度值代表亮暗程度,因此通过图像直方图可以分析图像亮暗对比度,并调整图像的亮暗程度。

在OpenCV 4中只提供了图像直方图的统计函数calcHist(),该函数能够统计出图像中每个灰度值的个数,但是对于直方图的绘制需要使用者自行绘制。我们首先学习统计灰度值数目的函数**calcHist()**的使用,该函数的原型在代码清单4-1中给出。

void cv::calcHist(const Mat * images, int nimages, const int * channels, InputArray mask, OutputArray hist, int dims, const int * histSize, const float ** ranges, bool uniform = true, bool accumulate = false )该函数用于统计图像中每个灰度值像素的个数,例如统计一张CV_8UC1的图像,需要统计灰度值从0到255中每一个灰度值在图像中的像素个数,如果某个灰度值在图像中没有,那么该灰度值的统计结果就是0。由于该函数具有较多的参数,并且每个参数都较为复杂,因此作者建议读者在使用该函数时只统计单通道图像的灰度值分布,对于多通道图像可以将图像每个通道分离后再进行统计。

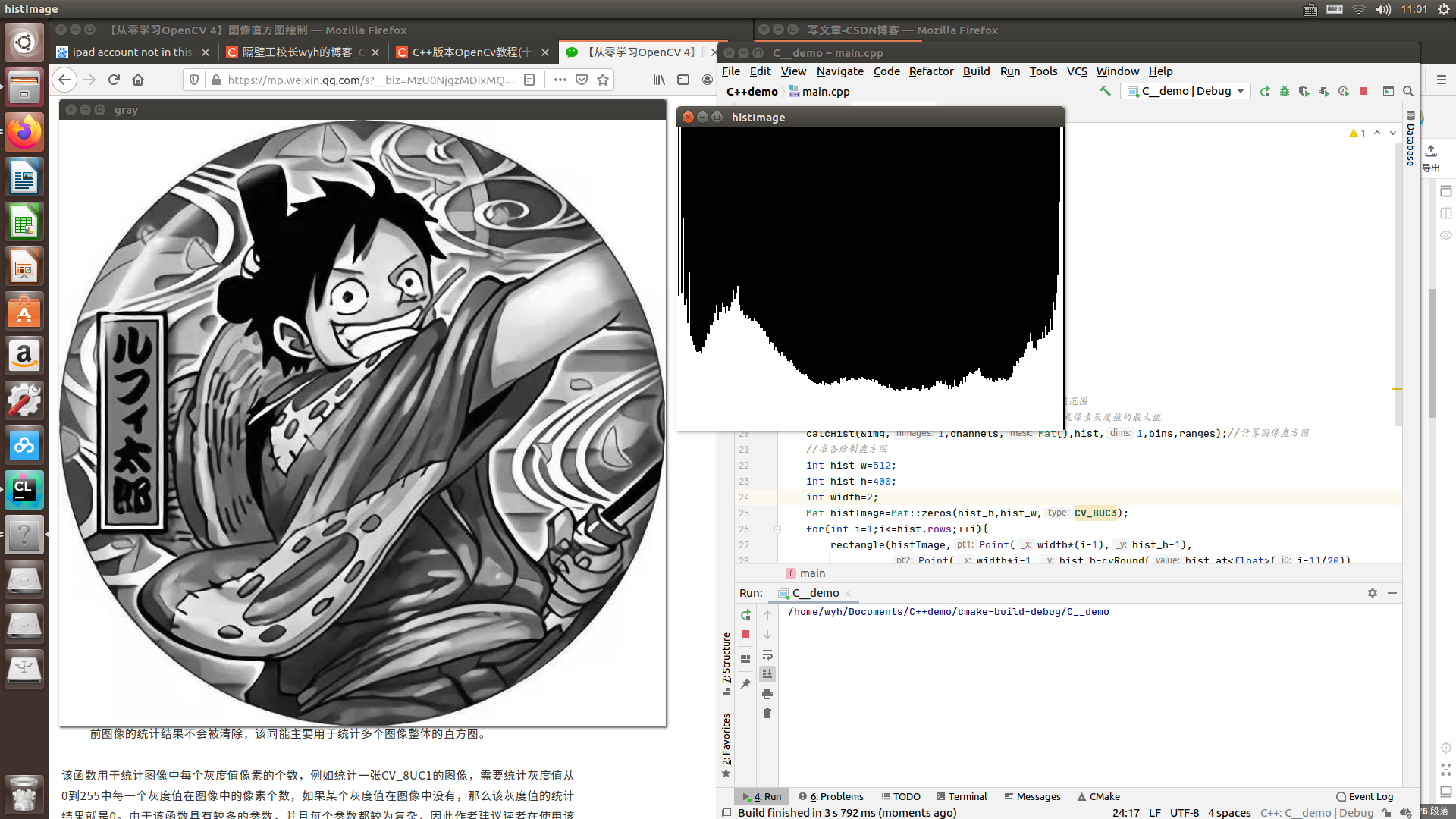

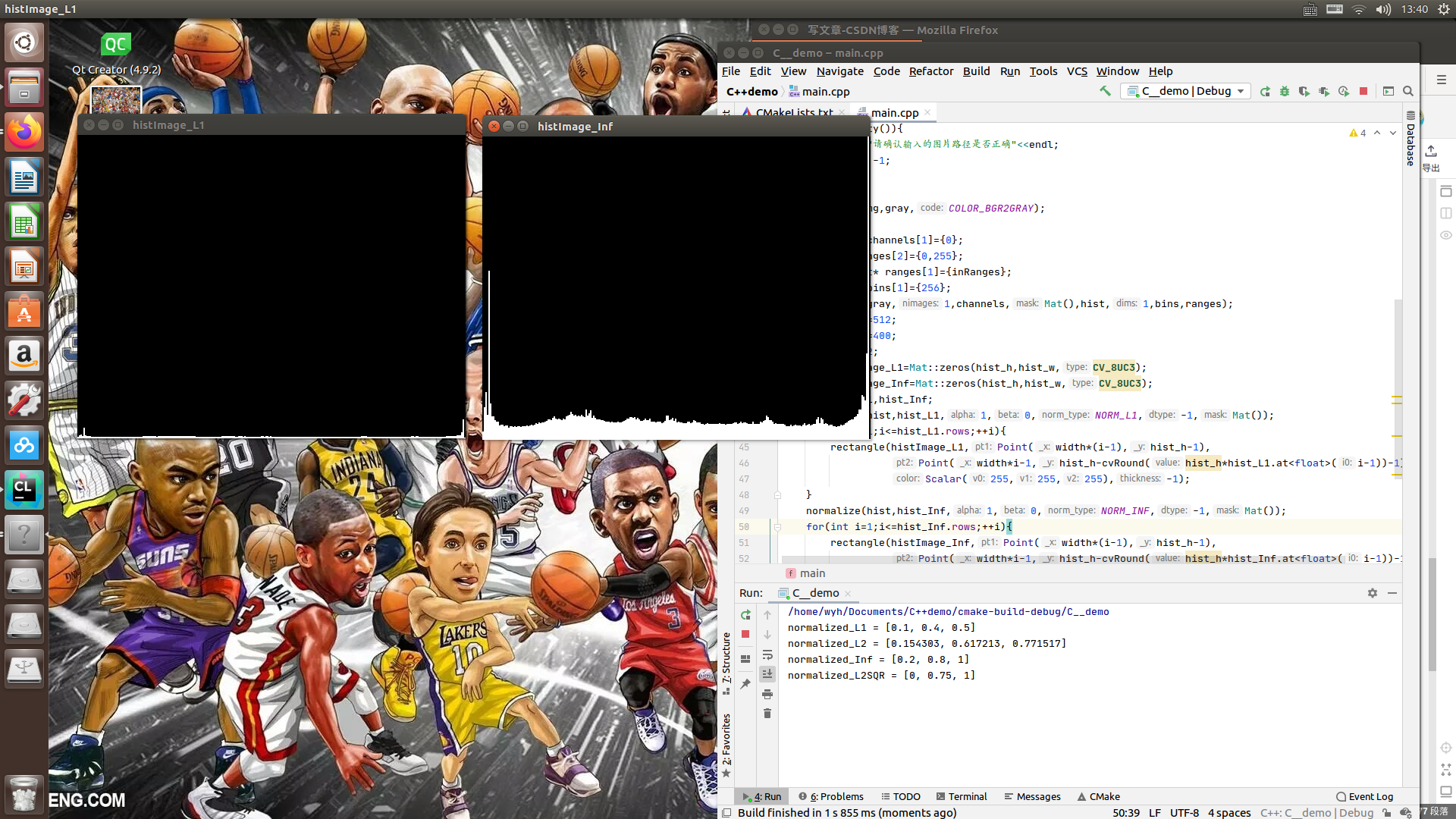

为了使读者更加了解函数的使用方法,我们在代码清单4-2中提供了绘制灰度图像的图像直方图的示例程序。在程序中我们首先使用calcHist()函数统计灰度图像里面每个灰度值的数目,之后通过不断绘制矩形的方式实现直方图的绘制。由于图像中部分灰度值像素数目较多,因此我们将每个灰度值数目缩小了20倍后再进行绘制,绘制的直方图在图4-1中所示。在程序中我们使用了OpenCV 4提供的四舍五入的取整函数cvRound(),该函数输入参数为double类型的变量,返回值为对该变量四舍五入后的int型数值。

#include <opencv2/opencv.hpp>#include <opencv2/highgui/highgui.hpp>using namespace cv;using namespace std;int main(){ Mat img=imread("699342568.jpg"); if(img.empty()){ cout<<"请确认输入的图片路径是否正确"<<endl; return -1; } Mat gray; cvtColor(img,gray,COLOR_BGR2GRAY); //设置提取直方图的相关变量 Mat hist;//用于存放直方图计算结果 const int channels[1]={0};//通道索引 float inRanges[2]={0,255}; const float*ranges[1]={inRanges};//像素灰度值范围 const int bins[1]={256};//直方图的维度,其实就是像素灰度值的最大值 calcHist(&img,1,channels,Mat(),hist,1,bins,ranges);//计算图像直方图 //准备绘制直方图 int hist_w=512; int hist_h=400; int width=2; Mat histImage=Mat::zeros(hist_h,hist_w,CV_8UC3); for(int i=1;i<=hist.rows;++i){ rectangle(histImage,Point(width*(i-1),hist_h-1), Point(width*i-1,hist_h-cvRound(hist.at<float>(i-1)/20)), Scalar(255,255,255),-1); } namedWindow("histImage",WINDOW_AUTOSIZE); imshow("histImage",histImage); imshow("gray",gray); waitKey(0); return 0;}

C++版本OpenCv教程(二十一)直方图归一化

Excerpt

前面我们完成了对一张图像像素灰度值的统计,并成功绘制了图像的直方图。但是由于绘制直方图的图像高度小于某些灰度值统计的数目,因此我们在绘制直方图时将所有的数据都缩小为原来的二十分之一之后再进行绘制,目的就是为了能够将直方图完整的绘制在图像中。如果换一张图像的直方图统计结果或者将直方图绘制到一个尺寸更小的图像中时,可能需要将统计数据缩小为原来的三十分之一、五十分之一甚至更低。数据缩小比例与统计结果、将要绘制直方图图像的尺寸相关,因此每次绘制时都需要计算数据缩小的比例。另外,由于像素灰度值统计的数目与图像的尺寸具

前面我们完成了对一张图像像素灰度值的统计,并成功绘制了图像的直方图。但是由于绘制直方图的图像高度小于某些灰度值统计的数目,因此我们在绘制直方图时将所有的数据都缩小为原来的二十分之一之后再进行绘制,目的就是为了能够将直方图完整的绘制在图像中。如果换一张图像的直方图统计结果或者将直方图绘制到一个尺寸更小的图像中时,可能需要将统计数据缩小为原来的三十分之一、五十分之一甚至更低。数据缩小比例与统计结果、将要绘制直方图图像的尺寸相关,因此每次绘制时都需要计算数据缩小的比例。另外,由于像素灰度值统计的数目与图像的尺寸具有直接关系,如果以灰度值数目作为最终统计结果,那么一张图像经过尺寸放缩后的两张图像的直方图将会有巨大的差异,然而直方图可以用来表示图像的明亮程度,从理论上讲通过缩放的两张图像将具有大致相似的直方图分布特性,因此用灰度值的数目作为统计结果具有一定的局限性。

图像的像素灰度值统计结果主要目的之一就是查看某个灰度值在所有像素中所占的比例,因此可以用每个灰度值像素的数目占一幅图像中所有像素数目的比例来表示某个灰度值数目的多少,即将统计结果再除以图像中像素个数。这种方式可以保证每个灰度值的统计结果都是0到100%之间的数据,实现统计结果的归一化,但是这种方式也存在一个弊端,就是再CV_8U类型的图像中,灰度值有256个等级,平均每个像素的灰度值所占比例为0.39%,这个比例非常低,因此为了更直观的绘制图像直方图,常需要将比例扩大一定的倍数后再绘制图像。另一种常用的归一化方式是寻找统计结果中最大数值,把所有结果除以这个最大的数值,以实现将所有数据都缩放到0到1之间。

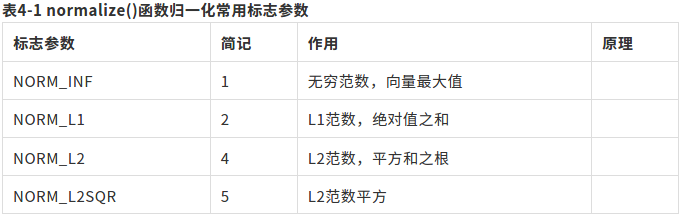

针对上面这两种归一化方式,OpenCV 4提供了normalize()函数实现多种形式的归一化功能,该函数的函数原型在代码清单4-3中给出。

void cv::normalize(InputArray src, InputOutputArray dst, double alpha = 1, double beta = 0, int norm_type = NORM_L2, int dtype = -1, InputArray mask = noArray() )该函数输入一个存放数据的矩阵,通过参数alpha设置将数据缩放到的最大范围,然后通过norm_type参数选择计算范数的种类,之后将输入矩阵中的每个数据分别除以求取的范数数值,最后得到缩放的结果。输出结果是一个CV_32F类型的矩阵,可以将输入矩阵作为输出矩阵,或者重新定义一个新的矩阵用于存放输出结果。该函数的第五个参数用于选择计算数据范数的种类,常用的可选择参数以及计算范数的公式都在表4-1中给出。计算不同的范数,最后的结果也不相同,例如选择NORM_L1标志,输出结果为每个灰度值所占的比例;选择NORM_INF参数,输出结果为除以数据中最大值,将所有的数据归一化到0到1之间。

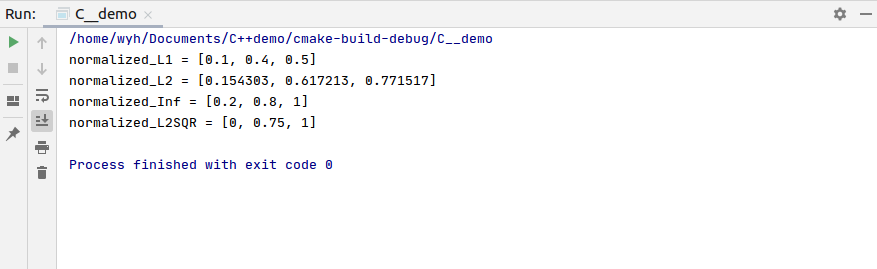

为了了解归一化函数normalize()的作用,在代码清单4-4中给出了通过不同方式归一化数组的计算结果,并且分别用灰度值所占比例和除以数据最大值的方式对图像直方图进行归一化操作。为了更加直观的展现归一化后的结果,我们将每个灰度值所占比例放大了30倍,并将绘制直方图的图像高度作为1进行绘制直方图,最终结果在图4-3给出,根据结果显示,无论是否进行归一化,或者采用那种归一化方法,直方图的分布特性都不会改变。

#include <opencv2/opencv.hpp>#include <opencv2/highgui/highgui.hpp>using namespace cv;using namespace std;int main(){ vector<double>positiveData{2.0,8.0,10.0}; vector<double>normalized_L1,normalized_L2,normalized_Inf,normalized_L2SQR; //测试不同的归一化方法 normalize(positiveData,normalized_L1,1.0,0.0,NORM_L1);//绝对值求和归一化 cout<<"normalized_L1 = ["<<normalized_L1[0]<<", " <<normalized_L1[1]<<", "<<normalized_L1[2]<<"]"<<endl; normalize(positiveData,normalized_L2,1.0,0.0,NORM_L2);//模长归一化 cout<<"normalized_L2 = ["<<normalized_L2[0]<<", " <<normalized_L2[1]<<", "<<normalized_L2[2]<<"]"<<endl; normalize(positiveData,normalized_Inf,1.0,0.0,NORM_INF);//最大值归一化 cout<<"normalized_Inf = ["<<normalized_Inf[0]<<", " <<normalized_Inf[1]<<", "<<normalized_Inf[2]<<"]"<<endl; normalize(positiveData,normalized_L2SQR,1.0,0.0,NORM_MINMAX);//偏移归一化 cout<<"normalized_L2SQR = ["<<normalized_L2SQR[0]<<", " <<normalized_L2SQR[1]<<", "<<normalized_L2SQR[2]<<"]"<<endl; //将直方图归一化 Mat img=imread("699342568.jpg"); if(img.empty()){ cout<<"请确认输入的图片路径是否正确"<<endl; return -1; } Mat gray; cvtColor(img,gray,COLOR_BGR2GRAY); Mat hist; const int channels[1]={0}; float inRanges[2]={0,255}; const float* ranges[1]={inRanges}; const int bins[1]={256}; calcHist(&gray,1,channels,Mat(),hist,1,bins,ranges); int hist_w=512; int hist_h=400; int width=2; Mat histImage_L1=Mat::zeros(hist_h,hist_w,CV_8UC3); Mat histImage_Inf=Mat::zeros(hist_h,hist_w,CV_8UC3); Mat hist_L1,hist_Inf; normalize(hist,hist_L1,1,0,NORM_L1,-1,Mat()); for(int i=1;i<=hist_L1.rows;++i){ rectangle(histImage_L1,Point(width*(i-1),hist_h-1), Point(width*i-1,hist_h-cvRound(hist_h*hist_L1.at<float>(i-1))-1), Scalar(255,255,255),-1); } normalize(hist,hist_Inf,1,0,NORM_INF,-1,Mat()); for(int i=1;i<=hist_Inf.rows;++i){ rectangle(histImage_Inf,Point(width*(i-1),hist_h-1), Point(width*i-1,hist_h-cvRound(hist_h*hist_Inf.at<float>(i-1))-1), Scalar(255,255,255),-1); } imshow("histImage_L1",histImage_L1); imshow("histImage_Inf",histImage_Inf); waitKey(0); return 0;}

C++版本OpenCv教程(二十二)直方图比较

Excerpt

图像的直方图表示图像像素灰度值的统计特性,因此可以通过比较两张图像的直方图特性比较两张图像的相似程度。从一定程度上来讲,虽然两张图像的直方图分布相似不代表两张图像相似,但是两张图像相似则两张图像的直方图分布一定相似。例如通过插值对图像进行放缩后图像的直方图虽然不会与之前完全一致,但是两者一定具有很高的相似性,因而可以通过比较两张图像的直方图分布相似性对图像进行初步的筛选与识别。OpenCV 4中提供了用于比较两个图像直方图相似性的compareHist()函数,该函数原型在代码清单4-5中给出。doub

图像的直方图表示图像像素灰度值的统计特性,因此可以通过比较两张图像的直方图特性比较两张图像的相似程度。从一定程度上来讲,虽然两张图像的直方图分布相似不代表两张图像相似,但是两张图像相似则两张图像的直方图分布一定相似。例如通过插值对图像进行放缩后图像的直方图虽然不会与之前完全一致,但是两者一定具有很高的相似性,因而可以通过比较两张图像的直方图分布相似性对图像进行初步的筛选与识别。

OpenCV 4中提供了用于比较两个图像直方图相似性的compareHist()函数,该函数原型在代码清单4-5中给出。

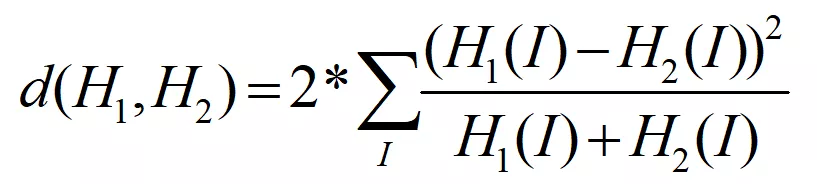

double cv::compareHist(InputArray H1, InputArray H2, int method )该函数前两个参数为需要比较相似性的图像直方图,由于不同尺寸的图像中像素数目可能不相同,为了能够得到两个直方图图像正确的相识性,需要输入同一种方式归一化后的图像直方图,并且要求两个图像直方图具有相同的尺寸。函数第三个参数为比较相似性的方法,选择不同的方法,会得到不同的相似性系数,函数将计算得到的相似性系数以double类型返回。由于不同计算方法的规则不一,因此相似性系数代表的含义也不相同,函数可以选择的计算方式标志在表4-2中给出,接下来介绍每种方法比较相似性的原理。

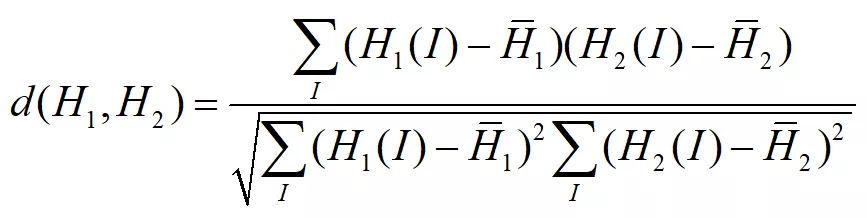

HISTCMP_CORREL

该方法名为相关法,其计算相似性原理在式(6.1)中给出,在该方法中如果两个图像直方图完全一致,则计算数值为1;如果两个图像直方图完全不相关,则计算值为0。

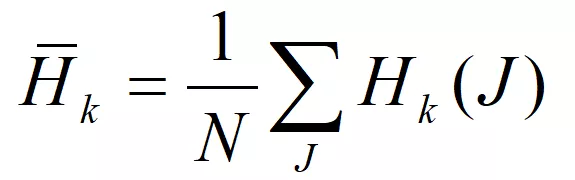

其中

其中 N是直方图的灰度值个数。

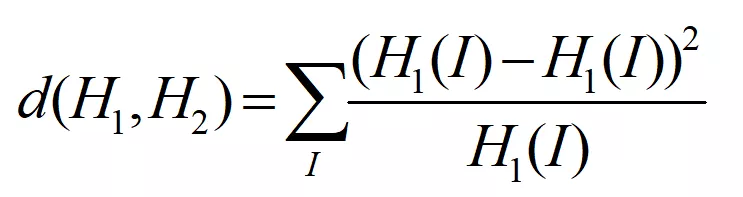

HISTCMP_CHISQR

该方法名为卡方法,其计算相似性原理在式(6.3)中给出,在该方法中如果两个图像直方图完全一致,则计算数值为0,两个图像的相似性越小,计算数值越大。

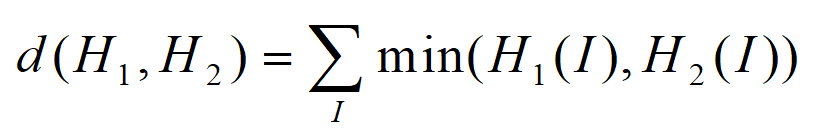

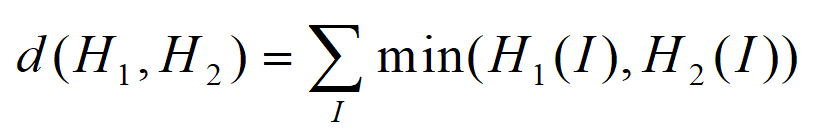

HISTCMP_INTERSECT

该方法名为直方图相交法,其计算相似性原理在式(6.4)中给出,在该方法不会将计算结果归一化,因此即使是两个完全一致的图像直方图,来自于不同图像也会有不同的数值,但是其遵循与同一个图像直方图比较时,数值越大相似性越高,数值越小相似性越低。

HISTCMP_INTERSECT

该方法名为直方图相交法,其计算相似性原理在式(6.4)中给出,在该方法不会将计算结果归一化,因此即使是两个完全一致的图像直方图,来自于不同图像也会有不同的数值,但是其遵循与同一个图像直方图比较时,数值越大相似性越高,数值越小相似性越低。

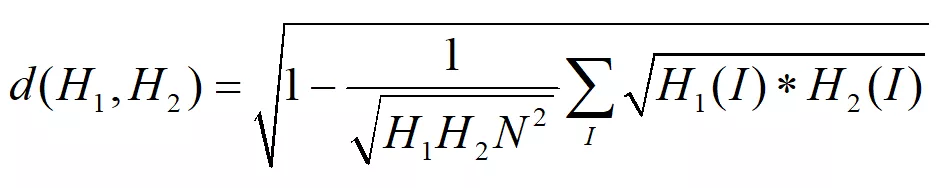

HISTCMP_BHATTACHARYYA

该方法名为巴塔恰里雅距离(巴氏距离)法,其计算相似性原理在式(6.5)中给出,在该方法中如果两个图像直方图完全一致,则计算数值为0,两个图像的相似性越小,计算数值越大。

HISTCMP_CHISQR_ALT

该方法与巴氏距离法相同,常用于替代巴氏距离法用于纹理比较,计算公式如式(6.6),

HISTCMP_KL_DIV

该方法名为相对熵法,又名Kullback-Leibler散度法,其计算相似性原理在式(6.7)中给出,在该方法中如果两个图像直方图完全一致,则计算数值为0,两个图像的相似性越小,计算数值越大。

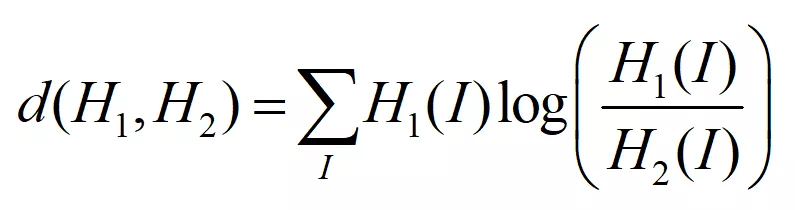

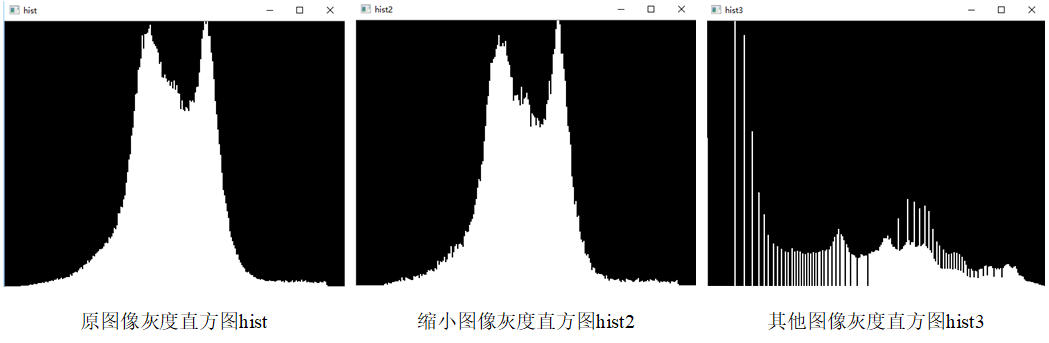

为了验证通过直方图比较两张图像相似性的可行性,在代码清单4-6中提供了三张图像直方图比较的示例程序。在程序中,我们将读取的图像转成灰度图像,之后将图像缩小为原来尺寸的一半,同时读取另外一张图像的灰度图,计算这三张图像的直方图,直方图的结果在图4-4中给出,通过观看直方图的趋势可以发现即使将图像尺寸缩小,两张图像的直方图分布也有一定的相似性。之后利用compareHist()函数对三个直方图进行比较,比较结果也显示图像缩小后的直方图与原来图像的直方图具有很高的相似性,而两张完全不相同的图像的直方图相似性比较小。

#include <opencv2/opencv.hpp>#include <opencv2/highgui/highgui.hpp>using namespace cv;using namespace std;void drawHist(Mat&hist,int type,string name){//归一化并回执直方图函数 int hist_w=512; int hist_h=400; int width=2; Mat histImage=Mat::zeros(hist_h,hist_w,CV_8UC3); normalize(hist,hist,1,0,type,-1,Mat()); for(int i=1;i<=hist.rows;++i){ rectangle(histImage,Point(width*(i-1),hist_h-1), Point(width*i-1,hist_h-cvRound(hist_h*hist.at<float>(i-1))-1), Scalar(255,255,255),-1); } imshow(name,histImage);}int main(){ Mat img=imread("apple.jpg"); if(img.empty()){ cout<<"请确认输入的图片路径是否正确"<<endl; return -1; } Mat gray,hist,gray2,hist2,gray3,hist3; cvtColor(img,gray,COLOR_BGR2GRAY); resize(gray,gray2,Size(),0.5,0.5); gray3=imread("lena.png",IMREAD_GRAYSCALE); const int channels[1]={0}; float inRanges[2]={0,255}; const float*ranges[1]={inRanges}; const int bins[1]={256}; calcHist(&gray,1,channels,Mat(),hist,1,bins,ranges); calcHist(&gray2,1,channels,Mat(),hist2,1,bins,ranges); calcHist(&gray3,1,channels,Mat(),hist3,1,bins,ranges); drawHist(hist,NORM_INF,"hist"); drawHist(hist2,NORM_INF,"hist2"); drawHist(hist3,NORM_INF,"hist3"); //原图直方图与原图直方图的相关系数 double hist_hist=compareHist(hist,hist,HISTCMP_CORREL); cout<<"apple_apple = "<<hist_hist<<endl; //原图直方图与缩小原图直方图的相关系数 double hist_hist2=compareHist(hist,hist2,HISTCMP_CORREL); cout<<"apple_apple256 = "<<hist_hist2<<endl; //两张不同图像直方图的相关系数 double hist_hist3=compareHist(hist,hist3,HISTCMP_CORREL); cout<<"apple_lena = "<<hist_hist3<<endl; waitKey(0); return 0;}

C++版本OpenCv教程(二十三)直方图均衡化

Excerpt

如果一个图像的直方图都集中在一个区域,则整体图像的对比度比较小,不便于图像中纹理的识别。例如相邻的两个像素灰度值如果分别是120和121,仅凭肉眼是如法区别出来的。同时,如果图像中所有的像素灰度值都集中在100到150之间,则整个图像想会给人一种模糊的感觉,看不清图中的内容。如果通过映射关系,将图像中灰度值的范围扩大,增加原来两个灰度值之间的差值,就可以提高图像的对比度,进而将图像中的纹理突出显现出来,这个过程称为图像直方图均衡化。在OpenCV 4中提供了equalizeHist()函数用于将图像的直方

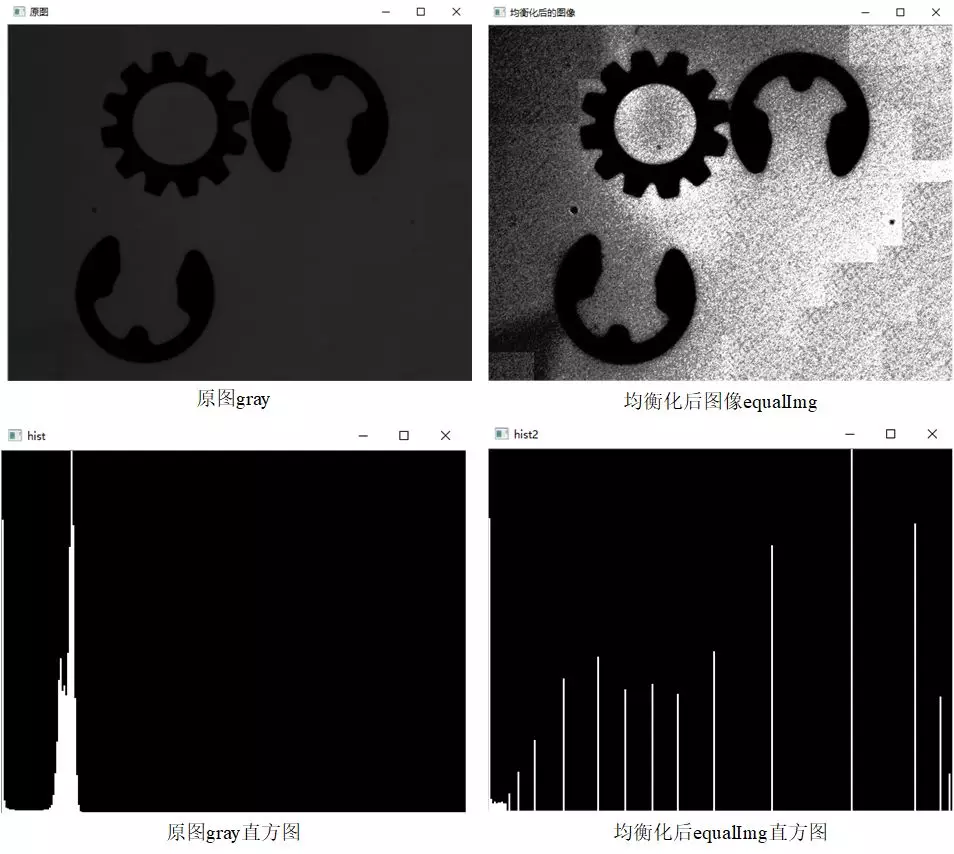

如果一个图像的直方图都集中在一个区域,则整体图像的对比度比较小,不便于图像中纹理的识别。例如相邻的两个像素灰度值如果分别是120和121,仅凭肉眼是如法区别出来的。同时,如果图像中所有的像素灰度值都集中在100到150之间,则整个图像想会给人一种模糊的感觉,看不清图中的内容。如果通过映射关系,将图像中灰度值的范围扩大,增加原来两个灰度值之间的差值,就可以提高图像的对比度,进而将图像中的纹理突出显现出来,这个过程称为图像直方图均衡化。

在OpenCV 4中提供了equalizeHist()函数用于将图像的直方图均衡化,该函数的函数原型在代码清单4-7中给出。

void cv::equalizeHist(InputArray src,OutputArray dst)该函数形式比较简单,但是需要注意该函数只能对单通道的灰度图进行直方图均衡化。对图像的均衡化示例程序在代码清单4-8中给出,程序中我们将一张图像灰度值偏暗的图像进行均衡化,通过结果可以发现经过均衡化后的图像对比度明显增加,可以看清楚原来看不清的纹理。通过绘制原图和均衡化后的图像的直方图可以发现,经过均衡化后的图像直方图分布更加均匀。

#include <opencv2/opencv.hpp>#include <opencv2/highgui/highgui.hpp>using namespace cv;using namespace std;void drawHist(Mat&hist,int type,string name){//归一化并回执直方图函数 int hist_w=512; int hist_h=400; int width=2; Mat histImage=Mat::zeros(hist_h,hist_w,CV_8UC3); normalize(hist,hist,1,0,type,-1,Mat()); for(int i=1;i<=hist.rows;++i){ rectangle(histImage,Point(width*(i-1),hist_h-1), Point(width*i-1,hist_h-cvRound(hist_h*hist.at<float>(i-1))-1), Scalar(255,255,255),-1); } imshow(name,histImage);}int main(){ Mat img=imread("gearwheel.jpg"); if(img.empty()){ cout<<"请确认输入的图片路径是否正确"<<endl; return -1; } Mat gray,hist,hist2; cvtColor(img,gray,COLOR_BGR2GRAY); Mat equalImg; equalizeHist(gray,equalImg);//将图像直方图均衡化 const int channels[1]={0}; float inRanges[2]={0,255}; const float*ranges[1]={inRanges}; const int bins[1]={256}; calcHist(&gray,1,channels,Mat(),hist,1,bins,ranges); calcHist(&equalImg,1,channels,Mat(),hist2,1,bins,ranges); drawHist(hist,NORM_INF,"hist"); drawHist(hist2,NORM_INF,"hist2"); imshow("原图",gray); imshow("均衡化后的图像",equalImg); waitKey(0); return 0;}

C++版本OpenCv教程(二十四)直方图匹配

Excerpt

直方图均衡化函数可以自动的改变图像直方图的分布形式,这种方式极大的简化了直方图均衡化过程中需要的操作步骤,但是该函数不能指定均衡化后的直方图分布形式。在某些特定的条件下需要将直方图映射成指定的分布形式,这种将直方图映射成指定分布形式的算法称为直方图匹配或者直方图规定化。直方图匹配与直方图均衡化相似,都是对图像的直方图分布形式进行改变,只是直方图均衡化后的图像直方图是均匀分布的,而直方图匹配后的直方图可以随意指定,即在执行直方图匹配操作时,首先要知道变换后的灰度直方图分布形式,进而确定变换函数。直方图匹配操作

直方图均衡化函数可以自动的改变图像直方图的分布形式,这种方式极大的简化了直方图均衡化过程中需要的操作步骤,但是该函数不能指定均衡化后的直方图分布形式。在某些特定的条件下需要将直方图映射成指定的分布形式,这种将直方图映射成指定分布形式的算法称为直方图匹配或者直方图规定化。直方图匹配与直方图均衡化相似,都是对图像的直方图分布形式进行改变,只是直方图均衡化后的图像直方图是均匀分布的,而直方图匹配后的直方图可以随意指定,即在执行直方图匹配操作时,首先要知道变换后的灰度直方图分布形式,进而确定变换函数。直方图匹配操作能够有目的的增强某个灰度区间,相比于直方图均衡化操作,该算法虽然多了一个输入,但是其变换后的结果也更灵活。

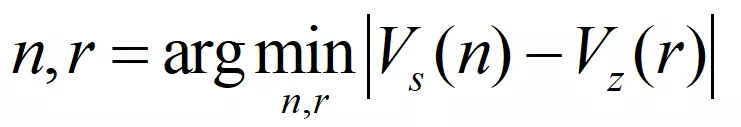

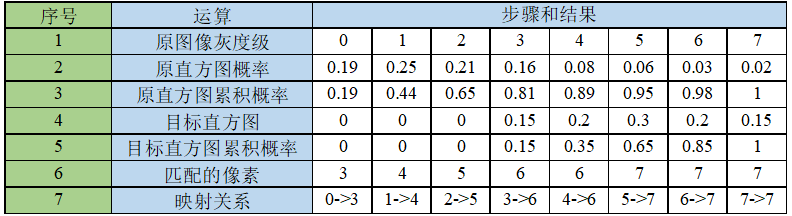

由于不同图像间像素数目可能不同,为了使两个图像直方图能够匹配,需要使用概率形式去表示每个灰度值在图像像素中所占的比例。理想状态下,经过图像直方图匹配操作后图像直方图分布形式应与目标分布一致,因此两者之间的累积概率分布也一致。累积概率为小于等于某一灰度值的像素数目占所有像素中的比例。我们用Vs表示原图像直方图的各个灰度级的累积概率,用Vz表示匹配后直方图的各个灰度级累积概率。那么确定由原图像中灰度值n映射成r的条件如式(6.8)所示。

为了更清楚的说明直方图匹配过程,在图4-7中给出了一个直方图匹配示例。示例中目标直方图灰度值2以下的概率都为0,灰度值3的累积概率为0.16,灰度值4的累积概率为0.35,原图像直方图灰度值为0时累积概率为0.19。0.19距离0.16的距离小于距离0.35的距离,因此需要将原图像中灰度值0匹配成灰度值3。同样,原图像灰度值1的累积概率为0.43,其距离目标直方图灰度值4的累积概率0.35的距离为0.08,而距离目标直方图灰度值5的累积概率0.64的距离为0.21,因此需要将原图像中灰度值1匹配成灰度值4。

这个寻找灰度值匹配的过程是直方图匹配算法的关键,在代码实现中我们可以通过构建原直方图累积概率与目标直方图累积概率之间的差值表,寻找原直方图中灰度值n的累积概率与目标直方图中所有灰度值累积概率差值的最小值,这个最小值对应的灰度值r就是n匹配后的灰度值。

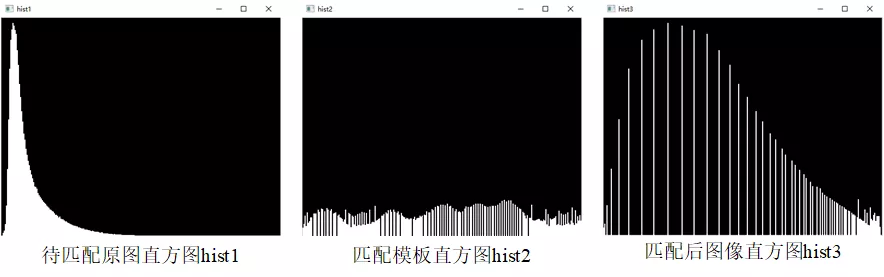

在OpenCV 4中并没有提供直方图匹配的函数,需要自己根据算法实现图像直方图匹配。在代码清单4-9中给出了实现直方图匹配的示例程序。程序中待匹配的原图是一个图像整体偏暗的图像,目标直方图分配形式来自于一张较为明亮的图像,经过图像直方图匹配操作之后,提高了图像的整体亮度,图像直方图分布也更加均匀,程序中所有的结果在图4-8、图4-9给出。

#include <opencv2/opencv.hpp>#include <opencv2/highgui/highgui.hpp>using namespace cv;using namespace std;void drawHist(Mat&hist,int type,string name){//归一化并回执直方图函数 int hist_w=512; int hist_h=400; int width=2; Mat histImage=Mat::zeros(hist_h,hist_w,CV_8UC3); normalize(hist,hist,1,0,type,-1,Mat()); for(int i=1;i<=hist.rows;++i){ rectangle(histImage,Point(width*(i-1),hist_h-1), Point(width*i-1,hist_h-cvRound(hist_h*hist.at<float>(i-1))-1), Scalar(255,255,255),-1); } imshow(name,histImage);}int main(){ Mat img1=imread("histMatch.png"); Mat img2=imread("equalLena.png"); if(img1.empty()||img2.empty()){ cout<<"请确认输入的图片路径是否正确"<<endl; return -1; } Mat hist1,hist2; //计算两张图像的直方图 const int channels[1]={0}; float inRanges[2]={0,255}; const float *ranges[1]={inRanges}; const int bins[1]={256}; calcHist(&img1,1,channels,Mat(),hist1,1,bins,ranges); calcHist(&img2,1,channels,Mat(),hist2,1,bins,ranges); //归一化两张图像 drawHist(hist1,NORM_INF,"hist1"); drawHist(hist2,NORM_INF,"hist2"); //计算两张图向直方图的;累计概率 float hist1_cdf[256]={hist1.at<float>(0)}; float hist2_cdf[256]={hist2.at<float>(0)}; for(int i=1;i<256;++i){ hist1_cdf[i]=hist1_cdf[i-1]+hist1.at<float>(i); hist2_cdf[i]=hist2_cdf[i-1]+hist2.at<float>(i); } //构建累积概率误差矩阵 float diff_cdf[256][256]; for(int i=0;i<256;++i){ for(int j=0;j<256;++j){ diff_cdf[i][j]=fabs(hist1_cdf[i]-hist2_cdf[i]); } } //生成LUT映射表 Mat lut(1,256,CV_8U); for(int i=0;i<256;++i){ //查找源灰度级为i的映射灰度 //和i的累积概率差值的最小的规定花灰度 float min=diff_cdf[i][0]; int index=0; //寻找累积概率误差矩阵中每一行中的最小值 for(int j=1;j<256;++j){ if(min>diff_cdf[i][j]){ min=diff_cdf[i][j]; index=j; } } lut.at<uchar>(i)=(uchar)index; } Mat result,hist3; LUT(img1,lut,result); imshow("待匹配图像",img1); imshow("匹配的模板图像",img2); imshow("直方图匹配结果",result); calcHist(&result,1,channels,Mat(),hist3,1,bins,ranges); drawHist(hist3,NORM_L1,"hist3"); waitKey(0); return 0;}

C++版本OpenCv教程(二十五)图像模板匹配

Excerpt

前面我们通过图像直方图反向投影的方式在图像中寻找模板图像,由于直方图不能直接反应图像的纹理,因此如果两张不同模板图像具有相同的直方图分布特性,那么在同一张图中对这两张模板图像的直方图进行反向投影,最终结果将不具有参考意义。因此,我们在图像中寻找模板图像时,可以直接通过比较图像像素的形式来搜索是否存在相同的内容,这种通过比较像素灰度值来寻找相同内容的方法叫做图像的模板匹配。模板匹配常用于在一幅图像中寻找特定内容的任务中。由于模板图像的尺寸小于待匹配图像的尺寸,同时又需要比较两张图像中的每一个像素的灰度值,因

前面我们通过图像直方图反向投影的方式在图像中寻找模板图像,由于直方图不能直接反应图像的纹理,因此如果两张不同模板图像具有相同的直方图分布特性,那么在同一张图中对这两张模板图像的直方图进行反向投影,最终结果将不具有参考意义。因此,我们在图像中寻找模板图像时,可以直接通过比较图像像素的形式来搜索是否存在相同的内容,这种通过比较像素灰度值来寻找相同内容的方法叫做图像的模板匹配。

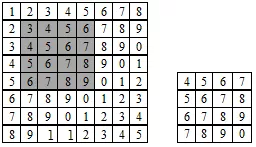

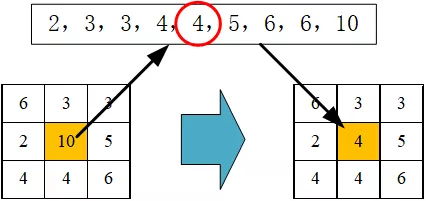

模板匹配常用于在一幅图像中寻找特定内容的任务中。由于模板图像的尺寸小于待匹配图像的尺寸,同时又需要比较两张图像中的每一个像素的灰度值,因此常采用在待匹配图像中选择与模板相同尺寸的滑动窗口,通过比较滑动窗口与模板的相似程度,判断待匹配图像中是否含有与模板图像相同的内容,其原理如图4-11所示。

在图4-11中,右侧4×4的图像是模板图像,每个像素中的数字是该像素的灰度值,左侧8×8图像是待匹配图像,模板匹配的流程如下:

Step1:在待匹配图像中选取与模板尺寸大小相同的滑动窗口,如图4-11中的阴影区域所示。

Step2:比较滑动窗口中每个像素与模板中对应像素灰度值的关系,计算模板与滑动窗口的相似性。

Step3:将滑动窗口从左上角开始先向右滑动,滑动到最右边后向下滑动一行,从最左侧重新开始滑动,记录每一次移动后计算的模板与滑动窗口的相似性。

Step4:比较所有位置的相似性,选择相似性最大的滑动窗口作为备选匹配结果。

OpenCV 4中提供了用于图像模板匹配的函数matchTemplate(),该函数能够实现模板匹配过程中图像与模板相似性的计算,在代码清单4-12中给出了函数原型。

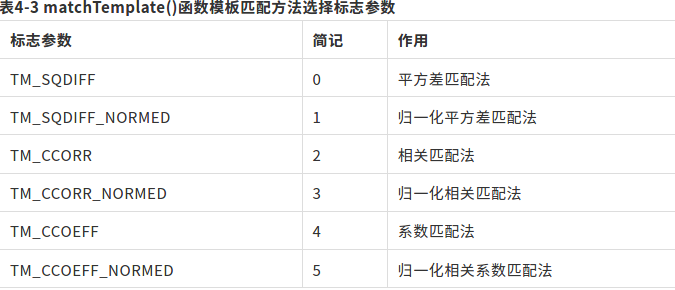

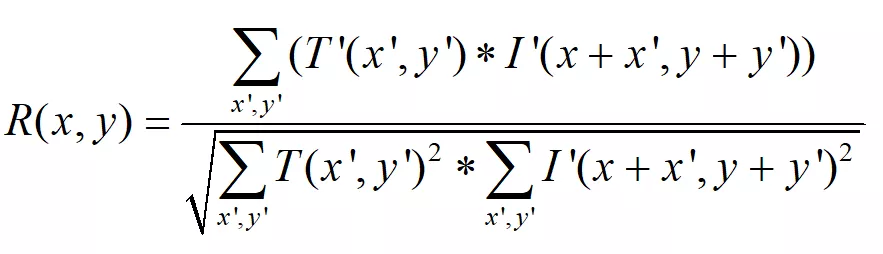

void cv::matchTemplate(InputArray image, InputArray templ, OutputArray result, int method, InputArray mask = noArray() )该函数同时支持灰度图像和彩色图像两种图像的模板匹配。函数前两个参数为输入的原图像和模板图像,由于是在原图像中搜索是否存在与模板图像相同的内容,因此需要模板图像的尺寸小于原图像,并且两者必须具有相同的数据类型。第三个参数为相似性矩阵,滑动窗口与模板的相似性系数存放在滑动窗口左上角第一个像素处,因此输出的相似性矩阵尺寸要小于原图像的尺寸,如果image的尺寸为W×H,模板图像尺寸为w×h,则输出图像的尺寸为(W-w+1)×(H-h+1)。因为在模板匹配中原图像不需要进行尺寸的外延,所以滑动窗口左上角可以移动的范围要小于原图像的尺寸。无论输入的是彩色图像还是灰度图像,函数输出结果都是单通道矩阵。了解相似性系数记录的方式便于寻找到与模板最相似的滑动窗口,继而在原图中标记出与模板相同的位置。函数第四个参数是滑动窗口与模板相似性系数的计算方式,OpenCV 4提供了多种计算方法,所有可以选择的标志参数在表4-3中给出,接下来对每一种方法进行详细介绍。

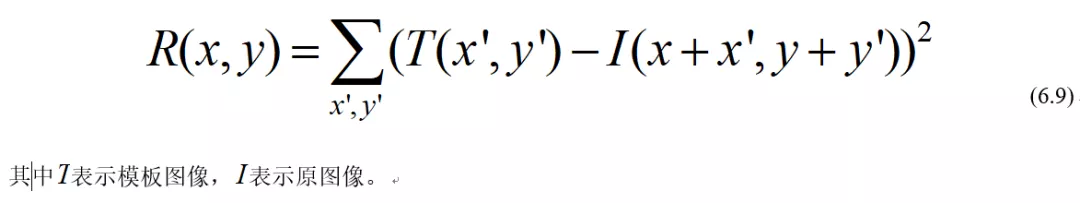

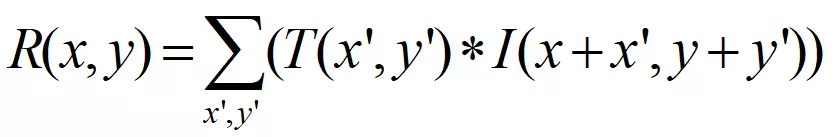

1.TM_SQDIFF

该方法名为平方差匹配法,计算的公式如式(6.9)所示,这种方法利用平方差来进行匹配,当模板与滑动窗口完全匹配时计算数值为0,两者匹配度越低计算数值越大。

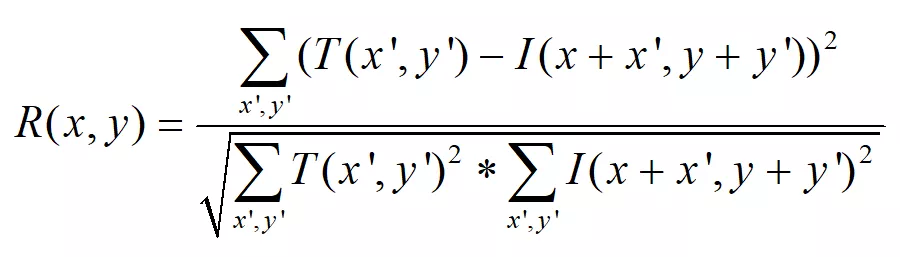

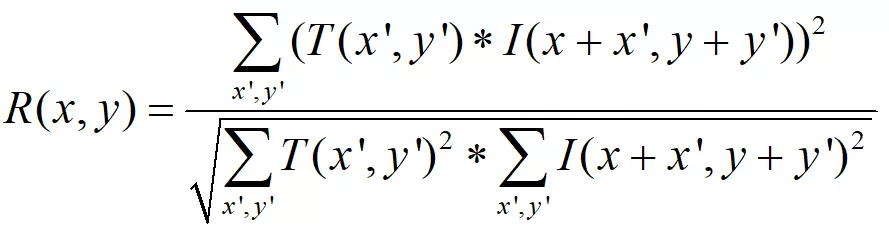

2.TM_SQDIFF_NORMED

该方法名为归一化平方差匹配方法,计算公式如式(6.10)所示,这种方法是将平方差方法进行归一化,使得输入结果缩放到了0到1之间,当模板与滑动窗口完全匹配时计算数值为0,两者匹配度越低计算数值越大。

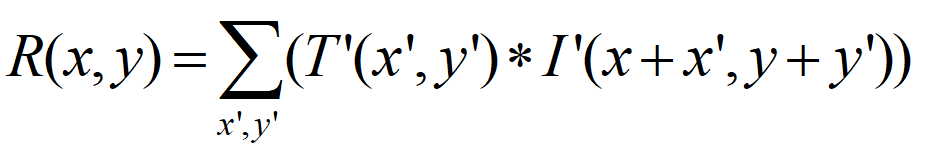

3.TM_CCORR

该方法名为相关匹配法,计算公式如式(6.11)所示,这类方法采用模板和图像间的乘法操作,所以数值越大表示匹配效果越好,0表示最坏的匹配结果。

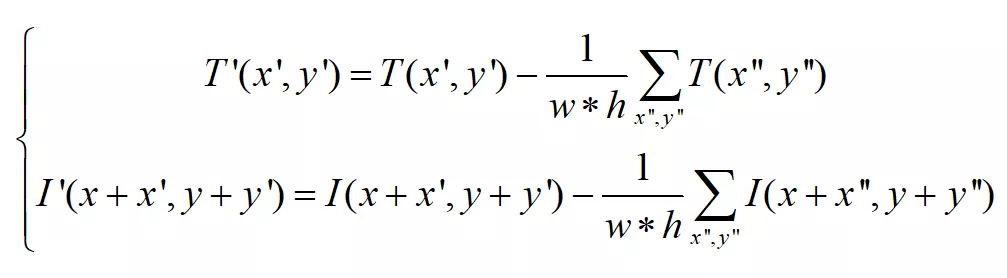

4.TM_CCORR_NORMED

该方法名为归一化相关匹配法,计算公式如式(6.12)所示,这种方法是将相关匹配法进行归一化,使得输入结果缩放到了0到1之间,当模板与滑动窗口完全匹配时计算数值为1,两者完全不匹配时计算结果为0。

5.TM_CCOEFF