linux系统安装hadoop环境

安装hadoop

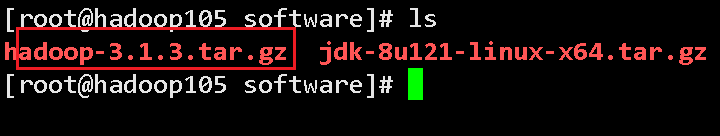

首先需要通过xftp文件传输将hadoop的.tar.gz(hadoop-3.1.3.tar.gz)文件传输到linux的/opt/software的目录下面

解压hadoop-3.1.3.tar.gz文件到/opt/module这个目录下

[tedu@hadoop105 software]$ tar -zxvf hadoop-3.1.3.tar.gz -C /opt/module/

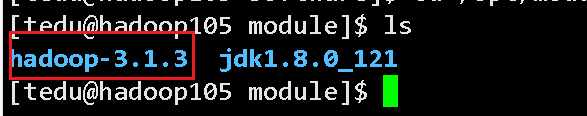

解压成功后会在/opt/module 目录下面看到以下信息

hadoop提供的命令不生效 原因是没有去配置hadoop对应的环境变量

配置hadoop的环境变量

配置三个

hadoop的家

path 对应的是hadoop家下面的/bin

path 对应的是hadoop家下面的/sbin

[tedu@hadoop105 profile.d]$ sudo vim /etc/profile.d/my_env.sh

将以下命令输入进去

#HADOOP

export HADOOP_HOME=/opt/module/hadoop-3.1.3

export PATH=$PATH:$HADOOP_HOME/bin

export PATH=$PATH:$HADOOP_HOME/sbin

配置成功后保存退出

:wq!

使配置文件立即生效

[tedu@hadoop105 profile.d]$ source /etc/profile

就可以测试hadoop的命令

查看hadoop的版本信息

hadoop version

以上界面出现说明成功了

hadoop的目录结构

找到hadoop安装目录 查看目录信息

[tedu@hadoop105 hadoop-3.1.3]$ pwd

/opt/module/hadoop-3.1.3

[tedu@hadoop105 hadoop-3.1.3]$ ll

总用量 176

drwxr-xr-x. 2 tedu tedu 183 9月 12 2019 bin

drwxr-xr-x. 3 tedu tedu 20 9月 12 2019 etc

drwxr-xr-x. 2 tedu tedu 106 9月 12 2019 include

drwxr-xr-x. 3 tedu tedu 20 9月 12 2019 lib

drwxr-xr-x. 4 tedu tedu 288 9月 12 2019 libexec

-rw-rw-r--. 1 tedu tedu 147145 9月 4 2019 LICENSE.txt

-rw-rw-r--. 1 tedu tedu 21867 9月 4 2019 NOTICE.txt

-rw-rw-r--. 1 tedu tedu 1366 9月 4 2019 README.txt

drwxr-xr-x. 3 tedu tedu 4096 9月 12 2019 sbin

drwxr-xr-x. 4 tedu tedu 31 9月 12 2019 share

目录详情

(1)bin 目录:存放对 Hadoop 相关服务(hdfs,yarn,mapred)进行操作的脚本

(2)etc 目录:Hadoop 的配置文件目录,存放 Hadoop 的配置文件

(3)lib 目录:存放 Hadoop 的本地库(对数据进行压缩解压缩功能)

(4)sbin 目录:存放启动或停止 Hadoop 相关服务的脚本

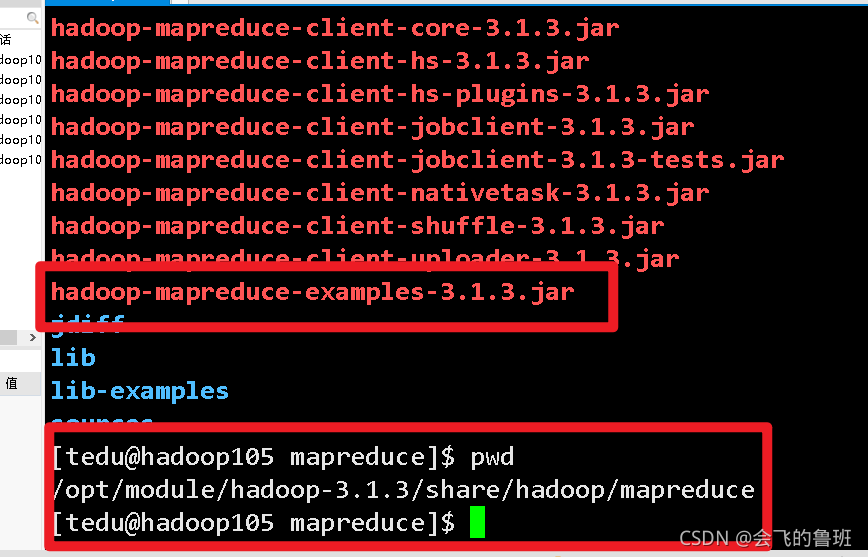

(5)share 目录:存放 Hadoop 的依赖 jar 包、文档、和官方案例

hadoop的官网

hadoop官网

Apache Hadoop

软件库是一个框架,允许使用简单的编程模型跨计算机集群分布式处理大型数据集。它旨在从单个服务器扩展到数千台机器,每台机器都提供本地计算和存储。该库本身不是依靠硬件来提供高可用性,而是设计用于检测和处理应用层的故障,因此在计算机集群之上提供高可用性服务,每台计算机都可能容易出现故障。

启动hadoop级群有三种模式

- 本地(独立)模式

官网提供的解释

默认情况下,Hadoop 配置为在非分布式模式下作为单个 Java 进程运行。这对于调试很有用。

以下示例复制解压后的 conf 目录以用作输入,然后查找并显示给定正则表达式的每个匹配项。输出写入给定的输出目录。

$ mkdir input

$ cp etc/hadoop/*.xml input

$ bin/hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-3.3.1.jar grep input output 'dfs[az.]+'

$ cat output/ *

本地版的wordcount的案例(统计单词数量)因为是本地版本的所以统计在linux服务器本机上面

在hadoop跟目录下面创建了一个wcinput的目录文件

[tedu@hadoop106 hadoop-3.1.3]$ mkdir wcinput

进入wcinput目录创建一个word.txt文件

[tedu@hadoop106 hadoop-3.1.3]$ cd wcinput

[tedu@hadoop106 wcinput]$ vim word.txt

写入测试数据

hadoop yarn

hadoop mapreduce

tedu

tedu

gqk

gqk

gqk

gqk

admin

admin

严加一

执行wordcount命令

[tedu@hadoop106 hadoop-3.1.3]$ bin/hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-3.1.3.jar wordcount wcinput/ ./wcoutput

查看结果

[tedu@hadoop105 wcoutput]$ cat part-r-00000

admin 2

gqk 4

hadoop 2

mapreduce 1

tedu 2

yarn 1

严加一 1

- 伪分布式模式

- 全分布式模式