文章目录

- 摘要

- 1.1 常见概念

- 1.1.1 机器学习本质

- 1.1.2 什么是神经网络

- 1.1.3 各种常见算法图示

- 1.1.4 计算图的导数计算

- 1.1.5 理解局部最优与全局最优

- 1.1.6 大数据与深度学习之间的关系

- 1.2 机器学习学习方式

- 1.2.1 监督学习

- 1.2.2 非监督式学习

- 1.2.3 半监督式学习

- 1.2.4 弱监督学习

- 1.2.5 监督学习有哪些步骤

- 1.8 分类算法

- 1.8.1 常用分类算法的优缺点?

- 1.8.2 分类算法的评估方法

- 1.8.3 正确率能很好的评估分类算法吗

- 1.8.4 什么样的分类器是最好的

- 1.9 逻辑回归

- 1.9.1 回归划分

- 1.9.2 逻辑回归适用性

- 1.9.3 生成模型和判别模型的区别

- 1.9.4 逻辑回归与朴素贝叶斯有什么区别

- 1.9.5 线性回归与逻辑回归的区别

- 1.10 代价函数

- 1.10.1 为什么需要代价函数

- 1.10.2 代价函数作用原理

- 1.10.3 为什么代价函数要非负

- 1.10.4 常见代价函数

- 1.10.5 为什么用交叉熵代替二次代价函数

- 1.11 损失函数

- 1.11.1 什么是损失函数

- 1.11.2 常见的损失函数

- 1.11.3 逻辑回归为什么使用对数损失函数

- 1.11.4 对数损失函数是如何度量损失的

- 1.12 梯度下降

- 1.12.1 机器学习中为什么需要梯度下降

- 1.12.2 梯度下降法缺点

- 1.12.3 梯度下降法直观理解

- 1.12.4 梯度下降法算法描述

- 1.12.5 如何对梯度下降法进行调优

- 1.12.6 随机梯度和批量梯度区别

- 1.12.7 各种梯度下降法性能比较

- 1.13 自然梯度法

- 1.13.1 为什么我们需要自然梯度

- 1.13.2 如何定义自然梯度

- 1.13.3 Fisher信息矩阵的意义

- 1.14 线性判别分析(LDA)

- 1.14.1 LDA思想总结

- 1.14.2 图解LDA核心思想

- 1.14.3 二类LDA算法原理

- 1.14.4 LDA算法流程总结

- 1.14.5 LDA和PCA区别

- 1.14.6 LDA优缺点

- 1.15 主成分分析(PCA)

- 1.15.1 主成分分析(PCA)思想总结

- 1.15.2 图解PCA核心思想

- 1.15.3 PCA算法推理

- 1.15.4 PCA算法流程总结

- 1.15.5 PCA算法主要优缺点

- 1.15.6 降维的必要性及目的

- 1.15.7 KPCA与PCA的区别

- 1.16 模型评估

- 1.16.1 模型评估常用方法?

- 1.16.2 误差、偏差和方差有什么区别和联系

- 1.16.3 经验误差与泛化误差

- 1.16.4 图解欠拟合、过拟合

- 1.16.5 如何解决过拟合与欠拟合

- 1.16.6 交叉验证的主要作用

- 1.16.7 理解k折交叉验证

- 1.16.8 混淆矩阵

- 1.16.9 错误率及精度

- 1.16.10 查准率与查全率

- 1.16.11 ROC与AUC

- 1.16.12 如何画ROC曲线

- 1.16.13 如何计算TPR,FPR

- 1.16.14 如何计算AUC

- 1.16.15 为什么使用Roc和Auc评价分类器

- 1.16.16 直观理解AUC

- 1.16.17 代价敏感错误率与代价曲线

- 1.16.18 模型有哪些比较检验方法

- 1.16.19 为什么使用标准差

- 1.16.20 类别不平衡产生原因

- 1.16.21 常见的类别不平衡问题解决方法

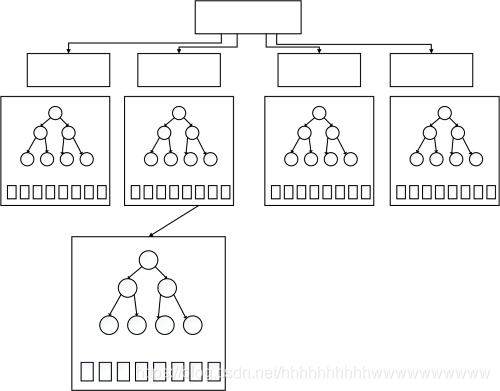

- 1.17 决策树

- 1.17.1 决策树的基本原理

- 1.17.2 决策树的三要素?

- 1.17.3 决策树学习基本算法

- 1.17.4 决策树算法优缺点

- 1.17.5 熵的概念以及理解

- 1.17.6 信息增益的理解

- 1.17.7 剪枝处理的作用及策略

- 1.18 支持向量机

- 1.18.1 什么是支持向量机

- 1.18.2 支持向量机能解决哪些问题

- 1.18.3 核函数特点及其作用

- 1.18.4 SVM为什么引入对偶问题

- 1.18.5 如何理解SVM中的对偶问题

- 1.18.7 常见的核函数有哪些

- 1.18.9 SVM主要特点

- 1.18.10 SVM主要缺点

- 1.18.11 逻辑回归与SVM的异同

- 1.19 贝叶斯分类器

- 1.19.1 图解极大似然估计

- 1.19.2 极大似然估计原理

- 1.19.3 贝叶斯分类器基本原理

- 1.19.4 朴素贝叶斯分类器

- 1.19.5 举例理解朴素贝叶斯分类器

- 2.19.6 半朴素贝叶斯分类器

- 1.20 EM算法

- 1.20.1 EM算法基本思想

- 1.20.2 EM算法推导

- 1.20.3 图解EM算法

- 1.20.4 EM算法流程

- 1.21 降维和聚类

- 1.21.1 图解为什么会产生维数灾难

- 1.21.2 怎样避免维数灾难

- 1.21.3 聚类和降维有什么区别与联系

- 1.21.4 有哪些聚类算法优劣衡量标准

- 1.21.5 聚类和分类有什么区别

- 1.21.6 不同聚类算法特点性能比较

- 1.21.7 四种常用聚类方法之比较

- 1.21.8 k-means聚类算法

- 1.21.9 层次聚类算法

- 1.21.10 SOM聚类算法

- 1.21.11 FCM聚类算法

- 1.21.12 四种聚类算法试验

摘要

机器学习起源于上世纪50年代,1959年在IBM工作的Arthur Samuel设计了一个下棋程序,这个程序具有学习的能力,它可以在不断的对弈中提高自己。由此提出了“机器学习”这个概念,它是一个结合了多个学科如概率论,优化理论,统计等,最终在计算机上实现自我获取新知识,学习改善自己的这样一个研究领域。机器学习是人工智能的一个子集,目前已经发展出许多有用的方法,比如支持向量机,回归,决策树,随机森林,强化方法,集成学习,深度学习等等,一定程度上可以帮助人们完成一些数据预测,自动化,自动决策,最优化等初步替代脑力的任务。本章我们主要介绍下机器学习的基本概念、监督学习、分类算法、逻辑回归、代价函数、损失函数、LDA、PCA、决策树、支持向量机、EM算法、聚类和降维以及模型评估有哪些方法、指标等等。

1.1 常见概念

1.1.1 机器学习本质

机器学习(Machine Learning, ML),顾名思义,让机器去学习。这里,机器指的是计算机,是算法运行的物理载体,你也可以把各种算法本身当做一个有输入和输出的机器。那么到底让计算机去学习什么呢?对于一个任务及其表现的度量方法,设计一种算法,让算法能够提取中数据所蕴含的规律,这就叫机器学习。如果输入机器的数据是带有标签的,就称作有监督学习。如果数据是无标签的,就是无监督学习。

1.1.2 什么是神经网络

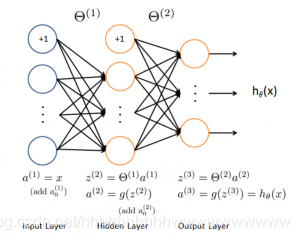

神经网络就是按照一定规则将多个神经元连接起来的网络。不同的神经网络,具有不同的连接规则。例如全连接(Full Connected, FC)神经网络,它的规则包括:

(1)有三种层:输入层,输出层,隐藏层。

(2)同一层的神经元之间没有连接。

(3)fully connected的含义:第 N 层的每个神经元和第 N-1 层的所有神经元相连,第 N-1 层神经元的输出就是第 N 层神经元的输入。

(4)每个连接都有一个权值。

神经网络架构

图1就是一个神经网络系统,它由很多层组成。输入层负责接收信息,比如一只猫的图片。输出层是计算机对这个输入信息的判断结果,它是不是猫。隐藏层就是对输入信息的传递和加工处理。

1.1.3 各种常见算法图示

日常使用机器学习的任务中,我们经常会遇见各种算法,图2是各种常见算法的图示。

| 回归算法 | 聚类算法 | 正则化方法 |

|---|---|---|

|  |  |

| 决策树学习 | 贝叶斯方法 | 基于核的算法 |

|---|---|---|

|  |  |

| 聚类算法 | 关联规则学习 | 人工神经网络 |

|---|---|---|

|  |  |

| 深度学习 | 降低维度算法 | 集成算法 |

|---|---|---|

|  |  |

1.1.4 计算图的导数计算

计算图导数计算是反向传播,利用链式法则和隐式函数求导。

假设 z = f ( u , v ) z = f(u,v) z=f(u,v) 在点 ( u , v ) (u,v) (u,v) 处偏导连续, ( u , v ) (u,v) (u,v)是关于 t t t 的函数,在 t t t 点可导,求 z z z 在 t t t 点的导数。

根据链式法则有

d

z

d

t

=

∂

z

∂

u

.

d

u

d

t

+

∂

z

∂

v

.

d

v

d

t

\frac{dz}{dt}=\frac{\partial z}{\partial u}.\frac{du}{dt}+\frac{\partial z}{\partial v} .\frac{dv}{dt}

dtdz=∂u∂z.dtdu+∂v∂z.dtdv

链式法则用文字描述:“由两个函数凑起来的复合函数,其导数等于里边函数代入外边函数的值之导数,乘以里边函数的导数。

为了便于理解,下面举例说明:

f

(

x

)

=

x

2

,

g

(

x

)

=

2

x

+

1

f(x)=x^2,g(x)=2x+1

f(x)=x2,g(x)=2x+1

则:

f

[

g

(

x

)

]

′

=

2

[

g

(

x

)

]

×

g

′

(

x

)

=

2

[

2

x

+

1

]

×

2

=

8

x

+

4

{f[g(x)]}'=2[g(x)] \times g'(x)=2[2x+1] \times 2=8x+4

f[g(x)]′=2[g(x)]×g′(x)=2[2x+1]×2=8x+4

1.1.5 理解局部最优与全局最优

笑谈局部最优和全局最优

柏拉图有一天问老师苏格拉底什么是爱情?苏格拉底叫他到麦田走一次,摘一颗最大的麦穗回来,不许回头,只可摘一次。柏拉图空着手出来了,他的理由是,看见不错的,却不知道是不是最好的,一次次侥幸,走到尽头时,才发现还不如前面的,于是放弃。苏格拉底告诉他:“这就是爱情。”这故事让我们明白了一个道理,因为生命的一些不确定性,所以全局最优解是很难寻找到的,或者说根本就不存在,我们应该设置一些限定条件,然后在这个范围内寻找最优解,也就是局部最优解——有所斩获总比空手而归强,哪怕这种斩获只是一次有趣的经历。

柏拉图有一天又问什么是婚姻?苏格拉底叫他到树林走一次,选一棵最好的树做圣诞树,也是不许回头,只许选一次。这次他一身疲惫地拖了一棵看起来直挺、翠绿,却有点稀疏的杉树回来,他的理由是,有了上回的教训,好不容易看见一棵看似不错的,又发现时间、体力已经快不够用了,也不管是不是最好的,就拿回来了。苏格拉底告诉他:“这就是婚姻。”

优化问题一般分为局部最优和全局最优。其中,

(1)局部最优,就是在函数值空间的一个有限区域内寻找最小值;而全局最优,是在函数值空间整个区域寻找最小值问题。

(2)函数局部最小点是它的函数值小于或等于附近点的点,但是有可能大于较远距离的点。

(3)全局最小点是那种它的函数值小于或等于所有的可行点。

1.1.6 大数据与深度学习之间的关系

首先来看大数据、机器学习及数据挖掘三者简单的定义:

大数据通常被定义为“超出常用软件工具捕获,管理和处理能力”的数据集。

机器学习关心的问题是如何构建计算机程序使用经验自动改进。

数据挖掘是从数据中提取模式的特定算法的应用,在数据挖掘中,重点在于算法的应用,而不是算法本身。

机器学习和数据挖掘之间的关系如下:

数据挖掘是一个过程,在此过程中机器学习算法被用作提取数据集中的潜在有价值模式的工具。

大数据与深度学习关系总结如下:

(1)深度学习是一种模拟大脑的行为。可以从所学习对象的机制以及行为等等很多相关联的方面进行学习,模仿类型行为以及思维。

(2)深度学习对于大数据的发展有帮助。深度学习对于大数据技术开发的每一个阶段均有帮助,不管是数据的分析还是挖掘还是建模,只有深度学习,这些工作才会有可能一一得到实现。

(3)深度学习转变了解决问题的思维。很多时候发现问题到解决问题,走一步看一步不是一个主要的解决问题的方式了,在深度学习的基础上,要求我们从开始到最后都要基于一个目标,为了需要优化的那个最终目标去进行处理数据以及将数据放入到数据应用平台上去,这就是端到端(End to End)。

(4)大数据的深度学习需要一个框架。在大数据方面的深度学习都是从基础的角度出发的,深度学习需要一个框架或者一个系统。总而言之,将你的大数据通过深度分析变为现实,这就是深度学习和大数据的最直接关系。

1.2 机器学习学习方式

根据数据类型的不同,对一个问题的建模有不同的方式。依据不同的学习方式和输入数据,机器学习主要分为以下四种学习方式。

1.2.1 监督学习

特点:监督学习是使用已知正确答案的示例来训练网络。已知数据和其一一对应的标签,训练一个预测模型,将输入数据映射到标签的过程。

常见应用场景:监督式学习的常见应用场景如分类问题和回归问题。

算法举例:常见的有监督机器学习算法包括支持向量机(Support Vector Machine, SVM),朴素贝叶斯(Naive Bayes),逻辑回归(Logistic Regression),K近邻(K-Nearest Neighborhood, KNN),决策树(Decision Tree),随机森林(Random Forest),AdaBoost以及线性判别分析(Linear Discriminant Analysis, LDA)等。深度学习(Deep Learning)也是大多数以监督学习的方式呈现。

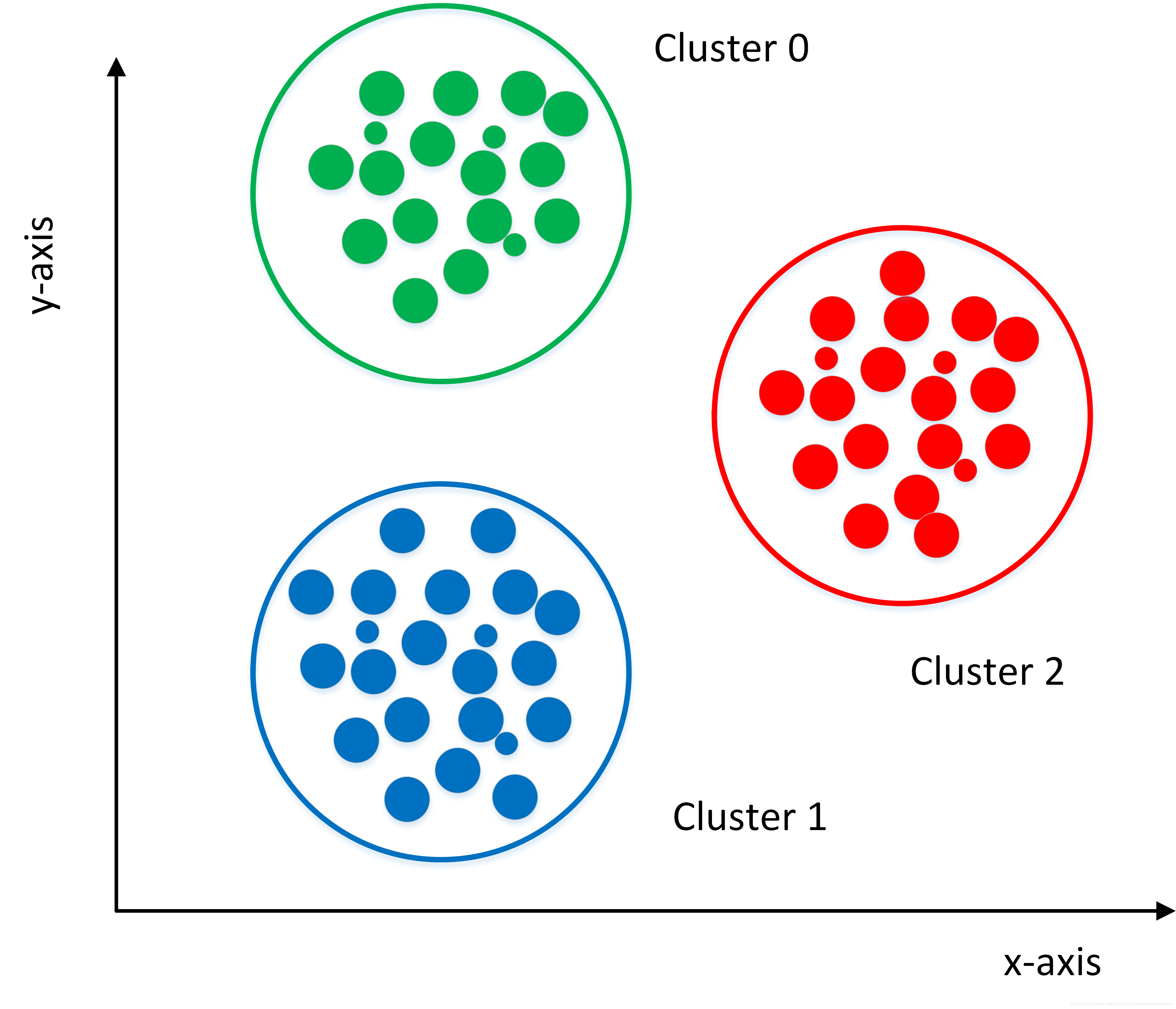

1.2.2 非监督式学习

定义:在非监督式学习中,数据并不被特别标识,适用于你具有数据集但无标签的情况。学习模型是为了推断出数据的一些内在结构。

常见应用场景:常见的应用场景包括关联规则的学习以及聚类等。

算法举例:常见算法包括Apriori算法以及k-Means算法。

1.2.3 半监督式学习

特点:在此学习方式下,输入数据部分被标记,部分没有被标记,这种学习模型可以用来进行预测。

常见应用场景:应用场景包括分类和回归,算法包括一些对常用监督式学习算法的延伸,通过对已标记数据建模,在此基础上,对未标记数据进行预测。

算法举例:常见算法如图论推理算法(Graph Inference)或者拉普拉斯支持向量机(Laplacian SVM)等。

1.2.4 弱监督学习

特点:弱监督学习可以看做是有多个标记的数据集合,次集合可以是空集,单个元素,或包含多种情况(没有标记,有一个标记,和有多个标记)的多个元素。 数据集的标签是不可靠的,这里的不可靠可以是标记不正确,多种标记,标记不充分,局部标记等。已知数据和其一一对应的弱标签,训练一个智能算法,将输入数据映射到一组更强的标签的过程。标签的强弱指的是标签蕴含的信息量的多少,比如相对于分割的标签来说,分类的标签就是弱标签。

算法举例:举例,给出一张包含气球的图片,需要得出气球在图片中的位置及气球和背景的分割线,这就是已知弱标签学习强标签的问题。

在企业数据应用的场景下, 人们最常用的可能就是监督式学习和非监督式学习的模型。 在图像识别等领域,由于存在大量的非标识的数据和少量的可标识数据, 目前半监督式学习是一个很热的话题。

1.2.5 监督学习有哪些步骤

监督学习是使用已知正确答案的示例来训练网络,每组训练数据有一个明确的标识或结果。想象一下,我们可以训练一个网络,让其从照片库中(其中包含气球的照片)识别出气球的照片。以下就是我们在这个假设场景中所要采取的步骤。

步骤1:数据集的创建和分类

首先,浏览你的照片(数据集),确定所有包含气球的照片,并对其进行标注。然后,将所有照片分为训练集和验证集。目标就是在深度网络中找一函数,这个函数输入是任意一张照片,当照片中包含气球时,输出1,否则输出0。

步骤2:数据增强(Data Augmentation)

当原始数据搜集和标注完毕,一般搜集的数据并不一定包含目标在各种扰动下的信息。数据的好坏对于机器学习模型的预测能力至关重要,因此一般会进行数据增强。对于图像数据来说,数据增强一般包括,图像旋转,平移,颜色变换,裁剪,仿射变换等。

步骤3:特征工程(Feature Engineering)

一般来讲,特征工程包含特征提取和特征选择。常见的手工特征(Hand-Crafted Feature)有尺度不变特征变换(Scale-Invariant Feature Transform, SIFT),方向梯度直方图(Histogram of Oriented Gradient, HOG)等。由于手工特征是启发式的,其算法设计背后的出发点不同,将这些特征组合在一起的时候有可能会产生冲突,如何将组合特征的效能发挥出来,使原始数据在特征空间中的判别性最大化,就需要用到特征选择的方法。在深度学习方法大获成功之后,人们很大一部分不再关注特征工程本身。因为,最常用到的卷积神经网络(Convolutional Neural Networks, CNNs)本身就是一种特征提取和选择的引擎。研究者提出的不同的网络结构、正则化、归一化方法实际上就是深度学习背景下的特征工程。

步骤4:构建预测模型和损失

将原始数据映射到特征空间之后,也就意味着我们得到了比较合理的输入。下一步就是构建合适的预测模型得到对应输入的输出。而如何保证模型的输出和输入标签的一致性,就需要构建模型预测和标签之间的损失函数,常见的损失函数(Loss Function)有交叉熵、均方差等。通过优化方法不断迭代,使模型从最初的初始化状态一步步变化为有预测能力的模型的过程,实际上就是学习的过程。

步骤5:训练

选择合适的模型和超参数进行初始化,其中超参数比如支持向量机中核函数、误差项惩罚权重等。当模型初始化参数设定好后,将制作好的特征数据输入到模型,通过合适的优化方法不断缩小输出与标签之间的差距,当迭代过程到了截止条件,就可以得到训练好的模型。优化方法最常见的就是梯度下降法及其变种,使用梯度下降法的前提是优化目标函数对于模型是可导的。

步骤6:验证和模型选择

训练完训练集图片后,需要进行模型测试。利用验证集来验证模型是否可以准确地挑选出含有气球在内的照片。

在此过程中,通常会通过调整和模型相关的各种事物(超参数)来重复步骤2和3,诸如里面有多少个节点,有多少层,使用怎样的激活函数和损失函数,如何在反向传播阶段积极有效地训练权值等等。

步骤7:测试及应用

当有了一个准确的模型,就可以将该模型部署到你的应用程序中。你可以将预测功能发布为API(Application Programming Interface, 应用程序编程接口)调用,并且你可以从软件中调用该API,从而进行推理并给出相应的结果。

1.8 分类算法

分类算法和回归算法是对真实世界不同建模的方法。分类模型是认为模型的输出是离散的,例如大自然的生物被划分为不同的种类,是离散的。回归模型的输出是连续的,例如人的身高变化过程是一个连续过程,而不是离散的。

因此,在实际建模过程时,采用分类模型还是回归模型,取决于你对任务(真实世界)的分析和理解。

1.8.1 常用分类算法的优缺点?

接下来我们介绍常用分类算法的优缺点,如表1所示。

表1 常用分类算法的优缺点

| 算法 | 优点 | 缺点 |

|---|---|---|

| Bayes 贝叶斯分类法 | 1)所需估计的参数少,对于缺失数据不敏感。 2)有着坚实的数学基础,以及稳定的分类效率。 | 1)需要假设属性之间相互独立,这往往并不成立。(喜欢吃番茄、鸡蛋,却不喜欢吃番茄炒蛋)。 2)需要知道先验概率。 3)分类决策存在错误率。 |

| Decision Tree决策树 | 1)不需要任何领域知识或参数假设。 2)适合高维数据。 3)简单易于理解。 4)短时间内处理大量数据,得到可行且效果较好的结果。 5)能够同时处理数据型和常规性属性。 | 1)对于各类别样本数量不一致数据,信息增益偏向于那些具有更多数值的特征。 2)易于过拟合。 3)忽略属性之间的相关性。 4)不支持在线学习。 |

| SVM支持向量机 | 1)可以解决小样本下机器学习的问题。 2)提高泛化性能。 3)可以解决高维、非线性问题。超高维文本分类仍受欢迎。 4)避免神经网络结构选择和局部极小的问题。 | 1)对缺失数据敏感。 2)内存消耗大,难以解释。 3)运行和调参略烦人。 |

| KNN K近邻 | 1)思想简单,理论成熟,既可以用来做分类也可以用来做回归; 2)可用于非线性分类; 3)训练时间复杂度为O(n); 4)准确度高,对数据没有假设,对outlier不敏感; | 1)计算量太大。 2)对于样本分类不均衡的问题,会产生误判。 3)需要大量的内存。 4)输出的可解释性不强。 |

| Logistic Regression逻辑回归 | 1)速度快。 2)简单易于理解,直接看到各个特征的权重。 3)能容易地更新模型吸收新的数据。 4)如果想要一个概率框架,动态调整分类阀值。 | 特征处理复杂。需要归一化和较多的特征工程。 |

| Neural Network 神经网络 | 1)分类准确率高。 2)并行处理能力强。 3)分布式存储和学习能力强。 4)鲁棒性较强,不易受噪声影响。 | 1)需要大量参数(网络拓扑、阀值、阈值)。 2)结果难以解释。 3)训练时间过长。 |

| Adaboosting | 1)adaboost是一种有很高精度的分类器。 2)可以使用各种方法构建子分类器,Adaboost算法提供的是框架。 3)当使用简单分类器时,计算出的结果是可以理解的。而且弱分类器构造极其简单。 4)简单,不用做特征筛选。 5)不用担心overfitting。 | 对outlier比较敏感 |

1.8.2 分类算法的评估方法

分类评估方法主要功能是用来评估分类算法的好坏,而评估一个分类器算法的好坏又包括许多项指标。了解各种评估方法,在实际应用中选择正确的评估方法是十分重要的。

-

几个常用术语

这里首先介绍几个常见的模型评价术语,现在假设我们的分类目标只有两类,计为正例(positive)和负例(negative)分别是:- True positives(TP): 被正确地划分为正例的个数,即实际为正例且被分类器划分为正例的实例数;

- False positives(FP): 被错误地划分为正例的个数,即实际为负例但被分类器划分为正例的实例数;

- False negatives(FN):被错误地划分为负例的个数,即实际为正例但被分类器划分为负例的实例数;

- True negatives(TN): 被正确地划分为负例的个数,即实际为负例且被分类器划分为负例的实例数。

表2 四个术语的混淆矩阵

表2-2是这四个术语的混淆矩阵,做以下说明:

1)P=TP+FN表示实际为正例的样本个数。

2)True、False描述的是分类器是否判断正确。

3)Positive、Negative是分类器的分类结果,如果正例计为1、负例计为-1,即positive=1、negative=-1。用1表示True,-1表示False,那么实际的类标=TF*PN,TF为true或false,PN为positive或negative。

4)例如True positives(TP)的实际类标=1*1=1为正例,False positives(FP)的实际类标=(-1)*1=-1为负例,False negatives(FN)的实际类标=(-1)*(-1)=1为正例,True negatives(TN)的实际类标=1*(-1)=-1为负例。

-

评价指标

-

正确率(accuracy)

正确率是我们最常见的评价指标,accuracy = (TP+TN)/(P+N),正确率是被分对的样本数在所有样本数中的占比,通常来说,正确率越高,分类器越好。 -

错误率(error rate)

错误率则与正确率相反,描述被分类器错分的比例,error rate = (FP+FN)/(P+N),对某一个实例来说,分对与分错是互斥事件,所以accuracy =1 - error rate。 -

灵敏度(sensitivity)

sensitivity = TP/P,表示的是所有正例中被分对的比例,衡量了分类器对正例的识别能力。 -

特异性(specificity)

specificity = TN/N,表示的是所有负例中被分对的比例,衡量了分类器对负例的识别能力。 -

精度(precision)

precision=TP/(TP+FP),精度是精确性的度量,表示被分为正例的示例中实际为正例的比例。 -

召回率(recall)

召回率是覆盖面的度量,度量有多个正例被分为正例,recall=TP/(TP+FN)=TP/P=sensitivity,可以看到召回率与灵敏度是一样的。 -

其他评价指标

计算速度:分类器训练和预测需要的时间;

鲁棒性:处理缺失值和异常值的能力;

可扩展性:处理大数据集的能力;

可解释性:分类器的预测标准的可理解性,像决策树产生的规则就是很容易理解的,而神经网络的一堆参数就不好理解,我们只好把它看成一个黑盒子。 -

精度和召回率反映了分类器分类性能的两个方面。如果综合考虑查准率与查全率,可以得到新的评价指标F1-score,也称为综合分类率: F 1 = 2 × p r e c i s i o n × r e c a l l p r e c i s i o n + r e c a l l F1=\frac{2 \times precision \times recall}{precision + recall} F1=precision+recall2×precision×recall。

为了综合多个类别的分类情况,评测系统整体性能,经常采用的还有微平均F1(micro-averaging)和宏平均F1(macro-averaging )两种指标。

(1)宏平均F1与微平均F1是以两种不同的平均方式求的全局F1指标。

(2)宏平均F1的计算方法先对每个类别单独计算F1值,再取这些F1值的算术平均值作为全局指标。

(3)微平均F1的计算方法是先累加计算各个类别的a、b、c、d的值,再由这些值求出F1值。

(4)由两种平均F1的计算方式不难看出,宏平均F1平等对待每一个类别,所以它的值主要受到稀有类别的影响,而微平均F1平等考虑文档集中的每一个文档,所以它的值受到常见类别的影响比较大。

-

-

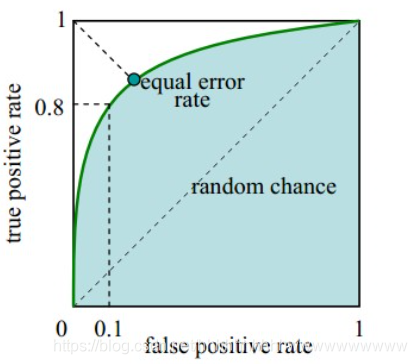

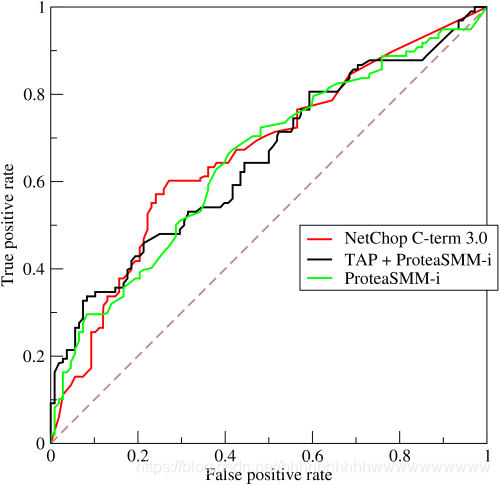

ROC曲线和PR曲线

如图3,ROC曲线是(Receiver Operating Characteristic Curve,受试者工作特征曲线)的简称,是以灵敏度(真阳性率)为纵坐标,以1减去特异性(假阳性率)为横坐标绘制的性能评价曲线。可以将不同模型对同一数据集的ROC曲线绘制在同一笛卡尔坐标系中,ROC曲线越靠近左上角,说明其对应模型越可靠。也可以通过ROC曲线下面的面积(Area Under Curve, AUC)来评价模型,AUC越大,模型越可靠。

PR曲线是Precision Recall Curve的简称,描述的是precision和recall之间的关系,以recall为横坐标,precision为纵坐标绘制的曲线。该曲线的所对应的面积AUC实际上是目标检测中常用的评价指标平均精度(Average Precision, AP)。AP越高,说明模型性能越好。

1.8.3 正确率能很好的评估分类算法吗

不同算法有不同特点,在不同数据集上有不同的表现效果,根据特定的任务选择不同的算法。如何评价分类算法的好坏,要做具体任务具体分析。对于决策树,主要用正确率去评估,但是其他算法,只用正确率能很好的评估吗?

答案是否定的。

正确率确实是一个很直观很好的评价指标,但是有时候正确率高并不能完全代表一个算法就好。比如对某个地区进行地震预测,地震分类属性分为0:不发生地震、1发生地震。我们都知道,不发生的概率是极大的,对于分类器而言,如果分类器不加思考,对每一个测试样例的类别都划分为0,达到99%的正确率,但是,问题来了,如果真的发生地震时,这个分类器毫无察觉,那带来的后果将是巨大的。很显然,99%正确率的分类器并不是我们想要的。出现这种现象的原因主要是数据分布不均衡,类别为1的数据太少,错分了类别1但达到了很高的正确率缺忽视了研究者本身最为关注的情况。

1.8.4 什么样的分类器是最好的

对某一个任务,某个具体的分类器不可能同时满足或提高所有上面介绍的指标。

如果一个分类器能正确分对所有的实例,那么各项指标都已经达到最优,但这样的分类器往往不存在。比如之前说的地震预测,既然不能百分百预测地震的发生,但实际情况中能容忍一定程度的误报。假设在1000次预测中,共有5次预测发生了地震,真实情况中有一次发生了地震,其他4次则为误报。正确率由原来的999/1000=99.9下降为996/1000=99.6。召回率由0/1=0%上升为1/1=100%。对此解释为,虽然预测失误了4次,但真的地震发生前,分类器能预测对,没有错过,这样的分类器实际意义更为重大,正是我们想要的。在这种情况下,在一定正确率前提下,要求分类器的召回率尽量高。

1.9 逻辑回归

1.9.1 回归划分

广义线性模型家族里,依据因变量不同,可以有如下划分:

(1)如果是连续的,就是多重线性回归。

(2)如果是二项分布,就是逻辑回归。

(3)如果是泊松(Poisson)分布,就是泊松回归。

(4)如果是负二项分布,就是负二项回归。

(5)逻辑回归的因变量可以是二分类的,也可以是多分类的,但是二分类的更为常用,也更加容易解释。所以实际中最常用的就是二分类的逻辑回归。

1.9.2 逻辑回归适用性

逻辑回归可用于以下几个方面:

(1)用于概率预测。用于可能性预测时,得到的结果有可比性。比如根据模型进而预测在不同的自变量情况下,发生某病或某种情况的概率有多大。

(2)用于分类。实际上跟预测有些类似,也是根据模型,判断某人属于某病或属于某种情况的概率有多大,也就是看一下这个人有多大的可能性是属于某病。进行分类时,仅需要设定一个阈值即可,可能性高于阈值是一类,低于阈值是另一类。

(3)寻找危险因素。寻找某一疾病的危险因素等。

(4)仅能用于线性问题。只有当目标和特征是线性关系时,才能用逻辑回归。在应用逻辑回归时注意两点:一是当知道模型是非线性时,不适用逻辑回归;二是当使用逻辑回归时,应注意选择和目标为线性关系的特征。

(5)各特征之间不需要满足条件独立假设,但各个特征的贡献独立计算。

1.9.3 生成模型和判别模型的区别

生成模型:由数据学习联合概率密度分布P(X,Y),然后求出条件概率分布P(Y|X)作为预测的模型,即生成模型:P(Y|X)= P(X,Y)/ P(X)(贝叶斯概率)。基本思想是首先建立样本的联合概率概率密度模型P(X,Y),然后再得到后验概率P(Y|X),再利用它进行分类。典型的生成模型有朴素贝叶斯,隐马尔科夫模型等

判别模型:由数据直接学习决策函数Y=f(X)或者条件概率分布P(Y|X)作为预测的模型,即判别模型。基本思想是有限样本条件下建立判别函数,不考虑样本的产生模型,直接研究预测模型。典型的判别模型包括k近邻,感知级,决策树,支持向量机等。这些模型的特点都是输入属性X可以直接得到后验概率P(Y|X),输出条件概率最大的作为最终的类别(对于二分类任务来说,实际得到一个score,当score大于threshold时则为正类,否则为负类)。

举例:

判别式模型举例:要确定一个羊是山羊还是绵羊,用判别模型的方法是从历史数据中学习到模型,然后通过提取这只羊的特征来预测出这只羊是山羊的概率,是绵羊的概率。

生成式模型举例:利用生成模型是根据山羊的特征首先学习出一个山羊的模型,然后根据绵羊的特征学习出一个绵羊的模型,然后从这只羊中提取特征,放到山羊模型中看概率是多少,在放到绵羊模型中看概率是多少,哪个大就是哪个。

联系和区别:

生成方法的特点:上面说到,生成方法学习联合概率密度分布P(X,Y),所以就可以从统计的角度表示数据的分布情况,能够反映同类数据本身的相似度。但它不关心到底划分各类的那个分类边界在哪。生成方法可以还原出联合概率分布P(Y,X),而判别方法不能。生成方法的学习收敛速度更快,即当样本容量增加的时候,学到的模型可以更快的收敛于真实模型,当存在隐变量时,仍可以用生成方法学习。此时判别方法就不能用。

判别方法的特点:判别方法直接学习的是决策函数Y=f(X)或者条件概率分布P(Y|X)。不能反映训练数据本身的特性。但它寻找不同类别之间的最优分类面,反映的是异类数据之间的差异。直接面对预测,往往学习的准确率更高。由于直接学习P(Y|X)或P(X),可以对数据进行各种程度上的抽象、定义特征并使用特征,因此可以简化学习问题。

最后,由生成模型可以得到判别模型,但由判别模型得不到生成模型。

1.9.4 逻辑回归与朴素贝叶斯有什么区别

逻辑回归与朴素贝叶斯区别有以下几个方面:

(1)逻辑回归是判别模型, 朴素贝叶斯是生成模型,所以生成和判别的所有区别它们都有。

(2)朴素贝叶斯属于贝叶斯,逻辑回归是最大似然,两种概率哲学间的区别。

(3)朴素贝叶斯需要条件独立假设。

(4)逻辑回归需要求特征参数间是线性的。

1.9.5 线性回归与逻辑回归的区别

线性回归与逻辑回归的区别如下描述:

(1)线性回归的样本的输出,都是连续值,$ y\in (-\infty ,+\infty ) , 而 逻 辑 回 归 中 ,而逻辑回归中 ,而逻辑回归中y\in (0,1)$,只能取0和1。

(2)对于拟合函数也有本质上的差别:

线性回归: f ( x ) = θ T x = θ 1 x 1 + θ 2 x 2 + . . . + θ n x n f(x)=\theta ^{T}x=\theta _{1}x _{1}+\theta _{2}x _{2}+...+\theta _{n}x _{n} f(x)=θTx=θ1x1+θ2x2+...+θnxn

逻辑回归: f ( x ) = P ( y = 1 ∣ x ; θ ) = g ( θ T x ) f(x)=P(y=1|x;\theta )=g(\theta ^{T}x) f(x)=P(y=1∣x;θ)=g(θTx),其中, g ( z ) = 1 1 + e − z g(z)=\frac{1}{1+e^{-z}} g(z)=1+e−z1

可以看出,线性回归的拟合函数,是对f(x)的输出变量y的拟合,而逻辑回归的拟合函数是对为1类样本的概率的拟合。

那么,为什么要以1类样本的概率进行拟合呢,为什么可以这样拟合呢?

θ T x = 0 \theta ^{T}x=0 θTx=0就相当于是1类和0类的决策边界:

当 θ T x > 0 \theta ^{T}x>0 θTx>0,则y>0.5;若$\theta ^{T}x\rightarrow +\infty , 则 ,则 ,则y \rightarrow 1 $,即y为1类;

当 θ T x < 0 \theta ^{T}x<0 θTx<0,则y<0.5;若$\theta ^{T}x\rightarrow -\infty , 则 ,则 ,则y \rightarrow 0 $,即y为0类;

这个时候就能看出区别,在线性回归中 θ T x \theta ^{T}x θTx为预测值的拟合函数;而在逻辑回归中 θ T x \theta ^{T}x θTx为决策边界。下表2-3为线性回归和逻辑回归的区别。

表2-3 线性回归和逻辑回归的区别

| 线性回归 | 逻辑回归 | |

|---|---|---|

| 目的 | 预测 | 分类 |

| y ( i ) y^{(i)} y(i) | 未知 | (0,1) |

| 函数 | 拟合函数 | 预测函数 |

| 参数计算方式 | 最小二乘法 | 极大似然估计 |

下面具体解释一下:

- 拟合函数和预测函数什么关系呢?简单来说就是将拟合函数做了一个逻辑函数的转换,转换后使得 y ( i ) ∈ ( 0 , 1 ) y^{(i)} \in (0,1) y(i)∈(0,1);

- 最小二乘和最大似然估计可以相互替代吗?回答当然是不行了。我们来看看两者依仗的原理:最大似然估计是计算使得数据出现的可能性最大的参数,依仗的自然是Probability。而最小二乘是计算误差损失。

1.10 代价函数

1.10.1 为什么需要代价函数

- 为了得到训练逻辑回归模型的参数,需要一个代价函数,通过训练代价函数来得到参数。

- 用于找到最优解的目的函数。

1.10.2 代价函数作用原理

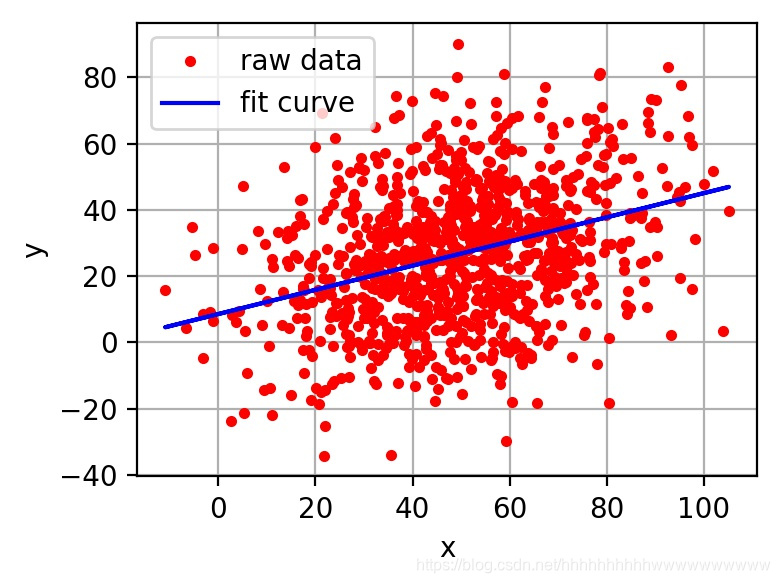

在回归问题中,通过代价函数来求解最优解,常用的是平方误差代价函数。假设函数图像如图4所示,当参数发生变化时,假设函数状态也会随着变化。

想要拟合图中的离散点,我们需要尽可能找到最优的

A

A

A和

B

B

B来使这条直线更能代表所有数据。如何找到最优解呢,这就需要使用代价函数来求解,以平方误差代价函数为例,假设函数为

h

(

x

)

=

θ

0

x

h(x)=\theta_0x

h(x)=θ0x。

平方误差代价函数的主要思想就是将实际数据给出的值与拟合出的线的对应值做差,求出拟合出的直线与实际的差距。在实际应用中,为了避免因个别极端数据产生的影响,采用类似方差再取二分之一的方式来减小个别数据的影响。因此,引出代价函数:

J

(

θ

0

,

θ

1

)

=

1

m

∑

i

=

1

m

(

h

(

x

(

i

)

)

−

y

(

i

)

)

2

J(\theta_0, \theta_1) = \frac{1}{m}\sum_{i=1}^m(h(x^{(i)})-y^{(i)})^2

J(θ0,θ1)=m1i=1∑m(h(x(i))−y(i))2

最优解即为代价函数的最小值

min

J

(

θ

0

,

θ

1

)

\min J(\theta_0, \theta_1)

minJ(θ0,θ1)。如果是1个参数,代价函数一般通过二维曲线便可直观看出。如果是2个参数,代价函数通过三维图像可看出效果,参数越多,越复杂。

当参数为2个时,代价函数是三维图像,如下图2-5所示。

1.10.3 为什么代价函数要非负

目标函数存在一个下界,在优化过程当中,如果优化算法能够使目标函数不断减小,根据单调有界准则,这个优化算法就能证明是收敛有效的。

只要设计的目标函数有下界,基本上都可以,代价函数非负更为方便。

1.10.4 常见代价函数

(1)二次代价函数(quadratic cost):

J

=

1

2

n

∑

x

∥

y

(

x

)

−

a

L

(

x

)

∥

2

J = \frac{1}{2n}\sum_x\Vert y(x)-a^L(x)\Vert^2

J=2n1x∑∥y(x)−aL(x)∥2

其中,

J

J

J表示代价函数,

x

x

x表示样本,

y

y

y表示实际值,

a

a

a表示输出值,

n

n

n表示样本的总数。使用一个样本为例简单说明,此时二次代价函数为:

J

=

(

y

−

a

)

2

2

J = \frac{(y-a)^2}{2}

J=2(y−a)2

假如使用梯度下降法(Gradient descent)来调整权值参数的大小,权值

w

w

w和偏置

b

b

b的梯度推导如下:

∂

J

∂

w

=

(

y

−

a

)

σ

′

(

z

)

x

,

∂

J

∂

b

=

(

y

−

a

)

σ

′

(

z

)

\frac{\partial J}{\partial w}=(y-a)\sigma'(z)x\;, \frac{\partial J}{\partial b}=(y-a)\sigma'(z)

∂w∂J=(y−a)σ′(z)x,∂b∂J=(y−a)σ′(z)

其中,

z

z

z表示神经元的输入,

σ

\sigma

σ表示激活函数。权值

w

w

w和偏置

b

b

b的梯度跟激活函数的梯度成正比,激活函数的梯度越大,权值

w

w

w和偏置

b

b

b的大小调整得越快,训练收敛得就越快。

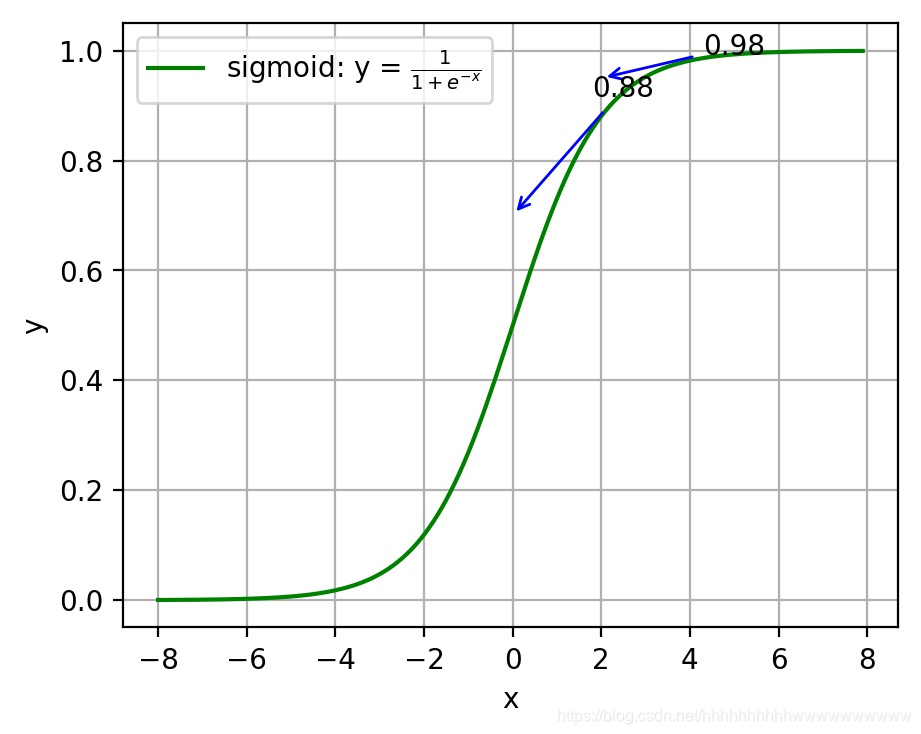

注:神经网络常用的激活函数为sigmoid函数,该函数的曲线如下图6所示:

如上图所示,对0.88和0.98两个点进行比较:

假设目标是收敛到1.0。0.88离目标1.0比较远,梯度比较大,权值调整比较大。0.98离目标1.0比较近,梯度比较小,权值调整比较小。调整方案合理。

假如目标是收敛到0。0.88离目标0比较近,梯度比较大,权值调整比较大。0.98离目标0比较远,梯度比较小,权值调整比较小。调整方案不合理。

原因:在使用sigmoid函数的情况下, 初始的代价(误差)越大,导致训练越慢。

(2)交叉熵代价函数(cross-entropy):

J

=

−

1

n

∑

x

[

y

ln

a

+

(

1

−

y

)

ln

(

1

−

a

)

]

J = -\frac{1}{n}\sum_x[y\ln a + (1-y)\ln{(1-a)}]

J=−n1x∑[ylna+(1−y)ln(1−a)]

其中,

J

J

J表示代价函数,

x

x

x表示样本,

y

y

y表示实际值,

a

a

a表示输出值,

n

n

n表示样本的总数。

权值

w

w

w和偏置

b

b

b的梯度推导如下:

∂

J

∂

w

j

=

1

n

∑

x

x

j

(

σ

(

z

)

−

y

)

,

∂

J

∂

b

=

1

n

∑

x

(

σ

(

z

)

−

y

)

\frac{\partial J}{\partial w_j}=\frac{1}{n}\sum_{x}x_j(\sigma{(z)}-y)\;, \frac{\partial J}{\partial b}=\frac{1}{n}\sum_{x}(\sigma{(z)}-y)

∂wj∂J=n1x∑xj(σ(z)−y),∂b∂J=n1x∑(σ(z)−y)

当误差越大时,梯度就越大,权值

w

w

w和偏置

b

b

b调整就越快,训练的速度也就越快。

二次代价函数适合输出神经元是线性的情况,交叉熵代价函数适合输出神经元是S型函数的情况。

(3)对数似然代价函数(log-likelihood cost):

对数似然函数常用来作为softmax回归的代价函数。深度学习中普遍的做法是将softmax作为最后一层,此时常用的代价函数是对数似然代价函数。

对数似然代价函数与softmax的组合和交叉熵与sigmoid函数的组合非常相似。对数似然代价函数在二分类时可以化简为交叉熵代价函数的形式。

在tensorflow中:

与sigmoid搭配使用的交叉熵函数:tf.nn.sigmoid_cross_entropy_with_logits()。

与softmax搭配使用的交叉熵函数:tf.nn.softmax_cross_entropy_with_logits()。

在pytorch中:

与sigmoid搭配使用的交叉熵函数:torch.nn.BCEWithLogitsLoss()。

与softmax搭配使用的交叉熵函数:torch.nn.CrossEntropyLoss()。

对数似然函数:

我们将似然函数作为机器学习模型的损失函数,并且用在分类问题中。这时似然函数是直接作用于模型的输出的(损失函数就是为了衡量当前参数下model的预测值predict距离真实值label的大小,所以似然函数用作损失函数时当然也是为了完成该任务),所以对于似然函数来说,这里的样本集就成了label集(而不是机器学习意义上的样本集X了),这里的参数也不是机器学习model 的参数,而是predict值。

其实作为损失函数的似然函数并不关心你当前的机器学习model的参数是怎样的,毕竟它此时所接收的输入只有两部分:1、predict。2、label 。3、分布模型(predict服从的分布)。

显然这里的label就是似然函数的观测值,即样本集。而它眼里的模型,当然就是predict这个随机变量所服从的概率分布模型。它的目的,就是衡量predict背后的模型对于当前观测值的解释程度。而每个样本的predict值,恰恰就是它所服从的分布模型的参数。

比如此时我们的机器学习任务是一个4个类别的分类任务,机器学习model的输出就是当前样本X下的每个类别的概率,如predict=[0.1, 0.1, 0.7, 0.1],而该样本的标签是类别3,表示成向量就是label=[0, 0, 1, 0]。那么label=[0, 0, 1, 0]就是似然函数眼里的样本,然后我们可以假设predict这个随机变量背后的模型是单次观测下的多项式分布,(因为softmax本身是基于多项式分布的)。

回顾:

伯努利分布,也叫做(0,1)分布,贝努利分布可以看成是将一枚硬币(只有正反两个面,代表两个类别)向上扔出,出现某个面(类别)的概率情况,因此其概率密度函数为:

f

(

x

)

=

p

x

(

1

−

p

)

1

−

x

=

{

p

,

x

=

1

q

,

x

=

0

f(x)=p^x(1-p)^{1-x}= \begin{cases} p,& x=1\\ q,& x=0 \end{cases}

f(x)=px(1−p)1−x={p,q,x=1x=0

这是理解似然函数做损失函数的关键!另外,贝努利分布的模型参数就是其中一个类别的发生概率。

而二项分布呢,就是将贝努利实验重复n次(各次实验之间是相互独立的)。

而多项式分布呢,就是将二项分布推广到多个面(类别)。

所以,单次观测下的多项式分布就是贝努利分布的多类推广!即:

f

m

u

l

i

t

(

x

;

p

)

=

∏

i

=

1

C

p

i

x

i

f_{mulit}(x;p)=\prod_{i=1}^C p_{i}^{xi}

fmulit(x;p)=i=1∏Cpixi

其中,C代表类别数。p代表向量形式的模型参数,即各个类别的发生概率,如p=[0.1, 0.1, 0.7, 0.1],则p1=0.1, p3=0.7等。即,多项式分布的模型参数就是各个类别的发生概率!x代表one-hot形式的观测值,如x=类别3,则x=[0, 0, 1, 0]。xi代表x的第i个元素,比如x=类别3时,x1=0,x2=0,x3=1,x4=0。

想一下,机器学习model对某个样本的输出,就代表各个类别发生的概率。但是,对于当前这一个样本而言,它肯定只能有一个类别,所以这一个样本就可以看成是一次实验(观察),而这次实验(观察)的结果要服从上述各个类别发生的概率,那不就是服从多项式分布嘛!而且是单次观察!各个类别发生的概率predict当然就是这个多项式分布的参数。

总结一下,对于多类分类问题,似然函数就是衡量当前这个以predict为参数的单次观测下的多项式分布模型与样本值label之间的似然度。

所以,根据似然函数的定义,单个样本的似然函数即:

L

=

f

m

u

l

i

t

(

l

a

b

e

l

;

p

r

e

d

i

c

t

)

L = f_{mulit}(label;predict)

L=fmulit(label;predict)

所以,整个样本集(或者一个batch)的似然函数即:

L

=

∏

X

f

m

u

l

t

i

(

l

a

b

e

l

;

p

r

e

d

i

c

t

)

=

∏

X

∏

i

=

1

C

p

r

e

d

i

c

t

(

i

)

l

a

b

e

l

(

i

)

L=\prod_{X}f_{multi}(label;predict)= \prod_{X}\prod_{i=1}^{C}predict(i)^{label(i)}

L=X∏fmulti(label;predict)=X∏i=1∏Cpredict(i)label(i)

所以在累乘号前面加上log函数后,就成了所谓的对数似然函数:

L

=

∑

X

∑

i

=

1

C

l

a

b

e

l

(

i

)

l

o

g

(

p

r

e

d

i

c

t

(

i

)

)

L=\sum_{X}\sum_{i=1}^{C}label(i)log(predict(i))

L=X∑i=1∑Clabel(i)log(predict(i))

而最大化对数似然函数就等效于最小化负对数似然函数,所以前面加个负号就和交叉熵的形式相同的了。

交叉熵定义:对于某种分布的随机变量X~p(x), 有一个模型q(x)用于近似p(x)的概率分布,则分布X与模型q之间的交叉熵即:

H

(

X

,

q

)

=

−

∑

x

p

(

x

)

l

o

g

q

(

x

)

H(X,q)=-\sum_{x}p(x)logq(x)

H(X,q)=−x∑p(x)logq(x)

这里X的分布模型即样本集label的真实分布模型,这里模型q(x)即想要模拟真实分布模型的机器学习模型。可以说交叉熵是直接衡量两个分布,或者说两个model之间的差异。而似然函数则是解释以model的输出为参数的某分布模型对样本集的解释程度。因此,可以说这两者是“同貌不同源”,但是“殊途同归”啦。

tips:

最大似然估计:

给定一堆数据,假如我们知道它是从某一种分布中随机取出来的,可是我们并不知道这个分布具体的参,即“模型已定,参数未知”。例如,我们知道这个分布是正态分布,但是不知道均值和方差;或者是二项分布,但是不知道均值。最大似然估计(MLE,Maximum Likelihood Estimation)就可以用来估计模型的参数。MLE的目标是找出一组参数,使得模型产生出观测数据的概率最大。

1.10.5 为什么用交叉熵代替二次代价函数

(1)为什么不用二次方代价函数

由上一节可知,权值

w

w

w和偏置

b

b

b的偏导数为

∂

J

∂

w

=

(

a

−

y

)

σ

′

(

z

)

x

\frac{\partial J}{\partial w}=(a-y)\sigma'(z)x

∂w∂J=(a−y)σ′(z)x,

∂

J

∂

b

=

(

a

−

y

)

σ

′

(

z

)

\frac{\partial J}{\partial b}=(a-y)\sigma'(z)

∂b∂J=(a−y)σ′(z), 偏导数受激活函数的导数影响,sigmoid函数导数在输出接近0和1时非常小,会导致一些实例在刚开始训练时学习得非常慢。

(2)为什么要用交叉熵

交叉熵函数权值

w

w

w和偏置

b

b

b的梯度推导为:

∂

J

∂

w

j

=

1

n

∑

x

x

j

(

σ

(

z

)

−

y

)

,

∂

J

∂

b

=

1

n

∑

x

(

σ

(

z

)

−

y

)

\frac{\partial J}{\partial w_j}=\frac{1}{n}\sum_{x}x_j(\sigma{(z)}-y)\;, \frac{\partial J}{\partial b}=\frac{1}{n}\sum_{x}(\sigma{(z)}-y)

∂wj∂J=n1x∑xj(σ(z)−y),∂b∂J=n1x∑(σ(z)−y)

由以上公式可知,权重学习的速度受到 σ ( z ) − y \sigma{(z)}-y σ(z)−y影响,更大的误差,就有更快的学习速度,避免了二次代价函数方程中因 σ ′ ( z ) \sigma'{(z)} σ′(z)导致的学习缓慢的情况。

1.11 损失函数

1.11.1 什么是损失函数

损失函数(Loss Function)又叫做误差函数,用来衡量算法的运行情况,估量模型的预测值与真实值的不一致程度,是一个非负实值函数,通常使用$

L(Y, f(x))$来表示。损失函数越小,模型的鲁棒性就越好。损失函数是经验风险函数的核心部分,也是结构风险函数重要组成部分。

1.11.2 常见的损失函数

机器学习通过对算法中的目标函数进行不断求解优化,得到最终想要的结果。分类和回归问题中,通常使用损失函数或代价函数作为目标函数。

损失函数用来评价预测值和真实值不一样的程度。通常损失函数越好,模型的性能也越好。

损失函数可分为经验风险损失函数和结构风险损失函数。经验风险损失函数指预测结果和实际结果的差别,结构风险损失函数是在经验风险损失函数上加上正则项。

下面介绍常用的损失函数:

(1)0-1损失函数

如果预测值和目标值相等,值为0,如果不相等,值为1。

L

(

Y

,

f

(

x

)

)

=

{

1

,

Y

≠

f

(

x

)

0

,

Y

=

f

(

x

)

L(Y, f(x)) = \begin{cases} 1,& Y\ne f(x)\\ 0,& Y = f(x) \end{cases}

L(Y,f(x))={1,0,Y=f(x)Y=f(x)

一般的在实际使用中,相等的条件过于严格,可适当放宽条件:

L ( Y , f ( x ) ) = { 1 , ∣ Y − f ( x ) ∣ ⩾ T 0 , ∣ Y − f ( x ) ∣ < T L(Y, f(x)) = \begin{cases} 1,& |Y-f(x)|\geqslant T\\ 0,& |Y-f(x)|< T \end{cases} L(Y,f(x))={1,0,∣Y−f(x)∣⩾T∣Y−f(x)∣<T

(2)绝对值损失函数

和0-1损失函数相似,绝对值损失函数表示为:

L

(

Y

,

f

(

x

)

)

=

∣

Y

−

f

(

x

)

∣

L(Y, f(x)) = |Y-f(x)|

L(Y,f(x))=∣Y−f(x)∣

(3)平方损失函数

L

(

Y

,

f

(

x

)

)

=

∑

N

(

Y

−

f

(

x

)

)

2

L(Y, f(x)) = \sum_N{(Y-f(x))}^2

L(Y,f(x))=N∑(Y−f(x))2

这点可从最小二乘法和欧几里得距离角度理解。最小二乘法的原理是,最优拟合曲线应该使所有点到回归直线的距离和最小。

(4)对数损失函数

L

(

Y

,

P

(

Y

∣

X

)

)

=

−

log

P

(

Y

∣

X

)

=

−

1

N

∑

i

=

1

N

∑

j

=

1

M

y

i

j

l

o

g

(

p

i

j

)

L(Y, P(Y|X)) = -\log{P(Y|X)}=-\frac{1}{N}\sum_{i=1}^N\sum_{j=1}^M y_{ij}log(p_{ij})

L(Y,P(Y∣X))=−logP(Y∣X)=−N1i=1∑Nj=1∑Myijlog(pij)

其中, Y 为输出变量, X为输入变量, L 为损失函数. N为输入样本量, M为可能的类别数, y i j y_{ij} yij 是一个二值指标, 表示类别 j 是否是输入实例 xi 的真实类别. p i j p_{ij} pij 为模型或分类器预测输入实例 xi 属于类别 j 的概率.

常见的逻辑回归使用的就是对数损失函数,有很多人认为逻辑回归的损失函数是平方损失,其实不然。逻辑回归它假设样本服从伯努利分布(0-1分布),进而求得满足该分布的似然函数,接着取对数求极值等。逻辑回归推导出的经验风险函数是最小化负的似然函数,从损失函数的角度看,就是对数损失函数。形式上等价于二分类的交叉熵损失函数。

(6)指数损失函数

指数损失函数的标准形式为:

L

(

Y

,

f

(

x

)

)

=

exp

(

−

Y

f

(

x

)

)

L(Y, f(x)) = \exp(-Yf(x))

L(Y,f(x))=exp(−Yf(x))

例如AdaBoost就是以指数损失函数为损失函数。

(7)Hinge损失函数

Hinge损失函数的标准形式如下:

L

(

y

)

=

max

(

0

,

1

−

t

y

)

L(y) = \max{(0, 1-ty)}

L(y)=max(0,1−ty)

统一的形式:

L

(

Y

,

f

(

x

)

)

=

max

(

0

,

Y

f

(

x

)

)

L(Y, f(x)) = \max{(0, Yf(x))}

L(Y,f(x))=max(0,Yf(x))

其中y是预测值,范围为(-1,1),t为目标值,其为-1或1。

在线性支持向量机中,最优化问题可等价于

w , b min ∑ i = 1 N ( 1 − y i ( w x i + b ) ) + λ ∥ w ∥ 2 \underset{\min}{w,b}\sum_{i=1}^N (1-y_i(wx_i+b))+\lambda\Vert w\Vert ^2 minw,bi=1∑N(1−yi(wxi+b))+λ∥w∥2

上式相似于下式

1 m ∑ i = 1 N l ( w x i + b y i ) + ∥ w ∥ 2 \frac{1}{m}\sum_{i=1}^{N}l(wx_i+by_i) + \Vert w\Vert ^2 m1i=1∑Nl(wxi+byi)+∥w∥2

其中 l ( w x i + b y i ) l(wx_i+by_i) l(wxi+byi)是Hinge损失函数, ∥ w ∥ 2 \Vert w\Vert ^2 ∥w∥2可看做为正则化项。

1.11.3 逻辑回归为什么使用对数损失函数

假设逻辑回归模型

P

(

y

=

1

∣

x

;

θ

)

=

1

1

+

e

−

θ

T

x

P(y=1|x;\theta)=\frac{1}{1+e^{-\theta^{T}x}}

P(y=1∣x;θ)=1+e−θTx1

假设逻辑回归模型的概率分布是伯努利分布,其概率质量函数为:

P

(

X

=

n

)

=

{

1

−

p

,

n

=

0

p

,

n

=

1

P(X=n)= \begin{cases} 1-p, n=0\\ p,n=1 \end{cases}

P(X=n)={1−p,n=0p,n=1

其似然函数为:

L

(

θ

)

=

∏

i

=

1

m

P

(

y

=

1

∣

x

i

)

y

i

P

(

y

=

0

∣

x

i

)

1

−

y

i

L(\theta)=\prod_{i=1}^{m} P(y=1|x_i)^{y_i}P(y=0|x_i)^{1-y_i}

L(θ)=i=1∏mP(y=1∣xi)yiP(y=0∣xi)1−yi

对数似然函数为:

ln

L

(

θ

)

=

∑

i

=

1

m

[

y

i

ln

P

(

y

=

1

∣

x

i

)

+

(

1

−

y

i

)

ln

P

(

y

=

0

∣

x

i

)

]

=

∑

i

=

1

m

[

y

i

ln

P

(

y

=

1

∣

x

i

)

+

(

1

−

y

i

)

ln

(

1

−

P

(

y

=

1

∣

x

i

)

)

]

\ln L(\theta)=\sum_{i=1}^{m}[y_i\ln{P(y=1|x_i)}+(1-y_i)\ln{P(y=0|x_i)}]\\ =\sum_{i=1}^m[y_i\ln{P(y=1|x_i)}+(1-y_i)\ln(1-P(y=1|x_i))]

lnL(θ)=i=1∑m[yilnP(y=1∣xi)+(1−yi)lnP(y=0∣xi)]=i=1∑m[yilnP(y=1∣xi)+(1−yi)ln(1−P(y=1∣xi))]

对数函数在单个数据点上的定义为:

c

o

s

t

(

y

,

p

(

y

∣

x

)

)

=

−

y

ln

p

(

y

∣

x

)

−

(

1

−

y

)

ln

(

1

−

p

(

y

∣

x

)

)

cost(y,p(y|x))=-y\ln{p(y|x)-(1-y)\ln(1-p(y|x))}

cost(y,p(y∣x))=−ylnp(y∣x)−(1−y)ln(1−p(y∣x))

则全局样本损失函数为:

c

o

s

t

(

y

,

p

(

y

∣

x

)

)

=

−

∑

i

=

1

m

[

y

i

ln

p

(

y

i

∣

x

i

)

+

(

1

−

y

i

)

ln

(

1

−

p

(

y

i

∣

x

i

)

)

]

cost(y,p(y|x)) = -\sum_{i=1}^m[y_i\ln p(y_i|x_i)+(1-y_i)\ln(1-p(y_i|x_i))]

cost(y,p(y∣x))=−i=1∑m[yilnp(yi∣xi)+(1−yi)ln(1−p(yi∣xi))]

由此可看出,对数损失函数与极大似然估计的对数似然函数本质上是相同的。所以逻辑回归直接采用对数损失函数。

1.11.4 对数损失函数是如何度量损失的

例如,在高斯分布中,我们需要确定均值和标准差。

如何确定这两个参数?最大似然估计是比较常用的方法。最大似然的目标是找到一些参数值,这些参数值对应的分布可以最大化观测到数据的概率。

因为需要计算观测到所有数据的全概率,即所有观测到的数据点的联合概率。现考虑如下简化情况:

(1)假设观测到每个数据点的概率和其他数据点的概率是独立的。

(2)取自然对数。

假设观测到单个数据点

x

i

(

i

=

1

,

2

,

.

.

.

n

)

x_i(i=1,2,...n)

xi(i=1,2,...n)的概率为:

P

(

x

i

;

μ

,

σ

)

=

1

σ

2

π

exp

(

−

(

x

i

−

μ

)

2

2

σ

2

)

P(x_i;\mu,\sigma)=\frac{1}{\sigma \sqrt{2\pi}}\exp \left( - \frac{(x_i-\mu)^2}{2\sigma^2} \right)

P(xi;μ,σ)=σ2π

1exp(−2σ2(xi−μ)2)

(3)其联合概率为:

P

(

x

1

,

x

2

,

.

.

.

,

x

n

;

μ

,

σ

)

=

1

σ

2

π

exp

(

−

(

x

1

−

μ

)

2

2

σ

2

)

×

1

σ

2

π

exp

(

−

(

x

2

−

μ

)

2

2

σ

2

)

×

.

.

.

×

1

σ

2

π

exp

(

−

(

x

n

−

μ

)

2

2

σ

2

)

P(x_1,x_2,...,x_n;\mu,\sigma)=\frac{1}{\sigma \sqrt{2\pi}}\exp \left( - \frac{(x_1-\mu)^2}{2\sigma^2} \right) \\ \times \frac{1}{\sigma \sqrt{2\pi}}\exp \left( - \frac{(x_2-\mu)^2}{2\sigma^2} \right) \times ... \times \frac{1}{\sigma \sqrt{2\pi}}\exp \left( - \frac{(x_n-\mu)^2}{2\sigma^2} \right)

P(x1,x2,...,xn;μ,σ)=σ2π

1exp(−2σ2(x1−μ)2)×σ2π

1exp(−2σ2(x2−μ)2)×...×σ2π

1exp(−2σ2(xn−μ)2)

对上式取自然对数,可得:

ln

(

P

(

x

1

,

x

2

,

.

.

.

x

n

;

μ

,

σ

)

)

=

ln

(

1

σ

2

π

)

−

(

x

1

−

μ

)

2

2

σ

2

+

ln

(

1

σ

2

π

)

−

(

x

2

−

μ

)

2

2

σ

2

+

.

.

.

+

ln

(

1

σ

2

π

)

−

(

x

n

−

μ

)

2

2

σ

2

\ln(P(x_1,x_2,...x_n;\mu,\sigma))= \ln \left(\frac{1}{\sigma \sqrt{2\pi}} \right) - \frac{(x_1-\mu)^2}{2\sigma^2} \\ + \ln \left( \frac{1}{\sigma \sqrt{2\pi}} \right) - \frac{(x_2-\mu)^2}{2\sigma^2} +...+ \ln \left( \frac{1}{\sigma \sqrt{2\pi}} \right) - \frac{(x_n-\mu)^2}{2\sigma^2}

ln(P(x1,x2,...xn;μ,σ))=ln(σ2π

1)−2σ2(x1−μ)2+ln(σ2π

1)−2σ2(x2−μ)2+...+ln(σ2π

1)−2σ2(xn−μ)2

根据对数定律,上式可以化简为:

ln

(

P

(

x

1

,

x

2

,

.

.

.

x

n

;

μ

,

σ

)

)

=

−

n

ln

(

σ

)

−

n

2

ln

(

2

π

)

−

1

2

σ

2

[

(

x

1

−

μ

)

2

+

(

x

2

−

μ

)

2

+

.

.

.

+

(

x

n

−

μ

)

2

]

\ln(P(x_1,x_2,...x_n;\mu,\sigma))=-n\ln(\sigma)-\frac{n}{2} \ln(2\pi)\\ -\frac{1}{2\sigma^2}[(x_1-\mu)^2+(x_2-\mu)^2+...+(x_n-\mu)^2]

ln(P(x1,x2,...xn;μ,σ))=−nln(σ)−2nln(2π)−2σ21[(x1−μ)2+(x2−μ)2+...+(xn−μ)2]

然后求导为:

∂

ln

(

P

(

x

1

,

x

2

,

.

.

.

,

x

n

;

μ

,

σ

)

)

∂

μ

=

n

σ

2

[

μ

−

(

x

1

+

x

2

+

.

.

.

+

x

n

)

]

\frac{\partial\ln(P(x_1,x_2,...,x_n;\mu,\sigma))}{\partial\mu}= \frac{n}{\sigma^2}[\mu - (x_1+x_2+...+x_n)]

∂μ∂ln(P(x1,x2,...,xn;μ,σ))=σ2n[μ−(x1+x2+...+xn)]

上式左半部分为对数损失函数。损失函数越小越好,因此我们令等式左半的对数损失函数为0,可得:

μ

=

x

1

+

x

2

+

.

.

.

+

x

n

n

\mu=\frac{x_1+x_2+...+x_n}{n}

μ=nx1+x2+...+xn

同理,可计算

σ

\sigma

σ。

1.12 梯度下降

1.12.1 机器学习中为什么需要梯度下降

梯度下降是机器学习中常见优化算法之一,梯度下降法有以下几个作用:

(1)梯度下降是迭代法的一种,可以用于求解最小二乘问题。

(2)在求解机器学习算法的模型参数,即无约束优化问题时,主要有梯度下降法(Gradient Descent)和最小二乘法。

(3)在求解损失函数的最小值时,可以通过梯度下降法来一步步的迭代求解,得到最小化的损失函数和模型参数值。

(4)如果我们需要求解损失函数的最大值,可通过梯度上升法来迭代。梯度下降法和梯度上升法可相互转换。

(5)在机器学习中,梯度下降法主要有随机梯度下降法和批量梯度下降法。

1.12.2 梯度下降法缺点

梯度下降法缺点有以下几点:

(1)靠近极小值时收敛速度减慢。

(2)直线搜索时可能会产生一些问题。

(3)可能会“之字形”地下降。

梯度概念也有需注意的地方:

(1)梯度是一个向量,即有方向有大小。

(2)梯度的方向是最大方向导数的方向。

(3)梯度的值是最大方向导数的值。

1.12.3 梯度下降法直观理解

梯度下降法经典图示如下图7所示:

形象化举例,由上图7所示,假如最开始,我们在一座大山上的某处位置,因为到处都是陌生的,不知道下山的路,所以只能摸索着根据直觉,走一步算一步,在此过程中,每走到一个位置的时候,都会求解当前位置的梯度,沿着梯度的负方向,也就是当前最陡峭的位置向下走一步,然后继续求解当前位置梯度,向这一步所在位置沿着最陡峭最易下山的位置走一步。不断循环求梯度,就这样一步步地走下去,一直走到我们觉得已经到了山脚。当然这样走下去,有可能我们不能走到山脚,而是到了某一个局部的山势低处。

由此,从上面的解释可以看出,梯度下降不一定能够找到全局的最优解,有可能是一个局部的最优解。当然,如果损失函数是凸函数,梯度下降法得到的解就一定是全局最优解。

核心思想归纳:

(1)初始化参数,随机选取取值范围内的任意数;

(2)迭代操作:

a)计算当前梯度;

b)修改新的变量;

c)计算朝最陡的下坡方向走一步;

d)判断是否需要终止,如否,返回a);

(3)得到全局最优解或者接近全局最优解。

1.12.4 梯度下降法算法描述

梯度下降法算法步骤如下:

(1)确定优化模型的假设函数及损失函数。

举例,对于线性回归,假设函数为:

h

θ

(

x

1

,

x

2

,

.

.

.

,

x

n

)

=

θ

0

+

θ

1

x

1

+

.

.

.

+

θ

n

x

n

h_\theta(x_1,x_2,...,x_n)=\theta_0+\theta_1x_1+...+\theta_nx_n

hθ(x1,x2,...,xn)=θ0+θ1x1+...+θnxn

其中,

θ

i

,

x

i

(

i

=

0

,

1

,

2

,

.

.

.

,

n

)

\theta_i,x_i(i=0,1,2,...,n)

θi,xi(i=0,1,2,...,n)分别为模型参数、每个样本的特征值。

对于假设函数,损失函数为:

J

(

θ

0

,

θ

1

,

.

.

.

,

θ

n

)

=

1

2

m

∑

j

=

0

m

(

h

θ

(

x

0

(

j

)

,

x

1

(

j

)

,

.

.

.

,

x

n

(

j

)

)

−

y

j

)

2

J(\theta_0,\theta_1,...,\theta_n)=\frac{1}{2m}\sum^{m}_{j=0}(h_\theta (x^{(j)}_0 ,x^{(j)}_1,...,x^{(j)}_n)-y_j)^2

J(θ0,θ1,...,θn)=2m1j=0∑m(hθ(x0(j),x1(j),...,xn(j))−yj)2

(2)相关参数初始化。

主要初始化

θ

i

{\theta}_i

θi、算法迭代步长${\alpha}

、

终

止

距

离

、终止距离

、终止距离{\zeta}

。

初

始

化

时

可

以

根

据

经

验

初

始

化

,

即

。初始化时可以根据经验初始化,即

。初始化时可以根据经验初始化,即{\theta}

初

始

化

为

0

,

步

长

初始化为0,步长

初始化为0,步长{\alpha}

初

始

化

为

1

。

当

前

步

长

记

为

初始化为1。当前步长记为

初始化为1。当前步长记为{\varphi}_i $。当然,也可随机初始化。

(3)迭代计算。

1)计算当前位置时损失函数的梯度,对${\theta}_i $,其梯度表示为:

∂

∂

θ

i

J

(

θ

0

,

θ

1

,

.

.

.

,

θ

n

)

=

1

2

m

∑

j

=

0

m

(

h

θ

(

x

0

(

j

)

,

x

1

(

j

)

,

.

.

.

,

x

n

(

j

)

)

−

y

j

)

2

\frac{\partial}{\partial \theta_i}J({\theta}_0,{\theta}_1,...,{\theta}_n)=\frac{1}{2m}\sum^{m}_{j=0}(h_\theta (x^{(j)}_0 ,x^{(j)}_1,...,x^{(j)}_n)-y_j)^2

∂θi∂J(θ0,θ1,...,θn)=2m1j=0∑m(hθ(x0(j),x1(j),...,xn(j))−yj)2

2)计算当前位置下降的距离。

φ

i

=

α

∂

∂

θ

i

J

(

θ

0

,

θ

1

,

.

.

.

,

θ

n

)

{\varphi}_i={\alpha} \frac{\partial}{\partial \theta_i}J({\theta}_0,{\theta}_1,...,{\theta}_n)

φi=α∂θi∂J(θ0,θ1,...,θn)

3)判断是否终止。

确定是否所有

θ

i

{\theta}_i

θi梯度下降的距离

φ

i

{\varphi}_i

φi都小于终止距离

ζ

{\zeta}

ζ,如果都小于

ζ

{\zeta}

ζ,则算法终止,当然的值即为最终结果,否则进入下一步。

4)更新所有的

θ

i

{\theta}_i

θi,更新后的表达式为:

θ

i

=

θ

i

−

α

∂

∂

θ

i

J

(

θ

0

,

θ

1

,

.

.

.

,

θ

n

)

{\theta}_i={\theta}_i-\alpha \frac{\partial}{\partial \theta_i}J({\theta}_0,{\theta}_1,...,{\theta}_n)

θi=θi−α∂θi∂J(θ0,θ1,...,θn)

θ

i

=

θ

i

−

α

1

m

∑

j

=

0

m

(

h

θ

(

x

0

(

j

)

,

x

1

(

j

)

,

.

.

.

,

x

n

(

j

)

)

−

y

j

)

x

i

(

j

)

\theta_i=\theta_i - \alpha \frac{1}{m} \sum^{m}_{j=0}(h_\theta (x^{(j)}_0 ,x^{(j)}_1,...,x^{(j)}_n)-y_j)x^{(j)}_i

θi=θi−αm1j=0∑m(hθ(x0(j),x1(j),...,xn(j))−yj)xi(j)

5)令上式

x

0

(

j

)

=

1

x^{(j)}_0=1

x0(j)=1,更新完毕后转入1)。

由此,可看出,当前位置的梯度方向由所有样本决定,上式中

1

m

\frac{1}{m}

m1、

α

1

m

\alpha \frac{1}{m}

αm1 的目的是为了便于理解。

1.12.5 如何对梯度下降法进行调优

实际使用梯度下降法时,各项参数指标不能一步就达到理想状态,对梯度下降法调优主要体现在以下几个方面:

(1)算法迭代步长

α

\alpha

α选择。

在算法参数初始化时,有时根据经验将步长初始化为1。实际取值取决于数据样本。可以从大到小,多取一些值,分别运行算法看迭代效果,如果损失函数在变小,则取值有效。如果取值无效,说明要增大步长。但步长太大,有时会导致迭代速度过快,错过最优解。步长太小,迭代速度慢,算法运行时间长。

(2)参数的初始值选择。

初始值不同,获得的最小值也有可能不同,梯度下降有可能得到的是局部最小值。如果损失函数是凸函数,则一定是最优解。由于有局部最优解的风险,需要多次用不同初始值运行算法,关键损失函数的最小值,选择损失函数最小化的初值。

(3)标准化处理。

由于样本不同,特征取值范围也不同,导致迭代速度慢。为了减少特征取值的影响,可对特征数据标准化,使新期望为0,新方差为1,可节省算法运行时间。

1.12.6 随机梯度和批量梯度区别

随机梯度下降(SGD)和批量梯度下降(BGD)是两种主要梯度下降法,其目的是增加某些限制来加速运算求解。

下面通过介绍两种梯度下降法的求解思路,对其进行比较。

假设函数为:

h

θ

(

x

0

,

x

1

,

.

.

.

,

x

3

)

=

θ

0

x

0

+

θ

1

x

1

+

.

.

.

+

θ

n

x

n

h_\theta (x_0,x_1,...,x_3) = \theta_0 x_0 + \theta_1 x_1 + ... + \theta_n x_n

hθ(x0,x1,...,x3)=θ0x0+θ1x1+...+θnxn

损失函数为:

J

(

θ

0

,

θ

1

,

.

.

.

,

θ

n

)

=

1

2

m

∑

j

=

0

m

(

h

θ

(

x

0

j

,

x

1

j

,

.

.

.

,

x

n

j

)

−

y

j

)

2

J(\theta_0, \theta_1, ... , \theta_n) = \frac{1}{2m} \sum^{m}_{j=0}(h_\theta (x^{j}_0 ,x^{j}_1,...,x^{j}_n)-y^j)^2

J(θ0,θ1,...,θn)=2m1j=0∑m(hθ(x0j,x1j,...,xnj)−yj)2

其中,

m

m

m为样本个数,

j

j

j为参数个数。

1、 批量梯度下降的求解思路如下:

a) 得到每个$ \theta $对应的梯度:

∂

∂

θ

i

J

(

θ

0

,

θ

1

,

.

.

.

,

θ

n

)

=

1

m

∑

j

=

0

m

(

h

θ

(

x

0

j

,

x

1

j

,

.

.

.

,

x

n

j

)

−

y

j

)

x

i

j

\frac{\partial}{\partial \theta_i}J({\theta}_0,{\theta}_1,...,{\theta}_n)=\frac{1}{m}\sum^{m}_{j=0}(h_\theta (x^{j}_0 ,x^{j}_1,...,x^{j}_n)-y^j)x^{j}_i

∂θi∂J(θ0,θ1,...,θn)=m1j=0∑m(hθ(x0j,x1j,...,xnj)−yj)xij

b) 由于是求最小化风险函数,所以按每个参数 $ \theta $ 的梯度负方向更新 $ \theta_i $ :

θ

i

=

θ

i

−

1

m

∑

j

=

0

m

(

h

θ

(

x

0

j

,

x

1

j

,

.

.

.

,

x

n

j

)

−

y

j

)

x

i

j

\theta_i=\theta_i - \frac{1}{m} \sum^{m}_{j=0}(h_\theta (x^{j}_0 ,x^{j}_1,...,x^{j}_n)-y^j)x^{j}_i

θi=θi−m1j=0∑m(hθ(x0j,x1j,...,xnj)−yj)xij

c) 从上式可以注意到,它得到的虽然是一个全局最优解,但每迭代一步,都要用到训练集所有的数据,如果样本数据很大,这种方法迭代速度就很慢。

相比而言,随机梯度下降可避免这种问题。

2、随机梯度下降的求解思路如下:

a) 相比批量梯度下降对应所有的训练样本,随机梯度下降法中损失函数对应的是训练集中每个样本的粒度。

损失函数可以写成如下这种形式,

J

(

θ

0

,

θ

1

,

.

.

.

,

θ

n

)

=

1

m

∑

j

=

0

m

(

y

j

−

h

θ

(

x

0

j

,

x

1

j

,

.

.

.

,

x

n

j

)

)

2

=

1

m

∑

j

=

0

m

c

o

s

t

(

θ

,

(

x

j

,

y

j

)

)

J(\theta_0, \theta_1, ... , \theta_n) = \frac{1}{m} \sum^{m}_{j=0}(y^j - h_\theta (x^{j}_0 ,x^{j}_1,...,x^{j}_n))^2 = \frac{1}{m} \sum^{m}_{j=0} cost(\theta,(x^j,y^j))

J(θ0,θ1,...,θn)=m1j=0∑m(yj−hθ(x0j,x1j,...,xnj))2=m1j=0∑mcost(θ,(xj,yj))

b)对每个参数 $ \theta$ 按梯度方向更新 $ \theta$:

θ

i

=

θ

i

+

(

y

j

−

h

θ

(

x

0

j

,

x

1

j

,

.

.

.

,

x

n

j

)

)

\theta_i = \theta_i + (y^j - h_\theta (x^{j}_0, x^{j}_1, ... ,x^{j}_n))

θi=θi+(yj−hθ(x0j,x1j,...,xnj))

c) 随机梯度下降是通过每个样本来迭代更新一次。

随机梯度下降伴随的一个问题是噪音较批量梯度下降要多,使得随机梯度下降并不是每次迭代都向着整体最优化方向。

小结:

随机梯度下降法、批量梯度下降法相对来说都比较极端,简单对比如下:

| 方法 | 特点 |

|---|---|

| 批量梯度下降 | a)采用所有数据来梯度下降。 b)批量梯度下降法在样本量很大的时候,训练速度慢。 |

| 随机梯度下降 | a)随机梯度下降用一个样本来梯度下降。 b)训练速度很快。 c)随机梯度下降法仅仅用一个样本决定梯度方向,导致解有可能不是全局最优。 d)收敛速度来说,随机梯度下降法一次迭代一个样本,导致迭代方向变化很大,不能很快的收敛到局部最优解。 |

下面介绍能结合两种方法优点的小批量梯度下降法。

3、 小批量(Mini-Batch)梯度下降的求解思路如下

对于总数为

m

m

m个样本的数据,根据样本的数据,选取其中的

n

(

1

<

n

<

m

)

n(1< n< m)

n(1<n<m)个子样本来迭代。其参数

θ

\theta

θ按梯度方向更新

θ

i

\theta_i

θi公式如下:

θ

i

=

θ

i

−

α

∑

j

=

t

t

+

n

−

1

(

h

θ

(

x

0

j

,

x

1

j

,

.

.

.

,

x

n

j

)

−

y

j

)

x

i

j

\theta_i = \theta_i - \alpha \sum^{t+n-1}_{j=t} ( h_\theta (x^{j}_{0}, x^{j}_{1}, ... , x^{j}_{n} ) - y^j ) x^{j}_{i}

θi=θi−αj=t∑t+n−1(hθ(x0j,x1j,...,xnj)−yj)xij

1.12.7 各种梯度下降法性能比较

下表简单对比随机梯度下降(SGD)、批量梯度下降(BGD)、小批量梯度下降(Mini-batch GD)、和Online GD的区别:

| BGD | SGD | Mini-batch GD | Online GD | |

|---|---|---|---|---|

| 训练集 | 固定 | 固定 | 固定 | 实时更新 |

| 单次迭代样本数 | 整个训练集 | 单个样本 | 训练集的子集 | 根据具体算法定 |

| 算法复杂度 | 高 | 低 | 一般 | 低 |

| 时效性 | 低 | 一般 | 一般 | 高 |

| 收敛性 | 稳定 | 不稳定 | 较稳定 | 不稳定 |

BGD、SGD、Mini-batch GD,前面均已讨论过,这里介绍一下Online GD。

Online GD于Mini-batch GD/SGD的区别在于,所有训练数据只用一次,然后丢弃。这样做的优点在于可预测最终模型的变化趋势。

Online GD在互联网领域用的较多,比如搜索广告的点击率(CTR)预估模型,网民的点击行为会随着时间改变。用普通的BGD算法(每天更新一次)一方面耗时较长(需要对所有历史数据重新训练);另一方面,无法及时反馈用户的点击行为迁移。而Online GD算法可以实时的依据网民的点击行为进行迁移。

1.13 自然梯度法

1.13.1 为什么我们需要自然梯度

传统的梯度下降方法是在欧氏空间进行、并与时序过程结合的优化方法,但这样的更新过程无法度量由于参数变化引起的概率属性的变化(这一点也可以认为是传统梯度下降方法的缺点)。在如强化学习等很多应用领域关注模型输出的概率分布,优化过程常常需要在一定概率属性的约束下完成,这就需要自然梯度。

1.13.2 如何定义自然梯度

若度量模型参数变化引起的概率分布变化,常用的“距离”度量是KL散度(Kullback-Leibler divergence)。设模型概率分布为

p

(

x

;

θ

)

p(x;\theta)

p(x;θ),其与参数变动后的概率分布间的KL散度为:

D

K

L

(

p

(

x

;

θ

)

∣

∣

p

(

x

;

θ

+

δ

θ

)

)

=

∫

p

(

x

;

θ

)

l

o

g

p

(

x

;

θ

)

p

(

x

;

θ

+

δ

θ

)

d

x

D_{KL}(p(x;\theta)||p(x;\theta+\delta\theta))=\int p(x;\theta)log\frac {p(x;\theta)}{p(x;\theta+\delta\theta)}dx

DKL(p(x;θ)∣∣p(x;θ+δθ))=∫p(x;θ)logp(x;θ+δθ)p(x;θ)dx

我们令

f

(

θ

+

δ

θ

)

=

l

o

g

p

(

x

;

θ

+

δ

θ

)

f(\theta+\delta\theta)=log p(x;\theta+\delta\theta)

f(θ+δθ)=logp(x;θ+δθ),做泰勒展开取二阶近似(忽略高阶余项)得到:

f

(

θ

+

δ

θ

)

≈

f

(

θ

)

+

δ

θ

T

∂

f

(

θ

)

∂

θ

+

1

2

δ

θ

T

∂

f

(

θ

)

∂

θ

∂

f

(

θ

)

T

∂

θ

δ

θ

f(\theta+\delta\theta)\approx f(\theta)+\delta\theta^T\frac{\partial f(\theta)}{\partial\theta}+\frac{1}{2}\delta\theta^T\frac{\partial f(\theta)}{\partial\theta}\frac{\partial f(\theta)^T}{\partial\theta}\delta\theta

f(θ+δθ)≈f(θ)+δθT∂θ∂f(θ)+21δθT∂θ∂f(θ)∂θ∂f(θ)Tδθ

带入到

D

K

L

(

p

(

x

;

θ

)

∣

∣

p

(

x

;

θ

+

δ

θ

)

)

D_{KL}(p(x;\theta)||p(x;\theta+\delta\theta))

DKL(p(x;θ)∣∣p(x;θ+δθ))中可得到:

KaTeX parse error: No such environment: eqnarray at position 8: \begin{̲e̲q̲n̲a̲r̲r̲a̲y̲}̲ D_{KL}(p(x;\th…

我们记在KL散度意义下的参数增量为

δ

θ

G

\delta\theta_G

δθG,接下来我们寻求在

∣

∣

δ

θ

G

∣

∣

2

=

ϵ

||\delta\theta_G||^2=\epsilon

∣∣δθG∣∣2=ϵ约束下

δ

θ

G

\delta\theta_G

δθG的方向,使得目标函数

J

(

θ

)

J(\theta)

J(θ)下降最快,即

J

(

θ

+

δ

θ

)

−

J

(

θ

)

J(\theta+\delta\theta)-J(\theta)

J(θ+δθ)−J(θ)最大。应用拉格朗日乘子法:

max

δ

θ

J

(

θ

+

δ

θ

)

−

J

(

θ

)

−

λ

(

∣

∣

δ

θ

G

∣

∣

2

−

ϵ

)

\max_{\delta\theta}J(\theta+\delta\theta)-J(\theta)-\lambda(||\delta\theta_G||^2-\epsilon)

δθmaxJ(θ+δθ)−J(θ)−λ(∣∣δθG∣∣2−ϵ)

应用一阶泰勒展开等价于:

max

δ

θ

∇

δ

θ

T

J

(

θ

)

−

1

2

λ

δ

θ

T

G

δ

θ

\max_{\delta\theta}\nabla \delta\theta^T J(\theta)-\frac{1}{2}\lambda\delta\theta^TG\delta\theta

δθmax∇δθTJ(θ)−21λδθTGδθ

对

δ

θ

\delta\theta

δθ求导得

∇

J

(

θ

)

−

λ

G

δ

θ

=

0

\nabla J(\theta)-\lambda G\delta\theta=0

∇J(θ)−λGδθ=0,即

δ

θ

=

1

λ

G

−

1

∇

J

(

θ

)

\delta\theta=\frac{1}{\lambda}G^{-1}\nabla J(\theta)

δθ=λ1G−1∇J(θ),其中

G

−

1

∇

J

(

θ

)

G^{-1}\nabla J(\theta)

G−1∇J(θ)称为自然梯度,相应的自然梯度下降公式为

θ

k

+

1

=

θ

k

−

α

k

G

−

1

(

θ

k

)

∇

J

(

θ

K

)

\theta_{k+1}=\theta_k-\alpha_kG^{-1}(\theta_k)\nabla J(\theta_K)

θk+1=θk−αkG−1(θk)∇J(θK)。

1.13.3 Fisher信息矩阵的意义

首先我们对一个模型进行建模,成为以 θ \theta θ为参数的概率分布 p ( x ; θ ) p(x;\theta) p(x;θ)。为求出一个合理的 θ \theta θ我们需要一个评分函数(score function): s ( θ ) = ∇ θ l o g p ( x ; θ ) s(\theta)=\nabla_{\theta}logp(x;\theta) s(θ)=∇θlogp(x;θ),意为对数似然的梯度,当分数为0时(对数似然梯度为0),对数似然达到极值。对评分函数求关于 p ( x ; θ ) p(x;\theta) p(x;θ)数学期望 p E p_E pE不难发现期望为0。接下来求估计误差的界,我们用评分函数的方差来确定,即 E p ( x ; θ ) [ ( s ( θ ) − p E ) ( s ( θ − p E ) T ) ] E_{p(x;\theta)}[(s(\theta)-p_E)(s(\theta-p_E)^T)] Ep(x;θ)[(s(θ)−pE)(s(θ−pE)T)]。带入评分函数的数学表达形式则等价于Fisher信息矩阵 G ( θ ) = ∫ p ( x ; θ ) ∂ f ( θ ) ∂ θ ∂ f ( θ ) T ∂ θ d x G(\theta)=\int p(x;\theta)\frac{\partial f(\theta)}{\partial\theta}\frac{\partial f(\theta)^T}{\partial\theta}dx G(θ)=∫p(x;θ)∂θ∂f(θ)∂θ∂f(θ)Tdx。特别地,Fisher信息矩阵与评分函数 ∇ θ l o g p ( x ; θ ) \nabla_{\theta}logp(x;\theta) ∇θlogp(x;θ)的Hessian似然的负数等价。

证明:首先求出评分函数的Hessian矩阵,由梯度的Jacobian决定

KaTeX parse error: No such environment: eqnarray at position 8: \begin{̲e̲q̲n̲a̲r̲r̲a̲y̲}̲ H_{logp(x;\the…

等式两边同时求关于

p

(

x

;

θ

)

p(x;\theta)

p(x;θ)的数学期望:

KaTeX parse error: No such environment: eqnarray at position 8: \begin{̲e̲q̲n̲a̲r̲r̲a̲y̲}̲ E_{p(x;\theta)…

而Hessian矩阵刻画着对数似然函数的曲率,所以本质上自然梯度下降法是在一个消除了不同概率分布的曲率后,在同一个“平坦”曲面上进行迭代更新,步长等于原概率分布空间的步长按照曲率折合到新的“平坦曲面”的大小。

值得注意的一点是,一般来说似然函数获取很难,在实际问题中,我们可以用采样的方法从数据集中采样数据,将Fisher信息矩阵原始表达式的积分变为求和来近似估计,这样的方式得到的Fisher信息矩阵称为经验Fisher。

1.14 线性判别分析(LDA)

1.14.1 LDA思想总结

线性判别分析(Linear Discriminant Analysis,LDA)是一种经典的降维方法。和主成分分析PCA不考虑样本类别输出的无监督降维技术不同,LDA是一种监督学习的降维技术,数据集的每个样本有类别输出。

LDA分类思想简单总结如下:

- 多维空间中,数据处理分类问题较为复杂,LDA算法将多维空间中的数据投影到一条直线上,将d维数据转化成1维数据进行处理。

- 对于训练数据,设法将多维数据投影到一条直线上,同类数据的投影点尽可能接近,异类数据点尽可能远离。

- 对数据进行分类时,将其投影到同样的这条直线上,再根据投影点的位置来确定样本的类别。

如果用一句话概括LDA思想,即“投影后类内方差最小,类间方差最大”。

1.14.2 图解LDA核心思想

假设有红、蓝两类数据,这些数据特征均为二维,如下图所示。我们的目标是将这些数据投影到一维,让每一类相近的数据的投影点尽可能接近,不同类别数据尽可能远,即图中红色和蓝色数据中心之间的距离尽可能大。

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-63wl3g3F-1628138740229)(img/ch2/2.29/1.png)]

左图和右图是两种不同的投影方式。

左图思路:让不同类别的平均点距离最远的投影方式。

右图思路:让同类别的数据挨得最近的投影方式。

从上图直观看出,右图红色数据和蓝色数据在各自的区域来说相对集中,根据数据分布直方图也可看出,所以右图的投影效果好于左图,左图中间直方图部分有明显交集。

以上例子是基于数据是二维的,分类后的投影是一条直线。如果原始数据是多维的,则投影后的分类面是一低维的超平面。

1.14.3 二类LDA算法原理

输入:数据集 D = { ( x 1 , y 1 ) , ( x 2 , y 2 ) , . . . , ( x m , y m ) } D=\{(\boldsymbol x_1,\boldsymbol y_1),(\boldsymbol x_2,\boldsymbol y_2),...,(\boldsymbol x_m,\boldsymbol y_m)\} D={(x1,y1),(x2,y2),...,(xm,ym)},其中样本 x i \boldsymbol x_i xi 是n维向量, y i ϵ { 0 , 1 } \boldsymbol y_i \epsilon \{0, 1\} yiϵ{0,1},降维后的目标维度 d d d。定义

N j ( j = 0 , 1 ) N_j(j=0,1) Nj(j=0,1) 为第 j j j 类样本个数;

X j ( j = 0 , 1 ) X_j(j=0,1) Xj(j=0,1) 为第 j j j 类样本的集合;

u j ( j = 0 , 1 ) u_j(j=0,1) uj(j=0,1) 为第 j j j 类样本的均值向量;

∑ j ( j = 0 , 1 ) \sum_j(j=0,1) ∑j(j=0,1) 为第 j j j 类样本的协方差矩阵。

其中

u

j

=

1

N

j

∑

x

ϵ

X

j

x

(

j

=

0

,

1

)

,

∑

j

=

∑

x

ϵ

X

j

(

x

−

u

j

)

(

x

−

u

j

)

T

(

j

=

0

,

1

)

u_j = \frac{1}{N_j} \sum_{\boldsymbol x\epsilon X_j}\boldsymbol x(j=0,1), \sum_j = \sum_{\boldsymbol x\epsilon X_j}(\boldsymbol x-u_j)(\boldsymbol x-u_j)^T(j=0,1)

uj=Nj1xϵXj∑x(j=0,1),j∑=xϵXj∑(x−uj)(x−uj)T(j=0,1)

假设投影直线是向量

w

\boldsymbol w

w,对任意样本

x

i

\boldsymbol x_i

xi,它在直线

w

w

w上的投影为

w

T

x

i

\boldsymbol w^Tx_i

wTxi,两个类别的中心点

u

0

u_0

u0, $u_1 $在直线

w

w

w 的投影分别为

w

T

u

0

\boldsymbol w^Tu_0

wTu0 、

w

T

u

1

\boldsymbol w^Tu_1

wTu1。

LDA的目标是让两类别的数据中心间的距离

∥

w

T

u

0

−

w

T

u

1

∥

2

2

\| \boldsymbol w^Tu_0 - \boldsymbol w^Tu_1 \|^2_2

∥wTu0−wTu1∥22 尽量大,与此同时,希望同类样本投影点的协方差

w

T

∑

0

w

\boldsymbol w^T \sum_0 \boldsymbol w

wT∑0w、

w

T

∑

1

w

\boldsymbol w^T \sum_1 \boldsymbol w

wT∑1w 尽量小,最小化

w

T

∑

0

w

+

w

T

∑

1

w

\boldsymbol w^T \sum_0 \boldsymbol w + \boldsymbol w^T \sum_1 \boldsymbol w

wT∑0w+wT∑1w 。

定义

类内散度矩阵

S

w

=

∑

0

+

∑

1

=

∑

x

ϵ

X

0

(

x

−

u

0

)

(

x

−

u

0

)

T

+

∑

x

ϵ

X

1

(

x

−

u

1

)

(

x

−

u

1

)

T

S_w = \sum_0 + \sum_1 = \sum_{\boldsymbol x\epsilon X_0}(\boldsymbol x-u_0)(\boldsymbol x-u_0)^T + \sum_{\boldsymbol x\epsilon X_1}(\boldsymbol x-u_1)(\boldsymbol x-u_1)^T

Sw=0∑+1∑=xϵX0∑(x−u0)(x−u0)T+xϵX1∑(x−u1)(x−u1)T

类间散度矩阵

S

b

=

(

u

0

−

u

1

)

(

u

0

−

u

1

)

T

S_b = (u_0 - u_1)(u_0 - u_1)^T

Sb=(u0−u1)(u0−u1)T

据上分析,优化目标为

arg

max

w

J

(

w

)

=

∥

w

T

u

0

−

w

T

u

1

∥

2

2

w

T

∑

0

w

+

w

T

∑

1

w

=

w

T

(

u

0

−

u

1

)

(

u

0

−

u

1

)

T

w

w

T

(

∑

0

+

∑

1

)

w

=

w

T

S

b

w

w

T

S

w

w

\mathop{\arg\max}_\boldsymbol w J(\boldsymbol w) = \frac{\| \boldsymbol w^Tu_0 - \boldsymbol w^Tu_1 \|^2_2}{\boldsymbol w^T \sum_0\boldsymbol w + \boldsymbol w^T \sum_1\boldsymbol w} = \frac{\boldsymbol w^T(u_0-u_1)(u_0-u_1)^T\boldsymbol w}{\boldsymbol w^T(\sum_0 + \sum_1)\boldsymbol w} = \frac{\boldsymbol w^TS_b\boldsymbol w}{\boldsymbol w^TS_w\boldsymbol w}

argmaxwJ(w)=wT∑0w+wT∑1w∥wTu0−wTu1∥22=wT(∑0+∑1)wwT(u0−u1)(u0−u1)Tw=wTSwwwTSbw

根据广义瑞利商的性质,矩阵

S

w

−

1

S

b

S^{-1}_{w} S_b

Sw−1Sb 的最大特征值为

J

(

w

)

J(\boldsymbol w)

J(w) 的最大值,矩阵

S

w

−

1

S

b

S^{-1}_{w} S_b

Sw−1Sb 的最大特征值对应的特征向量即为

w

\boldsymbol w

w。

1.14.4 LDA算法流程总结

LDA算法降维流程如下:

输入:数据集 D = { ( x 1 , y 1 ) , ( x 2 , y 2 ) , . . . , ( x m , y m ) } D = \{ (x_1,y_1),(x_2,y_2), ... ,(x_m,y_m) \} D={(x1,y1),(x2,y2),...,(xm,ym)},其中样本 $x_i $ 是n维向量, y i ϵ { C 1 , C 2 , . . . , C k } y_i \epsilon \{C_1, C_2, ..., C_k\} yiϵ{C1,C2,...,Ck},降维后的目标维度 d d d 。

输出:降维后的数据集 $\overline{D} $ 。

步骤:

- 计算类内散度矩阵 S w S_w Sw。

- 计算类间散度矩阵 S b S_b Sb 。

- 计算矩阵 S w − 1 S b S^{-1}_wS_b Sw−1Sb 。

- 计算矩阵 S w − 1 S b S^{-1}_wS_b Sw−1Sb 的最大的 d 个特征值。

- 计算 d 个特征值对应的 d 个特征向量,记投影矩阵为 W 。

- 转化样本集的每个样本,得到新样本 P i = W T x i P_i = W^Tx_i Pi=WTxi 。

- 输出新样本集 D ‾ = { ( p 1 , y 1 ) , ( p 2 , y 2 ) , . . . , ( p m , y m ) } \overline{D} = \{ (p_1,y_1),(p_2,y_2),...,(p_m,y_m) \} D={(p1,y1),(p2,y2),...,(pm,ym)}

1.14.5 LDA和PCA区别

| 异同点 | LDA | PCA |

|---|---|---|

| 相同点 | 1. 两者均可以对数据进行降维; 2. 两者在降维时均使用了矩阵特征分解的思想; 3. 两者都假设数据符合高斯分布; | |

| 不同点 | 有监督的降维方法; | 无监督的降维方法; |

| 降维最多降到k-1维; | 降维多少没有限制; | |

| 可以用于降维,还可以用于分类; | 只用于降维; | |

| 选择分类性能最好的投影方向; | 选择样本点投影具有最大方差的方向; | |

| 更明确,更能反映样本间差异; | 目的较为模糊; |

1.14.6 LDA优缺点

| 优缺点 | 简要说明 |

|---|---|

| 优点 | 1. 可以使用类别的先验知识; 2. 以标签、类别衡量差异性的有监督降维方式,相对于PCA的模糊性,其目的更明确,更能反映样本间的差异; |

| 缺点 | 1. LDA不适合对非高斯分布样本进行降维; 2. LDA降维最多降到分类数k-1维; 3. LDA在样本分类信息依赖方差而不是均值时,降维效果不好; 4. LDA可能过度拟合数据。 |

1.15 主成分分析(PCA)

1.15.1 主成分分析(PCA)思想总结

- PCA就是将高维的数据通过线性变换投影到低维空间上去。

- 投影思想:找出最能够代表原始数据的投影方法。被PCA降掉的那些维度只能是那些噪声或是冗余的数据。

- 去冗余:去除可以被其他向量代表的线性相关向量,这部分信息量是多余的。

- 去噪声,去除较小特征值对应的特征向量,特征值的大小反映了变换后在特征向量方向上变换的幅度,幅度越大,说明这个方向上的元素差异也越大,要保留。

- 对角化矩阵,寻找极大线性无关组,保留较大的特征值,去除较小特征值,组成一个投影矩阵,对原始样本矩阵进行投影,得到降维后的新样本矩阵。

- 完成PCA的关键是——协方差矩阵。协方差矩阵,能同时表现不同维度间的相关性以及各个维度上的方差。协方差矩阵度量的是维度与维度之间的关系,而非样本与样本之间。

- 之所以对角化,因为对角化之后非对角上的元素都是0,达到去噪声的目的。对角化后的协方差矩阵,对角线上较小的新方差对应的就是那些该去掉的维度。所以我们只取那些含有较大能量(特征值)的维度,其余的就舍掉,即去冗余。

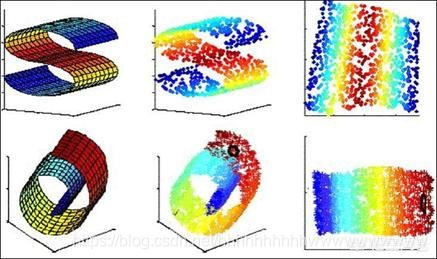

1.15.2 图解PCA核心思想

PCA可解决训练数据中存在数据特征过多或特征累赘的问题。核心思想是将m维特征映射到n维(n < m),这n维形成主元,是重构出来最能代表原始数据的正交特征。

假设数据集是m个n维,

(

x

(

1

)

,

x

(

2

)

,

⋯

,

x

(

m

)

)

(\boldsymbol x^{(1)}, \boldsymbol x^{(2)}, \cdots, \boldsymbol x^{(m)})

(x(1),x(2),⋯,x(m))。如果

n

=

2

n=2

n=2,需要降维到

n

′

=

1

n'=1

n′=1,现在想找到某一维度方向代表这两个维度的数据。下图有

u

1

,

u

2

u_1, u_2

u1,u2两个向量方向,但是哪个向量才是我们所想要的,可以更好代表原始数据集的呢?

从图可看出, u 1 u_1 u1比 u 2 u_2 u2好,为什么呢?有以下两个主要评价指标:

- 样本点到这个直线的距离足够近。

- 样本点在这个直线上的投影能尽可能的分开。

如果我们需要降维的目标维数是其他任意维,则:

- 样本点到这个超平面的距离足够近。

- 样本点在这个超平面上的投影能尽可能的分开。

1.15.3 PCA算法推理

下面以基于最小投影距离为评价指标推理:

假设数据集是m个n维, ( x ( 1 ) , x ( 2 ) , . . . , x ( m ) ) (x^{(1)}, x^{(2)},...,x^{(m)}) (x(1),x(2),...,x(m)),且数据进行了中心化。经过投影变换得到新坐标为 w 1 , w 2 , . . . , w n {w_1,w_2,...,w_n} w1,w2,...,wn,其中 w w w 是标准正交基,即 ∥ w ∥ 2 = 1 \| w \|_2 = 1 ∥w∥2=1, w i T w j = 0 w^T_iw_j = 0 wiTwj=0。

经过降维后,新坐标为 { w 1 , w 2 , . . . , w n } \{ w_1,w_2,...,w_n \} {w1,w2,...,wn},其中 n ′ n' n′ 是降维后的目标维数。样本点 x ( i ) x^{(i)} x(i) 在新坐标系下的投影为 z ( i ) = ( z 1 ( i ) , z 2 ( i ) , . . . , z n ′ ( i ) ) z^{(i)} = \left(z^{(i)}_1, z^{(i)}_2, ..., z^{(i)}_{n'} \right) z(i)=(z1(i),z2(i),...,zn′(i)),其中 z j ( i ) = w j T x ( i ) z^{(i)}_j = w^T_j x^{(i)} zj(i)=wjTx(i) 是 x ( i ) x^{(i)} x(i) 在低维坐标系里第 j 维的坐标。

如果用 $z^{(i)} $ 去恢复 $x^{(i)} $ ,则得到的恢复数据为 x ^ ( i ) = ∑ j = 1 n ′ x j ( i ) w j = W z ( i ) \widehat{x}^{(i)} = \sum^{n'}_{j=1} x^{(i)}_j w_j = Wz^{(i)} x (i)=∑j=1n′xj(i)wj=Wz(i),其中 W W W为标准正交基组成的矩阵。

考虑到整个样本集,样本点到这个超平面的距离足够近,目标变为最小化

∑

i

=

1

m

∥

x

^

(

i

)

−

x

(

i

)

∥

2

2

\sum^m_{i=1} \| \hat{x}^{(i)} - x^{(i)} \|^2_2

∑i=1m∥x^(i)−x(i)∥22 。对此式进行推理,可得:

∑

i

=

1

m

∥

x

^

(

i

)

−

x

(

i

)

∥

2

2

=

∑

i

=

1

m

∥

W

z

(

i

)

−

x

(

i

)

∥

2

2

=

∑

i

=

1

m

(

W

z

(

i

)

)

T

(

W

z

(

i

)

)

−

2

∑

i

=

1

m

(

W

z

(

i

)

)

T

x

(

i

)

+

∑

i

=

1

m

(

x

(

i

)

)

T

x

(

i

)

=

∑

i

=

1

m

(

z

(

i

)

)

T

(

z

(

i

)

)

−

2

∑

i

=

1

m

(

z

(

i

)

)

T

x

(

i

)

+

∑

i

=

1

m

(

x

(

i

)

)

T

x

(

i

)

=

−

∑

i

=

1

m

(

z

(

i

)

)

T

(

z

(

i

)

)

+

∑

i

=

1

m

(

x

(

i

)

)

T

x

(

i

)

=

−

t

r

(

W

T

(

∑

i

=

1

m

x

(

i

)

(

x

(

i

)

)

T

)

W

)

+

∑

i

=

1

m

(

x

(

i

)

)

T

x

(

i

)

=

−

t

r

(

W

T

X

X

T

W

)

+

∑

i

=

1

m

(

x

(

i

)

)

T

x

(

i

)

\sum^m_{i=1} \| \hat{x}^{(i)} - x^{(i)} \|^2_2 = \sum^m_{i=1} \| Wz^{(i)} - x^{(i)} \|^2_2 \\ = \sum^m_{i=1} \left( Wz^{(i)} \right)^T \left( Wz^{(i)} \right) - 2\sum^m_{i=1} \left( Wz^{(i)} \right)^T x^{(i)} + \sum^m_{i=1} \left( x^{(i)} \right)^T x^{(i)} \\ = \sum^m_{i=1} \left( z^{(i)} \right)^T \left( z^{(i)} \right) - 2\sum^m_{i=1} \left( z^{(i)} \right)^T x^{(i)} + \sum^m_{i=1} \left( x^{(i)} \right)^T x^{(i)} \\ = - \sum^m_{i=1} \left( z^{(i)} \right)^T \left( z^{(i)} \right) + \sum^m_{i=1} \left( x^{(i)} \right)^T x^{(i)} \\ = -tr \left( W^T \left( \sum^m_{i=1} x^{(i)} \left( x^{(i)} \right)^T \right)W \right) + \sum^m_{i=1} \left( x^{(i)} \right)^T x^{(i)} \\ = -tr \left( W^TXX^TW \right) + \sum^m_{i=1} \left( x^{(i)} \right)^T x^{(i)}

i=1∑m∥x^(i)−x(i)∥22=i=1∑m∥Wz(i)−x(i)∥22=i=1∑m(Wz(i))T(Wz(i))−2i=1∑m(Wz(i))Tx(i)+i=1∑m(x(i))Tx(i)=i=1∑m(z(i))T(z(i))−2i=1∑m(z(i))Tx(i)+i=1∑m(x(i))Tx(i)=−i=1∑m(z(i))T(z(i))+i=1∑m(x(i))Tx(i)=−tr(WT(i=1∑mx(i)(x(i))T)W)+i=1∑m(x(i))Tx(i)=−tr(WTXXTW)+i=1∑m(x(i))Tx(i)

在推导过程中,分别用到了

x

‾

(

i

)

=

W

z

(

i

)

\overline{x}^{(i)} = Wz^{(i)}

x(i)=Wz(i) ,矩阵转置公式

(

A

B

)

T

=

B

T

A

T

(AB)^T = B^TA^T

(AB)T=BTAT,

W

T

W

=

I

W^TW = I

WTW=I,

z

(

i

)

=

W

T

x

(

i

)

z^{(i)} = W^Tx^{(i)}

z(i)=WTx(i) 以及矩阵的迹,最后两步是将代数和转为矩阵形式。

由于

W

W

W 的每一个向量

w

j

w_j

wj 是标准正交基,

∑

i

=

1

m

x

(

i

)

(

x

(

i

)

)

T

\sum^m_{i=1} x^{(i)} \left( x^{(i)} \right)^T

∑i=1mx(i)(x(i))T 是数据集的协方差矩阵,$\sum^m_{i=1} \left( x^{(i)} \right)^T x^{(i)} $ 是一个常量。最小化

∑

i

=

1

m

∥

x

^

(

i

)

−

x

(

i

)

∥

2

2

\sum^m_{i=1} \| \hat{x}^{(i)} - x^{(i)} \|^2_2

∑i=1m∥x^(i)−x(i)∥22 又可等价于

arg

min

⏟

W

−

t

r

(

W

T

X

X

T

W

)

s

.

t

.

W

T

W

=

I

\underbrace{\arg \min}_W - tr \left( W^TXX^TW \right) s.t.W^TW = I

W

argmin−tr(WTXXTW)s.t.WTW=I

利用拉格朗日函数可得到

J

(

W

)

=

−

t

r

(

W

T

X

X

T

W

)

+

λ

(

W

T

W

−

I

)

J(W) = -tr(W^TXX^TW) + \lambda(W^TW - I)

J(W)=−tr(WTXXTW)+λ(WTW−I)

对

W

W

W 求导,可得 $-XX^TW + \lambda W = 0 $ ,也即 $ XX^TW = \lambda W $ 。 $ XX^T $ 是 $ n’ $ 个特征向量组成的矩阵,

λ

\lambda

λ 为$ XX^T $ 的特征值。

W

W

W 即为我们想要的矩阵。

对于原始数据,只需要

z

(

i

)

=

W

T

X

(

i

)

z^{(i)} = W^TX^{(i)}

z(i)=WTX(i) ,就可把原始数据集降维到最小投影距离的

n

′

n'

n′ 维数据集。

基于最大投影方差的推导,这里就不再赘述,有兴趣的同仁可自行查阅资料。

1.15.4 PCA算法流程总结

输入: n n n 维样本集 D = ( x ( 1 ) , x ( 2 ) , . . . , x ( m ) ) D = \left( x^{(1)},x^{(2)},...,x^{(m)} \right) D=(x(1),x(2),...,x(m)) ,目标降维的维数 n ′ n' n′ 。

输出:降维后的新样本集 D ′ = ( z ( 1 ) , z ( 2 ) , . . . , z ( m ) ) D' = \left( z^{(1)},z^{(2)},...,z^{(m)} \right) D′=(z(1),z(2),...,z(m)) 。

主要步骤如下:

- 对所有的样本进行中心化,$ x^{(i)} = x^{(i)} - \frac{1}{m} \sum^m_{j=1} x^{(j)} $ 。

- 计算样本的协方差矩阵 X X T XX^T XXT 。

- 对协方差矩阵 X X T XX^T XXT 进行特征值分解。

- 取出最大的 $n’ $ 个特征值对应的特征向量 { w 1 , w 2 , . . . , w n ′ } \{ w_1,w_2,...,w_{n'} \} {w1,w2,...,wn′} 。

- 标准化特征向量,得到特征向量矩阵 W W W 。

- 转化样本集中的每个样本 z ( i ) = W T x ( i ) z^{(i)} = W^T x^{(i)} z(i)=WTx(i) 。

- 得到输出矩阵

D

′

=

(

z

(

1

)

,

z

(

2

)

,

.

.

.

,

z

(

n

)

)

D' = \left( z^{(1)},z^{(2)},...,z^{(n)} \right)

D′=(z(1),z(2),...,z(n)) 。

注:在降维时,有时不明确目标维数,而是指定降维到的主成分比重阈值 k ( k ϵ ( 0 , 1 ] ) k(k \epsilon(0,1]) k(kϵ(0,1]) 。假设 n n n 个特征值为 λ 1 ⩾ λ 2 ⩾ . . . ⩾ λ n \lambda_1 \geqslant \lambda_2 \geqslant ... \geqslant \lambda_n λ1⩾λ2⩾...⩾λn ,则 n ′ n' n′ 可从 ∑ i = 1 n ′ λ i ⩾ k × ∑ i = 1 n λ i \sum^{n'}_{i=1} \lambda_i \geqslant k \times \sum^n_{i=1} \lambda_i ∑i=1n′λi⩾k×∑i=1nλi 得到。

1.15.5 PCA算法主要优缺点

| 优缺点 | 简要说明 |

|---|---|

| 优点 | 1. 仅仅需要以方差衡量信息量,不受数据集以外的因素影响。 2.各主成分之间正交,可消除原始数据成分间的相互影响的因素。3. 计算方法简单,主要运算是特征值分解,易于实现。 |

| 缺点 | 1.主成分各个特征维度的含义具有一定的模糊性,不如原始样本特征的解释性强。2. 方差小的非主成分也可能含有对样本差异的重要信息,因降维丢弃可能对后续数据处理有影响。 |

1.15.6 降维的必要性及目的

降维的必要性:

- 多重共线性和预测变量之间相互关联。多重共线性会导致解空间的不稳定,从而可能导致结果的不连贯。

- 高维空间本身具有稀疏性。一维正态分布有68%的值落于正负标准差之间,而在十维空间上只有2%。

- 过多的变量,对查找规律造成冗余麻烦。

- 仅在变量层面上分析可能会忽略变量之间的潜在联系。例如几个预测变量可能落入仅反映数据某一方面特征的一个组内。

降维的目的:

- 减少预测变量的个数。

- 确保这些变量是相互独立的。

- 提供一个框架来解释结果。相关特征,特别是重要特征更能在数据中明确的显示出来;如果只有两维或者三维的话,更便于可视化展示。

- 数据在低维下更容易处理、更容易使用。

- 去除数据噪声。

- 降低算法运算开销。

1.15.7 KPCA与PCA的区别

应用PCA算法前提是假设存在一个线性超平面,进而投影。那如果数据不是线性的呢?该怎么办?这时候就需要KPCA,数据集从 n n n 维映射到线性可分的高维 N > n N >n N>n,然后再从 N N N 维降维到一个低维度 n ′ ( n ′ < n < N ) n'(n'<n<N) n′(n′<n<N) 。

KPCA用到了核函数思想,使用了核函数的主成分分析一般称为核主成分分析(Kernelized PCA, 简称KPCA)。

假设高维空间数据由 n n n 维空间的数据通过映射 ϕ \phi ϕ 产生。

n

n

n 维空间的特征分解为:

∑

i

=

1

m

x

(

i

)

(

x

(

i

)

)

T

W

=

λ

W

\sum^m_{i=1} x^{(i)} \left( x^{(i)} \right)^T W = \lambda W

i=1∑mx(i)(x(i))TW=λW

其映射为

∑

i

=

1

m

ϕ

(

x

(

i

)

)

ϕ

(

x

(

i

)

)

T

W

=

λ

W

\sum^m_{i=1} \phi \left( x^{(i)} \right) \phi \left( x^{(i)} \right)^T W = \lambda W

i=1∑mϕ(x(i))ϕ(x(i))TW=λW

通过在高维空间进行协方差矩阵的特征值分解,然后用和PCA一样的方法进行降维。由于KPCA需要核函数的运算,因此它的计算量要比PCA大很多。

1.16 模型评估

1.16.1 模型评估常用方法?

一般情况来说,单一评分标准无法完全评估一个机器学习模型。只用good和bad偏离真实场景去评估某个模型,都是一种欠妥的评估方式。下面介绍常用的分类模型和回归模型评估方法。

分类模型常用评估方法:

| 指标 | 描述 |

|---|---|

| Accuracy | 准确率 |

| Precision | 精准度/查准率 |

| Recall | 召回率/查全率 |

| P-R曲线 | 查准率为纵轴,查全率为横轴,作图 |

| F1 | F1值 |

| Confusion Matrix | 混淆矩阵 |

| ROC | ROC曲线 |

| AUC | ROC曲线下的面积 |

回归模型常用评估方法:

| 指标 | 描述 |

|---|---|

| Mean Square Error (MSE, RMSE) | 平均方差 |

| Absolute Error (MAE, RAE) | 绝对误差 |

| R-Squared | R平方值 |

1.16.2 误差、偏差和方差有什么区别和联系

在机器学习中,Bias(偏差),Error(误差),和Variance(方差)存在以下区别和联系:

**对于Error **:

-

误差(error):一般地,我们把学习器的实际预测输出与样本的真是输出之间的差异称为“误差”。

-

Error = Bias + Variance + Noise,Error反映的是整个模型的准确度。

对于Noise:

噪声:描述了在当前任务上任何学习算法所能达到的期望泛化误差的下界,即刻画了学习问题本身的难度。

对于Bias:

- Bias衡量模型拟合训练数据的能力(训练数据不一定是整个 training dataset,而是只用于训练它的那一部分数据,例如:mini-batch),Bias反映的是模型在样本上的输出与真实值之间的误差,即模型本身的精准度。

- Bias 越小,拟合能力越高(可能产生overfitting);反之,拟合能力越低(可能产生underfitting)。

- 偏差越大,越偏离真实数据,如下图第二行所示。

对于Variance:

-

方差公式: S N 2 = 1 N ∑ i = 1 N ( x i − x ˉ ) 2 S_{N}^{2}=\frac{1}{N}\sum_{i=1}^{N}(x_{i}-\bar{x})^{2} SN2=N1∑i=1N(xi−xˉ)2

-

Variance描述的是预测值的变化范围,离散程度,也就是离其期望值的距离。方差越大,数据的分布越分散,模型的稳定程度越差。

-

Variance反映的是模型每一次输出结果与模型输出期望之间的误差,即模型的稳定性。

-

Variance越小,模型的泛化的能力越高;反之,模型的泛化的能力越低。

-

如果模型在训练集上拟合效果比较优秀,但是在测试集上拟合效果比较差劣,则方差较大,说明模型的稳定程度较差,出现这种现象可能是由于模型对训练集过拟合造成的。 如下图右列所示。

1.16.3 经验误差与泛化误差

经验误差(empirical error):也叫训练误差(training error),模型在训练集上的误差。

泛化误差(generalization error):模型在新样本集(测试集)上的误差称为“泛化误差”。

1.16.4 图解欠拟合、过拟合

根据不同的坐标方式,欠拟合与过拟合图解不同。

- 横轴为训练样本数量,纵轴为误差

如上图所示,我们可以直观看出欠拟合和过拟合的区别:

模型欠拟合:在训练集以及测试集上同时具有较高的误差,此时模型的偏差较大;

模型过拟合:在训练集上具有较低的误差,在测试集上具有较高的误差,此时模型的方差较大。

模型正常:在训练集以及测试集上,同时具有相对较低的偏差以及方差。

- 横轴为模型复杂程度,纵轴为误差

红线为测试集上的Error,蓝线为训练集上的Error

模型欠拟合:模型在点A处,在训练集以及测试集上同时具有较高的误差,此时模型的偏差较大。

模型过拟合:模型在点C处,在训练集上具有较低的误差,在测试集上具有较高的误差,此时模型的方差较大。

模型正常:模型复杂程度控制在点B处为最优。

- 横轴为正则项系数,纵轴为误差

红线为测试集上的Error,蓝线为训练集上的Error

模型欠拟合:模型在点C处,在训练集以及测试集上同时具有较高的误差,此时模型的偏差较大。

模型过拟合:模型在点A处,在训练集上具有较低的误差,在测试集上具有较高的误差,此时模型的方差较大。 它通常发生在模型过于复杂的情况下,如参数过多等,会使得模型的预测性能变弱,并且增加数据的波动性。虽然模型在训练时的效果可以表现的很完美,基本上记住了数据的全部特点,但这种模型在未知数据的表现能力会大减折扣,因为简单的模型泛化能力通常都是很弱的。

模型正常:模型复杂程度控制在点B处为最优。

1.16.5 如何解决过拟合与欠拟合

如何解决欠拟合:

- 添加其他特征项。组合、泛化、相关性、上下文特征、平台特征等特征是特征添加的重要手段,有时候特征项不够会导致模型欠拟合。

- 添加多项式特征。例如将线性模型添加二次项或三次项使模型泛化能力更强。例如,FM(Factorization Machine)模型、FFM(Field-aware Factorization Machine)模型,其实就是线性模型,增加了二阶多项式,保证了模型一定的拟合程度。

- 可以增加模型的复杂程度。

- 减小正则化系数。正则化的目的是用来防止过拟合的,但是现在模型出现了欠拟合,则需要减少正则化参数。

如何解决过拟合:

- 重新清洗数据,数据不纯会导致过拟合,此类情况需要重新清洗数据。

- 增加训练样本数量。

- 降低模型复杂程度。

- 增大正则项系数。

- 采用dropout方法,dropout方法,通俗的讲就是在训练的时候让神经元以一定的概率不工作。

- early stopping。

- 减少迭代次数。

- 增大学习率。

- 添加噪声数据。

- 树结构中,可以对树进行剪枝。

- 减少特征项。

欠拟合和过拟合这些方法,需要根据实际问题,实际模型,进行选择。

1.16.6 交叉验证的主要作用