✨✨ 欢迎大家来到景天科技苑✨✨

?? 养成好习惯,先赞后看哦~??

? 作者简介:景天科技苑

?《头衔》:大厂架构师,华为云开发者社区专家博主,阿里云开发者社区专家博主,CSDN全栈领域优质创作者,掘金优秀博主,51CTO博客专家等。

?《博客》:Python全栈,PyQt5和Tkinter桌面开发,小程序开发,人工智能,js逆向,App逆向,网络系统安全,数据分析,Django,fastapi,flask等框架,云原生K8S,linux,shell脚本等实操经验,网站搭建,数据库等分享。

所属的专栏:python综合应用,基础语法到高阶实战教学

景天的主页:景天科技苑

文章目录

Python实现XGBoost算法1. XGBoost简介1.1 XGBoost的基本思想1.2 XGBoost的优势 2. 环境准备3. 数据准备3.1 数据集介绍3.2 数据加载和预处理 4. 模型训练4.1 参数设置4.2 训练模型 5. 模型评估与预测5.1 模型评估5.2 预测新数据 6. 特征重要性与模型调优6.1 特征重要性6.2 模型调优 7. 总结与进一步学习7.1 总结7.2 进一步学习

Python实现XGBoost算法

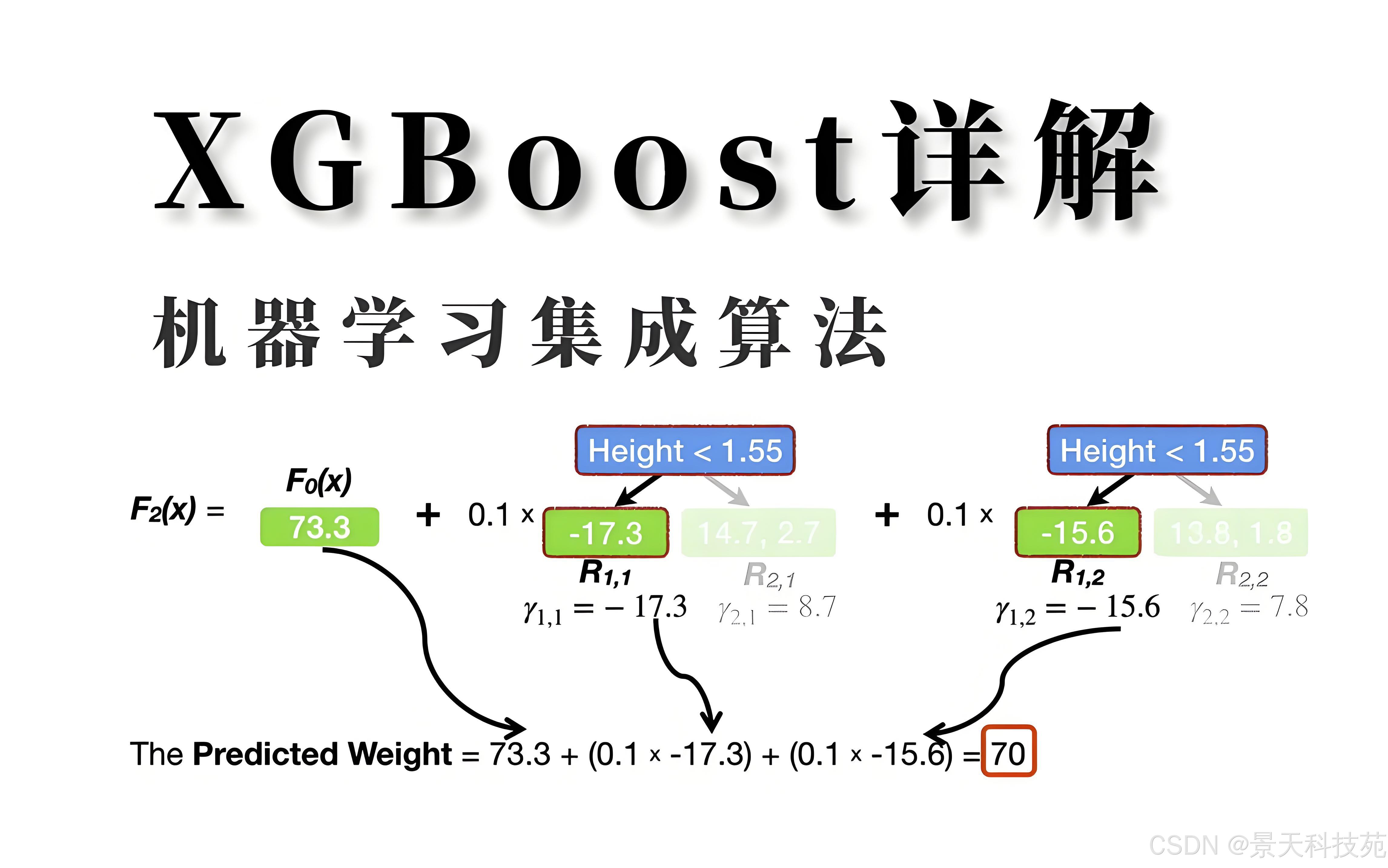

XGBoost(Extreme Gradient Boosting)是一种高效且广泛使用的集成学习算法,它属于梯度提升树(GBDT)模型的一种改进。XGBoost通过引入多种优化策略,如二阶泰勒展开、正则化项、自动处理缺失值等,显著提高了模型的预测精度和性能。本文将结合实际案例,详细介绍如何在Python中使用XGBoost算法进行模型训练和预测。

1. XGBoost简介

1.1 XGBoost的基本思想

XGBoost是一种基于梯度提升框架的算法,它通过构建多棵决策树来累加预测值,每棵树都试图修正前一棵树的预测误差。XGBoost的核心思想是贪心法,即逐棵树进行学习,每棵树拟合之前模型的偏差。

1.2 XGBoost的优势

二阶泰勒展开:XGBoost在目标函数优化时使用了二阶泰勒展开,相比一阶展开保留了更多信息,有助于提升模型效果。正则化项:XGBoost加入了L1和L2正则化项,有助于控制模型的复杂度,防止过拟合。自动处理缺失值:XGBoost能够自动处理数据中的缺失值,无需预处理。支持并行计算:XGBoost支持特征并行和数据并行,可以显著提升训练速度。2. 环境准备

在开始之前,请确保你的Python环境中已安装XGBoost库。如果没有安装,可以通过pip安装:

pip install xgboost此外,我们还将使用到pandas、numpy、sklearn等库来处理数据和评估模型,确保这些库也已安装。

3. 数据准备

3.1 数据集介绍

为了演示,我们将使用经典的鸢尾花(Iris)数据集,该数据集包含150个样本,每个样本有4个特征(花萼长度、花萼宽度、花瓣长度、花瓣宽度),以及对应的3种类别标签(Setosa、Versicolour、Virginica)。虽然鸢尾花数据集是分类问题,但XGBoost同样适用于回归问题。

3.2 数据加载和预处理

import pandas as pdfrom sklearn.datasets import load_irisfrom sklearn.model_selection import train_test_splitfrom sklearn.metrics import accuracy_score# 加载数据iris = load_iris()X = iris.datay = iris.target# 数据集划分X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)# 转换为DMatrix格式,DMatrix是XGBoost内部的数据结构,对性能有优化dtrain = xgb.DMatrix(X_train, label=y_train)dtest = xgb.DMatrix(X_test, label=y_test)4. 模型训练

4.1 参数设置

在训练模型之前,需要设置一些重要的参数。以下是一些常用参数及其含义:

max_depth:树的最大深度,增加此值会使模型变得更复杂,但可能导致过拟合。eta(或learning_rate):学习率,控制每棵树对最终结果的贡献。较小的值需要更多的树来拟合训练数据,但通常能得到更好的泛化能力。objective:目标函数,对于分类问题可以是multi:softmax或multi:softprob,对于回归问题则是reg:squarederror等。num_class:类别数,仅用于多分类问题。gamma:分裂节点所需的最小损失函数下降值,越大模型越保守。min_child_weight:子节点的最小权重和,较大的值会防止模型学习到噪声数据。subsample:样本采样比例,用于防止过拟合。colsample_bytree:特征采样比例,用于防止过拟合。 4.2 训练模型

import xgboost as xgb# 设置参数params = { 'max_depth': 3, 'eta': 0.1, 'objective': 'multi:softmax', 'num_class': 3}num_round = 100 # 迭代次数# 训练模型bst = xgb.train(params, dtrain, num_round)5. 模型评估与预测

5.1 模型评估

在模型训练完成后,我们需要在测试集上评估模型的性能。对于分类问题,常用的评估指标有准确率(accuracy)、精确率(precision)、召回率(recall)和F1分数(F1-score)等。由于我们的数据集是平衡的,所以这里使用准确率作为评估指标。

# 使用测试集进行预测preds = bst.predict(dtest)# 预测结果转换为类别标签(因为predict返回的是概率值,我们需要取概率最大的类别作为预测结果)predicted_classes = [np.argmax(line) for line in preds]# 计算准确率accuracy = accuracy_score(y_test, predicted_classes)print(f"Accuracy: {accuracy:.4f}")注意:由于XGBoost的predict方法在分类任务中默认返回每个类别的概率,因此我们需要通过np.argmax来找到概率最大的类别作为预测结果。

5.2 预测新数据

在实际应用中,我们通常会使用训练好的模型来预测新数据。假设我们有一些新的样本数据X_new,我们可以直接使用训练好的模型进行预测。

# 假设X_new是新的数据集# X_new = ... # 这里应该是你的新数据# 将新数据转换为DMatrix格式dnew = xgb.DMatrix(X_new)# 使用模型进行预测preds_new = bst.predict(dnew)predicted_classes_new = [np.argmax(line) for line in preds_new]# 输出预测结果print("Predicted classes for new data:", predicted_classes_new)6. 特征重要性与模型调优

6.1 特征重要性

XGBoost提供了方便的方法来查看特征的重要性。特征重要性可以帮助我们理解哪些特征对模型的预测结果贡献最大。

# 获取特征重要性importances = bst.get_fscore()# 打印特征重要性print("Feature importances:", importances)# 也可以将特征重要性排序后输出sorted_importances = sorted(importances.items(), key=lambda x: x[1], reverse=True)for feature, importance in sorted_importances: print(f"{feature}: {importance}")6.2 模型调优

模型调优是机器学习中的一个重要环节,它涉及到调整模型的参数以改善模型的性能。在XGBoost中,我们通常使用交叉验证(如xgb.cv)来评估不同参数组合下的模型性能,从而找到最优的参数设置。

from sklearn.model_selection import GridSearchCV# 定义参数网格param_grid = { 'max_depth': [3, 4, 5], 'eta': [0.01, 0.1, 0.3], 'subsample': [0.7, 0.8, 0.9], 'colsample_bytree': [0.7, 0.8, 0.9]}# 注意:XGBoost的GridSearchCV需要使用xgb.XGBClassifier或xgb.XGBRegressor包装器xgb_clf = xgb.XGBClassifier(objective='multi:softmax', num_class=3)# 使用GridSearchCV进行参数搜索grid_search = GridSearchCV(estimator=xgb_clf, param_grid=param_grid, cv=5, scoring='accuracy', verbose=1)grid_search.fit(X_train, y_train)# 输出最优参数和最优模型print("Best parameters found: ", grid_search.best_params_)print("Best score found: ", grid_search.best_score_)# 可以使用最优参数重新训练模型best_bst = grid_search.best_estimator_注意:上面的代码中使用了xgb.XGBClassifier而不是直接调用xgb.train,这是因为GridSearchCV需要与scikit-learn兼容的API一起工作。然而,对于xgb.train,我们可以使用xgb.cv进行交叉验证,但参数调整需要手动进行。

7. 总结与进一步学习

7.1 总结

在本文中,我们详细探讨了如何在Python中使用XGBoost库来实现一个机器学习模型,从数据准备、模型训练、参数调优到模型评估和预测,整个过程都得到了全面的覆盖。XGBoost作为一种强大的梯度提升框架,凭借其高效的算法设计和灵活的参数设置,成为了处理分类、回归等问题的首选工具之一。

通过实际案例(鸢尾花数据集)的演示,我们不仅学习了如何使用XGBoost进行基本的模型训练和预测,还掌握了如何通过特征重要性和交叉验证来优化模型性能。这些技能对于从事数据分析和机器学习工作的人来说,是极其宝贵的。

7.2 进一步学习

尽管本教程已经涵盖了XGBoost的许多基础用法,但XGBoost的功能远不止于此。以下是一些建议,帮助你进一步深入学习和应用XGBoost:

深入学习XGBoost的参数:

XGBoost拥有众多的参数,每个参数都对模型的性能有不同的影响。深入理解这些参数的含义和它们之间的相互作用,将帮助你更好地调整模型,以应对不同的数据集和问题。尝试不同的数据集:

使用不同类型和规模的数据集来训练XGBoost模型,可以帮助你更全面地了解XGBoost的适用范围和性能表现。例如,可以尝试使用大型数据集、不平衡数据集或高维数据集。学习XGBoost的高级特性:

XGBoost支持多种高级特性,如早停(early stopping)、保存和加载模型、自定义目标函数和评估指标等。掌握这些特性,将使你能够更灵活地应用XGBoost来解决实际问题。探索XGBoost在竞赛中的应用:

XGBoost在各类机器学习竞赛中表现出色,许多获奖者都将其作为主要的模型之一。参与这些竞赛,不仅可以锻炼你的技能,还可以学习到其他优秀选手的建模思路和技巧。学习与其他库的结合使用:

XGBoost通常与scikit-learn、pandas、numpy等库结合使用,以实现数据的预处理、模型的训练和评估等任务。掌握这些库的结合使用,将提高你的数据处理和模型构建效率。关注XGBoost的最新发展:

XGBoost是一个不断发展的项目,其新版本中经常包含性能改进、新特性和错误修复。关注XGBoost的官方文档和社区动态,将使你能够及时了解其最新发展,并应用到你的工作中。实践与应用:

最重要的是,将所学的知识应用到实际项目中。通过解决实际问题,你将更深入地理解XGBoost的工作原理和优势,并积累宝贵的实践经验。总之,XGBoost是一种强大而灵活的机器学习算法,掌握其使用方法对于从事数据分析和机器学习工作的人来说至关重要。希望本文能够为你提供一个良好的起点,并激发你对XGBoost深入学习的兴趣和动力。