【AI大语言模型应用】使用Ollama搭建本地大语言模型

【AI大语言模型应用】使用Ollama搭建本地大语言模型

简单介绍什么是Ollama

这玩意儿其实就是一个能够帮你快速启动并运行大语言模型的平台。

你可以类比于Java中的Springboot+maven

这个ollama是用go语言编写的,我对go语言了解不深,所以更细节的平台实现需要各位自行学习。

目前这个ollama支持 windows、linux、macos

下载Ollama

目前主要是两种安装方式:直接安装和docker安装

下面就直接开始了

平台:windows

下载地址:https://ollama.com/download/OllamaSetup.exe

很简单,直接下一步下一步就行。

平台:Linux (CentOS7)

直接命令安装:

curl -fsSL https://ollama.com/install.sh | sh

如果存在安装不了的情况,那就自己手动安装包

根据不同的平台下载压缩包手动安装

amd64 :https://ollama.com/download/ollama-linux-amd64.tgz

AMD GPU: https://ollama.com/download/ollama-linux-amd64-rocm.tgz

ARM64: https://ollama.com/download/ollama-linux-arm64.tgz

给ollama创建一个用户和组信息

sudo useradd -r -s /bin/false -U -m -d /usr/share/ollama ollamasudo usermod -a -G ollama $(whoami)创建一个服务文件/etc/systemd/system/ollama.service

[Unit]Description=Ollama ServiceAfter=network-online.target[Service]ExecStart=/usr/bin/ollama serveUser=ollamaGroup=ollamaRestart=alwaysRestartSec=3Environment="PATH=$PATH"[Install]WantedBy=default.target然后启动服务

sudo systemctl daemon-reloadsudo systemctl enable ollama平台:macOS

下载地址:https://ollama.com/download/Ollama-darwin.zip

DOCKER安装

根据平台选择下面的方式安装

# cpu或者英伟达GPUdocker pull ollama/ollama# AMD显卡docker pull ollama/ollama:rocm# 使用指定版本# CPU 或 Nvidia GPU 运行docker pull ollama/ollama:0.3.0# AMD 显卡运行docker pull ollama/ollama:0.3.0-rocmdocker运行

# 默认 CPU 模式运行docker run -d -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama# Nvidia GPU 模式运行docker run -d --gpus=all -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama# AMD 显卡运行docker run -d --device /dev/kfd --device /dev/dri -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama:rocm设置ollama的模型下载位置

在系统的环境变量进行设置就好了

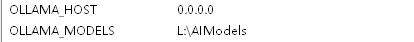

windows直接添加系统环境变量:

OLLAMA_HOST = 0.0.0.0

OLLAMA_MODELS = 你的models安装路径

Linux和macOS的自行百度设置环境变量,只需要将上面的这种映射对就行

然后重新启动Ollama

使用Ollama

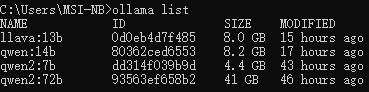

使用命令 ollama list 查看已经下载了多少模型

下载并运行模型

ollama run qwen:14b

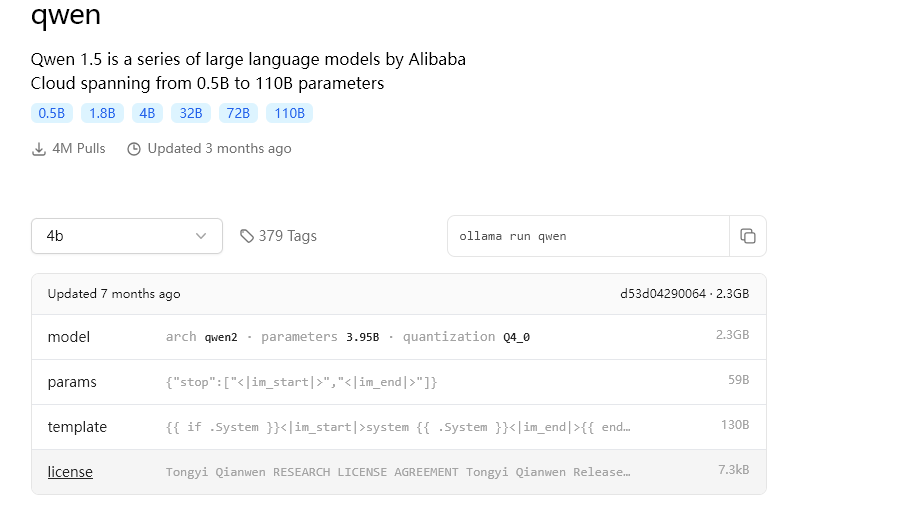

可以下载哪些模型呢?

官方地址:https://ollama.com/library

我这里选择阿里千问模型

选择好版本,并复制右边的命令运行

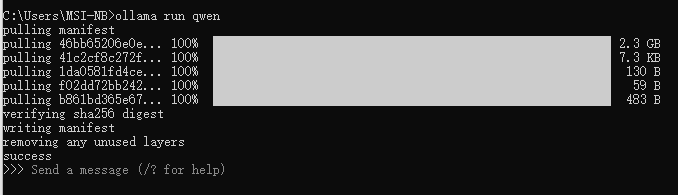

注意网络要通畅(在pulling的时候,可以开启vpn)

使用模型:

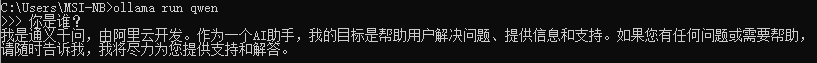

打开终端输入ollama run qwen 即可

使用Ollama提供的API

快速调用

目前你已经有了一个qwen大模型

直接使用ollama提供的API调用即可

请求url

POST http://localhost:11434/api/generate

请求体

{

“model”: “qwen2:7b”,

“prompt”: “你是谁?”,

“stream”: false

}

响应体

{

“model”: “qwen”,

“created_at”: “2024-09-17T10:22:20.1823352Z”,

“response”: “我是通义千问,由阿里云开发的人工智能模型。我的主要功能是回答用户的问题、提供信息和帮助解决问题等。如果您有任何问题或需要帮助,请随时告诉我,我会尽力提供支持。”,

“total_duration”: 3890331300,

“load_duration”: 3036409100,

“prompt_eval_count”: 11,

“prompt_eval_duration”: 65339000,

“eval_count”: 46,

“eval_duration”: 787166000

}

更多的API,请前往官方API地址:https://github.com/ollama/ollama/blob/main/docs/api.md

至此就完成了整个的Ollama模型的搭建工作

登录后可发表评论

点击登录