准备好qwen2模型:去huggingface镜像、魔搭 都可下载:

HF-Mirror、魔搭社区

创建conda环境:

conda create -n name python==3.10 (python环境一定要3.10 后面有用!)

激活环境:

conda activate name

替换镜像源:

pip config set global.index-url https://pypi.tuna.tsinghua.edu.cn/simple

安装所需依赖:

pip install modelscope==1.11.0

pip install openai==1.17.1

pip/pip3 install torch torchvision torchaudiopip install tqdm==4.64.1pip install transformers==4.39.3

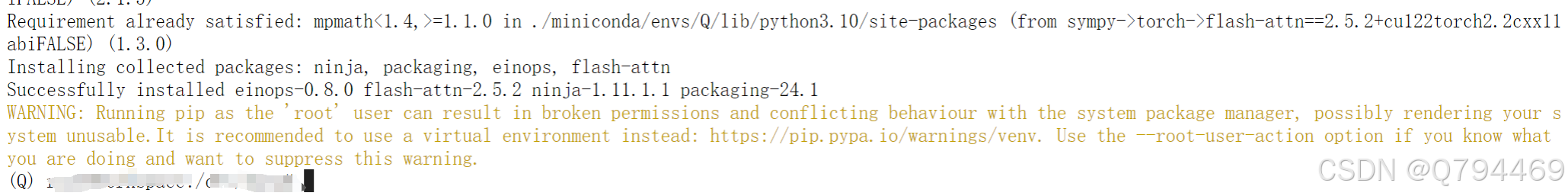

安装flash-attn依赖包的时候有坑!

需要先安装nijia这个包:

pip install ninja

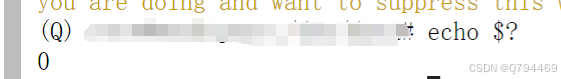

检查ninja是否安装成功:

echo $?

返回0代表安装成功!

此时再次安装flash-attn:

MAX_JOBS=8 pip install flash-attn --no-build-isolation

还是报错,加上代理再次安装!

pip install https://github.com/Dao-AILab/flash-attention/releases/download/v2.5.2/flash_attn-2.5.2+cu122torch2.2cxx11abiFALSE-cp310-cp310-linux_x86_64.whl

如果超时 可以设置参数 --timeout=250(具体多少根据实际情况定)