目录

什么是 Ollama WebUI?

系统要求

win配置

wsl常用指令

ubuntu更新

安装过程

ollama安装

open-webui安装

修改open webui端口

什么是 Ollama WebUI?

Ollama WebUI 已经更名为 Open WebUI. Open WebUI 是一个可扩展、功能丰富且用户友好的自托管 WebUI,旨在完全离线操作。它支持各种 LLM 运行程序,包括 Ollama 和 OpenAI 兼容的 API。

Ollama WebUI 是一个革命性的 LLM 本地部署框架,具有类似 ChatGPT 的 Web 界面。让我们为您的 Ollama 部署的 LLM 提供类似 ChatGPT Web UI 的界面,只需按照以下 5 个步骤开始行动吧。

系统要求

Windows 10 64 位:最低要求是 Home 或 Pro 21H2(内部版本 19044)或更高版本,或者 Enterprise 或 Education 21H2(内部版本 19044)或更高版本。

Windows 11 64 位:家庭版或专业版 21H2 或更高版本,或者企业版或教育版 21H2 或更高版本。

WSL 版本 1.1.3.0 或更高版本。在 Windows 上打开 WSL 2 功能。

8 核 64 位处理器、16GB+ RAM、带有 4GB+ VRAM 的 Nvidia 显卡。

win配置

wsl安装cuda环境, 按照NVIDIA给出的教程,首先需要安装Windows平台上的NVIDIA显卡驱动。

首先win安装cuda环境 查看指令 nvidia-smi

win能看到 那wsl中也能看到 然后安装

参考链接

Win10自定义路径位置安装WSL2 (Ubuntu 20.04) 并配置CUDA

https://zhuanlan.zhihu.com/p/681092042

wsl常用指令

查看运行版本号

wsl -l -v更新wsl,查看版本

wsl --updatewsl --version注销指定wsl镜像(注意就相当于删除系统,资料全丢的那种,慎重操作)

wsl --unregister wsl_01_ollama_webui_ubuntu2004导入导出,从网上下载好镜像,解压,用这种方式导入,可以指定安装目录,并指定名称

wsl --import wsl_00_ollama_webui_langchain E:\wsl2\img_wsl_00_ollama_webui_langchain E:\wsl2\wsl_img\Ubuntu_2004.2021.825.0_x64\install.tar.gzwsl --export wsl_ollama_webui_ubuntu2004 E:\wsl2\export\wsl_ollama_webui_ubuntu2004.tar.gz运行关闭指令 -u是以指定用户运行

wsl -d wsl_ollama_webui_ubuntu2004wsl -d wsl_ollama_webui_ubuntu2004 -u rootwsl -t wsl_ollama_webui_ubuntu2004使用非root用户,默认登录即解决方案先添加book用户

adduser booksudo adduser book sudo再添加以下内容,

sudo vim /etc/wsl.conf[user]default = book可以不用vim指令,使用echo也可以达到同样效果

echo "[user]" >> /etc/wsl.confecho "default = book" >> /etc/wsl.confVmmem介绍

Vmmem 进程是系统合成的一个虚拟进程,用于表示虚拟机消耗的内存和 CPU 资源。 换句话说,如果您看到 Vmmem 消耗大量内存和 CPU 资源,那么这意味着您的虚拟机正在消耗大量内存和 CPU 资源。如果要让它停止,请关闭您的虚拟机。

具体步骤

[wsl2]memory=2GBswap=0localhostForwarding=trueubuntu更新

sudo apt-get update sudo apt-get upgrade

安装过程

安装 wsl-ubuntu安装 Ubuntu-22.04,默认会安装在 C 盘,

wsl.exe --install -d Ubuntu-22.04导出 Ubuntu-22.04,

wsl --export Ubuntu-22.04 D:\tmp\Ubuntu-22.04.tar删除 Ubuntu-22.04,

wsl --unregister Ubuntu-22.04导入 Ubuntu-22.04,导入到 F:\VirtualPCs\Ubuntu-22.04 目录,

wsl --import Ubuntu-22.04 F:\VirtualPCs\Ubuntu-22.04 D:\tmp\Ubuntu-22.04.tar访问 Ubuntu-22.04,

wsl -d Ubuntu-22.04退出 Ubuntu-22.04,

exit(可选)关闭 Ubuntu-22.04,

wsl --shutdownollama安装

一键安装ollama,运行serve 在运行模型,此处下载并运行qwen2:7b,如果GPU不足,可以运行qwen2:7b-instruct-q5_K_M

curl -fsSL https://ollama.com/install.sh | shollama serveollama run qwen2-7b

open-webui安装

我安装的当前版本是

open webui v0.3.16

ollama v0.3.8

open-webui的安装采用直接官网下载最新源码安装的方式, 创建conda运行环境。

conda create --name open-webui-env python=3.11conda activate open-webui-env1、进入open-webui源码git官网,下载最新版本

https://github.com/open-webui/open-webui

直接下载zip安装包。(右上角点击code,点击download zip)

在root下创建open-webui文件夹,将zip文件解压到该文件夹。

2、重新安装open-webui并启动

#1.环节配置cd /root/open-webuicp -RPp .env.example .env#2.安装前端依赖npm inpm run build#3.安装后端依赖cd backendpip install -r requirements.txt#4.启动后端bash start.sh启动后访问:http://localhost:8080/

修改open webui端口

打开/root/open-webui/backend/start.sh文件修改端口

#!/usr/bin/env bashSCRIPT_DIR=$( cd -- "$( dirname -- "${BASH_SOURCE[0]}" )" &> /dev/null && pwd )cd "$SCRIPT_DIR" || exitKEY_FILE=.webui_secret_keyPORT="${PORT:-8088}"HOST="${HOST:-0.0.0.0}"重新启动服务后,访问:http://localhost:8088/

首次登录需要创建一个账号,如admin。

登录系统后可以自己下载qwen2的多个模型测试。

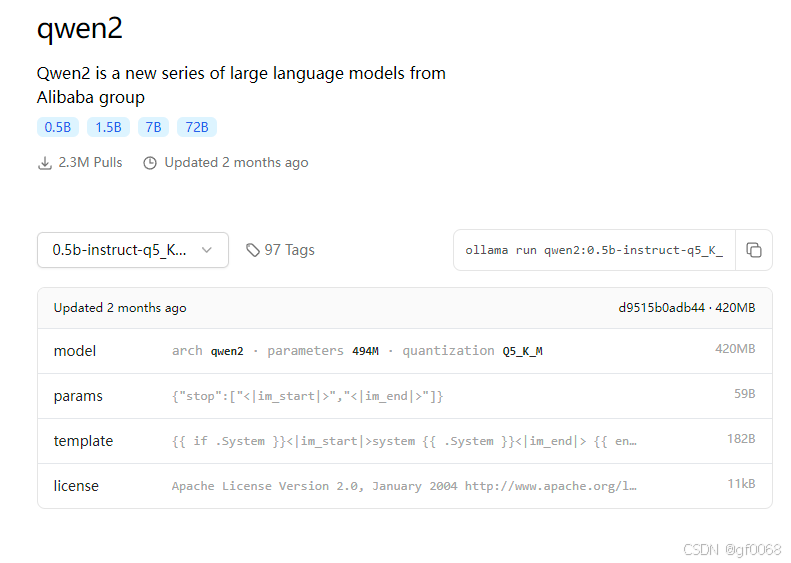

可以访问https://ollama.com/library 找到qwen2,选择合适的模型

点击上图的拷贝图标,获得:ollama run qwen2:7b-instruct-q5_K_M

在此处粘贴该文字,点下载即可。