一、大模型+工作流的优势

1. 降低任务门槛:工作流可以将复杂任务分解成多个小任务,降低每个任务的复杂度,从而减少对提示词和大模型推理能力的依赖。这样可以提升大模型处理复杂任务的性能和容错能力。

2. 提升任务效率:工作流可以实现自动化处理,减少重复劳动和纠正。只需提供必要元素,工作流就可以直接输出结果,提高效率和稳定性。

3. 提高任务的一致性:工作流可以确保任务的执行是一致的,减少人为错误和偏差,提高任务的可靠性和质量。

4. 实现任务的可重复性:工作流可以实现任务的可重复性,减少重复劳动和开发时间,提高开发效率和生产力。

二 安装ollama

1、安装ollama

下载ollama官方mac安装程序,下载后直接双击应用程序安装。

地址:Ollama

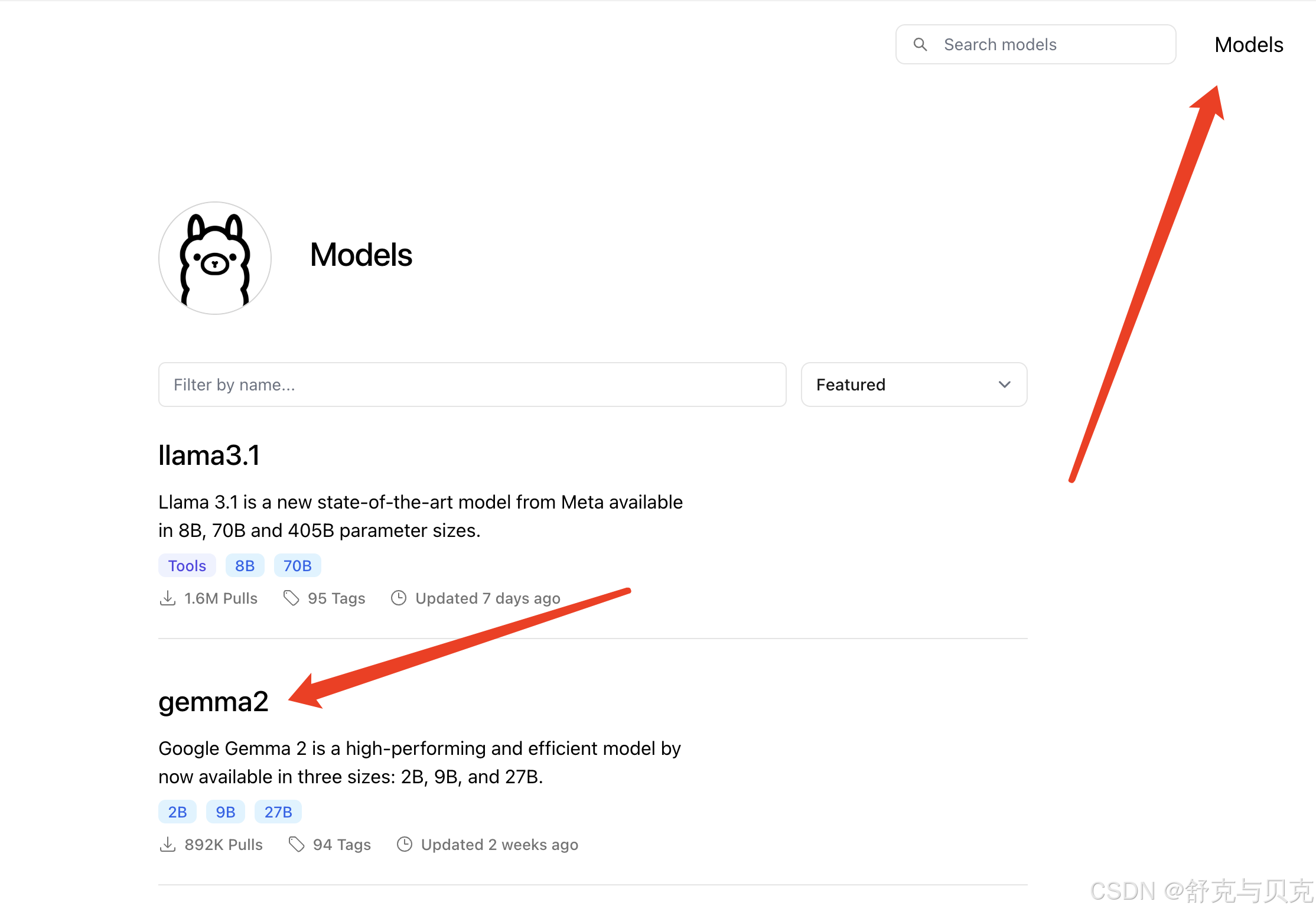

下载需要的大模型

三、安装部署FastGPT

Docker Compose 快速部署 | FastGPT

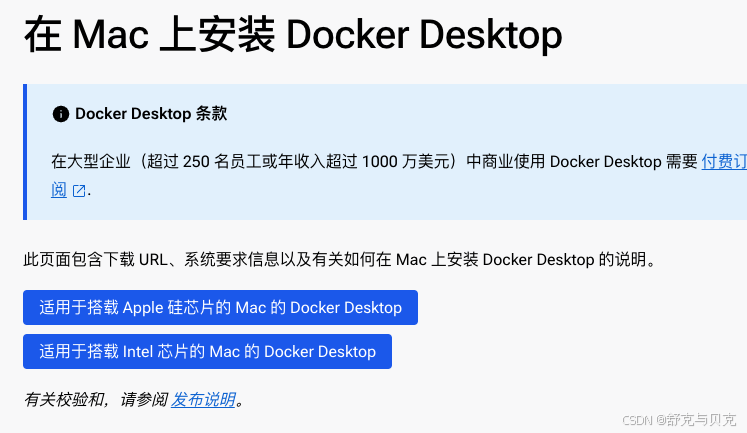

3.1 使用Docker环境部署(请提前安装好docker)

在 Mac 上安装 Docker Desktop | Docker 文档

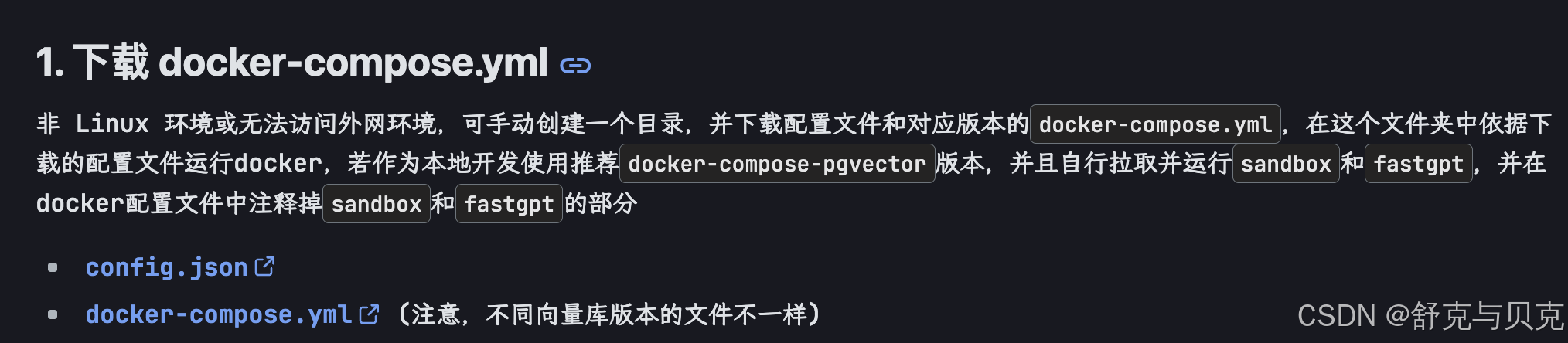

3.2 部署fastgpt

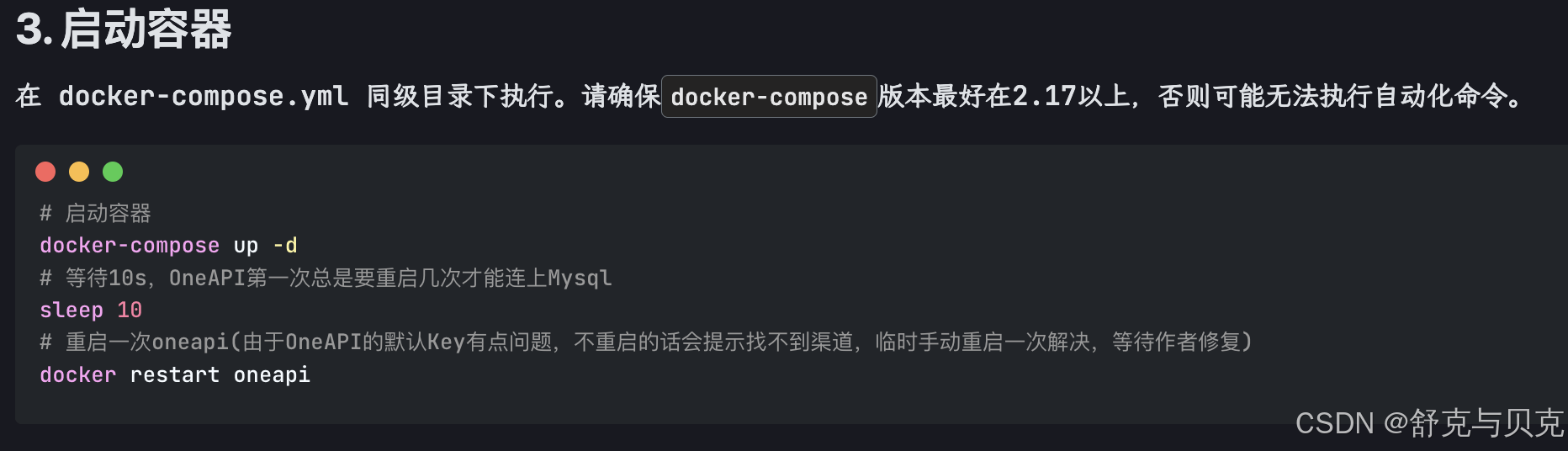

3.3 启动并配置oneapi模型:

访问本地部署好的oneapi:http://localhost:3001/channel

初始化的 用户名:root 密码:123456

3.4 配置Fastgpt

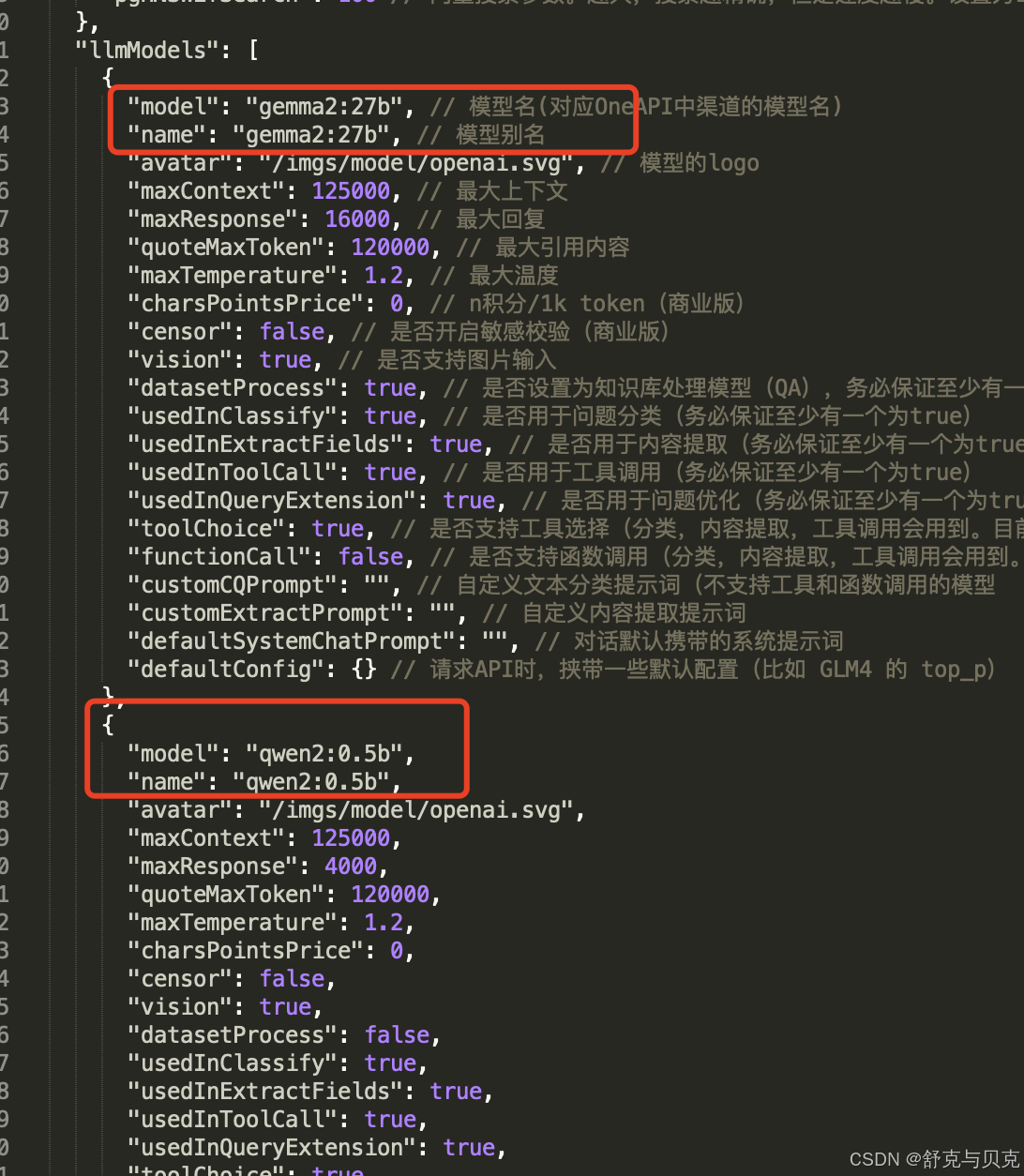

1、配置fastgpt的模型

进入最开始的fastgpt文件夹。找到config.json,配置llama3模型,位置和代码如下:

完成配置后需要重新启动dockerdesktop里面的oneapi和fastgpt。

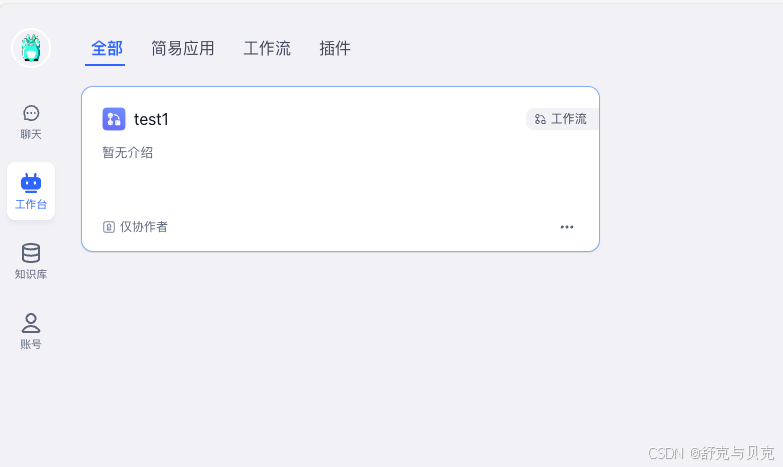

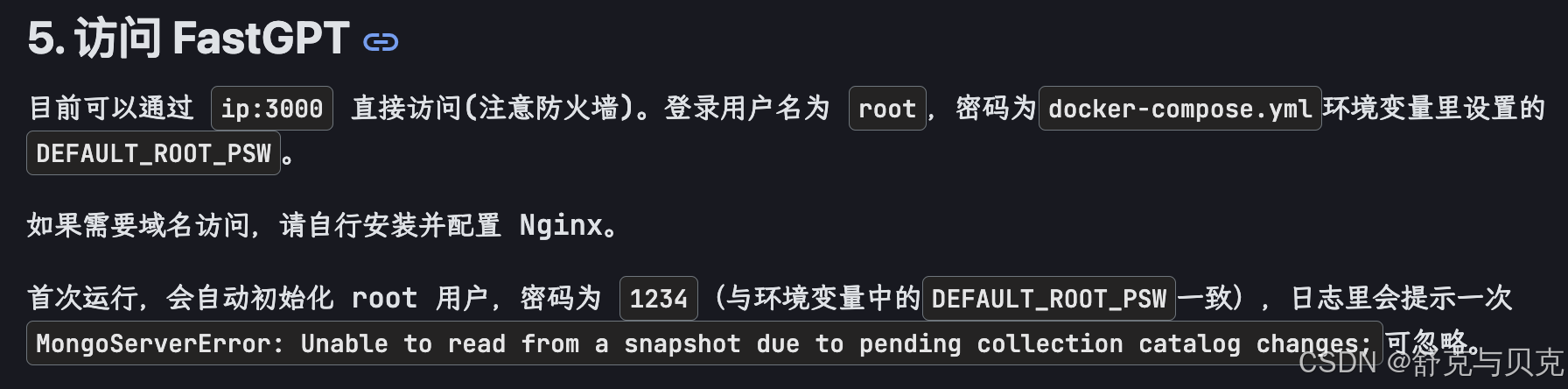

2、访问fastgpt

地址:http://localhost:3000/login,默认用户名:root 密码:1234