CVPR(IEEE Conference on Computer Vision and Pattern Recognition)是计算机视觉领域最有影响力的会议之一,主要方向包括图像和视频处理、目标检测与识别、三维视觉等。近期,CVPR 2024 公布了最佳论文。共有10篇论文获奖,其中2篇最佳论文,2篇最佳学生论文,2篇最佳论文题目和4篇最佳学生论文提名。本公众号推出CVPR 2024最佳论文专栏,分享这10篇最佳论文。

本文详细介绍了CVPR 2024最佳论文提名《EventPS: Real-Time Photometric Stereo Using an Event Camera》。该论文的第一作者为于博涵(北京大学计算机学院2021级直博生,导师:施柏鑫)。论文提出了一种使用事件相机的实时光度立体视觉(Photometric Stereo, PS)新方法。传统的 PS 方法需要在不同照明条件下捕捉多张高动态范围图像,这既耗时又需要高数据带宽。EventPS 利用事件相机卓越的时间分辨率、动态范围和低带宽特性,通过辐射变化来估计表面法线。这种方法与基于优化和深度学习的 PS 技术无缝结合,提供了一个应对非朗伯表面的解决方案。本推文由黄星宇撰写,审校为邱雪和许东舟。

原文链接:

https://openaccess.thecvf.com/content/CVPR2024/papers/Yu_EventPS_Real-Time_Photometric_Stereo_Using_an_Event_Camera_CVPR_2024_paper.pdf

代码链接:

https://codeberg.org/ybh1998/EventPS

1. 研究背景及解决的问题

1.1 研究背景

光度立体视觉是一种通过分析从各个方向照射物体的图像序列来估计物体表面法线(三维形状的一种表示方法)的技术,其独特之处在于重建结果的高分辨率和精确细节。在密集采样光照和朗伯反射物体的条件下,光度立体视觉方法的优势尤为突出。

传统的基于帧相机的光度立体视觉数据采集过程复杂且耗时,通常需要捕获多曝光图像来合成高动态范围(High Dynamic Range, HDR)图像,从而准确地捕获物体表面的镜面反射区域,很难满足对动态目标的实时三维重建需求。

1.2 解决的问题

论文利用事件相机(Event Camera)的独特属性实现了实时的光度立体视觉。从事件相机触发的基本模型出发,逐个事件推导出与表面法线直接相关的“零化向量”信息。在传统算法与深度学习算法领域分别实现了基于事件相机的光度立体视觉算法。配合高速转台进行数据采集和经过GPU优化的算法,实现了超过30帧每秒的实时表面法线重建。

2. 方法

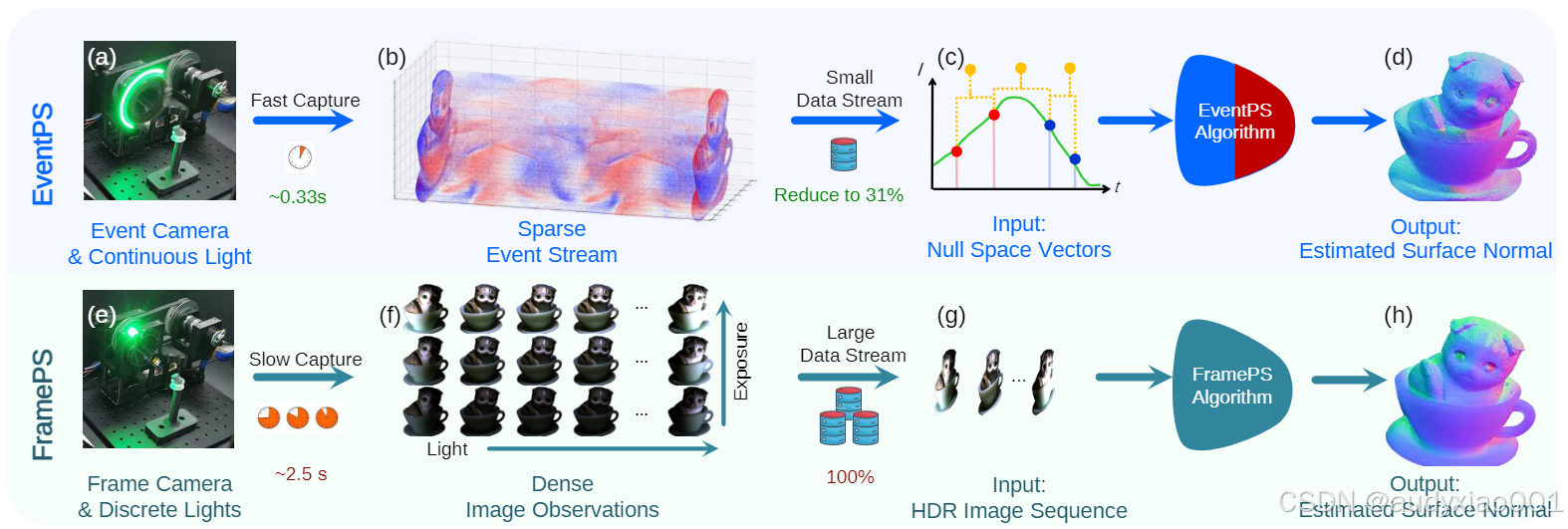

论文提出了一种EventPS的方法,EventPS重新定义了光度立体视觉问题,使其仅依赖于不同光照条件下场景辐射变化的观察结果,这特别适用于事件相机的优越特性。该方法使用高速旋转光源持续引发辐射变化并触发事件信号。每对连续事件被转换为正交于表面法线的零空间向量,从而使得可以进行表面法线的估计。EventPS相比于传统的FramePS方法,具有显著的实时性和数据效率优势。它利用事件相机的独特特性,在高动态范围和低带宽需求的情况下,实现了高效的表面法线估计,非常适合动态和实时应用场景。EventPS与FramePS方法比较如图1所示。

图1 EventPS与FramePS框架比较

2.1 基于优化的 EventPS(EventPS-OP)

EventPS-OP 聚合所有零空间向量,并使用奇异值分解方法来估计表面法线。理论上,至少需要三个事件来获得一个秩为2的矩阵以进行法线估计。通过最小化均方误差来定义优化目标,并通过 奇异值分解计算最小特征值对应的特征向量来获得表面法线。

2.2 基于深度学习的 EventPS(EventPS-FCN 和 EventPS-CNN)

为提高方法的鲁棒性和泛化能力,EventPS 适配了两种基于帧的深度学习方法:PS-FCN 和 CNN-PS。

(1)EventPS-FCN

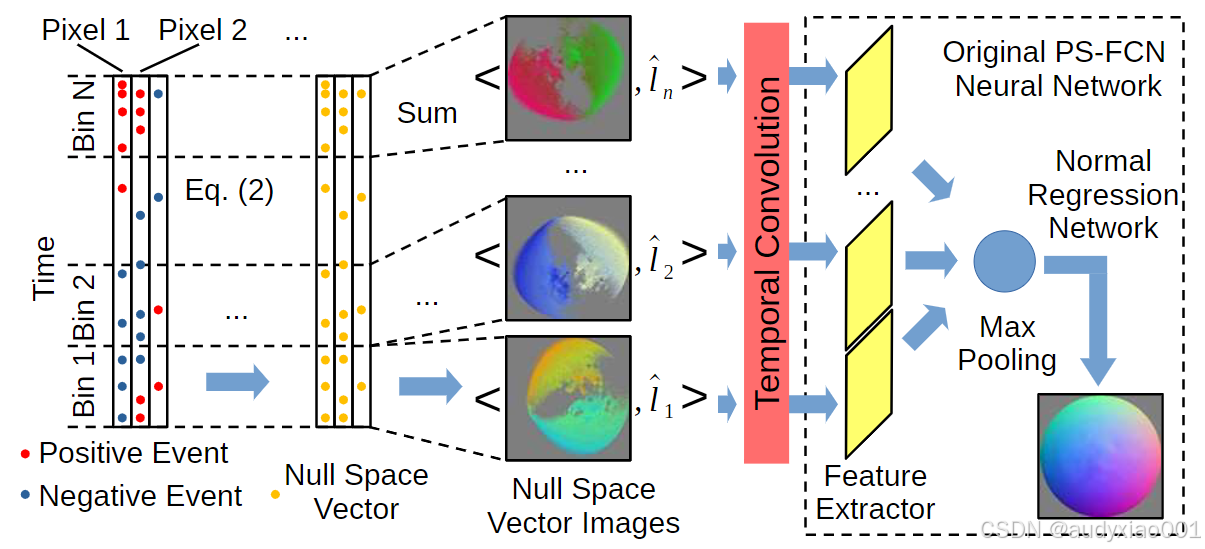

PS-FCN 使用卷积层对每个特定光照下的图像进行特征提取,并通过最大池化合并多个图像特征。在 EventPS-FCN 中,将事件信号转换为零空间向量图像作为输入,保持像素间关系。将扫描时间分为若干时间段,将每个时间段内的事件转换为零空间向量,生成零空间向量图像并输入到神经网络中进行特征提取和法线估计。EventPS-FCN的结构如图2所示。

图2 EventPS-FCN结构图

(2)EventPS-CNN

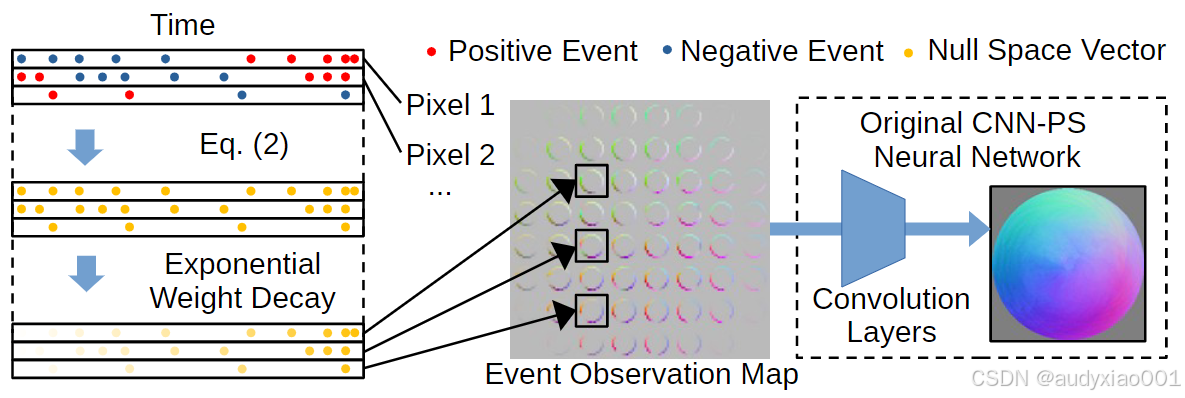

CNN-PS 对每个像素单独处理,通过从每个像素提取32×32的观察图并应用卷积层。在 EventPS-CNN 中,将事件信号转换为零空间向量,并定义事件观察图。观察图的每个像素代表相应光照方向下的零空间向量,从而保留每个像素的详细信息,并输入到 CNN-PS 模型中进行处理。EventPS-CNN的结构如图3所示。

图3 EventPS-CNN结构图

3. 实验

3.1 实验平台

为了验证算法在真实场景中的表现,研究者开发了一个高速度的照明和捕捉验证平台。

(1)照明系统:使用一个高达1800转每分钟的旋转光源,模拟快速变化的光照条件。

(2)同步捕捉:使用Prophesee EVK4 HD事件相机(IMX636传感器)捕捉事件信号。

(3)硬件配置:照明系统由同步皮带轮系统驱动,配备直流电机和霍尔效应角度传感器以检测LED位置并与事件相机同步。

3.2 数据集

(1)合成数据集(Blobby数据集中的所有对象以及Sculpture数据集中的15个对象)

(2)半真实数据集(DiLiGenT-Ev)

(3)真实数据集(BALL、BALLCVPR、BUNNY、HORSE和TIGER)

3.3 实验结果

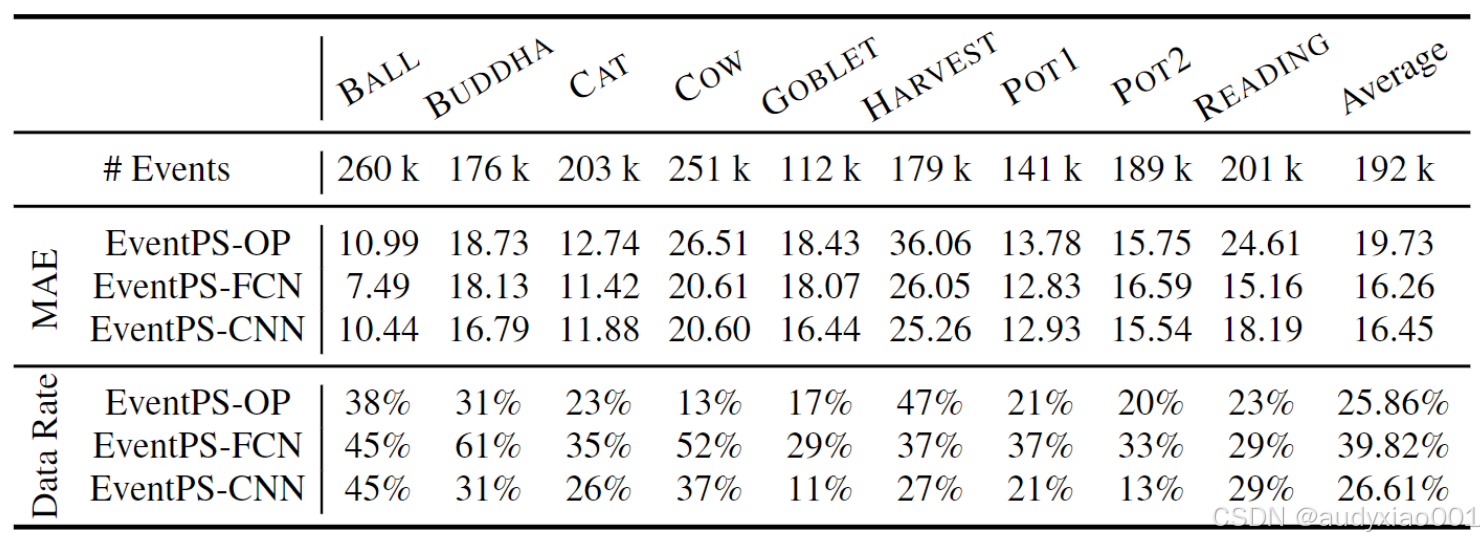

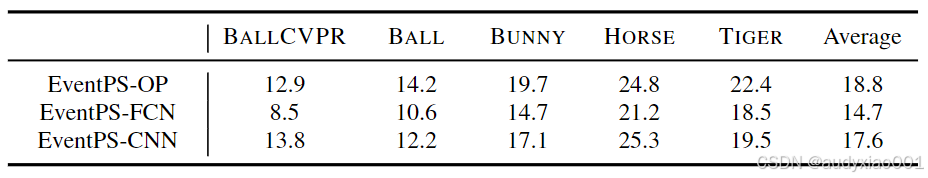

实验结果表明,EventPS方法在不同物体上的平均角度误差与传统的基于帧的光度立体方法相当,同时显著减少了数据传输需求。特别是EventPS-FCN方法表现最佳,平均角度误差为16.26°,数据率仅为传统方法的 39.82%。这些结果证明了EventPS方法在实时光度立体任务中的高效性和数据经济性,使其在高动态范围和低带宽需求的场景中具有显著的应用潜力。见表1-2。

表1 FramePS和EventPS之间的数据速率和平均角度误差比较

表2 EventPS在真实数据集上的结果

4. 结论

论文提出了EventPS方法,通过事件相机捕捉光照变化,实现高效的实时表面法线估计。该方法利用事件相机的高时间分辨率和低冗余数据特性,结合优化算法和深度学习模型,显著减少了带宽使用。实验结果表明,EventPS在多个合成和真实数据集上均表现出较高的精度和鲁棒性。