张士玉小黑屋

一个关注IT技术分享,关注互联网的网站,爱分享网络资源,分享学到的知识,分享生活的乐趣。

当前位置:首页 » 安装 - 第14页

12月30日

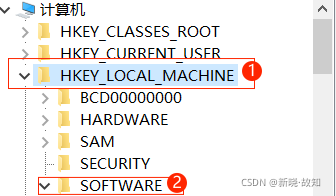

关于Visual Studio相关软件(本文采用Visual Studio2019举例)二次安装时,无法更改安装路径的解决办法之一_m0_57859086的博客

发布 : zsy861 | 分类 : 《随便一记》 | 评论 : 0 | 浏览 : 792次

12月26日

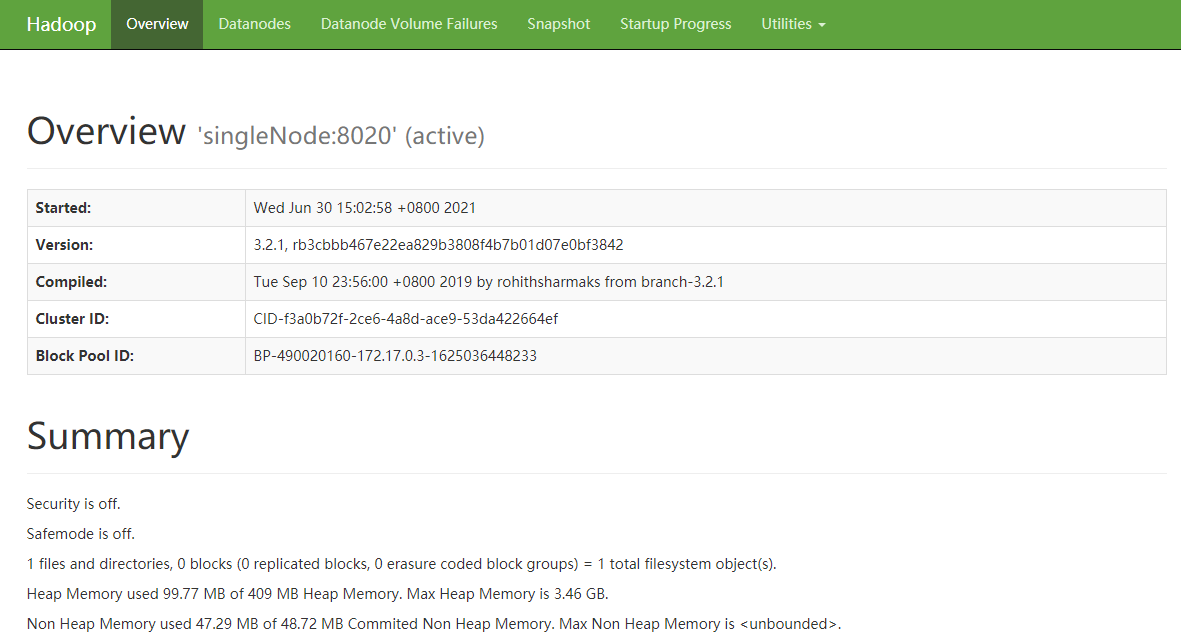

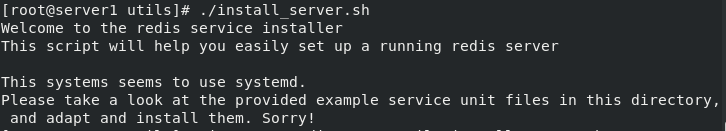

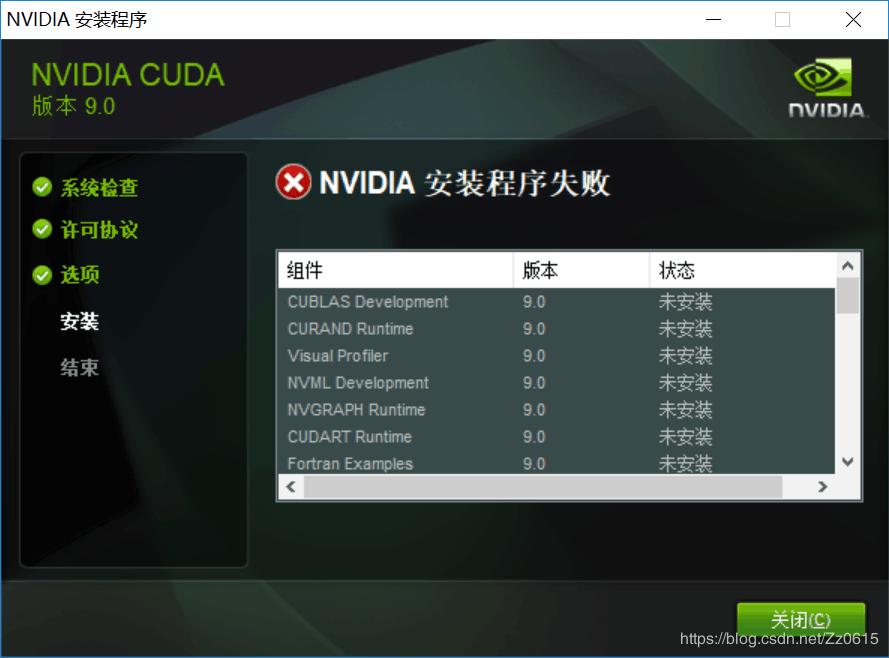

深度学习笔记1:“安装CUDA、Pytorch、调试GPU环境“方法以及常见误区_yuhongchuancsu的博客

发布 : zsy861 | 分类 : 《随便一记》 | 评论 : 0 | 浏览 : 558次

Copyright © 2020-2022 ZhangShiYu.com Rights Reserved.豫ICP备2022013469号-1