open-web UI 实用指南

open-web UI 类似于chatgpt的界面,可以私有化模型本地部署,也可以用商业模型.本文只是用开源模型. 它可以实现AI聊天 , AI 翻译 , 语音转文本, 文本转语音, 文生图,代码助手,可谓利器。

前提:安装好ollama

安装open-web UI

使用 pip 安装

需要 Python 3.11

安装Open WebUI:打开你的终端并运行以下命令:

pip install open-webui启动 Open WebUI:安装完成后,使用以下命令启动服务器:

open-webui serve安装后,可以在 http://localhost:8080 访问Open WebUI

AI 聊天,AI翻译

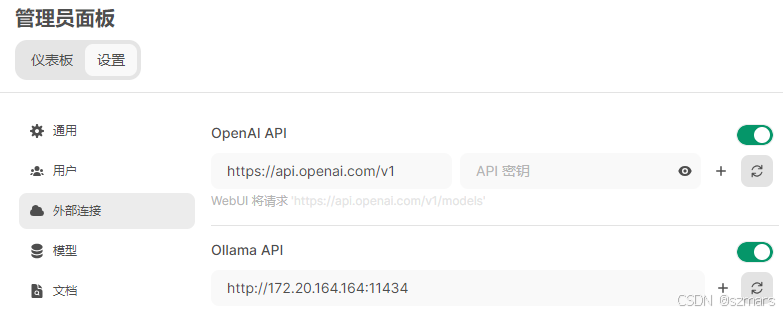

点用户,打开管理员面板,选择设置–外部连接,输入Ollama API的链接地址,点击右边按钮,测试连接

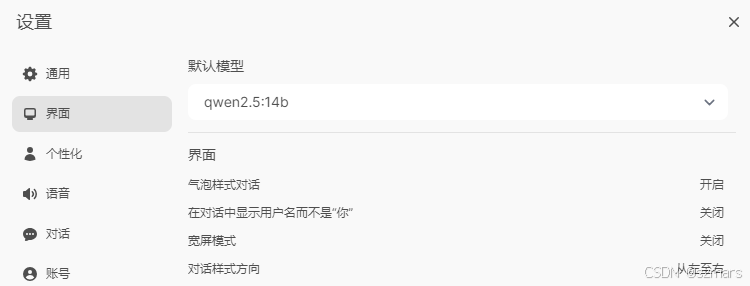

然后在 设置–界面 ,选择一个默认模型

然后就可以回到新对话,进行聊天了。

可以在工作空间编辑一下提示词,便于翻译

语音转文本

安装 faster-whisper-serve

faster-whisper-serve 是一个兼容 OpenAI API 的转录服务器,它使用fast-whisper作为后端。特征:

GPU 和 CPU 支持。 使用 Docker 可以轻松部署。 可通过环境变量进行配置(请参阅config.py ) 。 兼容 OpenAI API。 流媒体支持(转录是在音频转录时通过SSE发送的。您无需等待音频完全转录后再接收)。 实时转录支持(音频在生成时通过 websocket 发送)。 动态模型加载/卸载。只需在请求中指定您要使用的模型,它将自动加载。经过一段时间不活动后,它将被卸载。git clone https://github.com/fedirz/faster-whisper-servecd faster-whisper-servedocker compose up --detach faster-whisper-server-cuda设置open-web UI 语音转文本

点用户,打开管理员面板,选择设置–语音。 语音转文本模型输入 deepdml/faster-whisper-large-v3-turbo-ct2, 这个是多语言模型; API密钥随便输入,没有被使用到。

登录后可发表评论

点击登录